1.继承概念

我们平时有时候在写多个有内容重复的类的时候会很麻烦

比如我要写Student Teacher Staff 这三个类

里面都要包含 sex name age成员变量

唯一不同的可能有一个成员变量 但是这三个成员变量我要写三遍

太麻烦了 有没有好的方式呢?

有的 就是继承、我们先来看继承的书写格式

但是我们继承过来的类里面的成员是public private 还是protected呢?

在此之前我们要了解一下继承方式和访问限定符有哪些

继承基类成员访问方式的变化如下

继承基类成员访问方式的变化如下

这个地方很好记忆 记住两点就可以了

***这里的不可见要和private区分开来

***这里的不可见要和private区分开来

***简单点说就是基类访问方式和派生类的继承方式的最小方式

除此之外还有我们之前学类成员函数没有了解到的protected

虽然struct和class有默认继承方式,但是最好还是显示写

虽然struct和class有默认继承方式,但是最好还是显示写

当然以上这么多看起来好麻烦 但是实际让我们用的很少

2.基类和派生类类型转换

基类赋值给派生类是向下转换

派生类赋值给基类是向上转换

1.对于类成员,首先基类不能赋值给派生类(强制类型转换也不可以)

因为派生类有基类没有的成员变量 怎么赋值

2.此外派生类赋值给基类时,既不是隐式类型转换 也不是强制类型转换

而是赋值兼容(也称切割,切片) 因此不会产生临时变量 不具有常性

把派生类中的基类部分切割出来 赋值给基类

class Person

{};class Student :public Person

{};int main(void)

{int i = 0;double& d = i;//隐式类型会产生临时变量 具有常性 报错Person p;Student s;p = s;Person& pp = s;//赋值兼容 不产生临时变量 不具有常性 不报错return 0;

}像上面代码的变量pp 它是把派生类中的基类部分切割出来取别名

像上转换都是可以的

派生类赋值给 基类对象/引用/指针

至于向下转换

对象是不支持的

但是指针和引用可以

基类的指针/引用可以指向派生类中基类的那一部分

后面再详细讲解

3.继承中的作用域

1.在继承体系中 基类和派生类都有独立的作用域

那么基类和派生类如果有同名的成员呢?

当然是可以 在不同的作用域里面可以有同名的函数

就像stack里面有push

queue里面也有push啊!

C++对于这种同名的成员变量或者函数取了一个名称 叫隐藏也叫重定义

这个地方函数的同名要和函数重载区分一下

首先函数重载是在同一个域中

这个地方的函数同名是处于两个不同的域

我们直接上代码就很容易理解了

class Person

{

public:void func(){cout << "基类" << endl;}

};class Student :public Person

{

public:void func(int){cout << "派生类" << endl;}

};

int main(void)

{Person p;Student s;Person& pp = s;s.func();//错误s.func(2);//正确s.Person::func();//正确return 0;

}只要派生类和基类函数名相同就构成隐藏

总结

4.派生类的默认成员函数

我们的派生类变量 中基类变量那部分 初始化会调用基类的构造函数

不可以在 派生类的初始化列表初始化 但是可以在派生类的构造函数函数体内使用

class Person

{

public:Person(int a){cout << "基类" << endl;}

public:string sex;

};class Student :public Person

{

public:Student():age(18),Person(2)//不加就会报错{sex = 12;cout << sex << endl;}

private:int age = 18;

};

int main(void)

{Student s;return 0;

} 不加,Person(2)这个地方报错

这个地方你会发现先初始化Person后初始化age 因为初始化的顺序不是按照初始化列表的顺序

而是按照声明的顺序

按照声明来说 继承的类是在派生类自己类变量前面的

析构函数,拷贝构造和赋值重载也是差不多 但是还是有一些细微的差别

本质上相同!

class Person

{

public:Person(string a="Tony"){cout << "基类" << endl;}Person(const Person& v):sex(v.sex){}Person& operator=(Person& v){if (this != &v){v.sex = sex;}return*this;}~Person(){}

public:string sex;

};class Student :public Person

{

public:Student(string sex="zhangsan1"):age(18),Person(sex){}Student(const Student&s):age(s.age),Person(s)//Person拷贝构造函数要求Person类型的对象//这个地方我们没有Person对象 但是也可以直接传//派生类对象变量可以传给基类对象(向上转换 切割)////这个地方Person(s)你不写编译器就会去调用Person的默认构造函数{}Student& operator=(Student& v){if (this != &v){Person::operator=(v);//这个地方就涉及到我们前面学习的隐藏了age = v.age;}return *this;}~Student(){//Person:~Person 由于后面多态的原因,析构函数的函数名被特殊处理了,// 统一处理成destructor了 这个时候就构成隐藏了//但是实际上这个地方不用我们显示写 因为编译器会自动调用//这个地方是先析构派生类自己的成员 再去析构派生类中基类的那部分成员//原因是派生类中可能会用到基类的成员 // 比如cout<<sex<<endl;}

private:int age = 18;

};5.继承与友元

很简单 一句话

派生类不能继承基类的友元

6.继承与静态成员

我们来看这一串代码

打印的地址相同说明派生类和基类使用的是同一个

这个地方的静态成员属于父类和派生类

在派生类中不会单独拷贝一份、继承的是使用权

当然我们使用静态变量 无论是域名或者对象都可以!

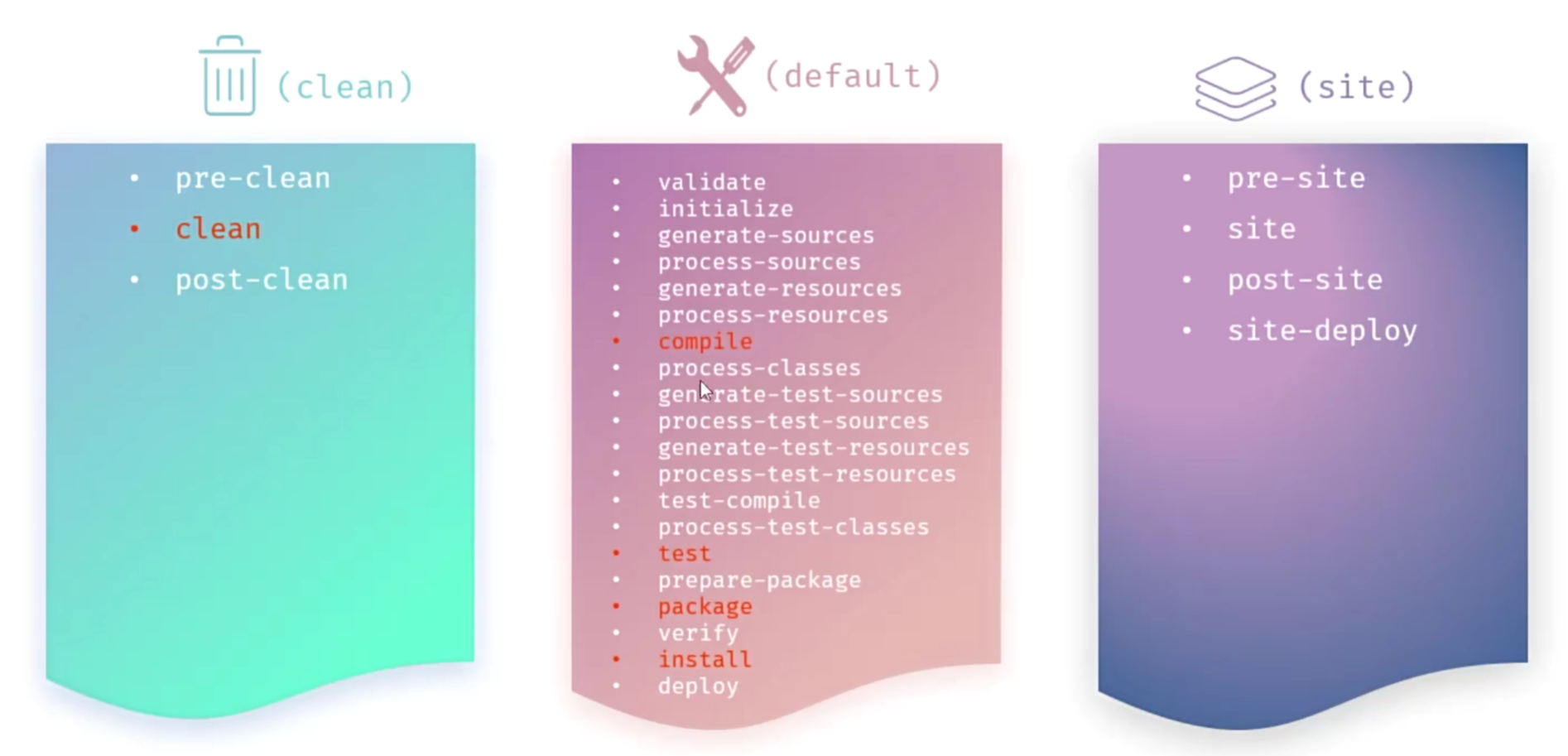

7.复杂的菱形继承及虚拟继承

继承是可以多继承的

但是多继承就容易出现问题

比如菱形继承

这个时候就会出现两个问题

1.冗余性

我把同样的成员变量拷贝了两份,太冗余了

2.二义性

比如上图的Student类和Teacher类都要age成员的情况下

Assitant a; a.age的这个age是从Teacher类继承过来的还是从Student继承过来的?

首先 解决二重性的方式比较简单

我要用Tearher继承来的age就直接 a.Teacher::age;

Tearher继承来的age就直接 a.Student::age;

那么怎么解决冗余性呢?

这就涉及到了虚拟菱形继承了

虚拟菱形继承就是在普通继承前面+一个virtual!

class D : public virtual B, public virtual C

{

}我们先来看普通菱形继承是怎么样的?

普通的菱形继承就和我们前面说的一样

有冗余 A类的成员被储存了两次

我们再来看菱形虚拟继承

它把原本B类和C类共有继承的A类 单独 拿出来了

但是这个地方多了两个东西 多了两个指针

指向的内容是距离A的偏移量(相对距离)

这也就意味着我们在使用B类和C类指针的时候

可以根据指针找到偏移量找到A的位置 毕竟A是B和C的基类

但是这个时候它们就没有存放到B和C里面

那么我为为什么不直接存偏移量在B和C里面 要存一个指针去找呢?

我们看到那个偏移量是存在第二个位置

第一个位置是为其他的预留位置

而且万一是三个值 四个值呢?

那我不是要存三四个地址?

那B C的大小会变得很大

而且万一你有其他D对象呢

那你岂不是要把所有的内容再存一遍?

直接用指针指向同一块公共区域不香吗?

毕竟这个偏移量只要是D对象都是固定的啊!

这个时候B类的结构也发生了变化

偏移量和在D类对象的不一样

这个时候就容易出问题 尤其是切片的时候

我们再来看下面这串代码

编译器单ptr->指向是无法判断ptr指向的是B类型的_a++还是D类型的

这个时候编译器就只能通过指针取到偏移量再根据偏移量去计算_aa的位置

上面两个ptr->_a++;本质上在编译的时候都是一样的

切片不需要特殊处理,都是通过指针去取偏移量