[1]

X. Wang et al., ‘Scalable Resource Management for Dynamic MEC: An Unsupervised Link-Output Graph Neural Network Approach’.

paper code:GitHub - UNIC-Lab/LOGNN: This is the code for paper "Scalable Resource Management for Dynamic MEC: An Unsupervised Link-Output Graph Neural Network Approach"

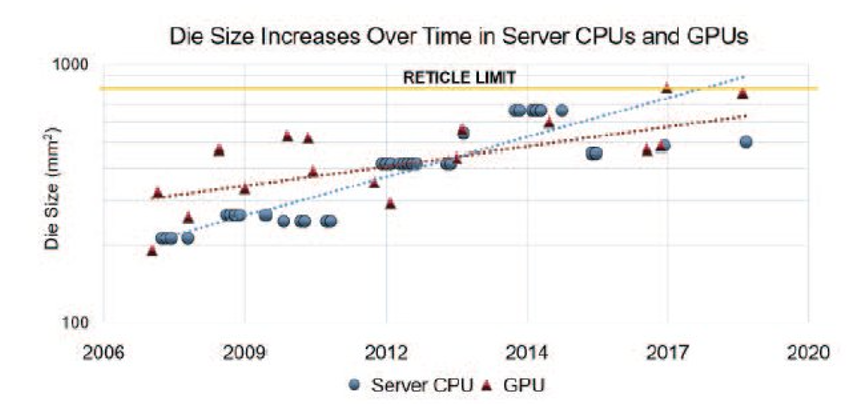

Motivation:

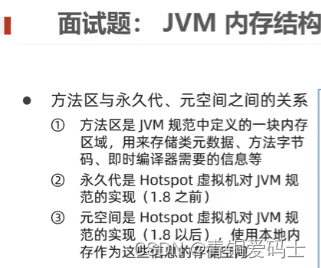

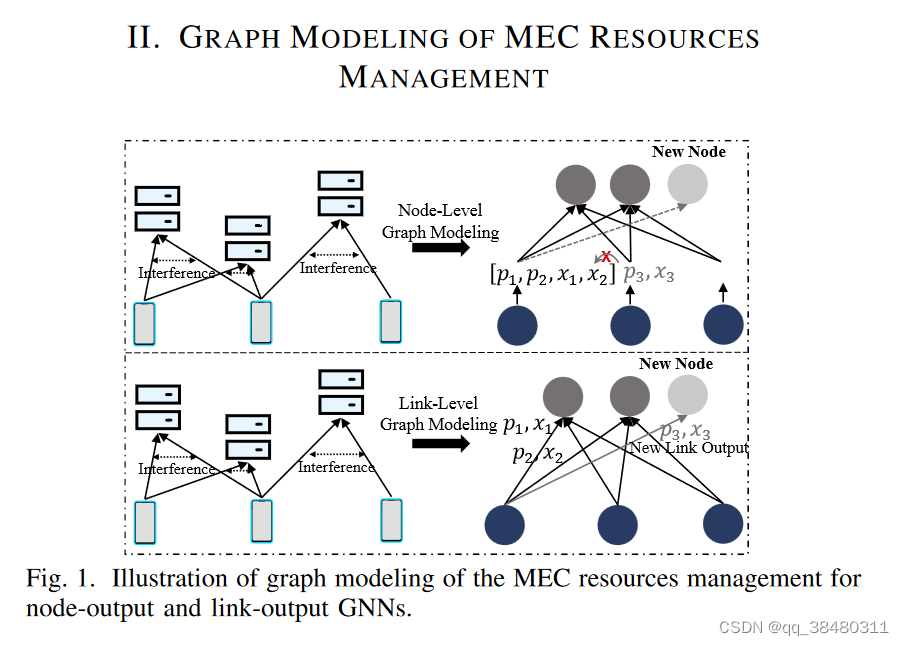

Although conventional node-output graph neural networks (GNN) can extract features of edge nodes when the network scales, they fail to handle a new scalability issue whereas the dimension of the decision space may change as the network scales.

传统的node-output网络可以在网络规模增长时抽取节点的feature,但是却不能解决网络规模改变时决策空间改变的问题。

Contribution:

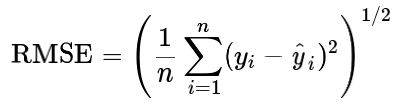

提出了一种新颖的基于链路输出 link-output GNN ( LOGNN )的资源管理方法,以极低的算法推理延迟为任意数量的边缘节点灵活地优化MEC中的资源分配。此外,一种无标签的无监督方法被应用于有效地训练LOGNN,其中边缘任务处理延迟相对于LOGNN参数的梯度被显式地导出。

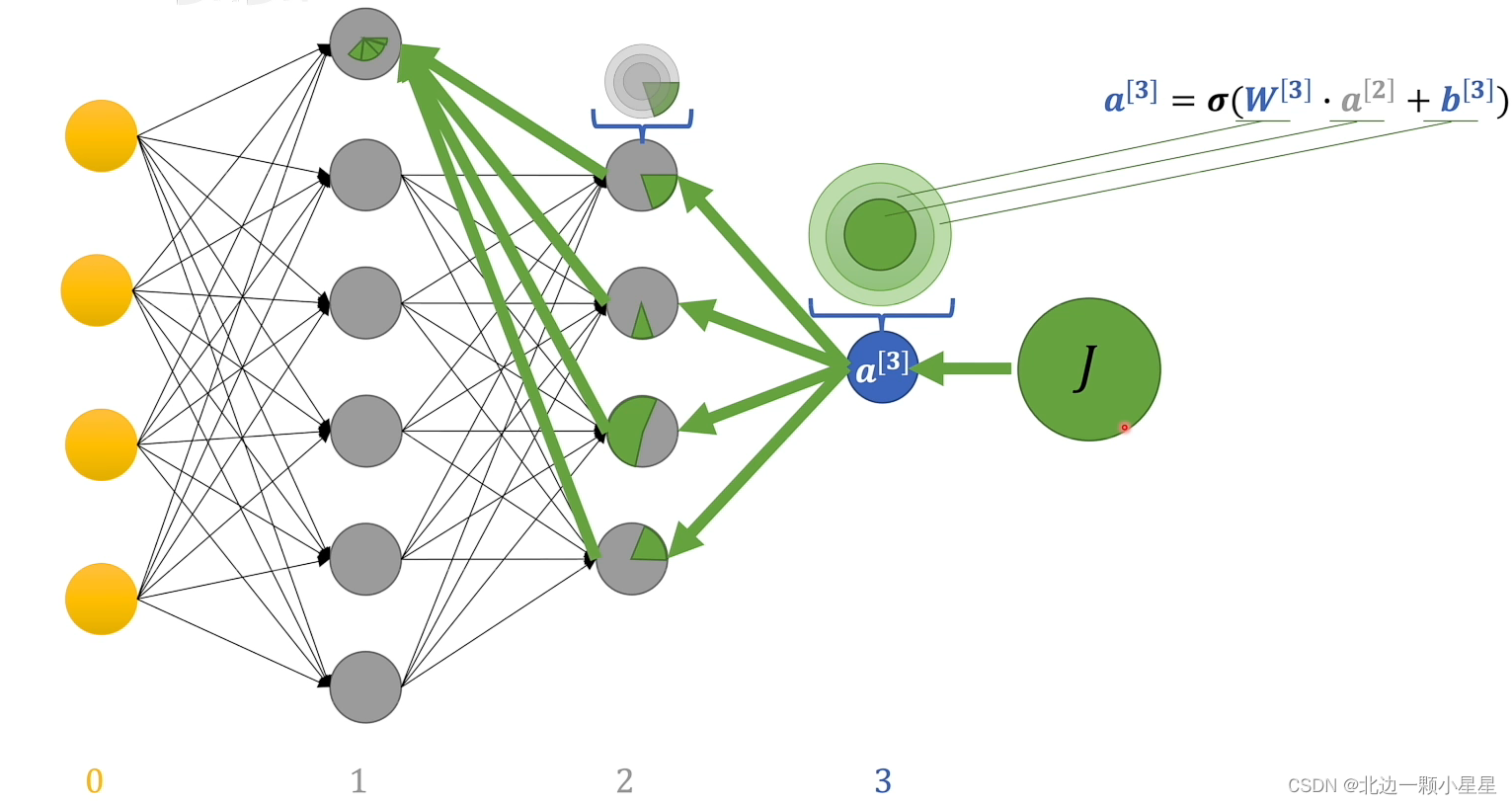

Node-output GNN 和 link-output GNN的区别?

在图神经网络 (GNN) 中,节点输出 (node-output) GNN 和边输出 (link-output) GNN 是两种不同的模型类型,分别代表着不同的意义。

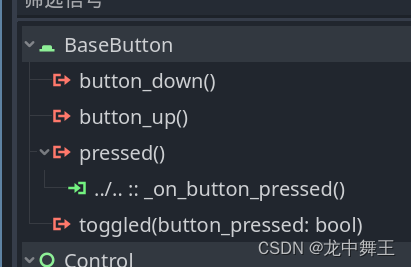

节点输出 GNN 是一种基于节点的模型,它将节点的特征作为输入,并通过模型的计算得到每个节点的输出。这种模型通常用于节点分类、节点嵌入和图分类等任务,其中每个节点都有一个标签或类别。

边输出 GNN 是一种基于边的模型,它将每条边的两个端点的特征作为输入,并通过模型的计算得到每条边的输出。这种模型通常用于边分类、边预测和关系预测等任务,其中每条边都有一个标签或类别。

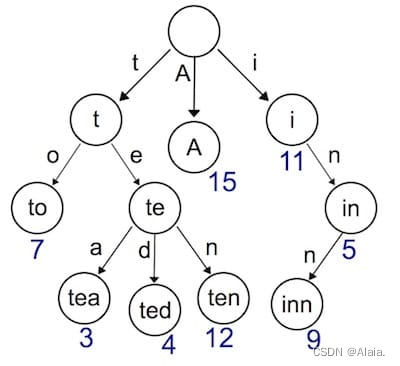

graph

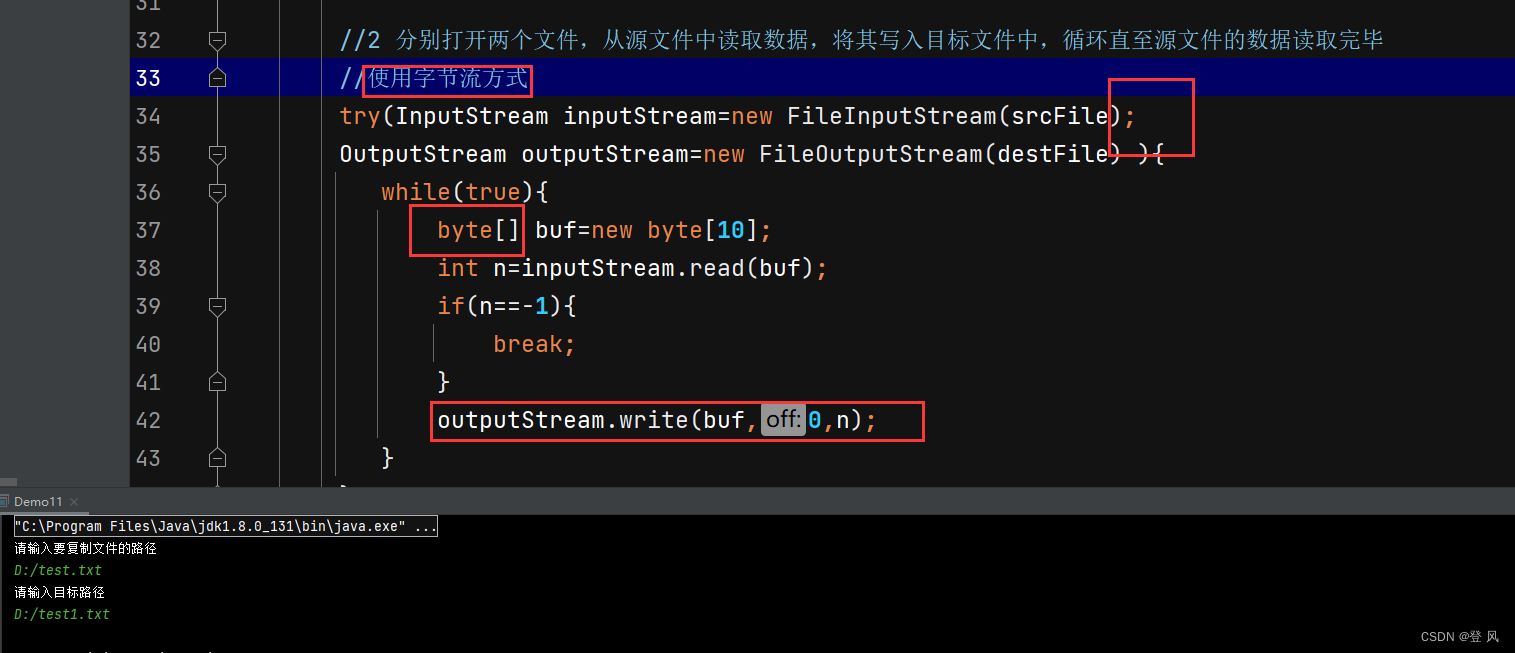

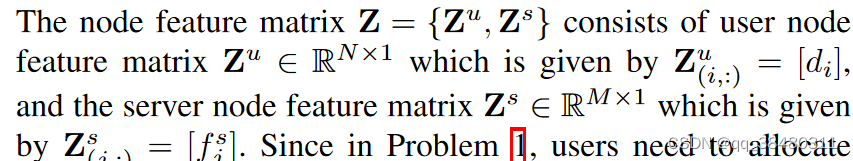

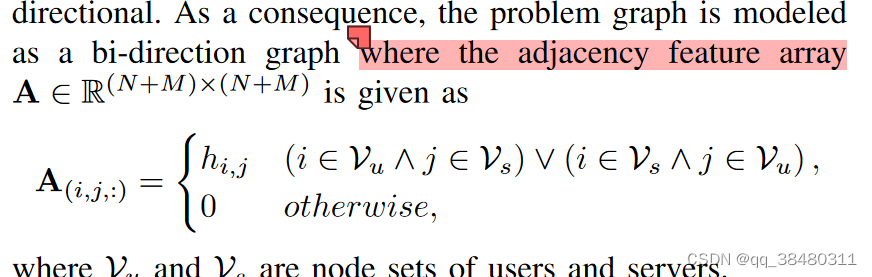

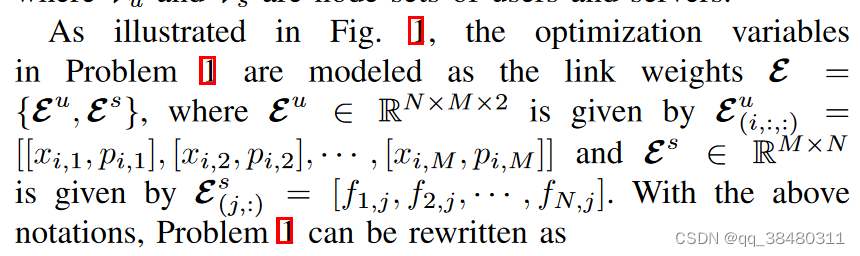

nodes: M servers and N users

links:wireless channels between users and servers are modeled as graph links

Node feature:

Link feature:

其中x i,j是表示 从user i 到 server j的offloading ratio, 而p i,j 表示发射功率。

f表示server j给用户 i分配的计算资源。

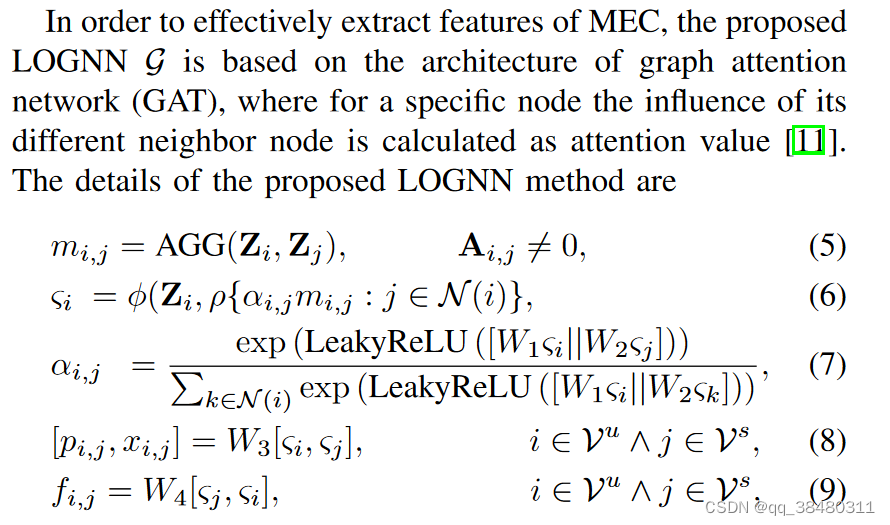

训练部分感觉写得并不详细,(5)应该是聚合邻居信息,(6)更新i节点的feature,为啥不更新j节点也就是server的feature呢?

(8)根据 link 链接的user i和server j来决策link的特性,即 offloading ratio和 transmit power

(9)根据link 链接的user i和server j来决策server link的特性,即resource allocation。

思考:

文中的分配还是针对一个静态的拓扑,不考虑time-varying。是将node feature 更改为 link feature prediction。