联邦学习需要参与者在每一次的本地训练后,上传所更新的模型参数并与其他参与者共享,而参数更新中仍有可能包含所有者的敏感信息

解决方案:

加密方法(安全多方计算、同态加密)通过将明文编码为密文的方式,只允许特定人员解码,为数据隐私保护提供了有效手段,但这往往需要极大的计算开销,较难应用于实际的联邦学习场景中

数据扰动(差分隐私)通过将明文编码为密文的方式,只允许特定人员解码,为数据隐私保护提供了有效手段,但这往往需要极大的计算开销,较难应用于实际的联邦学习场景中

如果选择梯度剪枝的话是需要考虑选择哪一部分剪枝的梯度参与训练

(将梯度剪枝与加密的防御体系结合)

差分隐私与联邦学习 梯度剪枝

一般与轻量级进行结合吗?

基于梯度选择的轻量化差分隐私保护联邦学习

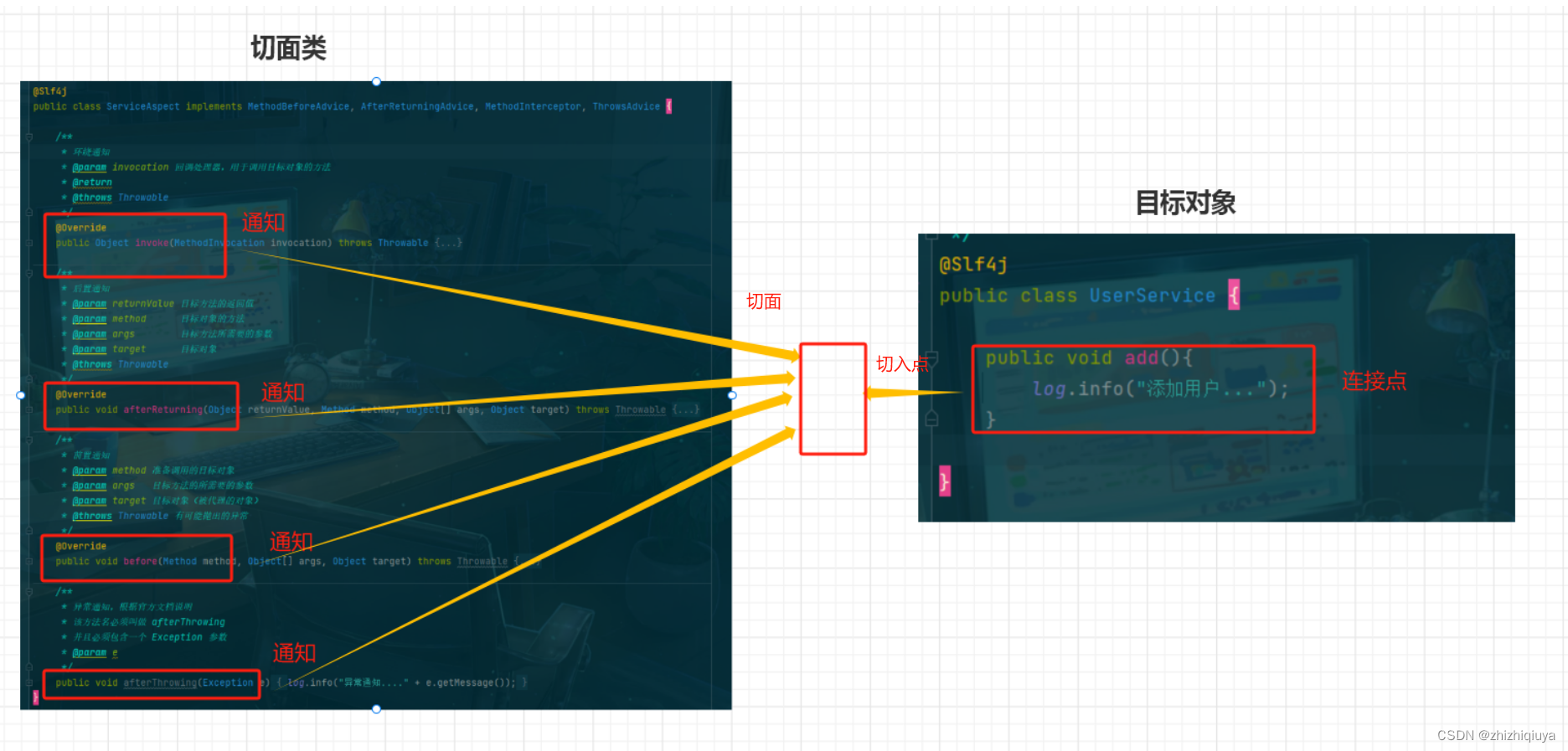

基于 Fisher 信息矩阵的 Dropout 机制,FisherDropout(差分隐私在什么地方使用呢?)

用差分隐私去解决——>轻量化、易部署

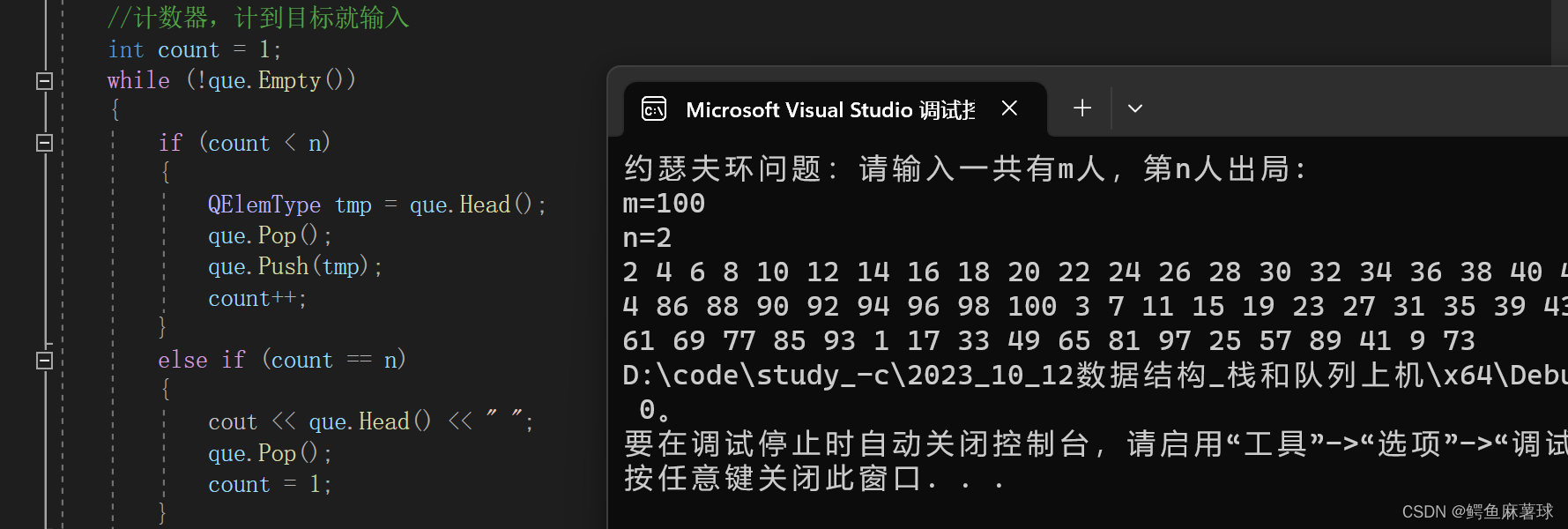

梯度剪枝方法:Federated Dropout(FedDropout)

采用完全客观的准确度与损失函数值作为评估标准(这个评估标准是怎么制定的呢?是否有理论依据?)

基于 Fisher 信息排序的 dropout 算法,通过优化选择梯度的一部分上传;由于 dropout 机制有利于减少梯度维度,应用于差分隐私保护方法中可以大大节约隐私预算

在差分隐私中,隐私预算 是平衡安全性与可用性的关键参数 。决 定了差分隐私方法所添加噪声方差的大小。较小的值会使安全性变高,但也会令数据的可用性变得更差。

是平衡安全性与可用性的关键参数 。决 定了差分隐私方法所添加噪声方差的大小。较小的值会使安全性变高,但也会令数据的可用性变得更差。

(差分隐私中主要的问题还是怎么处理隐私预算的值)

而在联邦学习中,用户通常需要在本地完成迭代以及噪声添加工作,这可能导致数据安全性与可用性的平衡更加困难。

当取值为 8 时,基于差分隐私保护的联邦学习在训练中可能需要额外使用 100 倍左右的数据量,才可达到与不含差分隐私的联邦学习一致的模型准确率。而在集中式学习中,这往往只需要付出大约 10 倍的训练量。

轻量化联邦学习的方式:剪枝、量化、蒸馏

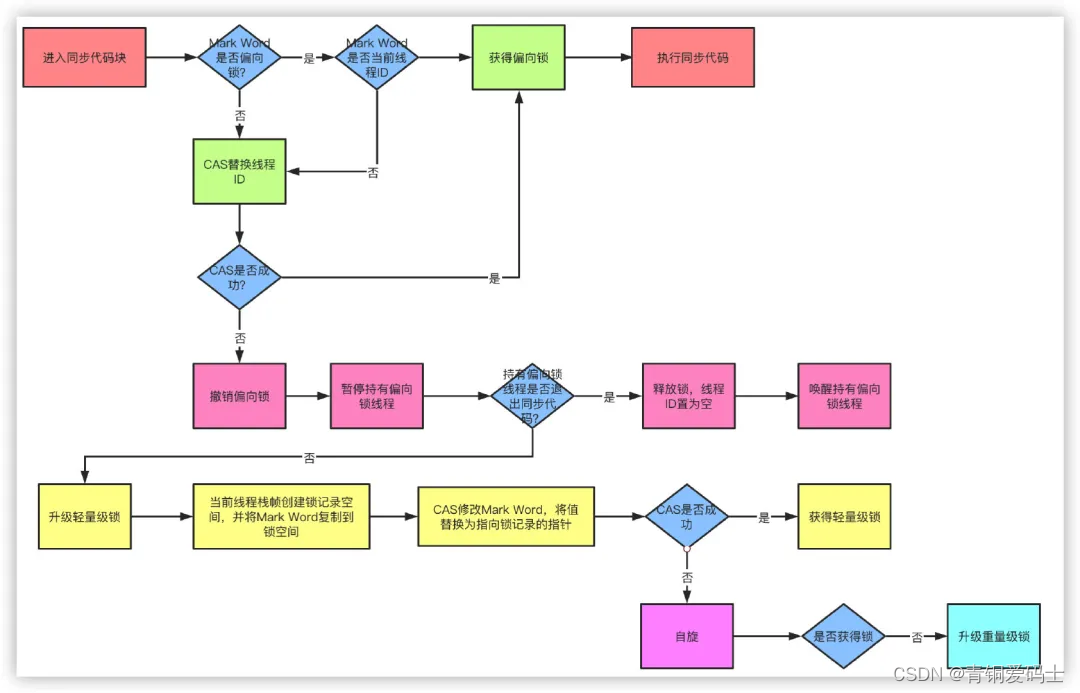

满足差分隐私的联邦学习:与经典的联邦学习不同的地方为增加了客户端随机扰动参数

梯度剪枝:

客户端首先采用FisherDropout 算法,以神经元为单位对全局模型进行裁剪,保留其中的一部分作为子模型。该裁剪过程一般被称为“dropout”。值得注意的是,每个客户端都需要根据自己的数据分布、通信状况与计算能力来独立地确定各自的裁剪方式与dropout 率,这将导致每个客户端最终所生成的子模型可能是异构的。

使用差分隐私进行数据扰动:

采用了差分隐私保护方法对待上传的数据进行扰动。被扰动后的数据将带有随机性,使得服务器很难根据这些参数反推客户端的原始数据。

由于每个客户端所上传的子模型是异构的,这也要求客户端在上传模型时还需要额外发送每个参数的位置信息。

服务器可以根据每位用户上一轮的位置信息发送新的子模型参数,而不用发送全局模型;或者考虑到收敛速度,可以每隔固定的迭代轮次便发送一次全局模型,以便让每个客户端确定新的子模型的位置。

一般是讲述梯度剪枝的原理与进行隐私性证明