一、概述

如今人们利用深度学习做无数的应用。然而,为了理解在许多作品中看到的大量设计选择(例如跳过连接),了解一点反向传播机制至关重要。

如果你在 2014 年尝试训练神经网络,你肯定会观察到所谓的梯度消失问题。简单来说:你在屏幕后面检查网络的训练过程,你看到的只是训练损失停止减少,但距离期望值仍然很远。

1、更新规则和梯度消失问题

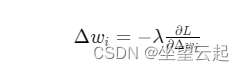

没有动量的梯度下降的更新规则,假设 L 是损失函数,λ是学习率

,其中

,其中

基本上是通过少量更改来更新参数Δwi。它是根据梯度计算的,假设早期层的平均梯度为1e-15 (ΔL/δw)。给定学习率为 1e-4(方程中的 λ),乘积为1e-19,因此,在训练网络时,实际上并没有观察到模型的任何