目录

亲和性

键值运算关系

硬策略

软策略

Pod亲和性与反亲和性

污点(Taint) 和 容忍(Tolerations)

污点(Taint)

容忍(Tolerations)

维护操作

故障排除步骤

亲和性

官方介绍:https://kubernetes.io/zh/docs/concepts/scheduling-eviction/assign-pod-node/

(1)节点亲和性

pod.spec.nodeAffinity

●preferredDuringSchedulingIgnoredDuringExecution:软策略

●requiredDuringSchedulingIgnoredDuringExecution:硬策略

(2)Pod 亲和性

pod.spec.affinity.podAffinity/podAntiAffinity

●preferredDuringSchedulingIgnoredDuringExecution:软策略

●requiredDuringSchedulingIgnoredDuringExecution:硬策略

可以把自己理解成一个Pod,当你报名来学云计算,如果你更倾向去zhangsan老师带的班级,把不同老师带的班级当作一个node的话,这个就是节点亲和性。如果你是必须要去zhangsan老师带的班级,这就是硬策略;而你说你想去并且最好能去zhangsan老师带的班级,这就是软策略。

如果你有一个很好的朋友叫lisi,你倾向和lisi同学在同一个班级,这个就是Pod亲和性。如果你一定要去lisi同学在的班级,这就是硬策略;而你说你想去并且最好能去lisi同学在的班级,这就是软策略。软策略是不去也可以,硬策略则是不去就不行。

键值运算关系

●In:label 的值在某个列表中 pending

●NotIn:label 的值不在某个列表中

●Gt:label 的值大于某个值

●Lt:label 的值小于某个值

●Exists:某个 label 存在

●DoesNotExist:某个 label 不存在

kubectl get nodes --show-labels

硬策略

requiredDuringSchedulingIgnoredDuringExecution 硬策略

mkdir /opt/affinity

cd /opt/affinityvim pod1.yaml

apiVersion: v1

kind: Pod

metadata:name: affinitylabels:app: node-affinity-pod

spec:containers:- name: with-node-affinityimage: soscscs/myapp:v1affinity:nodeAffinity:requiredDuringSchedulingIgnoredDuringExecution:nodeSelectorTerms:- matchExpressions:- key: kubernetes.io/hostname #指定node的标签operator: NotIn #设置Pod安装到kubernetes.io/hostname的标签值不在values列表中的node上values:- node02kubectl apply -f pod1.yamlkubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

affinity 1/1 Running 0 13s 10.244.1.30 node01 <none> <none>

kubectl delete pod --all && kubectl apply -f pod1.yaml && kubectl get pods -o wide

#如果硬策略不满足条件,Pod 状态一直会处于 Pending 状态。

软策略

preferredDuringSchedulingIgnoredDuringExecution 软策略

vim pod2.yaml

apiVersion: v1

kind: Pod

metadata:name: affinitylabels:app: node-affinity-pod

spec:containers:- name: with-node-affinityimage: soscscs/myapp:v1affinity:nodeAffinity:preferredDuringSchedulingIgnoredDuringExecution:- weight: 1 #如果有多个软策略选项的话,权重越大,优先级越高preference:matchExpressions:- key: kubernetes.io/hostnameoperator: Invalues:- node03kubectl apply -f pod2.yamlkubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

affinity 1/1 Running 0 5s 10.244.2.35 node02 <none> <none>

//把values:的值改成node01,则会优先在node01上创建Pod

kubectl delete pod --all && kubectl apply -f pod2.yaml && kubectl get pods -o wide

//如果把硬策略和软策略合在一起使用,则要先满足硬策略之后才会满足软策略

//示例:

apiVersion: v1

kind: Pod

metadata:name: affinitylabels:app: node-affinity-pod

spec:containers:- name: with-node-affinityimage: soscscs/myapp:v1affinity:nodeAffinity:requiredDuringSchedulingIgnoredDuringExecution: #先满足硬策略,排除有kubernetes.io/hostname=node02标签的节点nodeSelectorTerms:- matchExpressions:- key: kubernetes.io/hostnameoperator: NotInvalues:- node02preferredDuringSchedulingIgnoredDuringExecution: #再满足软策略,优先选择有kgc=a标签的节点- weight: 1preference:matchExpressions:- key: kgcoperator: Invalues:- aPod亲和性与反亲和性

| 调度策略 | 匹配标签 | 操作符 | 拓扑域支持 | 调度目标 |

| nodeAffinity | 主机 | In, NotIn, Exists,DoesNotExist, Gt, Lt | 否 | 指定主机 |

| podAffinity | Pod | In, NotIn, Exists,DoesNotExist | 是 | Pod与指定Pod同一拓扑域 |

| podAntiAffinity | Pod | In, NotIn, Exists,DoesNotExist | 是 | Pod与指定Pod不在同一拓扑域 |

kubectl label nodes node01 kgc=a

kubectl label nodes node02 kgc=a

//创建一个标签为 app=myapp01 的 Pod

vim pod3.yaml

apiVersion: v1

kind: Pod

metadata:name: myapp01labels:app: myapp01

spec:containers:- name: with-node-affinityimage: soscscs/myapp:v1kubectl apply -f pod3.yamlkubectl get pods --show-labels -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES LABELS

myapp01 1/1 Running 0 37s 10.244.2.3 node01 <none> <none> app=myapp01

//使用 Pod 亲和性调度,创建多个 Pod 资源

vim pod4.yaml

apiVersion: v1

kind: Pod

metadata:name: myapp02labels:app: myapp02

spec:containers:- name: myapp02image: soscscs/myapp:v1affinity:podAffinity:requiredDuringSchedulingIgnoredDuringExecution:- labelSelector:matchExpressions:- key: appoperator: Invalues:- myapp01topologyKey: kgc

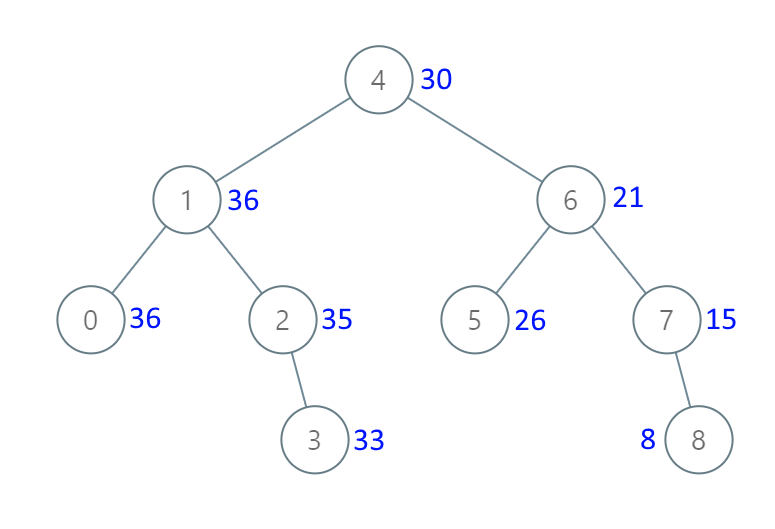

#仅当节点和至少一个已运行且有键为“app”且值为“myapp01”的标签 的 Pod 处于同一拓扑域时,才可以将该 Pod 调度到节点上。 (更确切的说,如果节点 N 具有带有键 kgc 和某个值 V 的标签,则 Pod 有资格在节点 N 上运行,以便集群中至少有一个具有键 kgc 和值为 V 的节点正在运行具有键“app”和值 “myapp01”的标签的 pod。)

#topologyKey 是节点标签的键。如果两个节点使用此键标记并且具有相同的标签值,则调度器会将这两个节点视为处于同一拓扑域中。 调度器试图在每个拓扑域中放置数量均衡的 Pod。

#如果 kgc 对应的值不一样就是不同的拓扑域。比如 Pod1 在 kgc=a 的 Node 上,Pod2 在 kgc=b 的 Node 上,Pod3 在 kgc=a 的 Node 上,则 Pod2 和 Pod1、Pod3 不在同一个拓扑域,而Pod1 和 Pod3在同一个拓扑域。

kubectl apply -f pod4.yaml

kubectl get pods --show-labels -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES LABELS

myapp01 1/1 Running 0 15m 10.244.1.3 node01 <none> <none> app=myapp01

myapp02 1/1 Running 0 8s 10.244.1.4 node01 <none> <none> app=myapp02

myapp03 1/1 Running 0 52s 10.244.2.53 node02 <none> <none> app=myapp03

myapp04 1/1 Running 0 44s 10.244.1.51 node01 <none> <none> app=myapp03

myapp05 1/1 Running 0 38s 10.244.2.54 node02 <none> <none> app=myapp03

myapp06 1/1 Running 0 30s 10.244.1.52 node01 <none> <none> app=myapp03

myapp07 1/1 Running 0 24s 10.244.2.55 node02 <none> <none> app=myapp03

//使用 Pod 反亲和性调度

示例1:

vim pod5.yaml

apiVersion: v1

kind: Pod

metadata:name: myapp10labels:app: myapp10

spec:containers:- name: myapp10image: soscscs/myapp:v1affinity:podAntiAffinity:preferredDuringSchedulingIgnoredDuringExecution:- weight: 100podAffinityTerm:labelSelector:matchExpressions:- key: appoperator: Invalues:- myapp01topologyKey: kubernetes.io/hostname#如果节点处于 Pod 所在的同一拓扑域且具有键“app”和值“myapp01”的标签, 则该 pod 不应将其调度到该节点上。 (如果 topologyKey 为 kubernetes.io/hostname,则意味着当节点和具有键 “app”和值“myapp01”的 Pod 处于相同的拓扑域,Pod 不能被调度到该节点上。)

kubectl apply -f pod5.yaml

kubectl get pods --show-labels -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES LABELS

myapp01 1/1 Running 0 44m 10.244.1.3 node01 <none> <none> app=myapp01

myapp02 1/1 Running 0 29m 10.244.1.4 node01 <none> <none> app=myapp02

myapp10 1/1 Running 0 75s 10.244.2.4 node02 <none> <none> app=myapp03

示例2:

vim pod6.yaml

apiVersion: v1

kind: Pod

metadata:name: myapp20labels:app: myapp20

spec:containers:- name: myapp20image: soscscs/myapp:v1affinity:podAntiAffinity:requiredDuringSchedulingIgnoredDuringExecution:- labelSelector:matchExpressions:- key: appoperator: Invalues:- myapp01topologyKey: kgc

//由于指定 Pod 所在的 node01 节点上具有带有键 kgc 和标签值 a 的标签,node02 也有这个kgc=a的标签,所以 node01 和 node02 是在一个拓扑域中,反亲和要求新 Pod 与指定 Pod 不在同一拓扑域,所以新 Pod 没有可用的 node 节点,即为 Pending 状态。

kubectl get pod --show-labels -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES LABELS

myapp01 1/1 Running 0 43s 10.244.1.68 node01 <none> <none> app=myapp01

myapp20 0/1 Pending 0 4s <none> <none> <none> <none> app=myapp03

kubectl label nodes node02 kgc=b --overwrite

kubectl get pod --show-labels -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES LABELS

myapp01 1/1 Running 0 7m40s 10.244.1.68 node01 <none> <none> app=myapp01

myapp21 1/1 Running 0 7m1s 10.244.2.65 node02 <none> <none> app=myapp03

污点(Taint) 和 容忍(Tolerations)

污点(Taint)

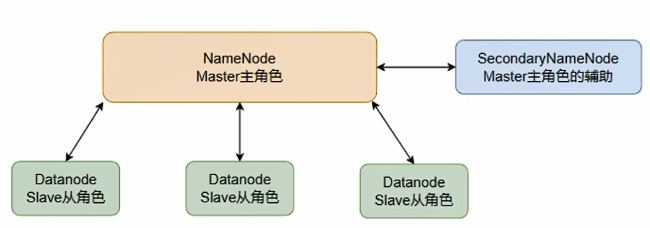

节点亲和性,是Pod的一种属性(偏好或硬性要求),它使Pod被吸引到一类特定的节点。Taint 则相反,它使节点能够排斥一类特定的 Pod。

Taint 和 Toleration 相互配合,可以用来避免 Pod 被分配到不合适的节点上。每个节点上都可以应用一个或多个 taint ,这表示对于那些不能容忍这些 taint 的 Pod,是不会被该节点接受的。如果将 toleration 应用于 Pod 上,则表示这些 Pod 可以(但不一定)被调度到具有匹配 taint 的节点上。

使用 kubectl taint 命令可以给某个 Node 节点设置污点,Node 被设置上污点之后就和 Pod 之间存在了一种相斥的关系,可以让 Node 拒绝 Pod 的调度执行,甚至将 Node 已经存在的 Pod 驱逐出去。

污点的组成格式如下:

key=value:effect

每个污点有一个 key 和 value 作为污点的标签,其中 value 可以为空,effect 描述污点的作用。

当前 taint effect 支持如下三个选项:

●NoSchedule:表示 k8s 将不会将 Pod 调度到具有该污点的 Node 上

●PreferNoSchedule:表示 k8s 将尽量避免将 Pod 调度到具有该污点的 Node 上

●NoExecute:表示 k8s 将不会将 Pod 调度到具有该污点的 Node 上,同时会将 Node 上已经存在的 Pod 驱逐出去

kubectl get nodes

NAME STATUS ROLES AGE VERSION

master Ready master 11d v1.20.11

node01 Ready <none> 11d v1.20.11

node02 Ready <none> 11d v1.20.11

//master 就是因为有 NoSchedule 污点,k8s 才不会将 Pod 调度到 master 节点上

kubectl describe node master

......

Taints: node-role.kubernetes.io/master:NoSchedule

#设置污点

kubectl taint node node01 key1=value1:NoSchedule

#节点说明中,查找 Taints 字段

kubectl describe node node-name

#去除污点

kubectl taint node node01 key1:NoSchedule-

kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

myapp01 1/1 Running 0 4h28m 10.244.2.3 node02 <none> <none>

myapp02 1/1 Running 0 4h13m 10.244.2.4 node02 <none> <none>

myapp03 1/1 Running 0 3h45m 10.244.1.4 node01 <none> <none>

kubectl taint node node02 check=mycheck:NoExecute

//查看 Pod 状态,会发现 node02 上的 Pod 已经被全部驱逐(注:如果是 Deployment 或者 StatefulSet 资源类型,为了维持副本数量则会在别的 Node 上再创建新的 Pod)

kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

myapp03 1/1 Running 0 3h48m 10.244.1.4 node01 <none> <none>

容忍(Tolerations)

设置了污点的 Node 将根据 taint 的 effect:NoSchedule、PreferNoSchedule、NoExecute 和 Pod 之间产生互斥的关系,Pod 将在一定程度上不会被调度到 Node 上。但我们可以在 Pod 上设置容忍(Tolerations),意思是设置了容忍的 Pod 将可以容忍污点的存在,可以被调度到存在污点的 Node 上。

kubectl taint node node01 check=mycheck:NoExecute

vim pod3.yaml

kubectl apply -f pod3.yaml

//在两个 Node 上都设置了污点后,此时 Pod 将无法创建成功

kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

myapp01 0/1 Pending 0 17s <none> <none> <none> <none>

vim pod3.yaml

apiVersion: v1

kind: Pod

metadata:name: myapp01labels:app: myapp01

spec:containers:- name: with-node-affinityimage: soscscs/myapp:v1tolerations:- key: "check"operator: "Equal"value: "mycheck"effect: "NoExecute"tolerationSeconds: 3600

#其中的 key、vaule、effect 都要与 Node 上设置的 taint 保持一致

#operator 的值为 Exists 将会忽略 value 值,即存在即可

#tolerationSeconds 用于描述当 Pod 需要被驱逐时可以在 Node 上继续保留运行的时间

kubectl apply -f pod3.yaml

//在设置了容忍之后,Pod 创建成功

kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

myapp01 1/1 Running 0 10m 10.244.1.5 node01 <none> <none>

//其它注意事项

(1)当不指定 key 值时,表示容忍所有的污点 key

tolerations:

- operator: "Exists"

(2)当不指定 effect 值时,表示容忍所有的污点作用

tolerations:

- key: "key"

operator: "Exists"

(3)有多个 Master 存在时,防止资源浪费,可以如下设置

kubectl taint node Master-Name node-role.kubernetes.io/master=:PreferNoSchedule

//如果某个 Node 更新升级系统组件,为了防止业务长时间中断,可以先在该 Node 设置 NoExecute 污点,把该 Node 上的 Pod 都驱逐出去

kubectl taint node node01 check=mycheck:NoExecute

//此时如果别的 Node 资源不够用,可临时给 Master 设置 PreferNoSchedule 污点,让 Pod 可在 Master 上临时创建

kubectl taint node master node-role.kubernetes.io/master=:PreferNoSchedule

//待所有 Node 的更新操作都完成后,再去除污点

kubectl taint node node01 check=mycheck:NoExecute-

维护操作

//cordon 和 drain

##对节点执行维护操作:

kubectl get nodes

//将 Node 标记为不可调度的状态,这样就不会让新创建的 Pod 在此 Node 上运行

kubectl cordon <NODE_NAME> #该node将会变为SchedulingDisabled状态

//kubectl drain 可以让 Node 节点开始释放所有 pod,并且不接收新的 pod 进程。drain 本意排水,意思是将出问题的 Node 下的 Pod 转移到其它 Node 下运行

kubectl drain <NODE_NAME> --ignore-daemonsets --delete-local-data --force

--ignore-daemonsets:无视 DaemonSet 管理下的 Pod。

--delete-local-data:如果有 mount local volume 的 pod,会强制杀掉该 pod。

--force:强制释放不是控制器管理的 Pod,例如 kube-proxy。

注:执行 drain 命令,会自动做了两件事情:

(1)设定此 node 为不可调度状态(cordon)

(2)evict(驱逐)了 Pod

//kubectl uncordon 将 Node 标记为可调度的状态

kubectl uncordon <NODE_NAME>

//Pod启动阶段(相位 phase)

Pod 创建完之后,一直到持久运行起来,中间有很多步骤,也就有很多出错的可能,因此会有很多不同的状态。

一般来说,pod 这个过程包含以下几个步骤:

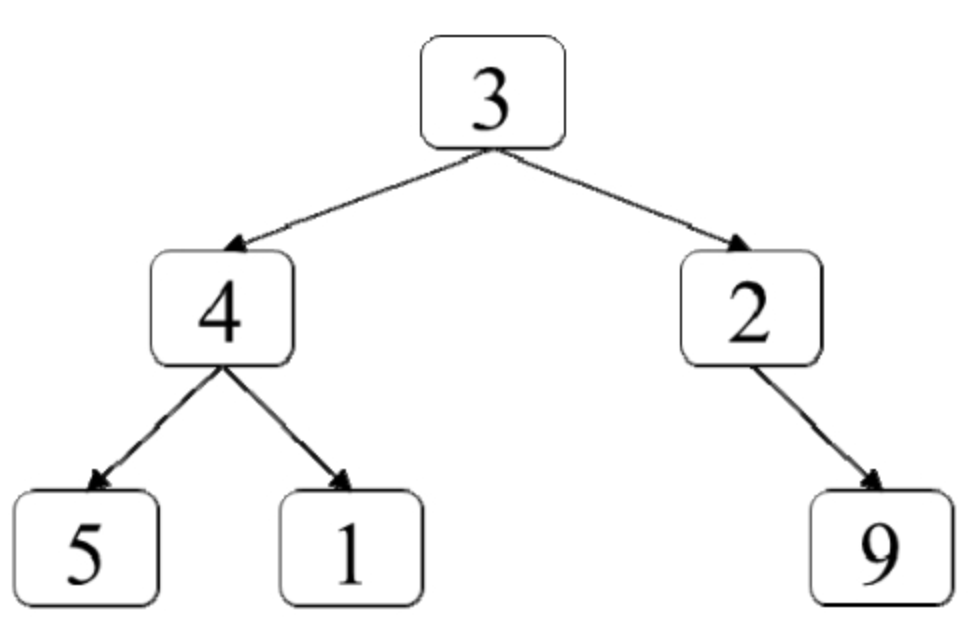

(1)调度到某台 node 上。kubernetes 根据一定的优先级算法选择一台 node 节点将其作为 Pod 运行的 node

(2)拉取镜像

(3)挂载存储配置等

(4)运行起来。如果有健康检查,会根据检查的结果来设置其状态。

phase 的可能状态有:

●Pending:表示APIServer创建了Pod资源对象并已经存入了etcd中,但是它并未被调度完成(比如还没有调度到某台node上),或者仍然处于从仓库下载镜像的过程中。

●Running:Pod已经被调度到某节点之上,并且Pod中所有容器都已经被kubelet创建。至少有一个容器正在运行,或者正处于启动或者重启状态(也就是说Running状态下的Pod不一定能被正常访问)。

●Succeeded:有些pod不是长久运行的,比如job、cronjob,一段时间后Pod中的所有容器都被成功终止,并且不会再重启。需要反馈任务执行的结果。

●Failed:Pod中的所有容器都已终止了,并且至少有一个容器是因为失败终止。也就是说,容器以非0状态退出或者被系统终止,比如 command 写的有问题。

●Unknown:表示无法读取 Pod 状态,通常是 kube-controller-manager 无法与 Pod 通信。

故障排除步骤

//查看Pod事件

kubectl describe TYPE NAME_PREFIX

//查看Pod日志(Failed状态下)

kubectl logs <POD_NAME> [-c Container_NAME]

//进入Pod(状态为running,但是服务没有提供)

kubectl exec –it <POD_NAME> bash

//查看集群信息

kubectl get nodes

//发现集群状态正常

kubectl cluster-info

//查看kubelet日志发现

journalctl -xefu kubelet