目录

- 背景

- 技术方案

- 存在的问题及解决思路

- 关键信息提取结果

- 其他解决方案

- 替换文心一言

- LangChain

- 大型多模态模型(Large Multimodal Model, LMM)

- 开源大模型汇总

- LLaMA —— Meta 大语言模型

- Stanford Alpaca —— 指令调优的 LLaMA 模型

- Lit-LLaMA —— 基于 nanoGPT 的语言模型

- GPT4All —— 基于 LLaMA 的大语言模型

- Chinese-LLaMA

- GLM —— 用于自然语言理解和生成的通用预训练框架

- ChatGLM-6B —— 中英双语对话语言模型

- MLC LLM —— 本地大语言模型

- mPLUG-Owl —— 多模态大语言模型

- 其他模型

背景

最近百度飞桨团队推出了一款基于文心大模型的通用图像关键信息抽取工具PP-ChatOCR。它结合了OCR文字识别和文心一言大语言模型,可以在多种场景下提取图像中的关键信息,效果非常惊艳。而传统的OCR识别技术的准确率容易受到多种因素影响,例如图像质量、字符布局、字体样式等。但当我们将OCR技术与大语言模型相结合时,可以避免繁杂的规则后处理,提升泛化能力,从而能够更智能、准确地理解和利用文本信息。(官方说明)

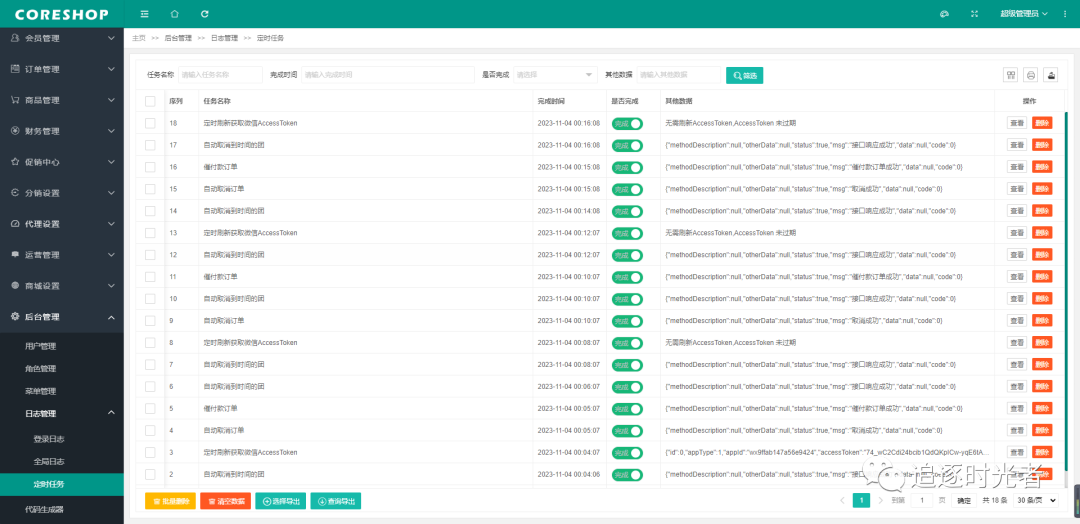

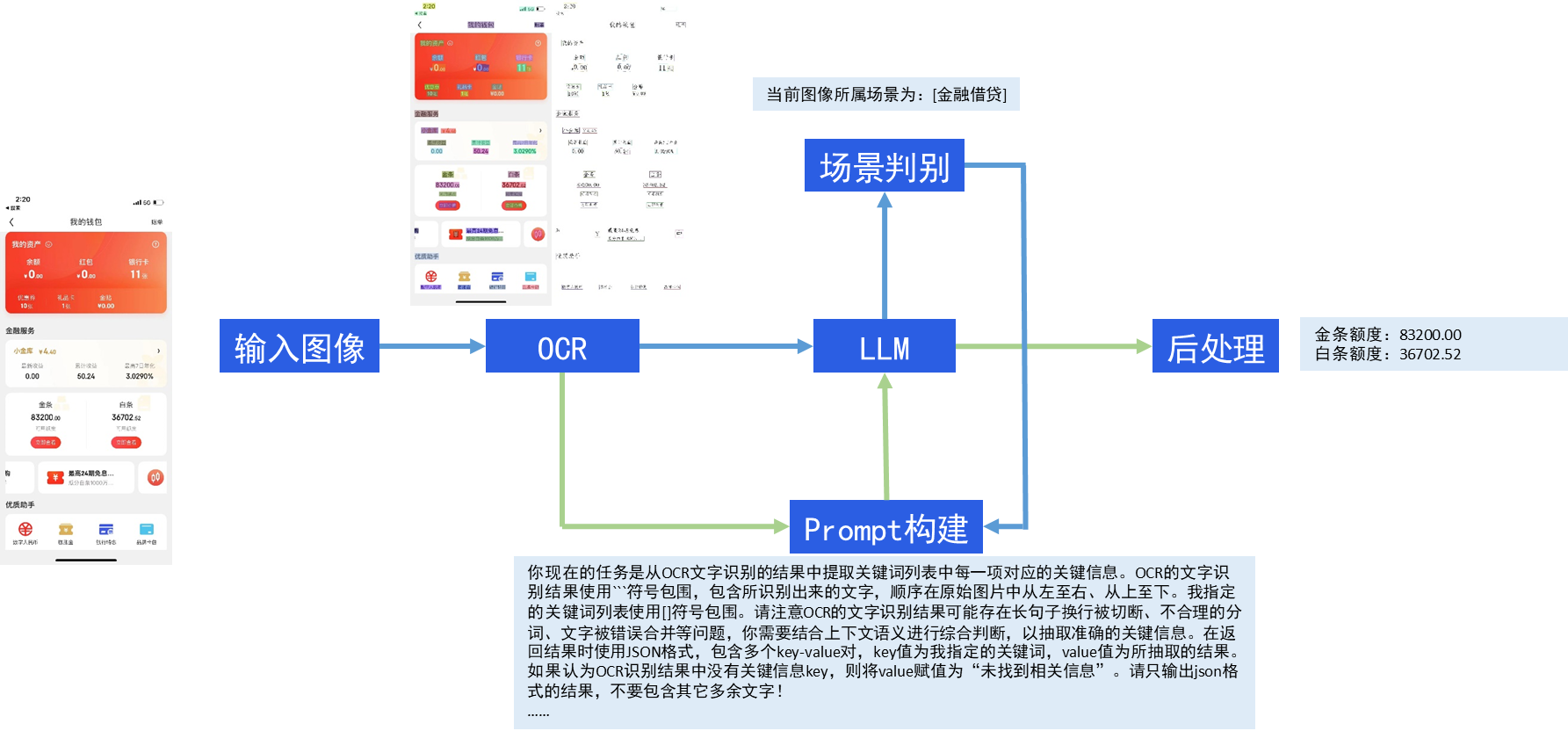

这里以手机app截图为例,定制化提取其中的感兴趣信息。实现OCR模型提取文字信息,输入LLM分析其识别结果直接给出所关注的关键信息——这就是ChatOCR的核心思想。

技术方案

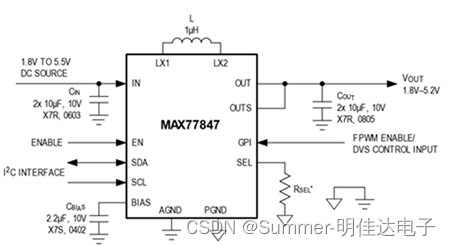

- 文字识别模型:PP-OCRv4;

- LLM:百度“文心一言”

- 开发环境:Python 3.10 + PaddlePaddle深度学习框架

存在的问题及解决思路

- LLM无法100%准确地判别图像所属的场景

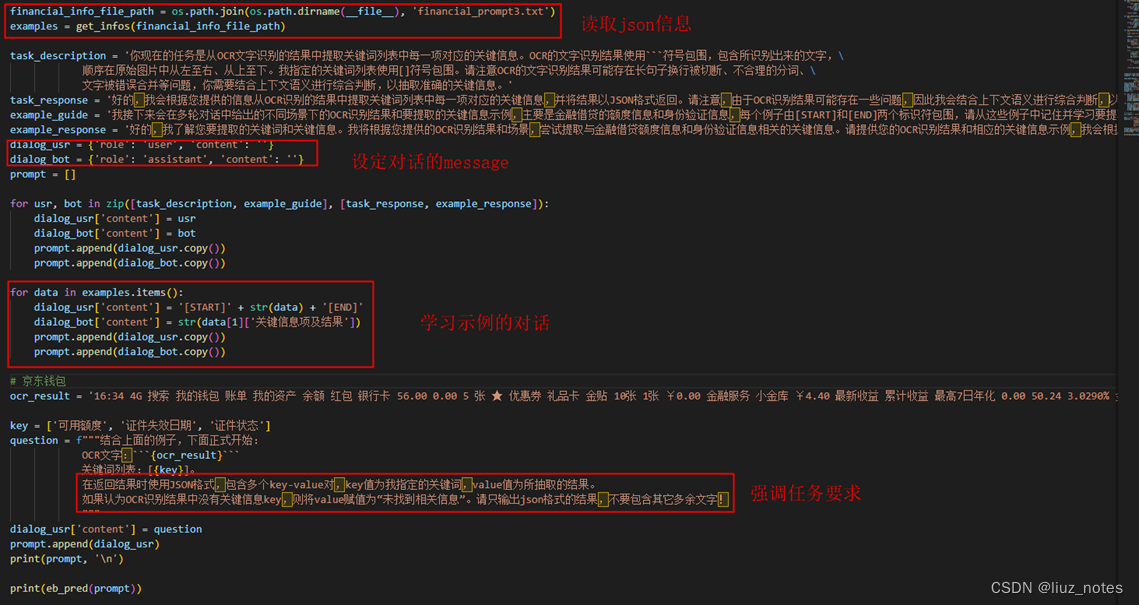

使用官方给出的思路,即给出场景列表,让大模型识别OCR结果属于哪个场景,然后将其作为key去提前写好的few-shot例子中找到对应场景下的信息抽取结果来指导LLM,然后LLM再根据用户提供的关键信息项和OCR结果得到最终的结果。

而这种方式依赖于LLM能准确无误的将OCR结果对应到给定列表中的某一个场景,若OCR结果不属于给定场景列表中的任何一个,或者将其错误的归于其他场景,都会导致关键信息提取失败,前者会使程序报错,而后者可能导致不正确的信息提取结果。(实测非卡证场景识别不稳定)- 解决思路:取消场景识别这一步骤,直接输入相关例子让LLM学习

- 大量场景例子无法一次性喂入LLM

LLM学习的例子太多,token数量的增加会导致成本的上升和推理时间的增加。 ———超过一次输入问题的2000字数限制- 解决思路:构建多轮对话,逐次学习例子

- LLM的记忆遗忘

多轮对话中bot的回应需要自己写,这个上下文信息会影响到后续的推理结果。对话轮数(例子)越多,LLM对前文的记忆越弱,导致忘记任务要求。- 解决思路:in-context learning prompt工程

关键信息提取结果

注:第二个结果图中可用额度信息不正确是由于OCR提取不准确导致的,不是LLM导致。

其他解决方案

替换文心一言

参考链接:https://aistudio.baidu.com/projectdetail/6629280

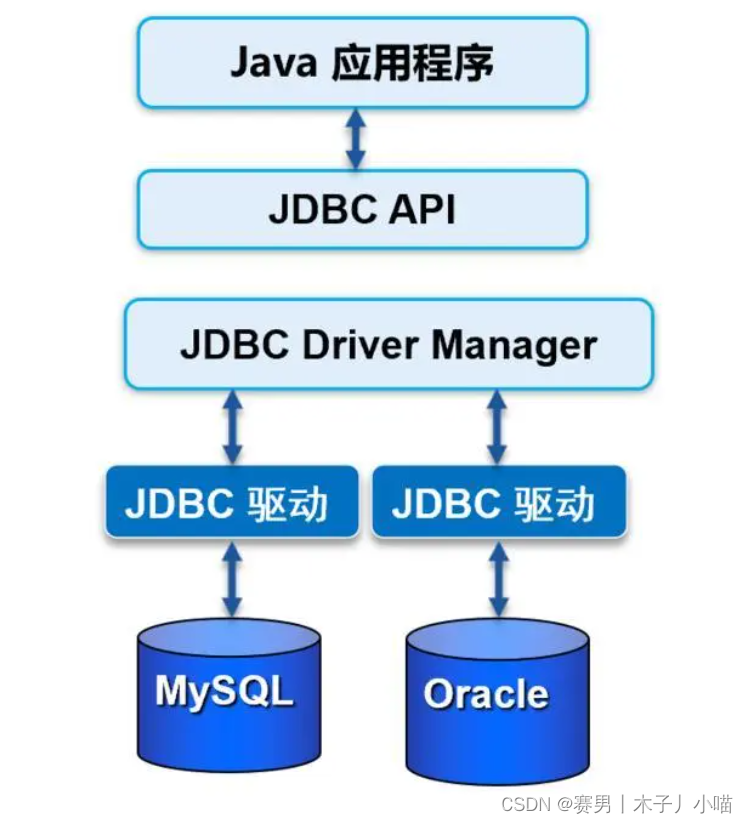

LangChain

一个基于LLM来开发应用程序的框架,提供Chain接口来继承各种LLM相关模块。可以读取结构化或非结构化数据,然后用LLM来进行信息摘要或信息提取。高度集成化,支持众多模型和工具。

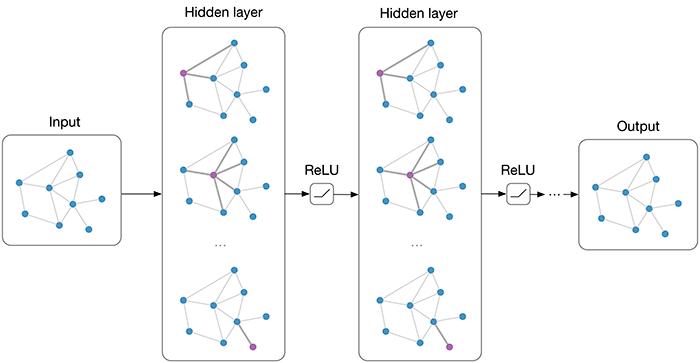

大型多模态模型(Large Multimodal Model, LMM)

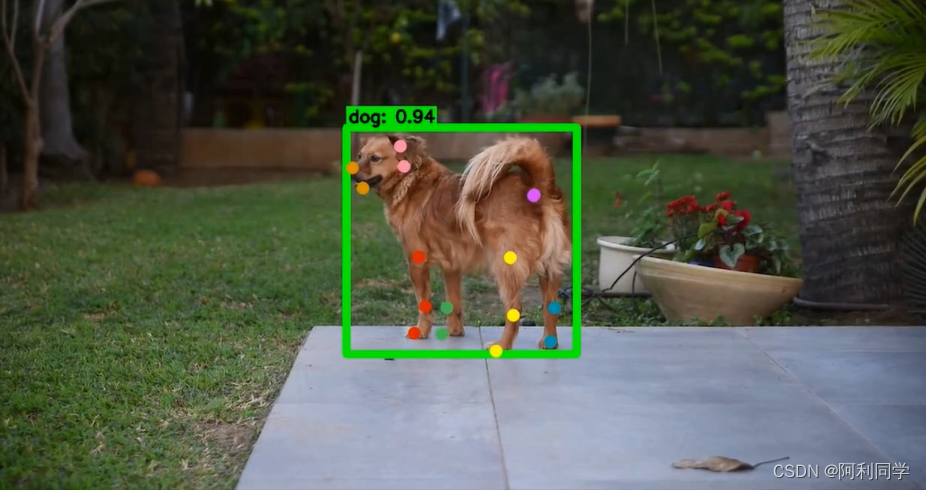

直接使用目前的SOTA LMM来在业务场景下的OCR图片集上fine-tune,然后进行OCR-VQA或者关键信息提取。

- 论文:On the Hidden Mystery of OCR in Large Multimodal Models, Arxiv 2023.

- 文章在多个Text及OCR benchmark上测试了目前的LMMs的Zero-Shot迁移性能,给出了利用LMM提升OCR识别性能的思路。

开源大模型汇总

以下仅列出主要的、关键的、常用的大模型。

LLaMA —— Meta 大语言模型

LLaMA 语言模型全称为 “Large Language Model Meta AI”,是 Meta 的全新大型语言模型(LLM),这是一个模型系列,根据参数规模进行了划分(分为 70 亿、130 亿、330 亿和 650 亿参数不等)。

其中 LaMA-13B(130 亿参数的模型)尽管模型参数相比 OpenAI 的 GPT-3(1750 亿参数) 要少了十几倍,但在性能上反而可以超过 GPT-3 模型。更小的模型也意味着开发者可以在 PC 甚至是智能手机等设备上本地运行类 ChatGPT 这样的 AI 助手,无需依赖数据中心这样的大规模设施。

Stanford Alpaca —— 指令调优的 LLaMA 模型

Stanford Alpaca是一个指令调优的 LLaMA 模型,从 Meta 的大语言模型 LLaMA 7B 微调而来。

Stanford Alpaca 让 OpenAI 的 text-davinci-003 模型以 self-instruct 方式生成 52K 指令遵循(instruction-following)样本,以此作为 Alpaca 的训练数据。

在测试中,Alpaca 的很多行为表现都与 text-davinci-003 类似,且只有 7B 参数的轻量级模型 Alpaca 性能可与 GPT-3.5 这样的超大规模语言模型性能媲美。

Lit-LLaMA —— 基于 nanoGPT 的语言模型

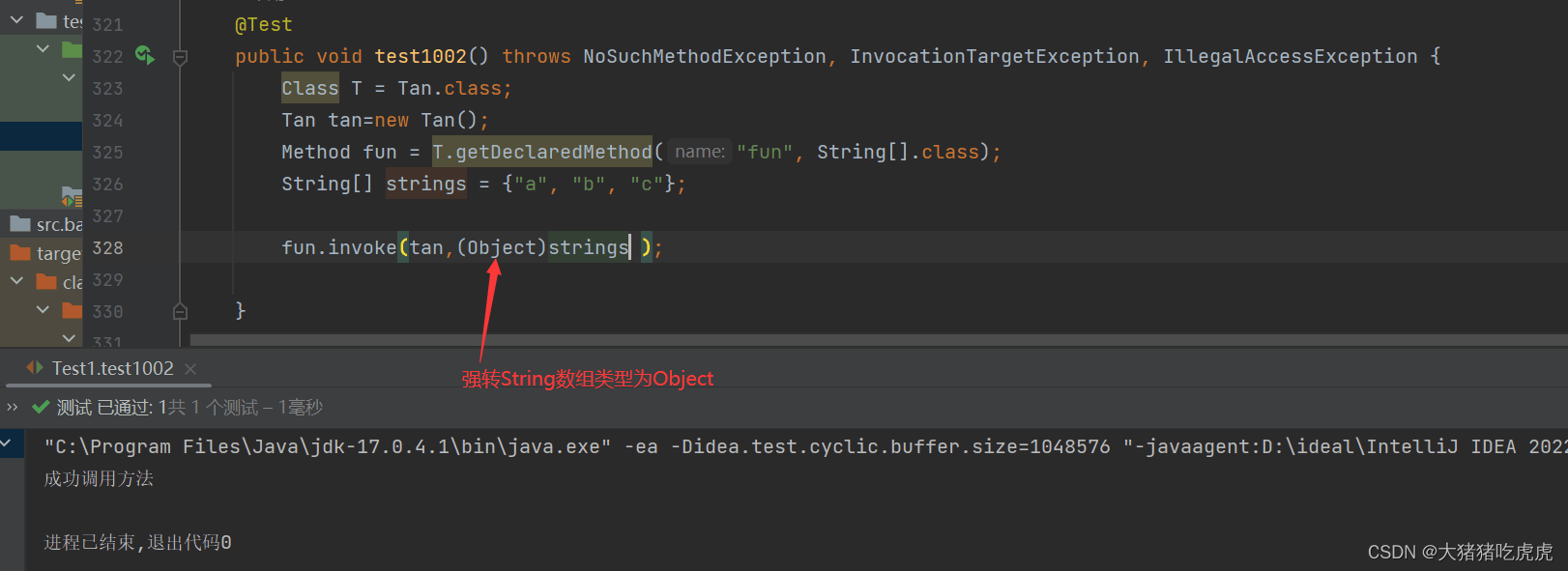

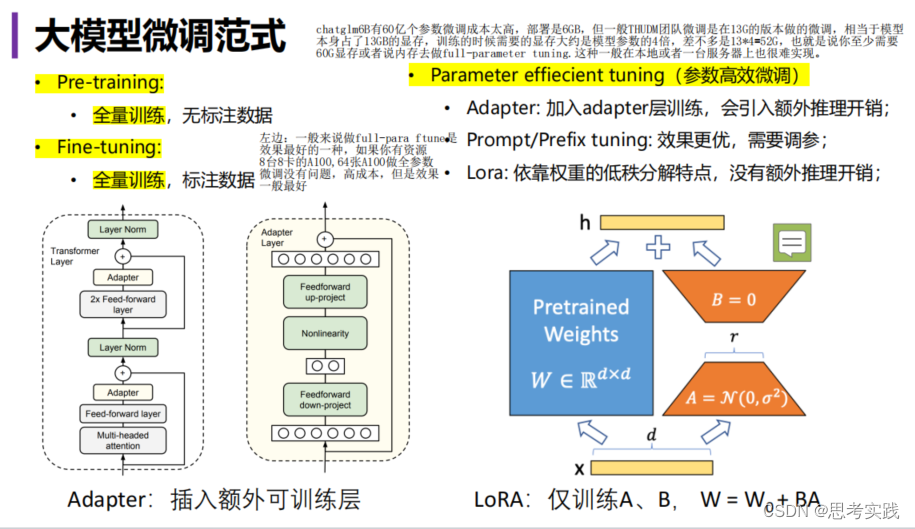

Lit-LLaMA 是一个基于 nanoGPT 的 LLaMA 语言模型的实现,支持量化、LoRA 微调、预训练、flash attention、LLaMA-Adapter 微调、Int8 和 GPTQ 4bit 量化。

主要特点:单一文件实现,没有样板代码;在消费者硬件上或大规模运行;在数值上等同于原始模型。

Lit-LLaMA认为人工智能应该完全开源并成为集体知识的一部分。但原始的 LLaMA 代码采用 GPL 许可证,这意味着使用它的任何项目也必须在 GPL 下发布。这 “污染” 了其他代码,阻止了与生态系统的集成。Lit-LLaMA使用Apache 2.0协议,永久性地解决了这个问题。

GPT4All —— 基于 LLaMA 的大语言模型

GPT4All是基于 LLaMa 的~800k GPT-3.5-Turbo Generations 训练出来的助手式大型语言模型,这个模型接受了大量干净的助手数据的训练,包括代码、故事和对话,提供的模型性能接近text-davinci-003。

给出了多平台的桌面版应用,可以在本地的CPU上运行。同时提供Python的API,可以在本地自己调用下载好的模型完成问答。

Chinese-LLaMA

1、Chinese-LLaMA-Alpaca

在Apache-2.0协议下开源了中文LLaMA模型和指令精调的Alpaca大模型,以进一步促进大模型在中文NLP社区的开放研究。这些模型在原版LLaMA的基础上扩充了中文词表并使用了中文数据进行二次预训练,进一步提升了中文基础语义理解能力。同时,中文Alpaca模型进一步使用了中文指令数据进行精调,显著提升了模型对指令的理解和执行能力。文档全面,支持本地推理部署,还在持续更新。

2、Chinese-Vicuna —— 一个中文低资源的LLaMA+lora方案

A Chinese Instruction-following LLaMA-based Model。项目目的是希望基于LLaMA+instruction数据构建一个中文的羊驼模型,并帮助大家能快速学会使用引入自己的数据,并训练出属于自己的小羊驼(Vicuna)。

方案的优势是参数高效,显卡友好,部署简易:

- 在一张2080Ti(11G)上可以对Llama-7B进行指令微调 (7b-instruct)

- 在一张3090(24G)上可以对Llama-13B进行指令微调 (13b-instruct)

- 即使是长度为2048的对话,在3090上也可以完成Llama-7B的微调;使用5万条数据即可有不错效果 (chatv1)

- 领域微调的例子:医学问答 和 法律问答。(medical and legal)

- 支持qlora-4bit,使用4bit可以在2080Ti上完成13B的训练

可在2080Ti/3090上轻松部署,支持多卡同时推理,可进一步降低显存占用

项目包括

- finetune模型的代码

- 推理的代码

- 仅使用CPU推理的代码 (使用C++)

- 下载/转换/量化Facebook llama.ckpt的工具

- 其他应用

- 详细文档

3、伶荔 (Linly) —— 大规模中文语言模型

深圳大学与腾讯AI Lab推出。相比已有的中文开源模型,伶荔模型具有以下优势:

- 在 32*A100 GPU 上训练了不同量级和功能的中文模型,对模型充分训练并提供强大的 baseline。据知,33B 的 Linly-Chinese-LLAMA 是目前最大的中文 LLaMA 模型。

- 公开所有训练数据、代码、参数细节以及实验结果,确保项目的可复现性,用户可以选择合适的资源直接用于自己的流程中。

- 项目具有高兼容性和易用性,提供可用于 CUDA 和 CPU 的量化推理框架,并支持 Huggingface 格式。

目前公开可用的模型有:

- Linly-Chinese-LLaMA-2 (7B、13B) 模型:使用 LLaMA2 扩充中文词表,在混合语料上进行增量预训练,模型仍在迭代中,将定期更新模型权重。

- Linly-Chinese-Falcon(7B): Chinese-Falcon 模型在 Falcon 基础上扩充中文词表,在中英文数据上增量预训练。模型以 Apache License 2.0 协议开源,支持商业用途。

- Linly-Chinese-LLaMA:中文基础模型,基于 LLaMA 在高质量中文语料上增量训练强化中文语言能力,现已开放 7B、13B 和 33B 量级,65B 正在训练中。

- Linly-ChatFlow:中文对话模型,在 400 万指令数据集合上对中文基础模型指令精调,现已开放 7B、13B 对话模型。

- Linly-ChatFlow-int4 :ChatFlow 4-bit 量化版本,用于在 CPU 上部署模型推理。

GLM —— 用于自然语言理解和生成的通用预训练框架

GLM (General Language Model)是清华大学推出的一种使用自回归填空目标进行预训练的通用语言模型,可以针对各种自然语言理解和生成任务进行微调。

GLM 通过添加 2D 位置编码并允许以任意顺序预测跨度来改进空白填充预训练,从而在 NLU 任务上获得优于 BERT 和 T5 的性能。同时,GLM 可以通过改变空白的数量和长度对不同类型的任务进行预训练。在横跨 NLU、条件和无条件生成的广泛任务上,GLM 在给定相同的模型大小和数据的情况下优于 BERT、T5 和 GPT,并从单一的预训练模型中获得了 1.25 倍 BERT Large 参数的最佳性能,表明其对不同下游任务的通用性。

关于 GLM 的详细描述可参考论文 GLM: General Language Model Pretraining with Autoregressive Blank Infilling (ACL 2022)

ChatGLM-6B 就是在 GLM 框架的基础上为中文 QA 和对话进行了优化。

ChatGLM-6B —— 中英双语对话语言模型

ChatGLM-6B()是一个开源的、支持中英双语问答的对话语言模型,并针对中文进行了优化。该模型基于 General Language Model (GLM) 架构,具有62亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。

ChatGLM-6B 使用了GLM框架,针对中文问答和对话进行了优化。经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62亿参数的 ChatGLM-6B 虽然规模不及千亿模型,但大大降低了推理成本,提升了效率,并且已经能生成相当符合人类偏好的回答。

MLC LLM —— 本地大语言模型

MLC LLM是一种通用解决方案,它允许将任何语言模型本地部署在各种硬件后端和本地应用程序上。

此外,MLC LLM 还提供了一个高效的框架,供使用者根据需求进一步优化模型性能。MLC LLM 旨在让每个人都能在个人设备上本地开发、优化和部署 AI 模型,而无需服务器支持,并通过手机和笔记本电脑上的消费级 GPU 进行加速。

mPLUG-Owl —— 多模态大语言模型

阿里达摩院提出的多模态 GPT 的模型:mPLUG-Owl,基于 mPLUG 模块化的多模态大语言模型。它不仅能理解推理文本的内容,还可以理解视觉信息,并且具备优秀的跨模态对齐能力。

- 论文:https://arxiv.org/abs/2304.14178

- DEMO:https://huggingface.co/spaces/MAGAer13/mPLUG-Owl

其他模型

- 开源LLM汇总及相关工具

- GitHub: Awesome-Chinese-LLM(中文LLM相关)

![[动态规划] (七) 路径问题:LCR 166.剑指offer 47. 珠宝的最高价值](https://img-blog.csdnimg.cn/img_convert/5dfc9ff7d9bd1eb623c8db2f7f032a58.png)