No.75

智源社区

强化学习组

强

化

学

习

研究

观点

资源

活动

社区热门文章

Google发布Bard与ChatGPT竞争

https://hub.baai.ac.cn/view/23925

纽约时报:ChatGPT诞生背后的故事

https://hub.baai.ac.cn/view/23835

ChatGPT提示与AI工具、开发工具、低代码工具汇总

《AI Prompts and Tools》

https://hub.baai.ac.cn/view/23771

谷歌Jason Wei :AI研究的四项基本技

https://hub.baai.ac.cn/view/23959

关于周刊

强化学习作为人工智能领域研究热点之一,其在人工智能领域以及学科交叉研究中的突出表现,引起越来越多的研究人员对该领域的关注。为更好地服务相关研究人员及时了解强化学习领域的研究进展以及科研资讯,智源社区结合以前工作基础及读者反馈,在论文推荐基础之上新增科研资讯、学术讲座、强化学习教程、相关招聘等板块,撰写为第75期《强化学习周刊》以飨诸位。

周刊采用社区协作的模式产生,欢迎感兴趣的朋友们参与我们的工作,一起来推动强化学习社群的分享、学习和交流活动。社区将定期为推动强化学习社群建设表现优异的同学提供精美的奖品。可以扫描文末的二维码加入强化学习社区群。

本期贡献者:(李明,刘青、小胖)

论文推荐

强化学习已经成为人工智能研究领域的热点,其在各个应用领域中取得了瞩目的成就。《强化学习周刊》共分三个板块,论文推荐板块为读者梳理了最近强化学习在自然语言处理方面应用相关研究论文;另外论文综述板块为读者介绍, University of Technology Sydney的强化学习中的这些安全和隐私问题的综述。本次教程推荐板块介绍来自斯坦福大学CS234:强化学习(2023)教学课程。本课程将提供强化学习领域的坚实介绍,学生将学习核心挑战和方法,包括概括和探索。通过讲座、书面和编码作业的结合,学生将精通RL的关键思想和技术。

标题:Evaluation Beyond Task Performance: Analyzing Concepts in AlphaZero in Hex(Brown University |超越任务绩效的评估:用十六进制分析AlphaZero中的概念)

简介:AlphaZero是一种结合了神经网络和蒙特卡洛树搜索(MCTS)的强化学习方法,它为国际象棋、围棋、将棋和Hex等传统棋类游戏制定了最先进的策略。尽管研究人员和游戏评论员认为AlphaZero使用了人类认为重要的概念,但尚不清楚这些概念是如何在网络中被捕获的。我们使用自然语言处理(NLP)的两种评估技术:模型探测和行为测试,研究了AlphaZero在Hex游戏中的内部表示。在这样做的过程中,我们向RL社区引入了新的评估工具,并说明了如何使用任务绩效以外的评估来更完整地描述模型的优点和缺点。我们在Hex游戏中的分析揭示了有趣的模式,并产生了一些关于此类模型如何学习的可测试假设。例如,我们发现MCTS在神经网络学习对概念进行编码之前就发现了概念。我们还发现,与短期游戏结束规划相关的概念最好编码在模型的最后一层,而与长期规划有关的概念编码在模型中间层。

论文链接:https://arxiv.org/pdf/2211.14673.pdf

标题:Towards Semantic Communications: Deep Learning-Based Image Semantic Coding(清华大学 | 面向语义通信:基于深度学习的图像语义编码)

简介:语义通信越来越受到人们的关注,因为它可以显著减少要传输的数据量,而不会丢失关键信息。在本文中,论文设想了图像数据的语义通信,它在语义和带宽方面更加丰富。论文提出了一种基于强化学习的自适应语义编码(RL-ASC)方法,该方法将图像编码到像素级之外。首先,论文定义了图像数据的语义概念,包括类别、空间排列和视觉特征作为表示单元,并提出了一种卷积语义编码器来提取语义概念。其次,提出了从传统的像素相似度到语义相似度和感知性能的图像重建标准。第三,设计了一种新的基于RL的语义比特分配模型,其奖励是在编码具有自适应量化级别的特定语义概念后,语义感知性能的提高。因此,任务相关信息被适当地保存和重建,而不太重要的数据被丢弃。最后,提出了基于生成对抗网(GAN)的语义解码器,该解码器通过关注模块融合局部和全局特征。实验结果表明,与标准编解码器和其他基于深度学习的图像编解码器相比,所提出的RL-ASC具有噪声鲁棒性,能够重建视觉上愉悦且语义一致的图像,并且节省了几倍的比特成本。

论文链接:https://arxiv.org/pdf/2208.04094.pdf

标题:LAMBADA: Backward Chaining for Automated Reasoning in Natural Language(谷歌 | LAMBADA:自然语言中反向链自动推理)

简介:通过使用大型语言模型(LMs)的强大功能以及思维链提示和选择推理等方法,在使用指定为非结构化自然文本的知识进行自动推理方面取得了显著进展。这些技术在从公理到结论的正向方向上搜索证明,这会导致搜索空间的组合爆炸,因此对于需要较长推理链的问题,失败率很高。经典的自动推理文献表明,反向推理(即从预期结论到支持它的公理集)在证据发现问题上效率明显更高。论文将这种直觉引入到LM设置中,并开发了一种反向链接算法,称之为LAMBADA,该算法将推理分解为四个子模块,每个子模块都可以简单地通过少数镜头提示的LM推理来实现。论文结果表明,LAMBADA在两个具有挑战性的逻辑推理数据集上实现了比最先进的正向推理方法更高的精度,特别是在需要深度和准确的证明链时。

论文链接:https://arxiv.org/pdf/2212.13894.pdf

标题:Improving a sequence-to-sequence nlp model using a reinforcement learning policy algorithm(西迪 · 穆罕默德 · 本 · 阿卜杜拉大学: Jabri Ismail|使用强化学习策略算法改进序列到序列NLP模型)

简介:如今,当前的对话生成神经网络模型(聊天机器人)展示出为聊天智能体生成答案的巨大希望。但是它们是短视的,因为其一次只预测一个话语,而忽略了它们对未来结果的影响。为对话的未来方向建模对于生成连贯、有趣的对话至关重要,这种需求导致了依赖强化学习的传统 NLP 对话模型。本文将解释如何通过使用深度强化学习来预测聊天机器人对话中未来的奖励,从而将这些目标结合起来。该模型模拟两个虚拟智能体之间的对话,使用策略梯度方法来奖励表现出三个有用对话特征的序列:非正式的流动、连贯性、和响应的简单性(与前瞻性功能相关)。本研究根据其多样性、长度和复杂性来评估模型。在对话模拟中,评估表明,所提出的模型会产生更多的互动反应,并鼓励更持久的成功对话。这项工作是为了纪念成功发展一个基于长期对话的神经会话模型的第一步。

论文链接:https://arxiv.org/abs/2212.14117

标题:Is Reinforcement Learning (Not) for Natural Language Processing?: Benchmarks, Baselines, and Building Blocks for Natural Language Policy Optimization(Fraunhofer IAIS: Rajkumar Ramamurthy|强化学习用于自然语言处理?自然语言策略优化的基准、基线和构建块)

简介:本文解决了将预训练的大型语言模型 (LM) 与人类偏好对齐的问题。如果将文本生成视为一个顺序决策问题,那么强化学习 (RL) 似乎是一个自然的概念框架。然而,使用 RL 进行基于 LM 的生成面临着经验挑战,包括由于组合动作空间导致的训练不稳定性,以及缺乏为 LM 对齐定制的开源库和基准。本文首先介绍了一个开源模块化库 RL4LMs,用于使用 RL 优化语言生成器。该库由在线策略 RL 算法组成,可用于训练 HuggingFace 库中具有任意奖励函数的LM。接下来,提出了GRUE基准,这是一组 6 种语言生成任务,这些任务不是由目标字符串监督,而是由捕获人类偏好的自动测量的奖励函数监督。GRUE 是首个排行榜样式评估用于 NLP 任务的 RL 算法。最后,介绍了一种易于使用、高性能的 RL 算法,NLPO,该算法学习有效地减少语言生成中的组合动作空间。

论文链接:https://arxiv.org/pdf/2210.01241.pdf

标题:Dependency Parsing with Backtracking using Deep Reinforcement Learning(CNRS: Franck Dary|使用深度强化学习进行回溯的依赖解析)

简介:NLP 的贪心算法(例如基于转换的解析)容易产生错误传播。克服这个问题的一种方法是允许算法回溯并在新证据与迄今为止探索的解决方案相矛盾的情况下探索替代解决方案。为了实现这种行为,本文使用强化学习并让算法回溯,以防这种行为比继续探索当前解决方案获得更好的回报。本文在 POS 标记和依赖解析上测试了这个想法,并表明回溯是对抗错误传播的有效手段。

论文链接:https://arxiv.org/pdf/2206.13914.pdf

标题:SupervisorBot: NLP-Annotated Real-Time Recommendations of Psychotherapy Treatment Strategies with Deep Reinforcement Learning(哥伦比亚大学: Baihan Lin|SupervisorBot:带有深度强化学习的心理治疗策略的 NLP 注释实时建议)

简介:本文提出了一个推荐系统,可以在心理治疗期间实时向治疗师建议治疗策略。本文的系统使用轮流等级评级机制,通过计算评分清单的深度嵌入与患者正在说的当前句子之间的相似性分数来预测治疗结果。该系统自动转录连续的音频流,并使用在线免注册的分类方法将其分成患者和治疗师的轮流。然后将对话对及其计算评分输入深度强化学习推荐器,其中会话被视为用户,主题被视为项目。除了评估现有数据集上核心组件的经验优势之外,本研究还在一个 Web 应用程序中验证了该系统的有效性。

论文链接:https://arxiv.org/pdf/2208.13077.pdf

标题:Addressing Optimism Bias in Sequence Modeling for Reinforcement Learning(卡内基·梅隆大学: Adam Villaflor|解决强化学习序列建模中的乐观偏差)

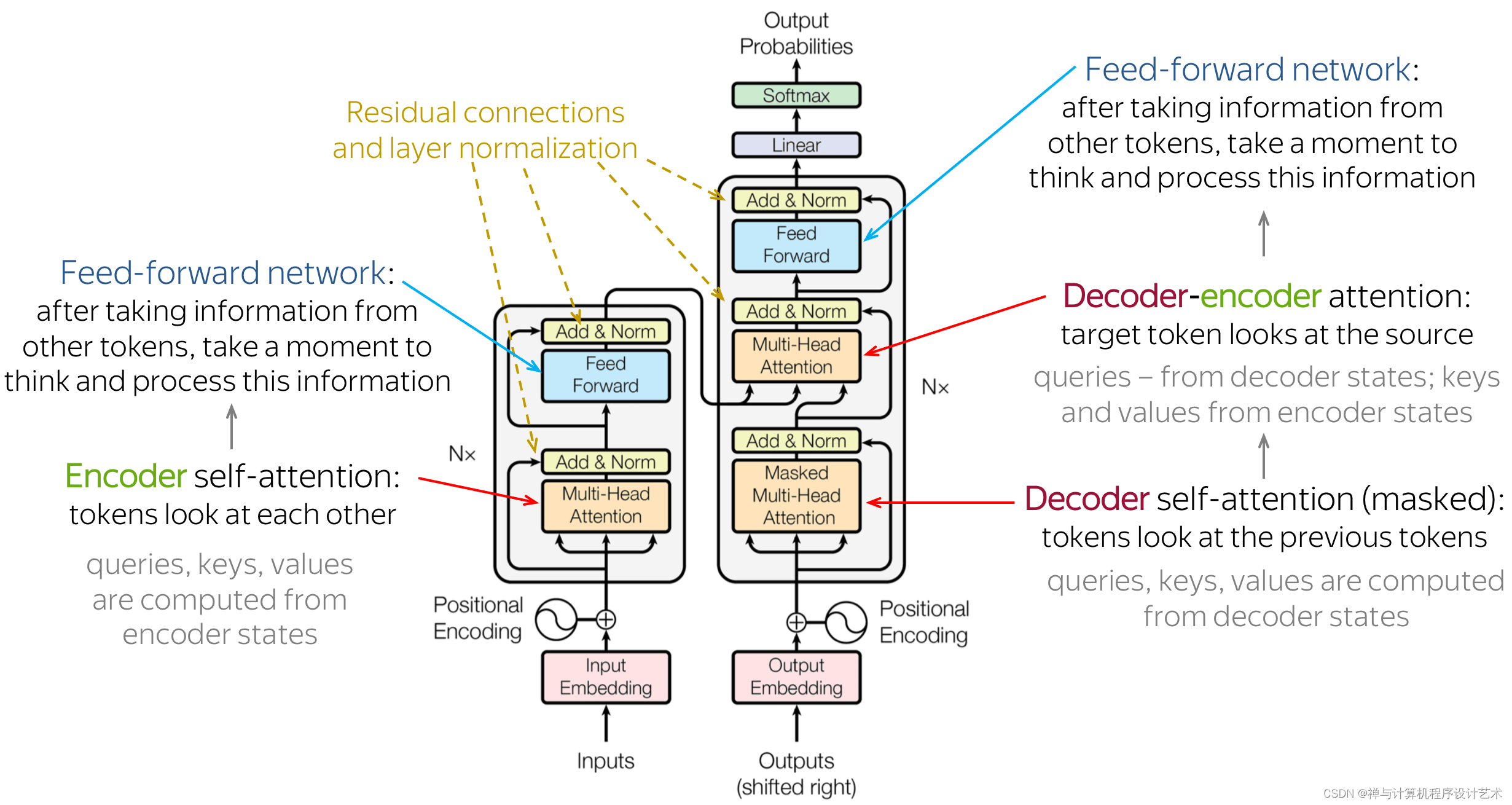

简介:基于 Transformer 神经网络架构的自然语言处理 (NLP) 的令人印象深刻的结果启发了研究人员探索将离线强化学习 (RL) 视为通用序列建模问题。最近基于这种范式的工作已经在几个最确定的离线 Atari 和 D4RL 基准测试中取得了最先进的结果。然而,由于这些方法将状态和行动共同建模为一个单一的排序问题,因此它们难以理清政策和世界动态对回报的影响。因此,在对抗性或随机环境中,这些方法会导致过于乐观的行为,这在自动驾驶等安全关键系统中可能是危险的。本文提出了一种通过明确分离政策和世界模型来解决这种乐观偏见的方法,能够在测试时搜索对环境中多种可能的未来具有鲁棒性的政策。本文在模拟中展示了作者的方法在各种自动驾驶任务中的卓越性能。

论文链接:https://arxiv.org/pdf/2207.10295.pdf

标题:RLPrompt: Optimizing Discrete Text Prompts with Reinforcement Learning(卡内基·梅隆大学: Mingkai Deng|RLPrompt:使用强化学习优化离散文本提示)

简介:提示在使大型预训练语言模型(LMs)能够执行各种NLP任务方面取得了令人印象深刻的成功,尤其是当只有很少的下游数据可用时。然而,自动为每个任务找到最佳提示是一项挑战。大多数现有的工作都依赖于调整软提示,这在可解释性、跨LMs的可重用性以及梯度不可访问时的适用性方面存在不足。另一方面,离散提示很难优化,通常是通过“枚举-然后选择”启发式方法创建的,这些启发式方法没有系统地探索提示空间。本文提出了一种具有强化学习(RL)的高效离散提示优化方法RLPrompt。RLPrompt制定了一个参数有效的策略网络,该网络在有奖励的训练之后生成期望的离散提示。为了克服大型LM环境中奖励信号的复杂性和随机性,作者引入了有效的奖励稳定,这大大提高了训练效率。RLPrompt可灵活应用于不同类型的LMs,例如掩码和从左到右的模型,用于分类和生成任务。在少数镜头分类和无监督文本风格转换上的实验表明,与现有的各种微调或提示方法相比,具有更高的性能。

论文链接:https://arxiv.org/pdf/2205.12548.pdf

最新综述

标题:New Challenges in Reinforcement Learning: A Survey of Security and Privacy(强化学习的新挑战:安全和隐私综述)

简介:强化学习(RL)是人工智能最重要的分支之一。由于其在动态环境中的自适应和决策能力,强化学习已广泛应用于医疗保健、数据市场、自动驾驶和机器人等多个领域。然而,这些应用程序和系统中的一些已被证明容易受到安全或隐私攻击,从而导致服务不可靠或不稳定。大量研究集中于强化学习中的这些安全和隐私问题。然而,很少有综述对现有问题和最先进的解决方案进行系统审查和比较,以跟上新出现的威胁的步伐。因此,该问在此提出了这样一个全面的综述,以从一个新的角度,即马尔可夫决策过程(MDP),解释和总结强化学习中与安全和隐私相关的挑战。在综述中,首先介绍与该领域相关的关键概念。接下来,分别讨论与MDP流程的状态、操作、环境和奖励功能相关的安全和隐私问题,进一步强调了与强化学习相关的安全和隐私方法的特殊特征。最后,讨论了该领域未来可能的研究方向。

论文链接:https://arxiv.org/pdf/2301.00188.pdf

教程推荐

标题:斯坦福大学CS234:强化学习(2023)

简介:要实现人工智能的梦想和影响,需要学习做出正确决策的自主系统。强化学习是实现这一目标的一个强大范例,它与大量任务相关,包括机器人、游戏、消费者建模和医疗保健。本课程将提供强化学习领域的坚实介绍,学生将学习核心挑战和方法,包括概括和探索。通过讲座、书面和编码作业的结合,学生将精通RL的关键思想和技术。作业将包括强化学习和深度强化学习的基础知识,这是一个非常有前途的新领域,将深度学习技术与强化学习相结合。

教程链接:https://web.stanford.edu/class/cs234/

如果你正在从事或关注 强化学习研究、实现与应用,欢迎加入“智源社区-强化学习-交流群”。你可以:

学习前沿知识、求解疑难困惑

分享经验心得、展示风貌才华

参与专属活动、结识研究伙伴

扫描下方二维码,加入强化学习兴趣群