【大模型】LLM显存占用对比:Qwen-7B-Chat,Qwen-14B-Chat-Int8,chatglm3-6b

- 显存占用对比:

- 总结

- 参考

显存占用对比:

显卡:NVIDIA GeForce RTX 4090

系统环境:ubuntu 22.04LTS

-

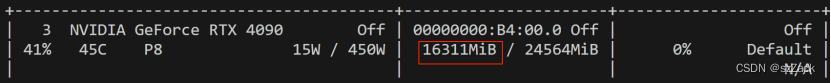

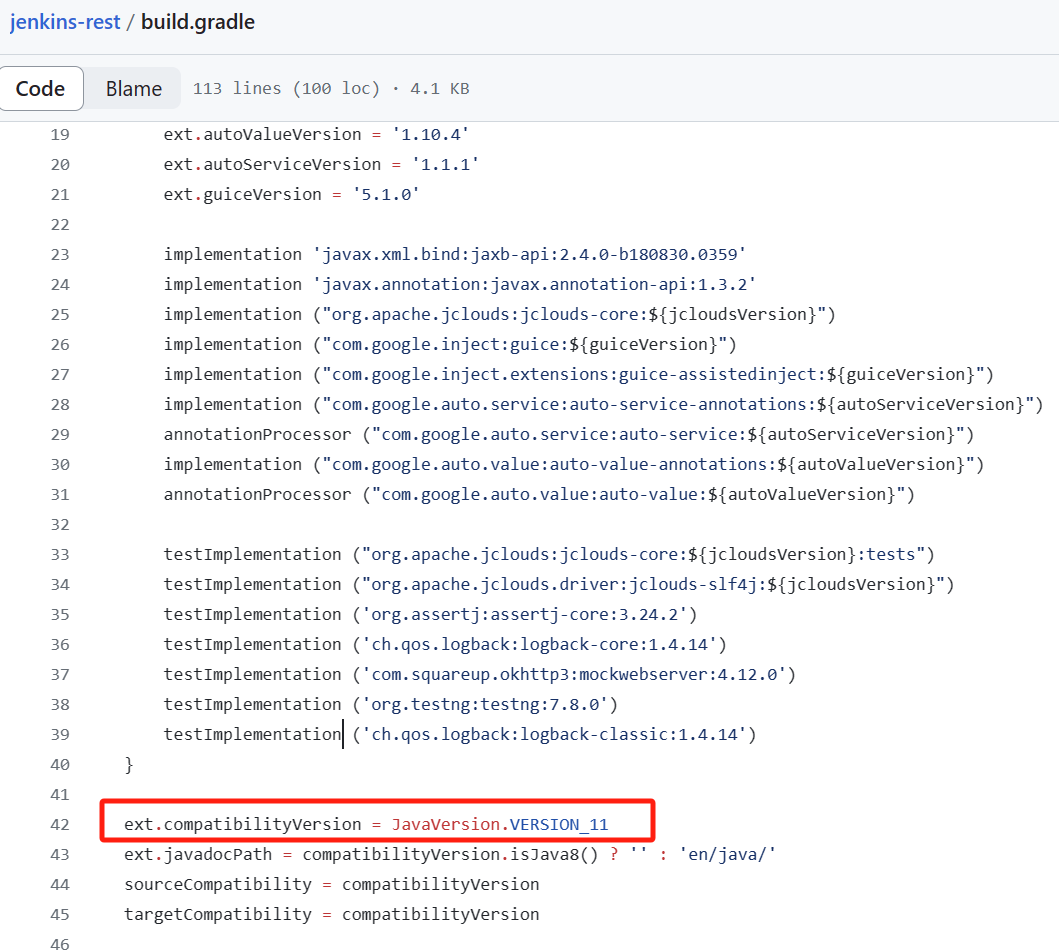

Qwen-14B-Chat-Int8

模型:qwen/Qwen-14B-Chat-Int8

GPU占用:

-

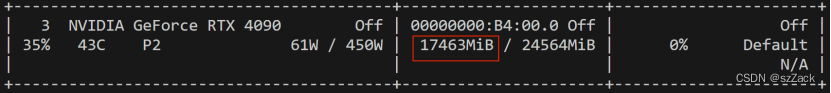

Qwen-7B-Chat

模型:qwen/Qwen-7B-Chat(bf16, fp16)

GPU占用:

-

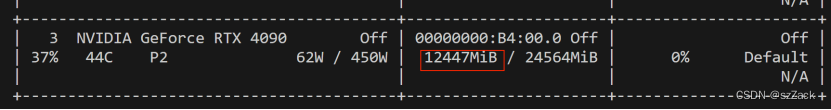

chatglm3-6b

模型:ZhipuAI/chatglm3-6b(bf16, fp16)

GPU占用:

总结

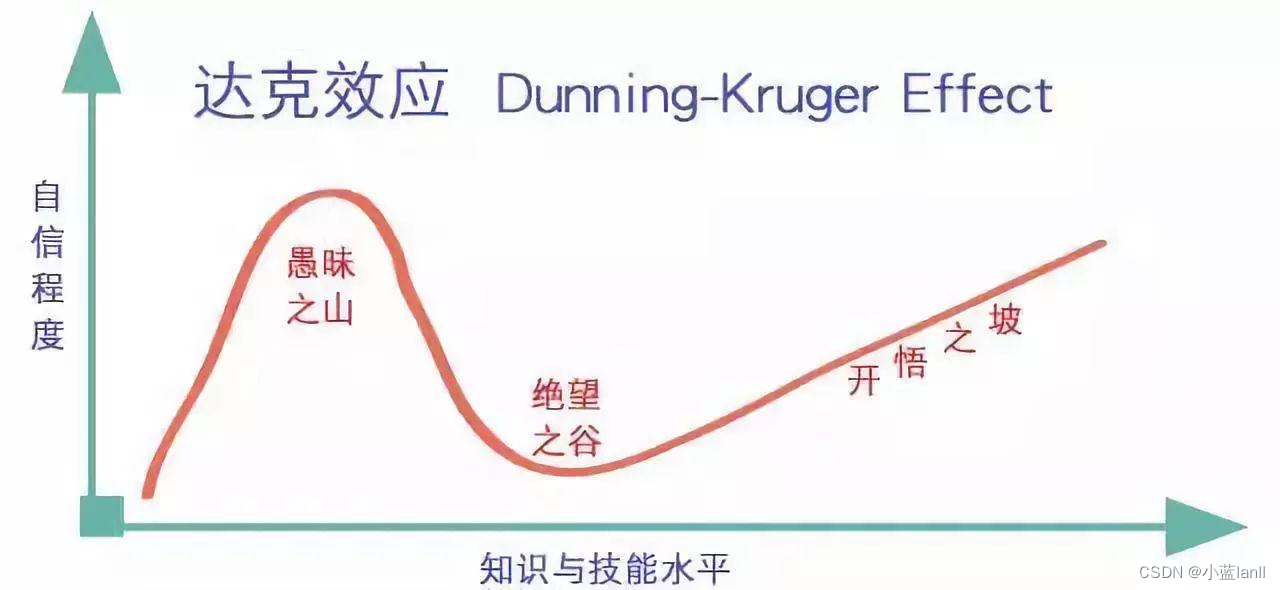

总结下来就是能用fp16就用fp16,能用Int8就用Int8,能用int4就用int4。

量化对降低显存占用还是非常不错。

参考

- https://modelscope.cn/models/qwen/Qwen-14B-Chat-Int8/summary

- https://modelscope.cn/models/qwen/Qwen-7B-Chat/summary

- https://modelscope.cn/models/ZhipuAI/chatglm3-6b/summary

![[Linux] LVS+Keepalived高可用集群部署](https://img-blog.csdnimg.cn/direct/2f66269e97074fd7869a2470c0815d33.png)

![基于博弈树的开源五子棋AI教程[1 位棋盘]](https://img-blog.csdnimg.cn/direct/992576eab01542c7b35c2247c778761a.png)