目录

- 1 安装 MySql

- 2 安装 Hive

- 3 Hive 元数据配置到 MySql

- 4 启动 Hive

Hive 官网

1 安装 MySql

为什么需要安装 MySql?

- 原因在于Hive 默认使用的元数据库为 derby,开启 Hive 之后就会占用元数据库,且不与其他客户端共享数据,如果想多窗口操作就会报错,操作比较局限。以我们需要将Hive 的元数据地址改为 MySql,可支持多窗口操作。

(1)检查当前系统是否安装过 Mysql,如果有,则删除

[huwei@hadoop101 ~]$ rpm -qa|grep mariadb

mariadb-libs-5.5.56-2.el7.x86_64

[huwei@hadoop101 ~]$ sudo rpm -e --nodeps mariadb-libs

rpm -qa用于列出系统中已安装的所有软件包的名称,CentOS 6系统自带的数据库 MySql,CentOS 7系统自带的数据库是 mariadb(本质上就是 MySQL),根据自己的系统来确定。

(2)将 MySql 安装包拷贝到 /opt/software 目录下

(3)解压 MySql 安装包

新建 mysql_rpm 文件夹,并将MySQL 安装包中的文件解压在此处

[huwei@hadoop101 software]$ mkdir mysql_rpm

[huwei@hadoop101 software]$ tar -xvf mysql-5.7.28-1.el7.x86_64.rpm-bundle.tar -C ./mysql_rpm/

注意,

mysql-5.7.28-1.el7.x86_64.rpm-bundle.tar没有以gz结尾,不是压缩文件

(4)在安装目录下执行 rpm 安装

注意:按照 顺序 依次执行

[huwei@hadoop101 mysql_rpm]$ sudo rpm -ivh mysql-community-common-5.7.28-1.el7.x86_64.rpm

[huwei@hadoop101 mysql_rpm]$ sudo rpm -ivh mysql-community-libs-5.7.28-1.el7.x86_64.rpm

[huwei@hadoop101 mysql_rpm]$ sudo rpm -ivh mysql-community-libs-compat-5.7.28-1.el7.x86_64.rpm

[huwei@hadoop101 mysql_rpm]$ sudo rpm -ivh mysql-community-client-5.7.28-1.el7.x86_64.rpm

[huwei@hadoop101 mysql_rpm]$ sudo rpm -ivh mysql-community-server-5.7.28-1.el7.x86_64.rpm

(5)初始化数据库

[huwei@hadoop101 mysql_rpm]$ sudo mysqld --initialize --user=mysql

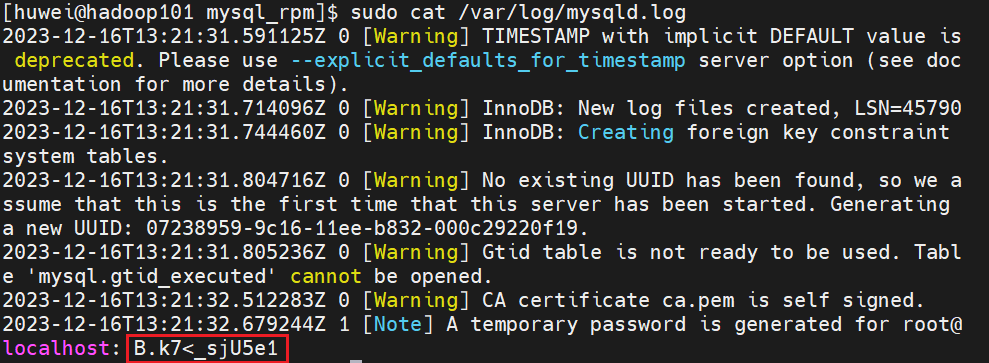

(6)查看临时生成的 root 用户的密码

[huwei@hadoop101 mysql_rpm]$ sudo cat /var/log/mysqld.log

复制保存临时密码

(7)启动 MySql 服务

[huwei@hadoop101 mysql_rpm]$ sudo systemctl start mysqld

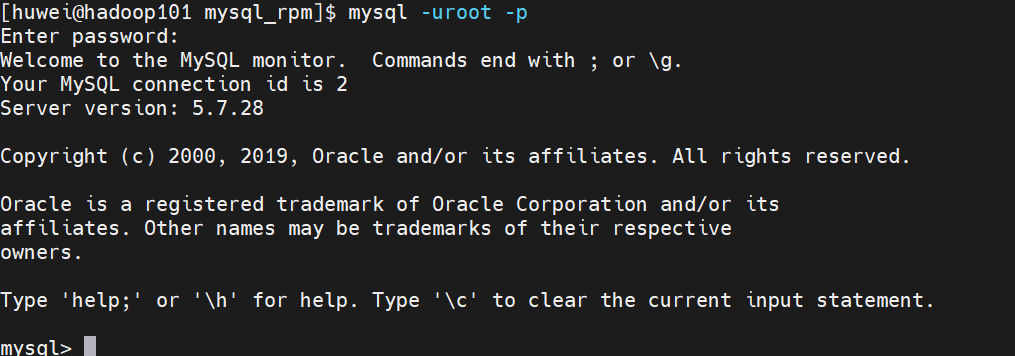

(8)登录 MySql 数据库

[huwei@hadoop101 mysql_rpm]$ mysql -uroot -p

不建议直接在

-p后直接输入密码,因为临时密码中可能含有一些特殊字符,shell 可能会把这些特殊字符解析导致出问题

(9)必须先修改 root 用户的密码,否则执行其他的操作会报错

这里我将 root 用户的密码改为 root

mysql> set password = password("root");

(10)修改 mysql 库下的 user 表中的 root 用户允许任意 ip 连接

此时我是在主机 hadoop101 上安装的 MySQL,如果我想在主机 hadoop102 上登录MySQL,是登录不上的

mysql> update mysql.user set host='%' where user='root';

mysql> flush privileges;

退出 MySQL 数据库

mysql> exit;

2 安装 Hive

(1)把 apache-hive-3.1.2-bin.tar.gz上传到 linux 的 /opt/software 目录下

(2)解压 apache-hive-3.1.2-bin.tar.gz 到 /opt/module/ 目录下面

[huwei@hadoop101 software]$ tar -zxvf /opt/software/apache-hive-3.1.2-bin.tar.gz -C /opt/module/

(3)修改 apache-hive-3.1.2-bin 的名称为 hive-3.1.2

[huwei@hadoop101 software]$ cd ../module/

[huwei@hadoop101 module]$ mv apache-hive-3.1.2-bin/ hive-3.1.2

(4)修改 /etc/profile.d/my_env.sh,添加环境变量

[huwei@hadoop101 module]$ sudo vim /etc/profile.d/my_env.sh

添加如下内容

# HIVE_HOME

export HIVE_HOME=/opt/module/hive-3.1.2

export PATH=$PATH:$HIVE_HOME/bin

使环境变量生效

[huwei@hadoop101 module]$ source /etc/profile

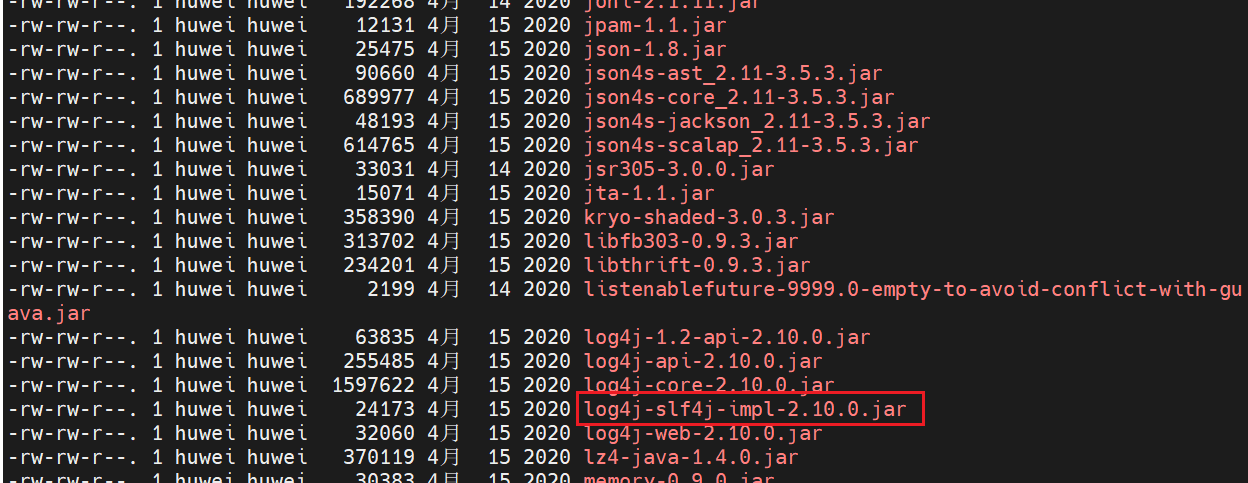

(5)解决日志Jar包冲突

[huwei@hadoop101 module]$ cd hive-3.1.2/lib/

[huwei@hadoop101 module]$ ll

hive 工作时底层是基于 hadoop 的,hadoop 里也有日志的 jar 包,二者可能会有冲突,将 hive 中的

log4j-slf4j-impl-2.10.0.jar删除,在hive运行时直接使用 hadoop 提供的日志 jar 包。

[huwei@hadoop101 lib]$ rm -rf log4j-slf4j-impl-2.10.0.jar

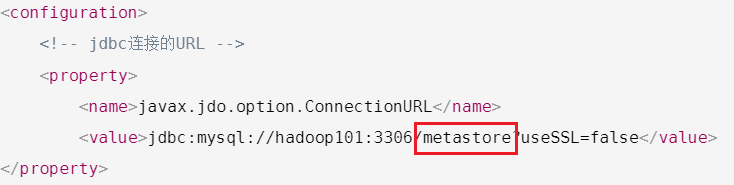

3 Hive 元数据配置到 MySql

(1)在 $HIVE_HOME/conf目录下新建 hive-site.xml 文件

[huwei@hadoop101 ~]$ vim $HIVE_HOME/conf/hive-site.xml

添加如下内容

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration><!-- jdbc连接的URL --><property><name>javax.jdo.option.ConnectionURL</name><value>jdbc:mysql://hadoop101:3306/metastore?useSSL=false</value>

</property><!-- jdbc连接的Driver--><property><name>javax.jdo.option.ConnectionDriverName</name><value>com.mysql.jdbc.Driver</value>

</property><!-- jdbc连接的username--><property><name>javax.jdo.option.ConnectionUserName</name><value>root</value></property><!-- jdbc连接的password --><property><name>javax.jdo.option.ConnectionPassword</name><value>root</value>

</property><!-- Hive默认在HDFS的工作目录 --><property><name>hive.metastore.warehouse.dir</name><value>/user/hive/warehouse</value></property><!-- Hive元数据存储的验证 --><property><name>hive.metastore.schema.verification</name><value>false</value></property><!-- 元数据存储授权 --><property><name>hive.metastore.event.db.notification.api.auth</name><value>false</value></property>

</configuration>

(2)拷贝驱动

上传 JDBC 驱动至/opt/software/ ,然后将 MySql 的 JDBC 驱动拷贝到 Hive 的 lib 目录下

[huwei@hadoop101 software]$ cp /opt/software/mysql-connector-java-5.1.37.jar $HIVE_HOME/lib

(3)初始化元数据库

登录 mysql

[huwei@hadoop101 ~]$ mysql -uroot -proot

由于在 hive-site.xml 文件中指定了存放元数据的数据库 metastore

所以新建 Hive 元数据库 metastore

mysql> create database metastore;

Query OK, 1 row affected (0.01 sec)mysql> quit;

Bye

初始化 Hive 元数据库

[huwei@hadoop101 ~]$ schematool -initSchema -dbType mysql -verbose

4 启动 Hive

(1)启动 hadoop 集群

[huwei@hadoop101 ~]$ hdp_cluster.sh start

从下面三种启动方式中选择一种即可

(3)普通方式启动 hive

[huwei@hadoop101 ~]$ hive

(4)元数据服务方式启动 hive

hive的元数据是存在 MySql 里的,如果不使用元数据服务的话,hive直接会操作MySql里的元数据,使用元数据服务的话,hive会操作元数据服务,元数据服务再去操作 MySql 里的元数据

① 在 hive-site.xml 文件中添加如下配置信息

[huwei@hadoop101 ~]$ cd /opt/module/hive-3.1.2/conf

[huwei@hadoop101 conf]$ vim hive-site.xml

<!-- 指定存储元数据要连接的地址 --><property><name>hive.metastore.uris</name><value>thrift://hadoop101:9083</value></property>

② 启动 metastore

[huwei@hadoop101 ~]$ hive --service metastore

③ 新开启一个窗口,启动 hive

[huwei@hadoop101 ~]$ hive

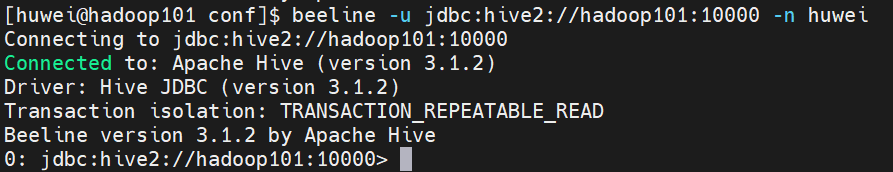

(5)JDBC 方式启动 hive

这里是引用

① 在 hive-site.xml 文件中添加如下配置信息

[huwei@hadoop101 ~]$ cd /opt/module/hive-3.1.2/conf

[huwei@hadoop101 conf]$ vim hive-site.xml

<!-- 指定hiveserver2连接的host --><property><name>hive.server2.thrift.bind.host</name><value>hadoop101</value></property><!-- 指定hiveserver2连接的端口号 --><property><name>hive.server2.thrift.port</name><value>10000</value></property>

② 启动 hiveserver2

[huwei@hadoop101 ~]$ hive --service hiveserver2

③ 新开启一个窗口,启动 beeline 客户端

[huwei@hadoop101 conf]$ beeline -u jdbc:hive2://hadoop101:10000 -n huwei

注意:

-n后跟的是当前的用户名

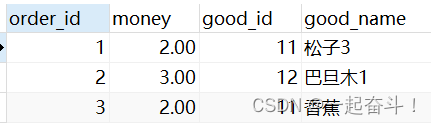

(6)使用 hive

hive> show databases;

hive> show tables;

hive> create table test (id int);

hive> insert into test values(1);

hive> select * from test;

(7)编写启动 metastore 和 hiveserver2 脚本

前面第2、3种启动的方式导致需要打开多个 shell 窗口,编写启动 metastore 和 hiveserver2 脚本

[huwei@hadoop101 ~]$ cd bin

[huwei@hadoop101 bin]$ vim hiveservice.sh

#!/bin/bash

HIVE_LOG_DIR=$HIVE_HOME/logs

if [ ! -d $HIVE_LOG_DIR ]

thenmkdir -p $HIVE_LOG_DIR

fi

#检查进程是否运行正常,参数1为进程名,参数2为进程端口

function check_process()

{pid=$(ps -ef 2>/dev/null | grep -v grep | grep -i $1 | awk '{print $2}')ppid=$(netstat -nltp 2>/dev/null | grep $2 | awk '{print $7}' | cut -d '/' -f 1)echo $pid[[ "$pid" =~ "$ppid" ]] && [ "$ppid" ] && return 0 || return 1

}function hive_start()

{metapid=$(check_process HiveMetastore 9083)cmd="nohup hive --service metastore >$HIVE_LOG_DIR/metastore.log 2>&1 &"cmd=$cmd" sleep 4; hdfs dfsadmin -safemode wait >/dev/null 2>&1"[ -z "$metapid" ] && eval $cmd || echo "Metastroe服务已启动"server2pid=$(check_process HiveServer2 10000)cmd="nohup hive --service hiveserver2 >$HIVE_LOG_DIR/hiveServer2.log 2>&1 &"[ -z "$server2pid" ] && eval $cmd || echo "HiveServer2服务已启动"

}function hive_stop()

{metapid=$(check_process HiveMetastore 9083)[ "$metapid" ] && kill $metapid || echo "Metastore服务未启动"server2pid=$(check_process HiveServer2 10000)[ "$server2pid" ] && kill $server2pid || echo "HiveServer2服务未启动"

}case $1 in

"start")hive_start;;

"stop")hive_stop;;

"restart")hive_stopsleep 2hive_start;;

"status")check_process HiveMetastore 9083 >/dev/null && echo "Metastore服务运行正常" || echo "Metastore服务运行异常"check_process HiveServer2 10000 >/dev/null && echo "HiveServer2服务运行正常" || echo "HiveServer2服务运行异常";;

*)echo Invalid Args!echo 'Usage: '$(basename $0)' start|stop|restart|status';;

esac

添加执行权限

[huwei@hadoop101 bin]$ chmod u+x hiveservice.sh

启动服务

[huwei@hadoop101 bin]$ hiveservice.sh start

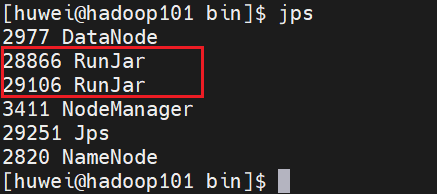

此时,我们发现有两个 RunJar 进程,就是hive服务进程了

![【算法每日一练]-动态规划(保姆级教程 篇14) #三倍经验 #散步 #异或和 #抽奖概率](https://img-blog.csdnimg.cn/direct/8b6f3b7be0454f68be86fa35faf0f6d4.jpeg)