文章目录

- 前言

- 0、论文摘要

- 一、Introduction

- 1.1目标问题

- 1.2相关的尝试

- 1.3本文贡献

- 二.相关工作

- 2.1 单词表示

- 2.2 文本摘要方法

- 三.本文方法

- 四 实验效果

- 4.1数据集

- 4.2 对比模型

- 4.3实施细节

- 4.4评估指标

- 4.5 实验结果

- 4.6 细粒度分析

- 五 总结

- 思考

前言

Automatic text summarization using deep reinforced model coupling contextualized word representation and attention mechanism(2108)

0、论文摘要

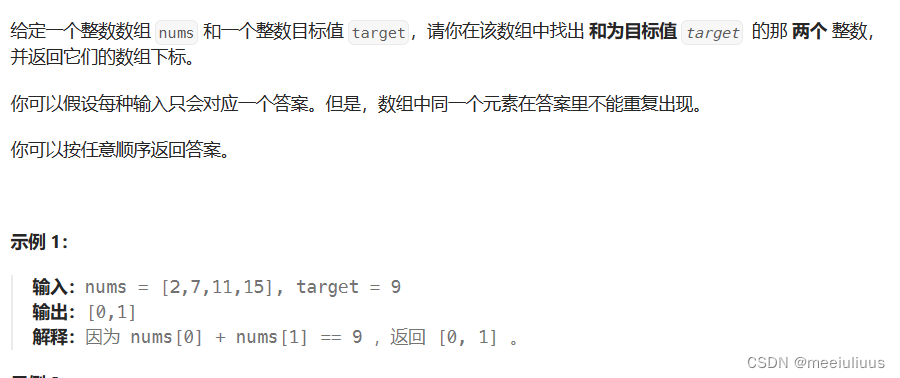

近年来,随着文本数据的快速且前所未有的增长,非常需要自动文本摘要模型来在合理的时间内从这些大量文本文档中检索有用信息,而无需人工干预。文本摘要通常基于提取和抽象范式进行。尽管在过去的几十年里,针对文本摘要任务提出了不同的基于机器学习和深度学习的方法,但它们仍处于发展的早期阶段,其潜力尚未得到充分发掘。

因此,本文提出了一种新的摘要模型,该模型利用提取和抽象文本摘要模型作为基于强化学习策略梯度的单一统一模型。

除了注意机制之外,所提出的模型还在提取和抽象模块中采用了卷积神经网络和门控循环单元的组合。此外,语言模型,即Word2Vec和BERT,被用作所提出模型的骨干,以更好地将句子语义表达为词向量。

我们在广泛研究的文本摘要数据集(CNN\Daily Mail 和 DUC-2004)上进行了实验,根据实证结果,与提取和抽象摘要模型相比,所提出的模型不仅在 ROUGE 度量方面实现了更高的准确性,而且此外,其生成的摘要基于人工评估呈现出更高的显着性和可读性。

一、Introduction

1.1目标问题

随着互联网技术的显着发展和社交媒体的指数级发展,人们如今面临着大量以非结构化文本形式产生的数据。尽管这些文本数据有价值且信息丰富,但从中提取有效信息已成为近年来吸引许多研究人员的重要挑战。在这方面,自动文本摘要作为自然语言处理的突出应用之一,被认为是一种有效的解决方案,它不仅试图将长文本压缩为较短的文本并保留其主要思想,而且可以帮助读者除了减少检索信息所需的时间外,还可以轻松理解文本的主要概念[1, 28]。

自动文本摘要方法通常分为抽取式和抽象式两类[14, 46]。提取方法通常基于传统方法,其中选择输入文档的重要句子,然后组合以生成输出摘要。相比之下,抽象方法旨在类似于人类书写的摘要并考虑源文本的语义。事实上,抽象方法除了保留其主要含义外,还能够生成新的句子作为输出摘要,而这些句子在源文本中是不可用的[6, 29]。

尽管提取式摘要方法最先被开发出来并取得了可观的成果,但它们只能从源文档中挖掘重要信息,无法思考输入文本的语义并生成摘要。然而,近年来,随着计算机性能的提高和深度神经网络的扩展,抽象摘要方法获得了极大的关注,它们专注于通过将输入序列转换为另一个序列来生成摘要[3,28,46,71]。必须指出的是,现有的抽象摘要方法大多基于编码器-解码器框架,长短期记忆(LSTM)和门控循环单元(GRU)可以作为该领域的适用模型,并且首先被大规模应用。由于其强大的能力,它们被用于机器翻译,然后用于文本摘要任务[15,63,70]。

必须指出的是,尽管机器翻译和文本摘要之间有很大相似之处,但它们还是有很大不同的。因此,在机器翻译中,生成的序列大致与输入序列一样长,而在文本摘要中,生成的序列通常比输入序列短,并且与原始文本的长度无关。很明显,尽管机器翻译往往是无损的,但输入文本在文本摘要中以有损方式压缩,同时保留了其主要概念。换句话说,机器翻译试图解决输入和输出序列之间一对一的字级对齐问题,但文本摘要并不高度依赖于对齐[48, 57]。

尽管近年来推出的许多基于深度学习的摘要方法取得了成功,但现有模型仍处于发展的初级阶段,无法解决所有局限性。事实上,一个好的总结不仅要简短、信息丰富、连贯,而且还必须考虑句法结构。考虑到现有的抽取式和抽象式文本摘要模型生成的摘要,很明显,抽取范式很简单并且保证了语法正确性,而生成的摘要通常显着性较差并且语义不一致。相反,抽象范式更加简洁但冗余,其生成的摘要不满足句法结构要求[20]。而且,在总结很长的文档时,提取模型很简单,而其可读性较差,并且抽象模型将长序列压缩为固定长度的向量,从而导致信息丢失。因此,他们都无法更有效地执行长文档摘要[1]。

通过仔细研究当前的文本摘要模型,可以发现源文本的所有内容,特别是在抽象摘要模型中,通常被编码为解码器的输入。因此,如果源文档包含不相关的信息,则所有输入文本都会被编码并用作解码器的隐藏状态,这可能导致生成的摘要不一致,因为编码器受到不相关信息的高度影响,因此语义会受到影响。无法有效地表示文本。此外,当前的编码器-解码器模型只能将一个单词作为输入,而将短语作为输入不仅可以产生更高的性能,而且可以通过考虑单词的搭配来帮助模型生成更自然的句子[40]。

相反,之前的研究也表明,使用预训练模型进行单词表示对于各种自然语言处理任务都是有益的 [50, 59]。重要的预训练模型之一是词嵌入,例如 Word2Vec [31]、Glove [37] 和 ELMo [38],它们通常用于生成词向量,这些词向量用作主要任务之外的附加特征。另一种预训练模型是句子级的,如 UML-FiT [18]、OpenAI GPT [39] 和 BERT [13]。值得注意的是,尽管利用预训练模型进行单词表示已经取得了惊人的结果,但其潜力和影响力尚未得到充分探索。此外,尽管有词嵌入,但句子级预训练模型的效果很少被探索,并且仍然很少有研究旨在使用它们来增强文本摘要的性能[50]。

1.2相关的尝试

1.3本文贡献

考虑到上述问题,本文提出了一种新的自动文本摘要模型,该模型不仅结合了提取式和抽象式文本摘要范式的优点,而且减少了不相关信息的影响,增强了生成摘要的连贯性和显着性。专注于合成结构。该模型使用强化学习集成了提取和抽象文本摘要模型,同时在提取和抽象模块中利用了 CNN 和 GRU 的组合。值得注意的是,自注意力机制和辅助注意力机制分别应用于提取和抽象模块中,以模仿人脑生成摘要。此外,为了更好地表达句子语义,我们还在我们提出的文本摘要模型的基础上利用 Word2Vec 和 BERT 结构进行单词表示,并研究了它们对目标任务的影响。必须指出的是,尽管使用 Word2Vec 进行向量表示的效果已在各种自然语言任务中得到了广泛的探索[43, 44],但使用 BERT 来提高抽象文本摘要效率的研究却很有限。为此,我们决定将它们单独用作我们提出的模型的第一层,以便对它们进行比较并突出 BERT 的潜力。

简而言之,提取模型和抽象模型分别被预训练为两个子模型,然后使用强化学习的策略梯度来训练完整的端到端模型并在所提出的模型中桥接两个训练有素的网络。

总之,我们的贡献如下:

- 所提出的模型利用了提取和抽象文本摘要模型,这些模型被训练为基于强化学习策略梯度的单一统一模型。

- CNN 和 GRU 的结合用于提取和抽象模块。在提取模块中使用 CNN 不仅可以实现句子级编码,还有助于提取局部特征。在抽象模块的编码器中使用 CNN 还使模型能够使用短语而不是单词作为输入,从而生成更自然的句子。 •

- 所提出的模型分别在提取和抽象模块中采用自注意力机制和辅助注意力,通过模仿人脑在摘要生成中的过程来突出重要信息。 •

- 为了清楚地展示单词表示模型的影响并提高文本摘要的性能,我们分别利用 Word2Vec 和 BERT 技术作为我们提出的模型的支柱。 •

- 除了使用CNN 和GRU 的组合、辅助注意力和情境化表示之外,这是第一个尝试连接提取和抽象模型的研究。

- 根据实验结果,与现有的提取和抽象摘要模型相比,所提出的模型不仅在 ROUGE 度量方面获得了更高的准确性,而且其生成的摘要具有更高的可读性和显着性。

- 我们论文的其余部分分类如下。第 2 节总结了基于深度学习的提取和抽象摘要模型的相关研究。第 3 节介绍了所提出模型的细节。第 4 节包括模型情境化和实证结果。第 5 节提供了结论和对未来研究的建议。

二.相关工作

文本摘要是自然语言处理的突出应用之一,近年来得到了广泛的研究并吸引了许多研究人员。为了更好地研究文本摘要领域的研究,本文的文献综述分类如下。首先,探讨了词表示的影响以及这方面的相关工作。其次,介绍了各种针对深度神经网络的抽取式和抽象式文本摘要方法。第三,介绍了强化学习和注意力机制的影响。

2.1 单词表示

文本摘要的第一步是单词表示,旨在将文本转换为固定大小的向量 [10, 40]。由于预处理步骤后获得的词汇中的单词数量有限,许多研究都集中在解决学习单词嵌入的问题,Mikolov 等人提出的模型。 [40],即Word2Vec,是这方面第一个有前途的模型。他们使用未标记的文本来训练单词的连续语义表示。同样,彭宁顿等人。 [50]利用共现矩阵并仅对非零元素进行训练来生成语义词嵌入。

然而,所提到的单词表示模型是上下文无关的,只能为每个单词生成单个单词嵌入[38]。这意味着“银行”一词在“河岸”和“银行存款”中将具有相同的向量,而上下文可以使“银行”一词的含义不同。为了克服这个问题,最近的语言模型专注于生成上下文词嵌入。因此,ELMo [59] 是一个试图从语言模型中提取上下文相关特征的模型,其中每个标记的上下文表示是其从右到左和从左到右表示的串联。德夫林等人。 [38]还提出了来自 Transformers 的双向编码器表示(BERT),以训练来自未标记文本的深度双向表示。 BERT 可以合并来自双向表示的信息,这对于用自然语言表示单词非常重要。

2.2 文本摘要方法

下一步是利用词向量进行文本摘要。文本摘要模型大致分为提取方法和抽象方法。大多数早期研究主要集中在提取方法和计算技术,例如模糊逻辑、遗传编程、神经网络或机器学习,它们依赖于人类生成的特征来生成摘要[30, 61]。在这方面,Janpeng Cheng [11]提出了一种数据驱动模型,利用神经网络和连续句子特征以及分层文档编码器和基于注意力的解码器来生成摘要。同样,Marina Litvak [25] 使用监督和无监督方法来识别源文档的重要概念以生成摘要。所有这些方法都是基于文本摘要的系统表示扩展,利用结构文档特征来提高传统向量空间模型的性能。接下来,Kami-Fai Wong [55] 提出了一种基于学习的模型,该模型集成了被分类为表面、相关性、内容和事件的各种特征。值得注意的是,句子的外部方面是通过表面特征来探索的,而句子的语义相关性是通过相关特征来考虑的。内容特征还根据内容传输单词计算句子,而事件特征根据其包含的事件表示句子。

随着深度学习的出现,文本摘要进入了一个新的发展阶段,循环神经网络和图卷积网络首先被用来计算句子的重要性并生成摘要。遵循类似的研究路线,Cao 等人使用了卷积神经网络。 [7] 对句子进行编码。然后根据语义信息对编码句子进行排序以生成最终摘要。尽管该模型取得了巨大成功,但它无法对关键词提取中的内容进行注释。此外,任等人。 [41]利用卷积和基于注意力的 RNN 来生成摘要,尽管之前有研究,但他们的模型可以考虑内容来提取信息丰富的句子。 Verma 和 Nidhi [47] 提出了一种提取摘要模型,该模型由特征提取、特征增强和摘要生成三个阶段组成,旨在提取突出信息,然后生成可理解且连贯的摘要。为此,他们利用受限玻尔兹曼机(RBM)来抽象特征并提高整体概括精度。张等人。 [62]引入了一种用于提取摘要的多视图卷积神经网络。他们利用两个单独的卷积神经网络来获取句子的特征,然后对句子进行联合排序。

SummaRuNNer 随后由 Nallapati 等人提出。 [32]假设摘要是一个文本分类问题。因此,SummaRuNNer 中使用了两级 RNN,第一个用于单词级,第二个用于单词级用于句子级隐藏状态表示计算。周等人。 [68]还引入了一种提取摘要模型,该模型采用分层循环神经网络和 BERT 作为预训练模型来执行摘要。尽管有其他现有方法,他们还是引入了联合句子评分框架,该框架根据句子内容和先前选择的句子来预测相对句子重要性得分。

尽管通过提取文本摘要获得了可观的结果,但提取模型生成的摘要在语义上并不连贯[14]。事实上,尽管提取模型能够生成具有可接受的句法结构水平的摘要,但其生成的摘要的可读性很差。考虑到人类不仅喜欢用自己的话来解释文档来生成摘要,而且还选择突出简洁、连贯的摘要,文本摘要时代的研究已经改变了方向,最近的研究集中在抽象文本摘要满足现有要求[40]。最初的抽象文本摘要模型通常基于机器学习和所需的手工特征。然而,深度学习的发展使得该领域取得了显着的发展[28, 49]。

因此,拉什等人。 [42]旨在解决长文档摘要的问题,并使用基于词袋的编码器和具有注意机制的CNN作为解码器来生成摘要。 Lopyrev [27] 还利用基于注意力的 LSTM 来生成标题,考虑到新闻文章的文本,其中在解码器中使用 RNN 而不是神经语言模型。在下文中,乔普拉等人。 [12]提出了一种基于注意力的前馈神经网络来生成新闻文章的标题。

尽管深度神经网络具有巨大的潜力,但仍存在一些局限性。例如,重复词、短句和生僻词通常被认为是抽象文本摘要中的突出问题。为了填补这些空白,近年来进行了不同的研究,研究人员致力于解决重复性和生僻字问题。因此,Nallapati 等人。 [33]提出了一种基于注意力的编码器-解码器,它在不同的摘要数据集上获得了最高的准确率。还引入了覆盖机制来克服重复性问题。对此,铃木等人。 [51]检查了编码器中的目标词上键特征,并通过控制解码器中的输出词来降低摘要的可重复性。最近的研究还利用强化学习和注意力机制来提高生成的摘要的可读性和一致性[3, 36]。

Vinyals等人在编码器和解码器中引入了指针机制。 [53]克服生僻字问题。顾等人。 [16],古尔塞雷等人。 [17] 和 Nallapati 等人。 [33]还采用了具有不同配置的指针机制的概念来控制罕见词问题。最近,See 等人。 [45]。在他们的模型中使用了类似的机制,在摘要生成方面取得了相当大的改进。

卷积神经网络也已成功用于抽象概括。为此,宋等人。 [48]引入了一种摘要模型,除了指针机制之外,还利用 CNN 和 LSTM 来生成摘要。此外,Li 等人使用了 seq2seq 编码器-解码器。 [23]生成抽象摘要。他们提出的模型利用生成模型来学习摘要的潜在结构和判别状态信息。 Wang和Len [54]还提出了摘要感知注意力来总结社交媒体的短文本,其中利用源隐藏状态和参与摘要向量来测量注意力权重。类似地,Xiang 等人提出了一种注意力编码器-解码器框架。 [56] 他们在哪里在编码器和解码器中使用 Bi-LSTM 分别对输入序列进行编码并生成输出摘要。

周等人。 [69]开发了序列到序列模型,并利用句子编码器、选择性门网络和配备注意力的解码器进行抽象摘要,其中选择性门网络通过控制从编码器到解码器的信息流来提供句子级表示。 Huan 等人还提出了一种变分神经解码器文本摘要模型。 [65]。基于他们提出的模型,利用变分 RNN 和变分自动编码器的组合来获得复杂的语义表示,然后生成摘要。接下来,Fan 等人使用了卷积序列到序列模型。 [24]对于抽象文本摘要,提供了一种注意力机制,使读者能够通过具体化高级特征来关注生成的摘要的更重要的方面。

通过开发预训练的语言模型,他们还成功应用于文本摘要,并取得了显着的效果。因此,Zhang 等人使用了 BERT。 [64]对输入序列进行编码并表示上下文。他们提出的模型包括两个步骤,首先采用基于变压器的解码器来生成草稿输出。此后,草稿序列被屏蔽并馈送到 BERT。最后,使用基于变压器的解码器来组合输入序列和草稿表示,并为每个掩码位置生成精炼词。此外,Liu和Lapata [26]提出了一种基于BERT的新文档级编码器来表示文档的语义,然后生成摘要。阿克谢诺夫等人。 [2] 还在 BERT 语言模型上评估了基于 Transformer 的神经模型的编码器和解码器的调节,并在文本摘要任务中获得了可观的结果。

强化学习的应用也吸引了许多研究人员,并且有望彻底改变文本摘要的任务,因为与其他机器学习方法相比,算法不明确地知道任务是如何执行的,而是自行解决问题。因此,姚等人。 [58] 除了基于注意力的 LSTM 和概率生成模型之外,还采用强化学习来生成摘要。 Li等人还提出了神经抽象概括框架。 [22]。他们采用强化学习和注意力机制中的演员-批评家方法,并分别利用最大似然作为演员和批评家。值得注意的是,Hsu 等人。 [19]还提出了一种抽象摘要模型,该模型利用提取和抽象文本摘要模型的组合,利用单词级、句子级和不一致损失函数来惩罚两个注意力级别之间的不一致。为了克服长文档摘要问题,Celikyilmaz 等人。 [8]在编码器-解码器中引入了深度通信代理。为此,长文档被分成较短的部分,然后使用特定的代理对每个部分进行编码。此后,采用强化学习进行训练并提取最终总结。纳拉扬等人。 [34]还利用强化学习对提取摘要方法中提取的句子进行排序。保卢斯等人。 [36]还引入了一种深度强化模型,利用强化学习策略梯度方法进行抽象总结。在下文中,托马斯等人。 [52]引入了一种用于文本摘要的集成方法,其中提取和抽象文本摘要方法相结合,以充分利用原始数据。他们分别将 LSTM 和指针生成器网络用于提取和抽象模块。查利等人。 [9]还使用了各种方法进行句子排序和聚类,以避免摘要中存在冗余数据。他们提出了一种无监督的提取总结方法,并开发了两种使用强化学习技术和变压器模型的抽象多文档摘要模型。肯内什卢等人。 [21]采用了基于自我批评策略梯度方法的强化学习框架,该框架在各种数据集上获得了很好的泛化性和显着的结果。

通过仔细研究现有的研究,很明显,尽管除了强化学习之外,还引入了各种基于深度学习的模型来进行自动文本摘要,但它们仍处于发展的早期阶段,并面临着一些局限性。此外,可以说机器生成的摘要和人类生成的摘要之间仍然存在相当大的差距,这使得自动文本摘要成为对研究人员有吸引力和潜在的主题。