简介

发布时间与背景

通义万相 Wan2.1 模型于 2025年1月 发布,并迅速登顶视频生成领域权威评测 Vbench 的榜首,超越了包括 Sora、HunyuanVideo、Minimax 等国内外知名模型,并于这周开源。它是阿里云在 AI 视频生成领域的最新成果,旨在提供高质量、高效率的视频生成能力。

核心功能

Wan X2.1 支持多种视频生成任务,包括 文生视频(Text-to-Video) 和 图生视频(Image-to-Video) ,并具备动态字幕生成、多语言配音等多模态融合能力。支持分辨率从 480P 到 1080P ,满足不同场景需求。

模型架构

参数规模

Wan2.1 提供两种参数规模的模型版本:

- 1.3B 版本 :轻量化设计,适合消费级 GPU,仅需 8.2GB 显存 即可生成 480P 分辨率的视频,适用于对生成速度要求较高的场景4。

- 14B 版本 :高性能版本,生成效果更优,适用于专业人士和对画质要求更高的任务。

多模态融合技术

Wan2.1 引入了 多模态融合技术 ,能够同时处理文本、图像、音频等多种输入,生成包含动态字幕、语音配音的高清视频。

这种技术确保了视频输出的高质量和自然感,尤其是在复杂运动和物理规律还原方面表现卓越。

编解码优化

Wan2.1 在视频编解码方面进行了深度优化,支持高效的视频生成和播放,确保输出视频的流畅性和清晰度。

性能对比

Vbench 评测结果

在 Vbench 测评中,Wan2.1 的性能全面领先其他开源和闭源模:

- 复杂运动处理 :相比 Sora 和 HunyuanVideo,Wan2.1 在人物动作、物体运动的连贯性上表现更佳5。

- 物理规律还原 :如水波、火焰等动态效果的生成更加逼真,接近专业级水准。

与其他模型的对比

- Sora :虽然 Sora 在创意生成上有一定优势,但 Wan2.1 在稳定性和细节表现上更胜一筹。

- Luma 和 Gen3 :这些模型在生成速度上稍快,但在画质和语义理解能力上不及 Wan2.1。

- Pika :Pika 更注重风格化生成,而 Wan2.1 则兼顾写实与艺术风格。

- 硬件兼容性 :

Wan2.1 的 1.3B 版本 能够在消费级显卡(如 8GB 显存的 GPU)上运行,大幅降低了使用门槛。相比之下,许多闭源模型需要高性能计算资源。

相关文献

1.3B模型国内下载

14B模型国内下载

github项目地址

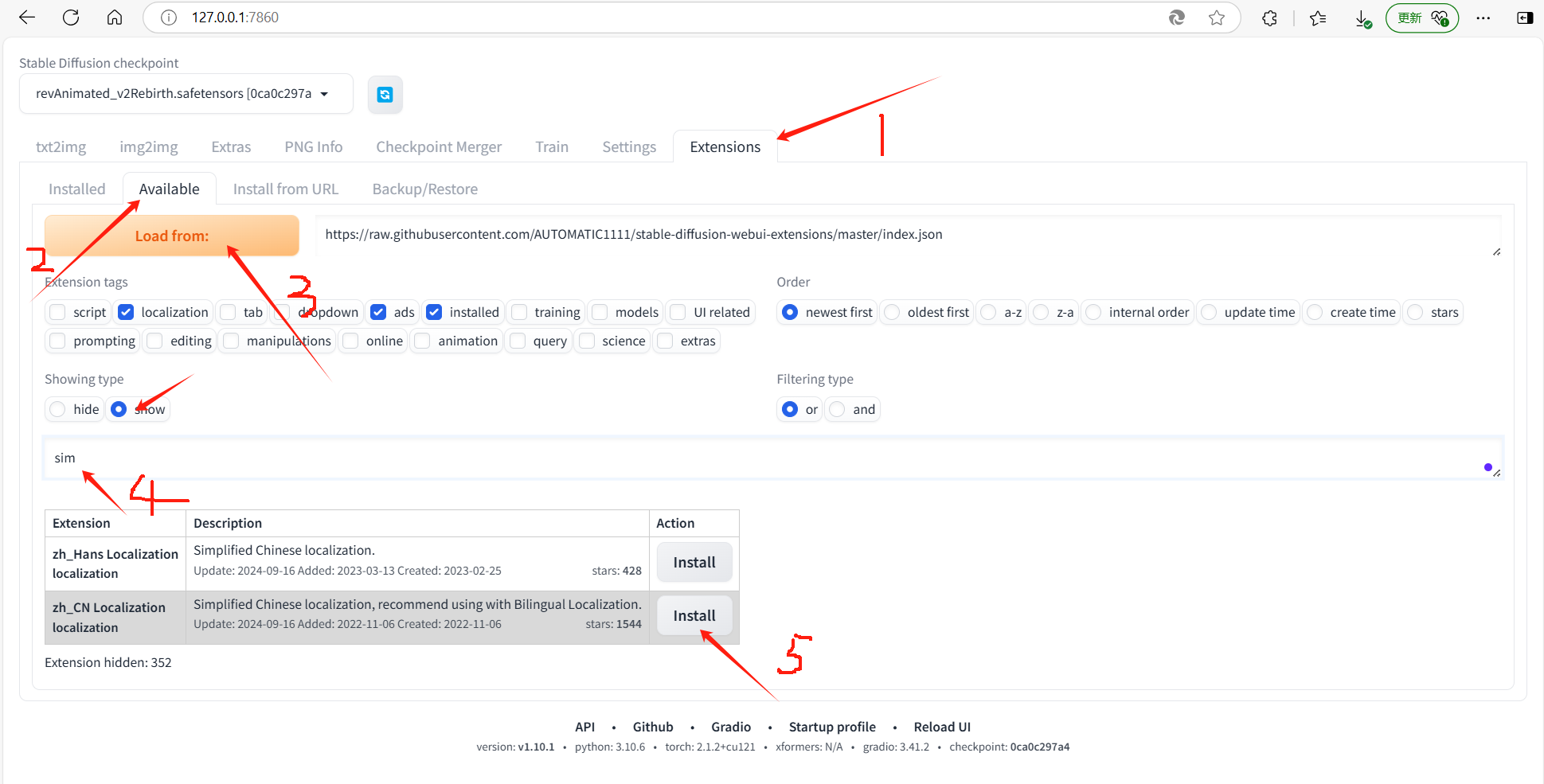

并且wanx2.1目前支持comfyui了已经,有兴趣的可以试试~

![[Linux]项目自动化构建工具-make/Makefile](https://i-blog.csdnimg.cn/direct/df44eb49f1394d3891a33e860df8d01d.png)