OpenAI Sora 初体验

就在刚刚,OpenAI 再次投下一枚重磅炸弹——Sora,一个文本到视频生成模型。

我第一时间体验了 Sora。看过 Sora 的能力后,我真的印象深刻。对细节的关注、无缝的角色刻画以及生成视频的绝对质量真正将可能性提升到了一个新的高度。

文章目录

- Sora 介绍

- 一点思考

Sora 介绍

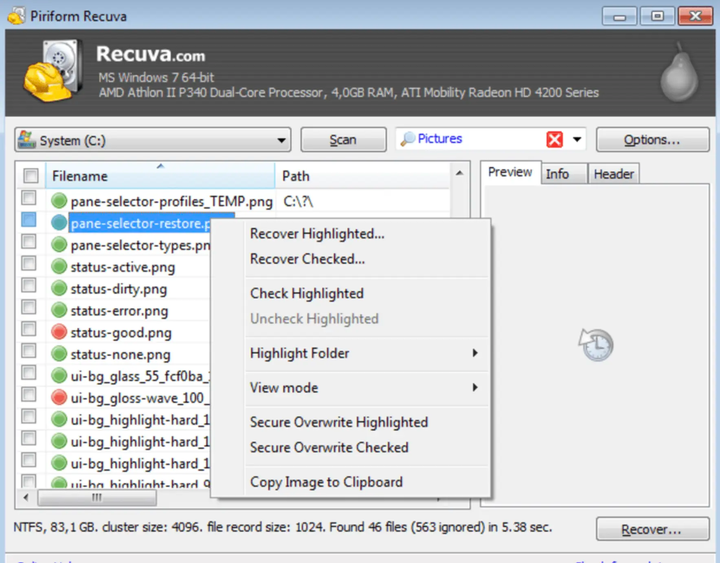

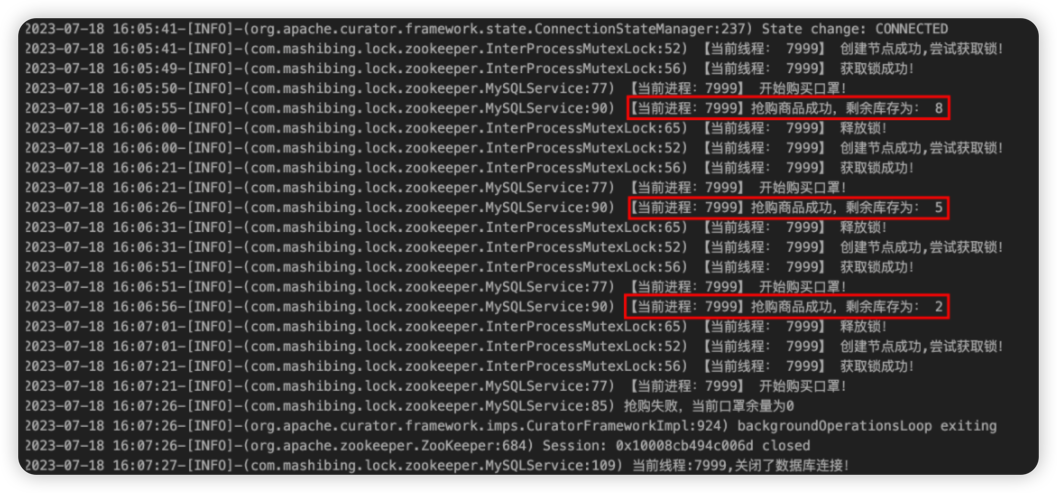

虽然 Sora 不是根据文本提示生成视频的先驱—— Runway ML 的 Gen-2、 Pika Labs 和 Google Lumiere 等前辈为这个领域铺平了道路——但根据我迄今为止观察到的情况,Sora 绝对超越了当下所有竞争对手。从官网发布的视频来看,不仅分辨率和清晰度高于其他竞品,更能够生成长达 60 秒的视频。

OpenAI 最新发布的文生视频模型 Sora 生成的超逼真视频

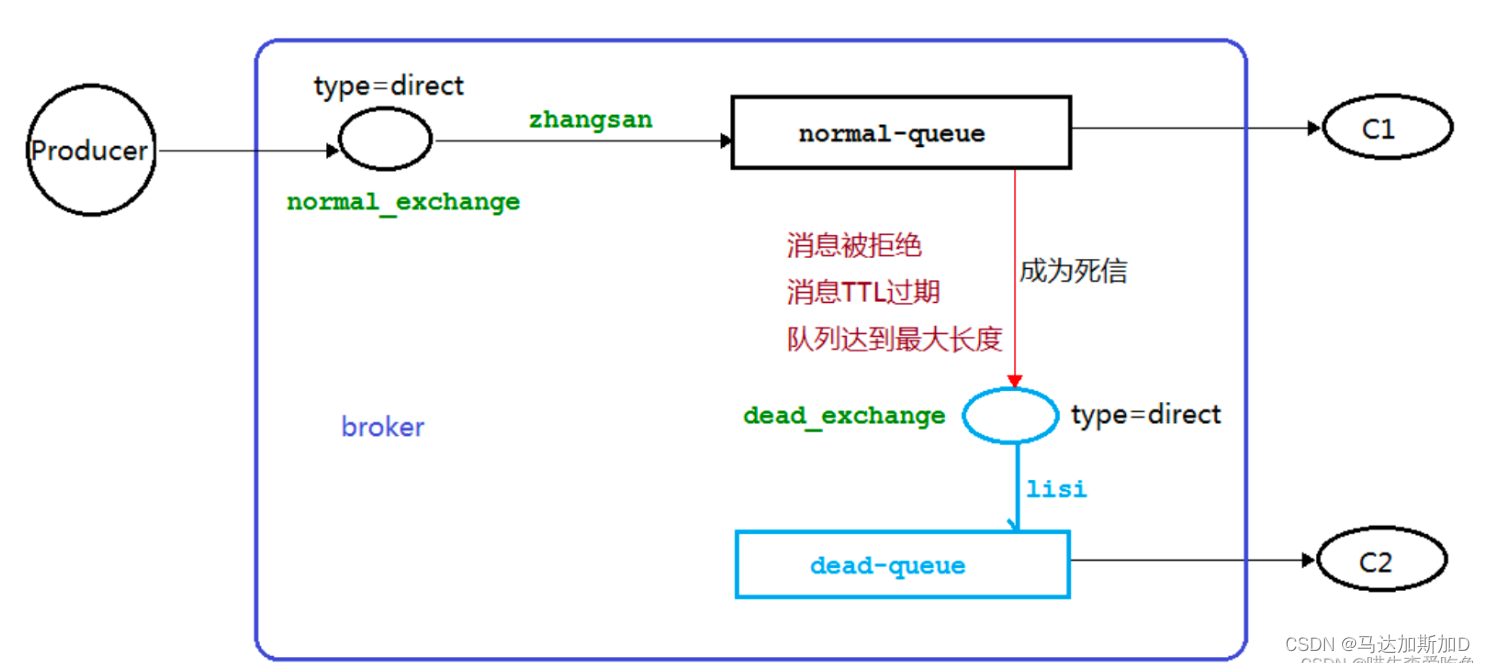

与 Midjourney 和 DALL·E 等文本到图像生成工具类似,Sora 使用一种称为稳定扩散(Stable Diffusion)的技术将静态噪声转换为连贯图像。不同的是,在这种情况下,Sora 生成的是视频而不是静态图像。

主要注意的是,Sora 不是像我们在上面示例中看到的那样单帧工作的,而是同时在多个帧上工作,确保视频中的角色和环境的一致性,即使它们在所有帧中不可见。

与静态图像生成器不同,Sora 必须处理场景中运动和物理效果的复杂性。这不仅仅是创建一系列图像,而是将它们编织成一个无缝流动的连贯叙事,反映现实世界的动态。

不得不说,这项技术还不完美。 就跟图像生成器难以生成看起来正常的人手一样,Sora 也有其错误和缺点。模拟现实世界并不是一件容易的事。有时模型会达不到要求。下面是个有趣的小例子:

Sora 生成的搞笑视频

Sora 的官方页面上展示了很多 Sora 生成的视频,并且未经任何后期加工。每个视频均附带生成提示词。

Sora 目前已对红队和一些视觉艺术家、设计师、电影制作人提供访问权限,它们也放出了许多令人惊艳的案例。

一点思考

像 Sora 这样的模型正在开启一个充满全新可能的宇宙,赋予创意人士将他们最富有想象力的想法变为现实的能力。 当我们进入这场技术革命时,我们很难想象未来会怎样。

在接下来的十年内,我们是否可以仅通过简单的提示来制作个性化的电影?

使用人工智能和苹果 Vision Pro 等下一代工具,我们是否可以沉浸在从想象变为现实的逼真环境中?

现在这一切都触手可及。技术正在开辟新的可能性,将曾经纯粹的科幻小说一步一步通过人工智能模型变成现实。

未来不仅仅是一个遥远的梦想——它正在我们眼前展开。新时代的曙光已经到来,艺术家和创新者已经使用这些工具来制作令人惊叹的艺术作品。

当我们勇往直前,拥抱这些进步时,我们不仅是变革的见证者,而且是创造一个想象力无限的世界的参与者。

活着是多么令人兴奋的时刻啊!