1 NodeLocal DNS是什么?

NodeLocal DNSCache 通过在集群节点上运行一个 DaemonSet 来提高 clusterDNS 性能和可靠性。处于 ClusterFirst 的 DNS 模式下的 Pod 可以连接到 kube-dns 的 serviceIP 进行 DNS 查询。通过 kube-proxy 组件添加的 iptables 规则将其转换为 CoreDNS 端点。通过在每个集群节点上运行 DNS 缓存,NodeLocal DNSCache 可以缩短 DNS 查找的延迟时间、使 DNS 查找时间更加一致,以及减少发送到 kube-dns 的 DNS 查询次数。

借助这种新架构,Pod 将可以访问在同一节点上运行的 DNS 缓存代理,从而避免 iptables DNAT 规则和连接跟踪。 本地缓存代理将查询 kube-dns 服务以获取集群主机名的缓存缺失(默认为 "cluster.local" 后缀)。

2 为什么使用NodeLocal DNS?

- 使用当前的 DNS 体系结构,如果没有本地 kube-dns/CoreDNS 实例,则具有最高 DNS QPS 的 Pod 可能必须延伸到另一个节点。 在这种场景下,拥有本地缓存将有助于改善延迟。

- 跳过 iptables DNAT 和连接跟踪将有助于减少 conntrack 竞争并避免 UDP DNS 条目填满 conntrack 表。

- 从本地缓存代理到 kube-dns 服务的连接可以升级为 TCP。 TCP conntrack 条目将在连接关闭时被删除,相反 UDP 条目必须超时 (默认 nf_conntrack_udp_timeout 是 30 秒)。

- 将 DNS 查询从 UDP 升级到 TCP 将减少由于被丢弃的 UDP 包和 DNS 超时而带来的尾部等待时间; 这类延时通常长达 30 秒(3 次重试 + 10 秒超时)。 由于 nodelocal 缓存监听 UDP DNS 查询,应用不需要变更。

- 在节点级别对 DNS 请求的度量和可见性。

- 可以重新启用负缓存,从而减少对 kube-dns 服务的查询数量。

- 避免IPVS缺陷导致的DNS概率性解析超时问题

- 默认解析使用UDP,UDP默认返回报文长度为512字节,大于512字节后就会将包丢弃,升级为TCP协议可以解决这个问题。TCP可以进行数据包的切片可以完整的得到返回的response

3 工作原理

- 配置了NodeLocal DNS本地缓存的Pod,默认会通过NodeLocal DNSCache监听于节点上的IP(169.254.20.10)解析域名。

- NodeLocal DNSCache本地若无缓存应答解析请求,则会通过kube-dns服务请求CoreDNS进行解析

- CoreDNS对于非集群内域名,会通过VPC DNS服务器进行解析

- 已注入DNS本地缓存的Pod,当无法连通NodeLocal DNSCache时,会继而直接通过kube-dns服务连接到CoreDNS进行解析,此链路为备用链路

- 未注入DNS本地缓存的Pod,会通过标准的kube-dns服务链路连接到CoreDNS进行解析

4 安装NodeLocal DNS

4.1 获取部署文件

将文件保存为nodelocaldns.yaml,文件地址:

https://github.com/kubernetes/kubernetes/blob/master/cluster/addons/dns/nodelocaldns/nodelocaldns.yaml

4.2 修改配置

4.2.1 IPV6配置

如果使用 IPv6,在使用 'IP:Port' 格式的时候需要把 CoreDNS 配置文件里的所有 IPv6 地址用方括号包起来。 如果你使用上述的示例清单, 需要把配置行 L70 修改为: "health [__PILLAR__LOCAL__DNS__]:8080"。

4.2.2 变量配置

把清单里的变量更改为正确的值。

# 获取coredns的IP

$ kubedns=`kubectl get svc coredns -n kube-system -o jsonpath={.spec.clusterIP}`# 表示集群域,默认就是 cluster.local

domain=cluster.local# 表示 DNSCache 本地的 IP,默认为169.254.20.10

localdns=169.254.20.10<cluster-domain> 的默认值是 "cluster.local"。

<localdns> 是 NodeLocal DNSCache 选择的本地侦听 IP 地址。如果 kube-proxy 运行在 IPTABLES 模式:

sed -i "s/__PILLAR__LOCAL__DNS__/$localdns/g; s/__PILLAR__DNS__DOMAIN__/$domain/g; s/__PILLAR__DNS__SERVER__/$kubedns/g" nodelocaldns.yamlnode-local-dns Pod 会设置 __PILLAR__CLUSTER__DNS__ 和 __PILLAR__UPSTREAM__SERVERS__。 在此模式下, node-local-dns Pod 会同时侦听 kube-dns 服务的 IP 地址和 <node-local-address> 的地址,以便 Pod 可以使用其中任何一个 IP 地址来查询 DNS 记录。

如果 kube-proxy 运行在 IPVS 模式:

sed -i "s/__PILLAR__LOCAL__DNS__/$localdns/g; s/__PILLAR__DNS__DOMAIN__/$domain/g; s/,__PILLAR__DNS__SERVER__//g; s/__PILLAR__CLUSTER__DNS__/$kubedns/g" nodelocaldns.yaml在此模式下,node-local-dns Pod 只会侦听 <node-local-address> 的地址。 node-local-dns 接口不能绑定 kube-dns 的集群 IP 地址,因为 IPVS 负载均衡使用的接口已经占用了该地址。 node-local-dns Pod 会设置 __PILLAR__UPSTREAM__SERVERS__

4.3 将NodeLocalDNS 部署到集群

4.3.1 灰度部署

如果是线上集群,推荐不要直接apply 文件,采用灰度的方式部署。可以在yaml中增加配置如下:

spec:nodeSelector:nodelocaldns: "true"4.3.2 node打标签

挑选集群的一些机器打上nodelocaldns=true的标签

for i in `cat 1.txt`; do kubectl label node $i nodelocaldns=true;done4.3.3 apply 文件

kubectl apply -f nodelocaldns.yaml 4.3.4 验证

这个时候需要进入到pod内验证服务是否有异常 (这些打了标签的node 上面的pod)

验证方式:

1) pod内是否可以解析外网域名(前提条件 node节点可以访问域名)

2) pod内解析内网域名

2) pod内解析集群service name

如果都没有问题,说明部署NodeLocalDNS后并没有影响我们集群现有的服务

4.3.5 取消节点亲和性配置

将yaml中NodeSelect 配置注释,重新apply

kubectl apply -f nodelocaldns.yaml 4.3.6 pod信息查看

查看kube-system 命名空间下的node-local-dns pod

kubectl get pod -n kube-system | grep node-local自此NodeLocalDNS就部署完成了,但是还没有应用到它。

5 应用NodeLocal DNSCache

为了能使应用原本请求CoreDNS的流量改为由DNS缓存DaemonSet代理,需要使Pod内部的中nameservers配置成169.254.20.10和kube-dns对应的IP地址,有以下几种方式可以选择:

- 方式一:借助DNSConfig动态注入控制器在Pod创建时配置DNSConfig自动注入。

- 方式二:创建Pod时手动指定DNSConfig。

- 方式三:修改kubelet参数,并重启节点kubelet。存在业务中断风险,不推荐使用此方式。

第一种方式:

需要集群具备adminssion webhook功能,或者可以使用第三方的一些插件完成部署

- adminssion webhook:基于Admission Webhook机制拦截Pod创建的请求,自动注入使用DNS缓存的Pod DNSConfig信息。

第二种方式:

如果用了原生的部署方式,可以在生产环境采用第二种应用方式

应用方式(以helm为例):业务的每一个服务都是通过helm 模板渲染生成一个chart, 其hekm模版会在gitlab代码仓库管理,所以只要修改helm 模板,服务重新发布即可使用NodeLocal DNSCache了。也可以手动修改yaml文件。具体方式需要看业务当前环境是怎么部署的服务了。下面是helm具体配置

{{-if eq .Values.cluster "offline" }}dnsPolicy: NonednsConfig:nameservers: ["169.254.20.10","10.11.128.10"]searches:- yidian-prod.svc.cluster.local- default.svc.cluster.local- svc.cluster.local- cluster.local- yidian.com- yidian-inc.comoptions:- name: ndotsvalue: "3"- name: attemptsvalue: "2"- name: timeout value: "1"

{{- end }}第三种方式:

不建议使用尤其是生产环境禁止使用

- 如果是二进制部署的集群,需要修改/etc/systemd/system/kubelet.service.d/10-kubeadm.conf 文件中的--cluster-dns=xxx.xxx.xxx.xxx参数。

查看kbuelet启动依赖的配置文件

ps -elf | grep kubelet | grep cluster-dns

systemctl status kubelet- 如果是kubeadm部署的集群,修改/var/lib/kubelet/config.yaml文件中的clusterDNS参数

六、验证

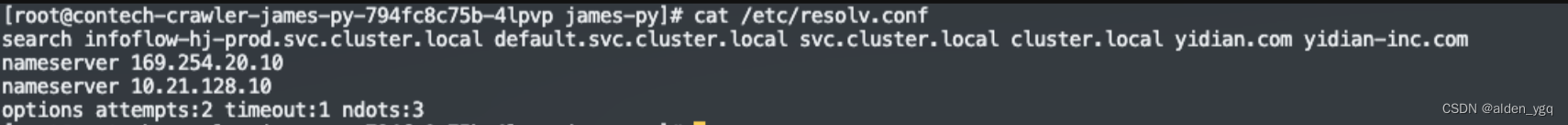

上面使用的第二种方式,需要重新发布才可以生效。下图是发布后pod内部的状况,可以看到pod内有两行nameserver信息第一行为NodeLocalDNS的IP,第二行是coreDNS的IP。

验证方式:

1) pod内是否可以解析外网域名(前提条件 node节点可以访问域名)

2) pod内解析内网域名

2) pod内解析集群service name

下面是nodelocaldns.yaml,也可以使用我的yaml,需要注意的是对应的那些变量要做变更,一定要改coredns的ip

apiVersion: v1

kind: ServiceAccount

metadata:name: node-local-dnsnamespace: kube-systemlabels:kubernetes.io/cluster-service: "true"addonmanager.kubernetes.io/mode: Reconcile

---

apiVersion: v1

kind: Service

metadata:name: kube-dns-upstreamnamespace: kube-systemlabels:k8s-app: kube-dnskubernetes.io/cluster-service: "true"addonmanager.kubernetes.io/mode: Reconcilekubernetes.io/name: "KubeDNSUpstream"

spec:ports:- name: dnsport: 53protocol: UDPtargetPort: 53- name: dns-tcpport: 53protocol: TCPtargetPort: 53selector:k8s-app: coredns

---

apiVersion: v1

kind: ConfigMap

metadata:name: node-local-dnsnamespace: kube-systemlabels:addonmanager.kubernetes.io/mode: Reconcile

data:Corefile: |cluster.local:53 {errorscache {success 9984 30denial 9984 5}reloadloopbind 169.254.20.10 __PILLAR__DNS__SERVER__forward . 10.11.128.10 {force_tcp}prometheus :9253health 169.254.20.10:8080}in-addr.arpa:53 {errorscache 30reloadloopbind 169.254.20.10 __PILLAR__DNS__SERVER__forward . 10.11.128.10 {force_tcp}prometheus :9253}ip6.arpa:53 {errorscache 30reloadloopbind 169.254.20.10 __PILLAR__DNS__SERVER__forward . 10.11.128.10 {force_tcp}prometheus :9253}.:53 {errorscache 30reloadloopbind 169.254.20.10 __PILLAR__DNS__SERVER__forward . __PILLAR__UPSTREAM__SERVERS__ {force_tcp}prometheus :9253}

---

apiVersion: apps/v1

kind: DaemonSet

metadata:name: node-local-dnsnamespace: kube-systemlabels:k8s-app: node-local-dnskubernetes.io/cluster-service: "true"addonmanager.kubernetes.io/mode: Reconcile

spec:updateStrategy:rollingUpdate:maxUnavailable: 10%selector:matchLabels:k8s-app: node-local-dnstemplate:metadata:labels:k8s-app: node-local-dnsannotations:prometheus.io/port: "9253"prometheus.io/scrape: "true"spec:priorityClassName: system-node-criticalserviceAccountName: node-local-dnshostNetwork: truednsPolicy: Default # Don't use cluster DNS.tolerations:- key: "CriticalAddonsOnly"operator: "Exists"- effect: "NoExecute"operator: "Exists"- effect: "NoSchedule"operator: "Exists"containers:- name: node-cacheimage: hub.kce.ksyun.com/ksyun/k8s-dns-node-cache:1.22.8resources:requests:cpu: 25mmemory: 5Miargs: [ "-localip", "169.254.20.10", "-conf", "/etc/Corefile", "-upstreamsvc", "kube-dns-upstream" ]securityContext:privileged: trueports:- containerPort: 53name: dnsprotocol: UDP- containerPort: 53name: dns-tcpprotocol: TCP- containerPort: 9253name: metricsprotocol: TCPlivenessProbe:httpGet:host: 169.254.20.10path: /healthport: 8080initialDelaySeconds: 60timeoutSeconds: 5volumeMounts:- mountPath: /run/xtables.lockname: xtables-lockreadOnly: false- name: config-volumemountPath: /etc/coredns- name: kube-dns-configmountPath: /etc/kube-dnsvolumes:- name: xtables-lockhostPath:path: /run/xtables.locktype: FileOrCreate- name: kube-dns-configconfigMap:name: corednsoptional: true- name: config-volumeconfigMap:name: node-local-dnsitems:- key: Corefilepath: Corefile.base

---

# A headless service is a service with a service IP but instead of load-balancing it will return the IPs of our associated Pods.

# We use this to expose metrics to Prometheus.

apiVersion: v1

kind: Service

metadata:annotations:prometheus.io/port: "9253"prometheus.io/scrape: "true"labels:k8s-app: node-local-dnsname: node-local-dnsnamespace: kube-system

spec:clusterIP: Noneports:- name: metricsport: 9253targetPort: 9253selector:k8s-app: node-local-dns