苹果对智能产品的设计,正在放飞自我。

根爆料,苹果在「未来设备」的规划里,有两个大胆的想法:

一是带有屏幕的 HomePod 正在研发中,当中将集成 Apple TV、FaceTime 等重多功能;二是配备摄像头的 AirPods,低分辨率的镜头将用来收集周身信息,并通过 AI 处理数据,以此「协助人们的日常生活」。

两个概念产品目前还处于探索阶段,但我仍惊讶于这种「前卫」的组合,以及一反苹果「简约」的理念,特别是带镜头的耳机,实在有些费解。

在翻阅相关文献资料时,一份代号为 US11432095B1 的苹果专利文件,似乎能证明「镜头+耳机」这对奇葩组合的可行性。

虚拟声场,离不开耳机上的镜头

先说总结,在这份专利文件中,加上摄像头的并非 AirPods (Pro),而是 AirPods Max;另外,当中涉及的技术也不是新闻中爆料的「AI 功能」,而是已经在 Vision Pro 上初见雏形的空间音频。

首先,我们要理清一个原理:人是如何辨别声音发出的位置的?

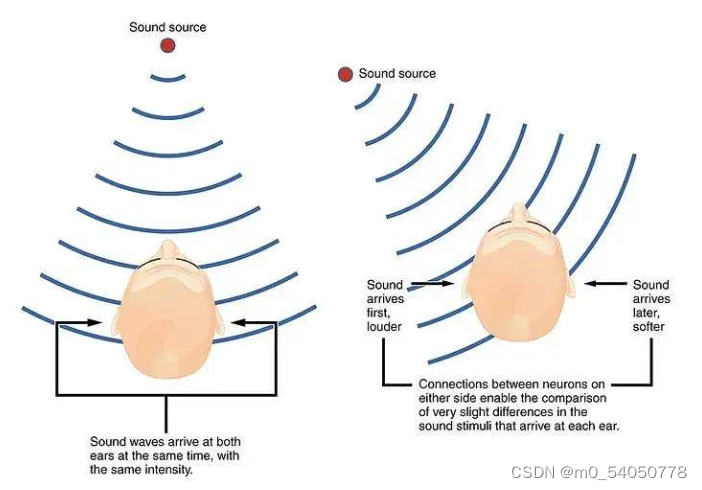

两只耳朵在头两侧的布局,除了美观,更重要的作用是让我们拥有了听声辨位的能力。

在保持同一水平线且轴对称的前提下,尽可能远离彼此,为的就是在听到同一个声源时,每只耳朵接收到的声音信息与另一只都有所差异,主要包括双耳时间差、强度差以及频率差三种,一般的来说这些差异都非常微小。

以时间差举例,生活中的大部分声音到达两只耳朵的时间都是不一样的,往往只有百微秒左右(眨 1/10 次眼的时间)的差别,我们感知不到,大脑则可以从这些几乎可以忽略不计的声源信息差异中,判断出孰先孰后听见,以此产生了「声音从那里发出」的感觉。

好比我们启用手表上「找手机」的功能时,耳朵就是通过各种声源差异,才能顺利发现手机掉进了沙发缝里。

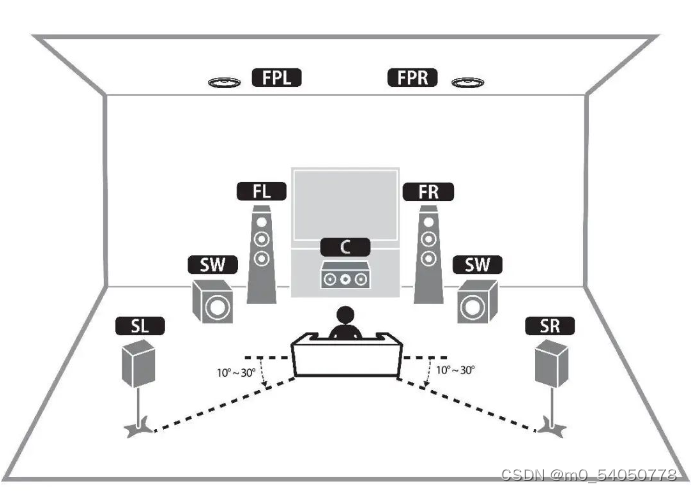

许多电影院和家庭影音设备正是利用了人耳极为敏感的特性,在有限的空间内用多声道的组合,实现环绕立体声,让观影在声音层面身临其境。

以上的信息包含了两个核心要素:

- 人能通过声源信息的差异实现听声辨位

- 声音从空间中不同位置发出造成了听觉上的差异

这份 US11432095B1 专利文件,就是在解释,苹果如何只通过耳机让用户听到来自四面八方的声音,就像是拥有了一整套环绕立体声设备。

这项技术,被称为「虚拟声场」。

拥有虚拟声场的设备能在当中构建若干个虚拟扬声器,通过听声辨位的生理特性,让每个扬声器都放在用户所处空间的固定位置,从而实现「一副耳机就是一套音响」的效果。

那,摄像头在当中发挥了什么作用?

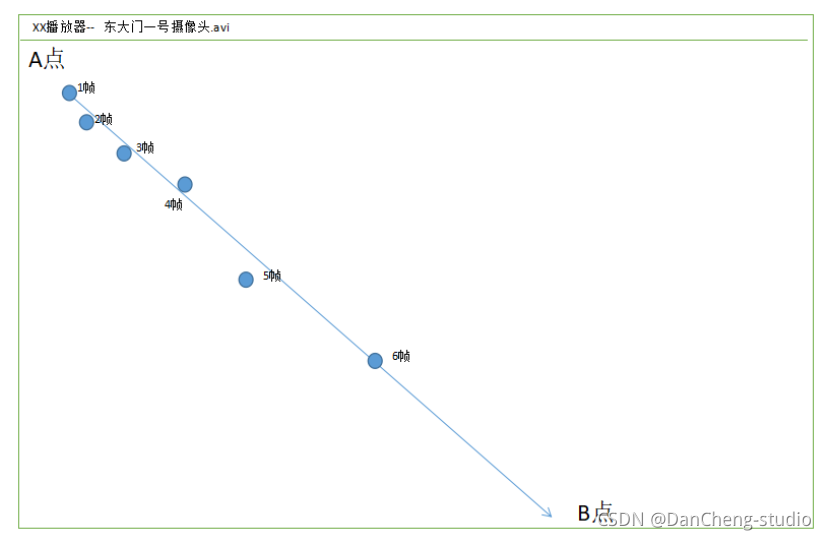

科技博主何同学在 Vision Pro 评测的视频中做过一个实验:把 Vision Pro 的一个应用窗口放在固定的位置后,往远处走了 300 余米再回到原地,窗口的位置几乎没有发生变化。

如此精准的定位来源于 Vision Pro 前方的视觉定位系统,通过红外线、摄像头等扫描所在空间的物理信息,并记录窗口在重构空间中的物理位置,以此实现了令人惊叹的准确定位。

AirPods Max 上的摄像头,也是利用相同的原理录入图像信息,再由跟踪处理器实时分析用户的头部位置信息,并且能够使用显示器和周围环境的映射作为参考,来跟踪用户的头部,实现双重保障。

搭配上 Apple TV 盒子中的摄像头,虚拟扬声器在房间内的位置就能确定下来,若干个声源从放在哪里、从哪发射,都有据可依。

简言之,镜头让 AirPods Max 拥有了视觉,虚拟声也能接近真实地还原实体音响的效果。

比起听到,我更愿意说成可以「看到」声音。

虚拟音响摆在哪、摆几个,都可以由用户自己设置,5.1 或 7.1 环绕声不用再大费周折地添置,甚至还能根据电视尺寸、位置和收听区域(包括房间的几何形状)实时调整;同时用户的坐姿也会影响虚拟音响在声场中的位置。

专利文件中还说明,在虚拟声场中,可以生成单独的一组一个或多个虚拟扬声器,并将其分配给多个带着相同设备的用户。

即使两人交换了座位,或是在房间里来回走动,虚拟声场都会根据用户的所在位置,调整每个虚拟音响的音效,使每个音源都能相对使用者保持静止。

另外,专利当中还对「显示器」做了特别说明,虚拟声场中的观影屏幕,不仅仅局限于传统的电视,而是拥有屏幕或投影的设备都可以实现此类功能,例如笔记本电脑、平板电脑、投影仪、台式电脑屏幕等(需要搭配带有摄像头的 Apple TV 盒子使用)。

也就是说,你的下一套环绕音响,为何不能是耳机?

![[java基础揉碎]super关键字](https://img-blog.csdnimg.cn/direct/02cf4646776e40c6b8a1d87b625d5bf0.png)