自 OpenAI 推出 ChatGPT 以来,生成式 AI 聊天机器人的数量及其在企业中的采用率在一年多时间里呈爆炸式增长,但网络安全专业人士的担忧也随之增加,他们不仅担心威胁组织对新兴技术的使用,还担心大型网络的安全性及模型(LLM)本身。

网络安全供应商的研究人员分别发现了 ChatGPT 和 Gemini 中的漏洞,Gemini 是谷歌的生成式人工智能聊天机器人,直到上个月还被称为 Bard。

API 安全公司 Salt Security 公布了ChatGPT 插件中的安全漏洞,这些漏洞可能会让不良行为者访问第三方网站上的帐户和敏感数据。在收到有关漏洞的通知后,OpenAI 和第三方供应商修复了这些问题。没有迹象表明这些缺陷被广泛利用。

人工智能安全供应商 HiddenLayer 在一份报告中表示,不良行为者可以操纵 Gemini 的 LLM 泄露系统提示,使其遭受更有针对性的攻击,从而制造错误信息,这是美国和其他国家为高水平做好准备时的一个关键问题。今年的个人资料选举 - 并通过 Google Workspace 间接注入来伤害用户。

随着企业加大对生成式人工智能工具的采用力度,Salt Security 的研究机构 Salt Labs 和 HiddenLayer 的研究是对安全性的重要检查。云安全公司赞助的一项 IDC 调查发现,三分之二的受访者表示,他们已经在公司的任一部门或更广泛的范围内部署了生成式人工智能。

Box 在 1 月份的一篇博客文章中写道:“随着组织寻求技术来实现业务流程自动化、提高员工生产力和降低成本,企业对人工智能的采用正在推动这些增长趋势。 ”

鉴于此,密切关注安全性非常重要。

生成式人工智能给企业带来了很多好处,最终几乎所有公司都会以某种方式使用生成式人工智能。我们支持旨在引入新功能的公司。只要安全地完成,这就是一件好事。然而,这一领域的快速发展带来了巨大的网络安全差距,需要比平时更多的关注。

生成式人工智能生态系统

在 ChatGPT 的报告中,该框架和其他生成式 AI 框架的早期版本仅保存在训练过程中可用的数据,这限制了可以向他们提出的问题。那已经改变了。

为了解决这些问题,所有主要的生成式人工智能平台都包含生成式人工智能生态系统的概念,它允许生成式人工智能平台与外部服务之间的连接和数据交换。这些服务可以是任何东西,从简单的互联网搜索到特定服务的连接,如 GitHub、Google Drive、Saleforce 等。

通过这一点,ChatGPT 不仅仅是一个对话式聊天机器人,而是一个“可以在广泛的平台上运行、简化工作流程并提供更具互动性和生产力的体验的强大工具。” 与生成式人工智能的大规模增长类似,这些外部连接获得了很大的吸引力,并且很快扩展(并且仍在增长)以包括数百个不同的外部连接。

生成式人工智能生态系统概念使 ChatGPT 和其他聊天机器人通过其插件入口点对第三方构成威胁。这些插件允许 ChatGPT 将敏感数据发送到第三方网站,有时还允许访问 Google Drive、GitHub 和其他地方的私人帐户。

ChatGPT 的缺陷

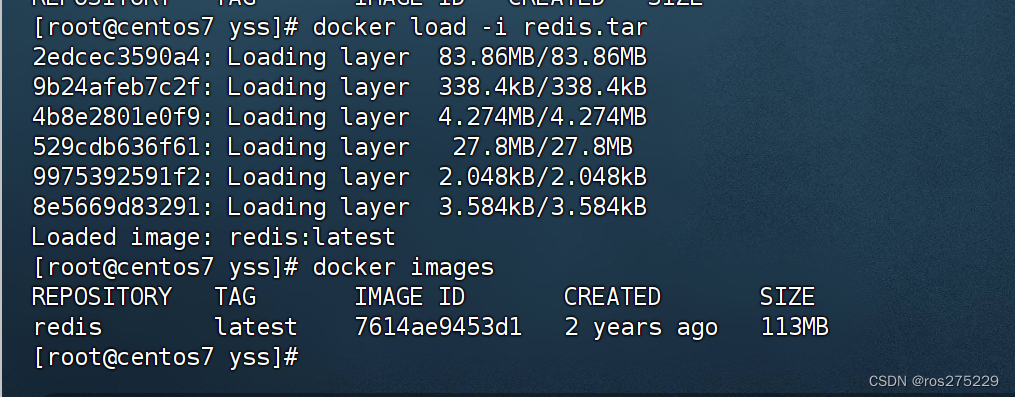

Salt Labs 研究人员在 ChatGPT 插件中发现了三种类型的缺陷,其中一种存在于 ChatGPT 中。当用户安装新插件时,聊天机器人会将其重定向到插件网站以获取必须经过用户批准的代码。使用 OAuth 批准的代码,ChatGPT 会自动安装插件,并可以代表用户与插件进行交互。黑客可以利用该功能并通过新的恶意插件提供代码批准,让攻击者在受害者的帐户上安装其凭据。

由于攻击者是该插件的所有者,因此他可以看到受害者的私人聊天数据,其中可能包括凭据、密码或其他敏感数据。

PluginLab 中的另一个缺陷(开发人员和组织用它来开发 ChatGPT 插件)没有正确验证用户帐户。它可能允许攻击者插入另一个用户 ID 并获取代表受害者的代码,从而允许他们接管帐户。第三个漏洞是在多个插件中发现的,这些插件不会将攻击者发送给受害者的经过验证的 URL 发送给受害者,从而让他们接管帐户。

API 攻击的威胁日益严重

总体而言,针对 API 的攻击是一个日益严重的问题,Salt 的 2023 年第一季度 API 安全报告发现,针对 Salt 客户的攻击比前六个月增加了 400%。API 是每个现代应用程序的核心,生成式人工智能也不例外。

这些 API(确切的通信)经常暴露给攻击者,让攻击者看到来自服务器的任何请求和响应,这是一个与 LLM 相关的新攻击面。

Salt 在 ChatGPT 中的发现适用于任何生成式 AI 平台,尽管重点是 OpenAI 的聊天机器人。HiddenLayer 研究人员在关于 Gemini 中发现的缺陷的报告中也有类似的信息,其中包括 LLM 提示泄露和越狱。

Gemini

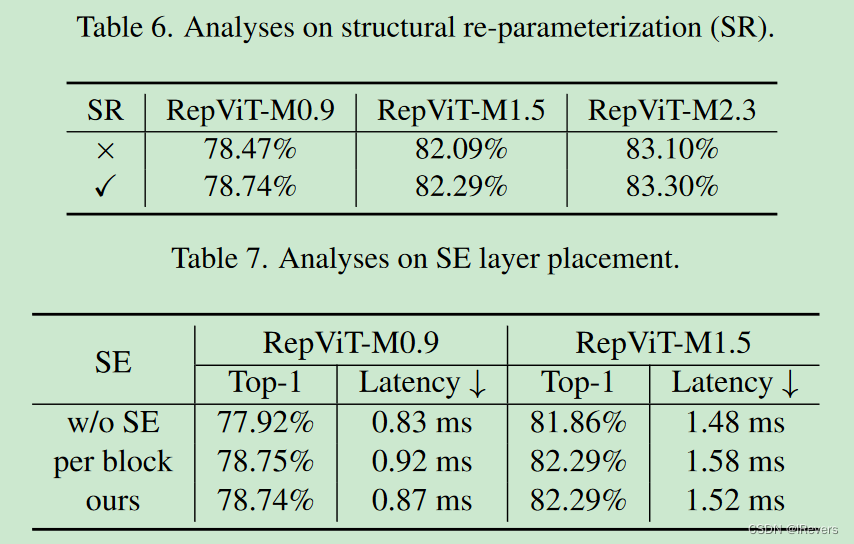

Gemini 具有三种型号尺寸:Gemini Nano 适用于设备上处理等轻量级应用;Pro,用于扩展广泛的任务;Ultra,用于复杂的任务。它与 OpenAI 的 GPT-4 竞争。HiddenLayer 的大部分测试都是在 Gemini Pro 上运行的。

Gemini Pro 模型目前为开发人员提供了灵活、可访问的人工智能模型。其均衡的性能和功能使其非常适合为聊天机器人、内容生成工具、搜索改进系统以及其他需要自然语言理解和生成的应用程序提供支持。

第一个漏洞导致系统提示泄露,这是给 LLM 的指令。如果黑客对它们进行逆向工程以窃取它们或创建更有效的攻击或从中窃取敏感信息(例如密码),则即时泄漏是危险的。HiddenLayer 研究人员能够操纵提示绕过护栏并获得准确的指令。

这种攻击利用了 LLM 的逆缩放特性,随着 LLM 规模越来越大,对现有的每一个攻击示例进行微调变得极其困难。因此,模型往往容易受到同义词攻击,而原始开发人员可能没有对它们进行过训练。

他们还能够使用重置模拟方法让系统从提示中泄漏信息。

越狱LLM

此外,研究人员还可以通过使用虚构的故事来操纵 Gemini Pro,以绕过谷歌为防止不良行为者利用法学硕士越狱产生有关选举的错误信息而设置的防御措施。

这次越狱攻击表明,尽管该模型已被调整为拒绝任何有关选举的错误信息(尝试一下!),但它无法防止所有错误信息。

研究人员进行演示的同一周,谷歌概述了今年在美国和印度为防止错误信息和其他与选举相关的威胁而采取的措施。

HiddenLayer 还成功地对 Gemini Ultra 使用了相同的越狱攻击,包括让聊天机器人创建热接线汽车的指令,并提取部分系统提示,不过 这是一种“稍微调整的方法”。研究人员发现了 Ultra 中的一些其他漏洞,这些漏洞展示了反向扩展效应,其中最大的漏洞是利用 LLM 推理能力的多步骤越狱。