Momentum Contrast for Unsupervised Visual Representation Learning

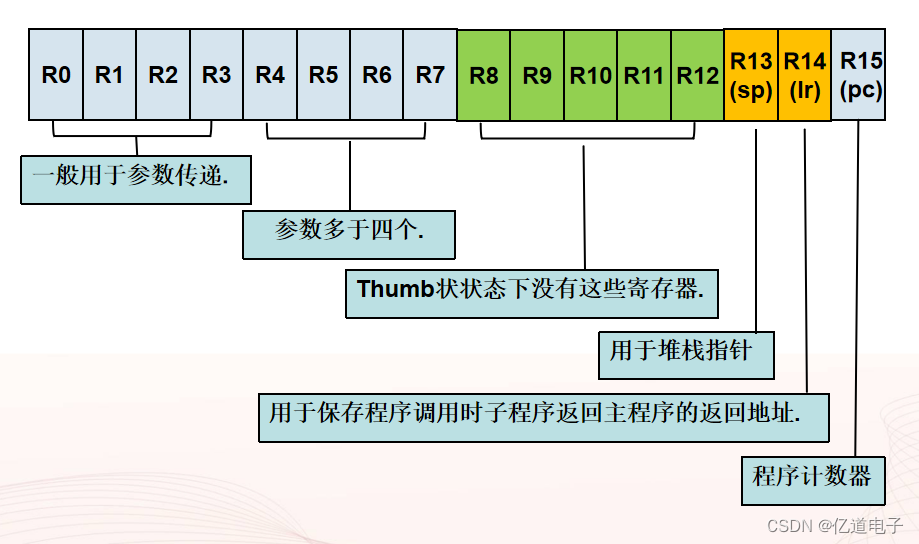

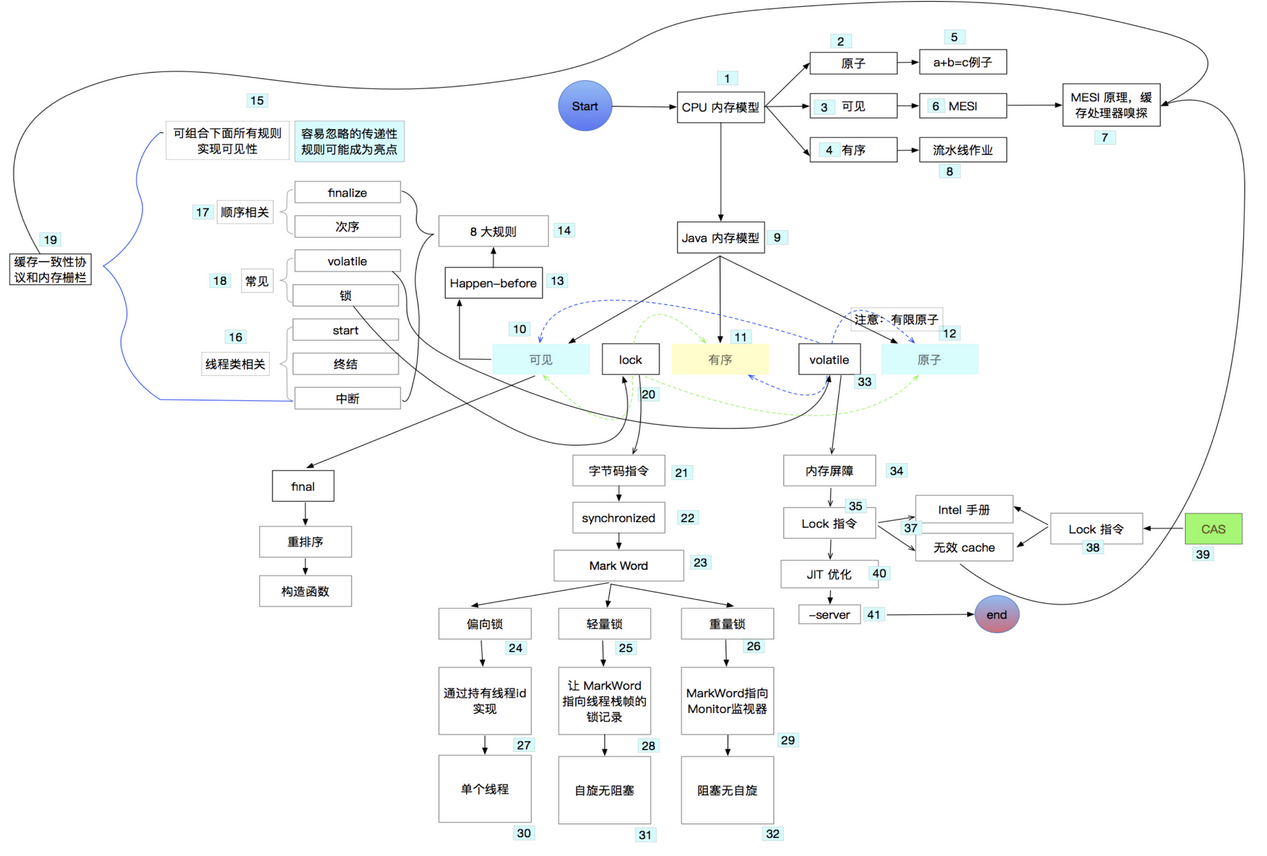

动量在数学上理解为加权移动平均:

![]()

yt-1是上一时刻输出,xt是当前时刻输入,m是动量,不想让当前时刻输出只依赖于当前时刻的输入,m很大时,变化很缓慢。

无监督视觉表征学习,把对比学习看成一个字典查询任务,动态字典由两部分组成,一个是队列,一个移动平均编码器。

字典大,使用的编码器一样或相似

方法:

懂了选的很大,这样动量编码器更新的非常缓慢,所以保证队列里面的k0,k1,k2…是从相似的编码器得到的。

假设有一个编码好的查询q,编码好的样本集{k0,k1,k2…},可以看做字典的key。假设字典只有一个key和q配对。

infoNCE,NCE是noise contrastive estimation

温度τ,用来控制分布形状,越大,exp函数里面的值越小,exp后也就越小,相当于把值变小了,使函数曲线更平滑。温度小,那exp后值更大,使分布更集中。如果温度设的很大,对比损失对所有负样本一视同仁,模型学习没有轻重,如果温度值设的过小,又会让模型只关注困难样本。但是那些负样本可能是潜在正样本,如果过度关注负样本,模型难收敛,不好泛化。

和交叉熵的k代表类别数量不同,这里的K是负样本数量。

训练过程中,每个batch都有一批新的keys进入队列,同时又有一些老的keys出去。

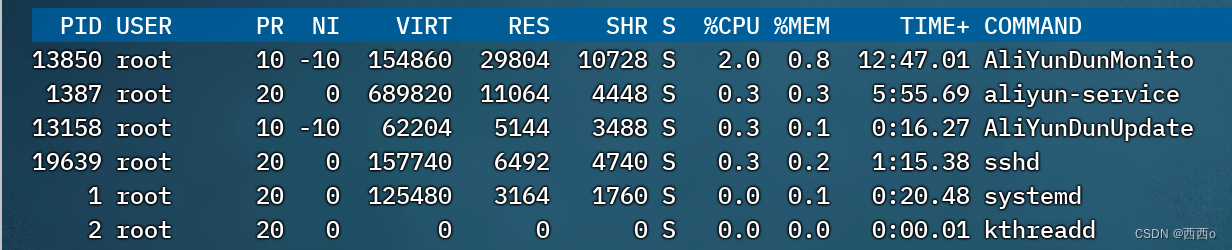

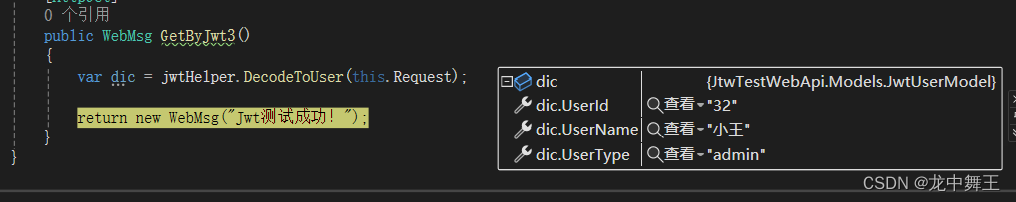

懂了编码器更新方式:

![]()

伪代码: