NIPS 2024

paper

Intro

离线强化学习一般需要带奖励标签的数据,而现实中这种标签获取困难。本文提出一种基于搜索的离线方法SEABO。SEABO以无监督学习的方式,对最接近专家演示的transaction较大的奖励,否则分配较小的奖励。

Method

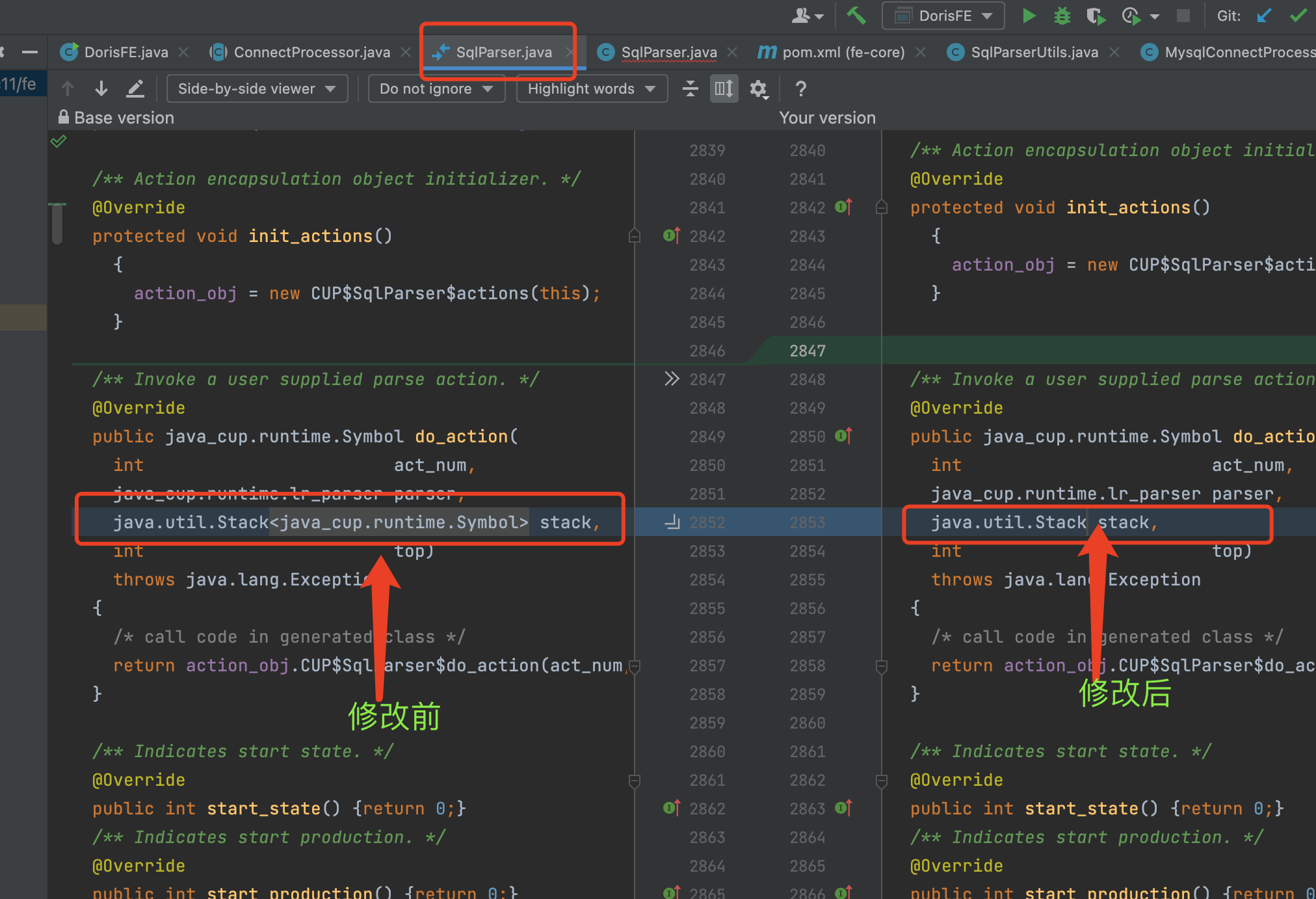

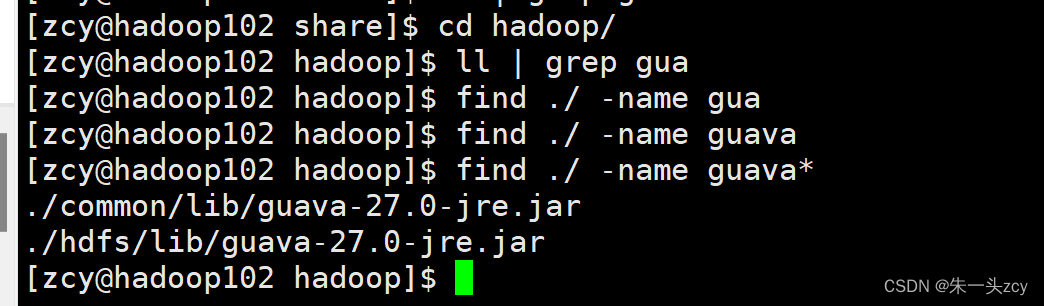

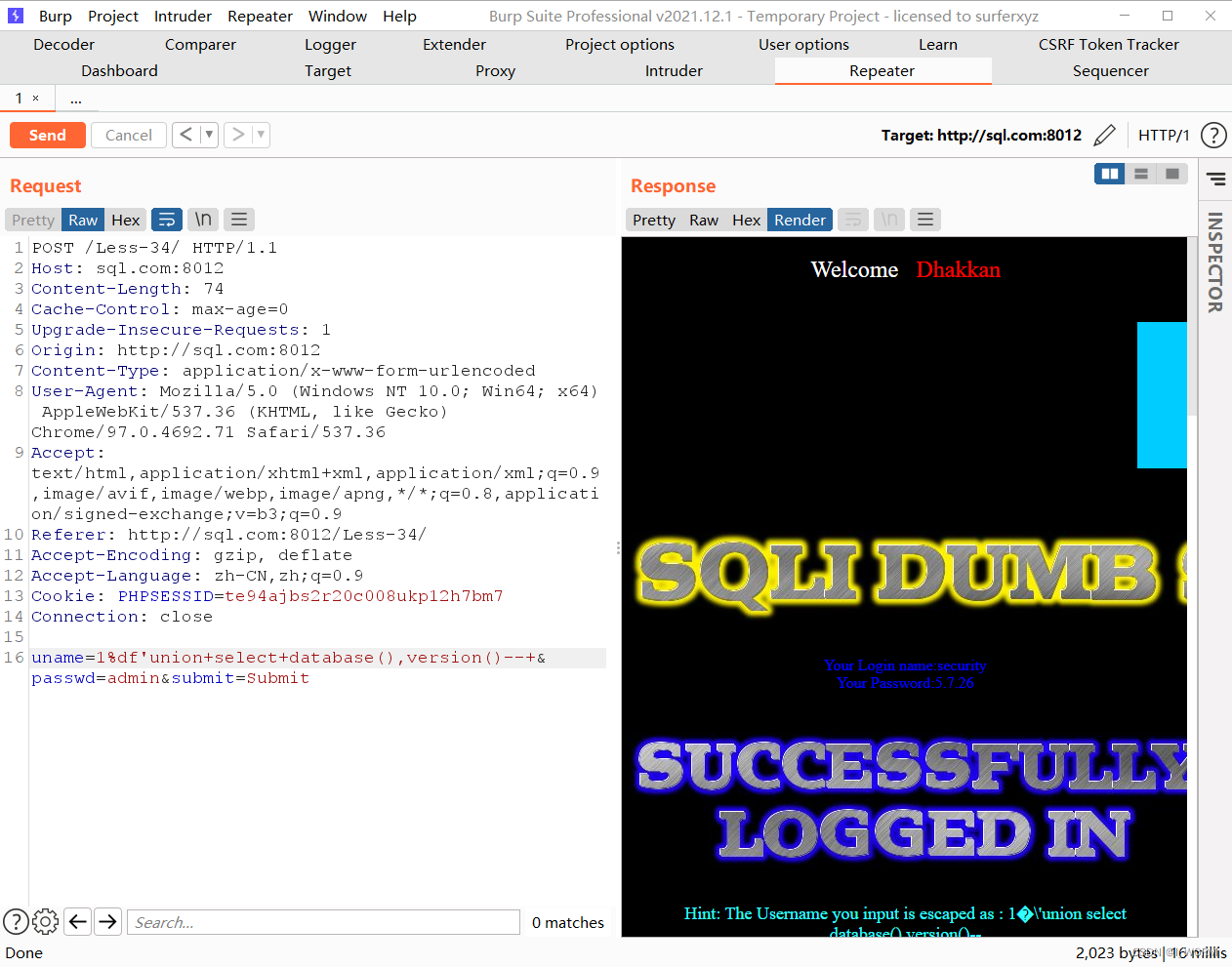

SEABO采用KD-tree搜索最近邻的专家数据,距离度量方法采用默认的欧氏距离: d = D ( ( s ~ e , a ~ e , s ~ e ′ ) , ( s , a , s ′ ) ) d=D((\tilde{s}_{e},\tilde{a}_{e},\tilde{s}_{e}^{\prime}),(s,a,s^{\prime})) d=D((s~e,a~e,s~e′),(s,a,s′))。

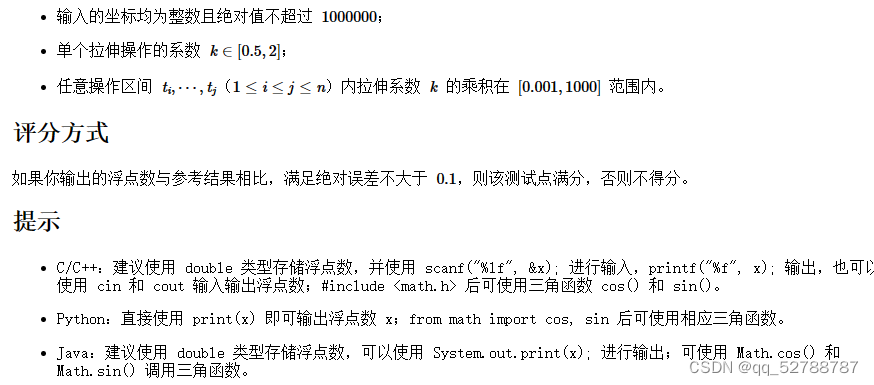

奖励函数的设计将基于上面的距离 d : r = α exp ( − β × d ∣ A ∣ ) d:r=\alpha\exp\left(-\frac{\beta\times d}{|\mathcal{A}|}\right) d:r=αexp(−∣A∣β×d)。这样无标签的数据将获得奖励标签,然后结合其他Offline RL方法进一步优化策略。算法伪代码如下: