深度学习:基于PyTorch的模型解释工具Captum

- 引言

- 简介

- 示例

- 安装

- 解释模型的预测

- 解释文本模型

- 情绪分析

- 问答

- 解释视觉模型

- 特征分析

- 特征消融

- 鲁棒性

- 解释多模态模型

引言

当我们训练神经网络模型时,我们通常只关注模型的整体性能,例如准确率或损失函数值。然而,理解模型为何做出特定预测,哪些输入特征对模型决策影响最大,对于构建可解释、可信赖和健壮的模型至关重要。为此,Facebook AI研究团队开发了captum库,这是一个开源项目,旨在帮助研究人员和开发人员更好地理解PyTorch模型的运行机制。

简介

Captum(拉丁文"comprehension"的词根,意为理解)是一个开源、可扩展的库,用于构建在 PyTorch 上的模型可解释性。Captum能够与任何PyTorch构建的模型相适配。它提供了多种解释算法,包括Integrated Gradients、Deep Lift、Feature Ablation等。这些算法可以针对单个输出或一组输出应用,并可在CPU或CUDA上运行。Captum还提供了一个交互式可视化工具,让用户能够轻松地观察和比较不同特征的影响。更多详细内容可见官网https://captum.ai/。

示例

以下展示了如何安装和使用captum:

安装

# conda 安装

conda install captum -c pytorch

# pip 安装

pip install captum

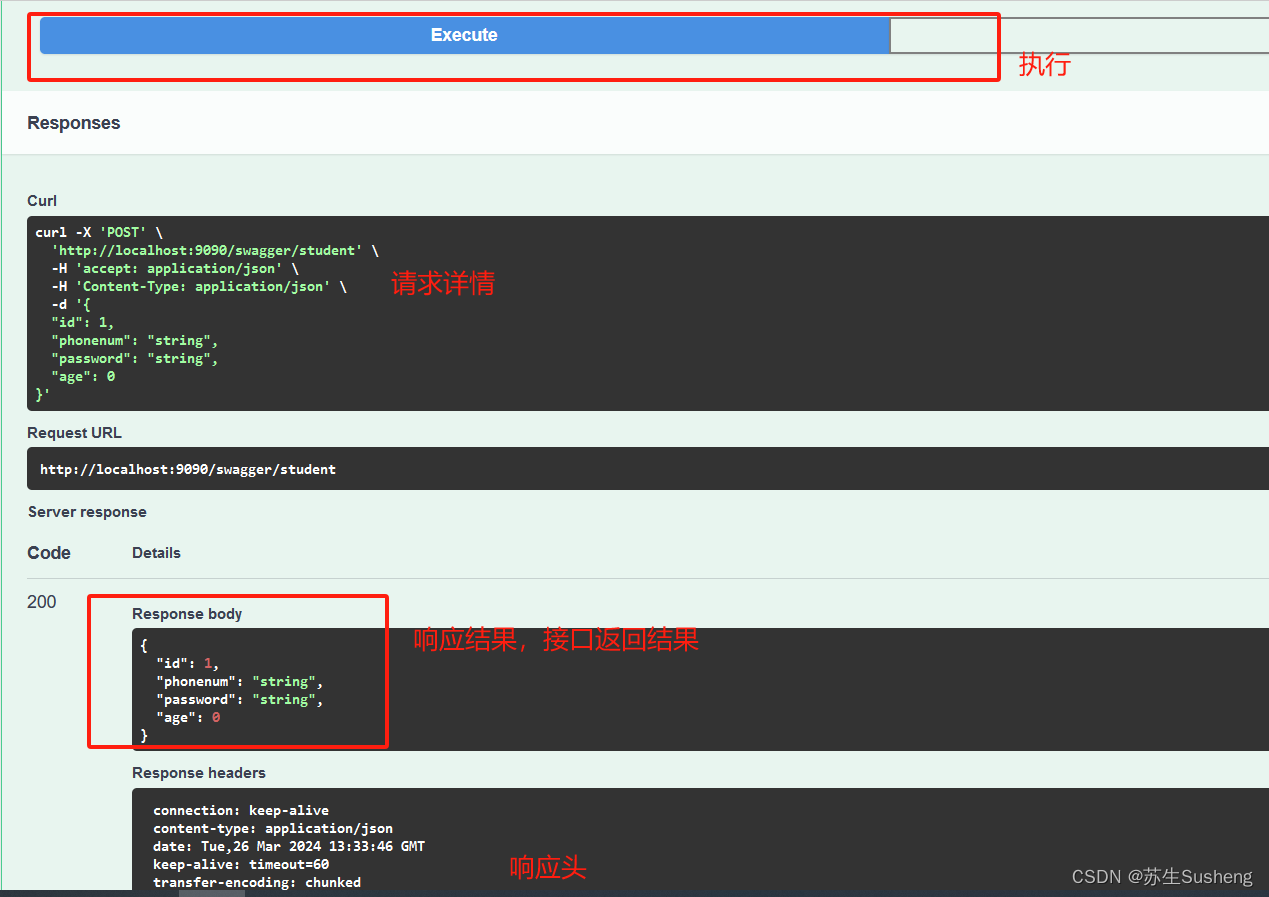

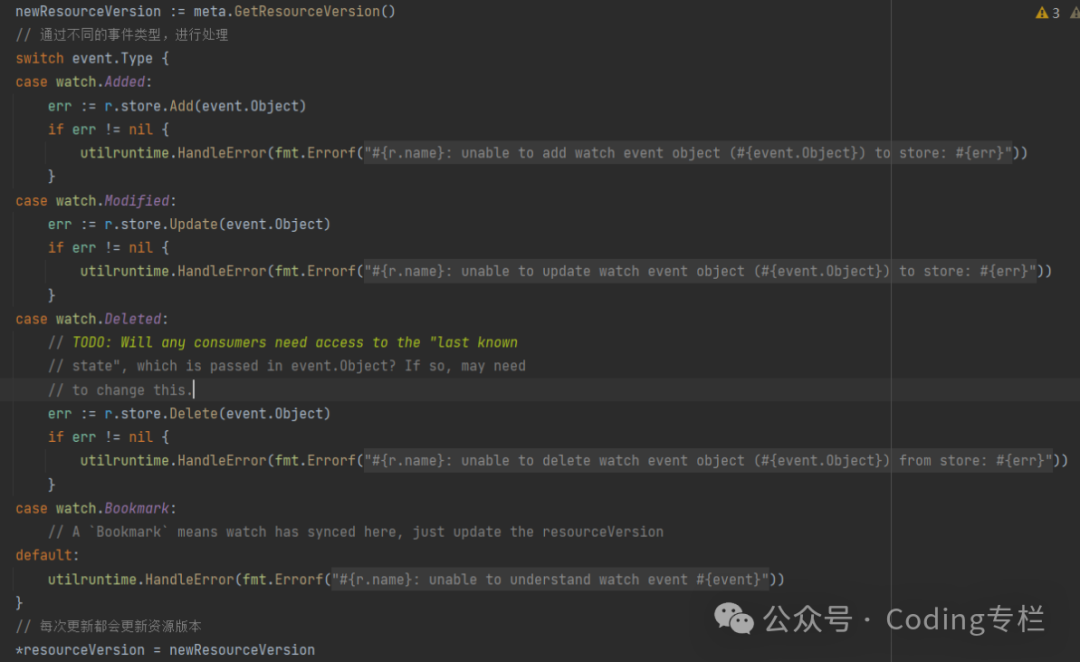

解释模型的预测

利用Integrated Gradients算法分析输入对于目标输出的贡献度,并打印出结果。

from captum.attr import IntegratedGradients# 假设model是我们用PyTorch构建和训练好的模型

# input是模型的输入数据

# target是我们想要解释的分类输出ig = IntegratedGradients(model)

attr, delta = ig.attribute(input, target=target, return_convergence_delta=True)

print('Integrated Gradients Attribution:', attr)

print('Convergence Delta:', delta)

解释文本模型

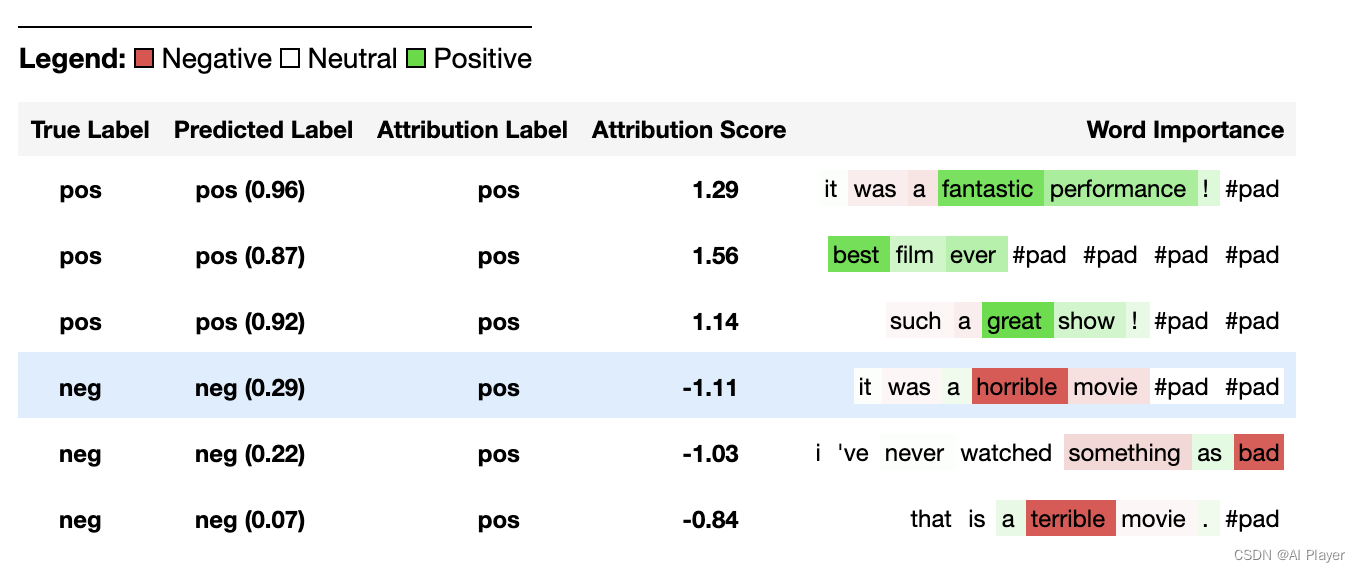

情绪分析

此示例加载预训练的CNN模型使用Integrated Gradients算法对IMDB数据集进行情绪分析。

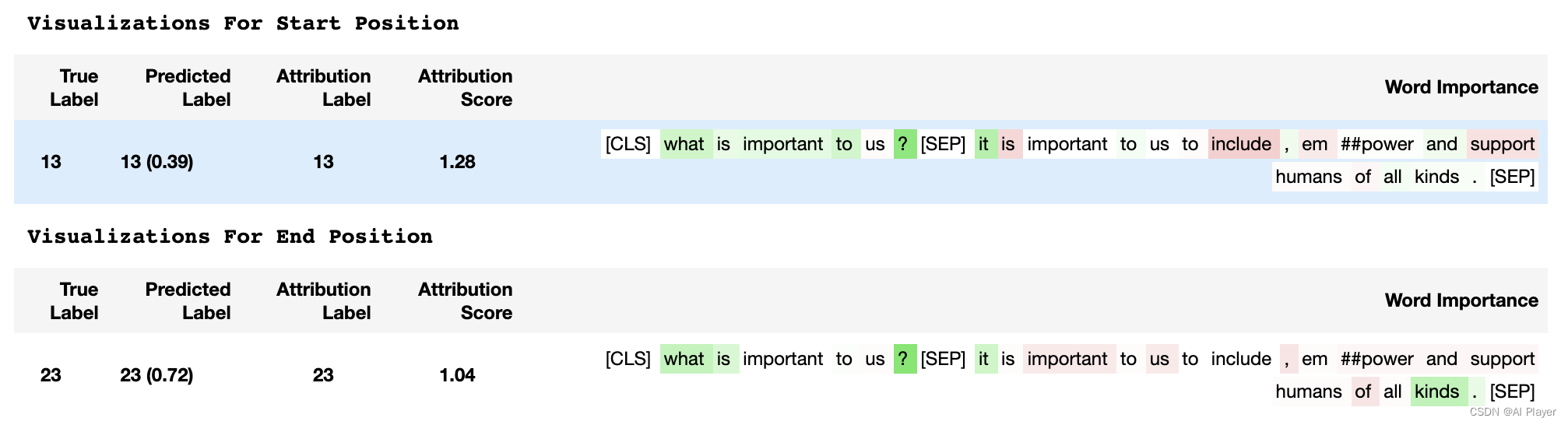

问答

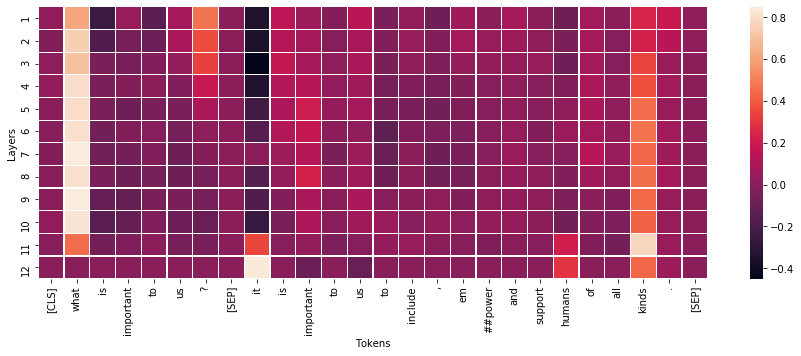

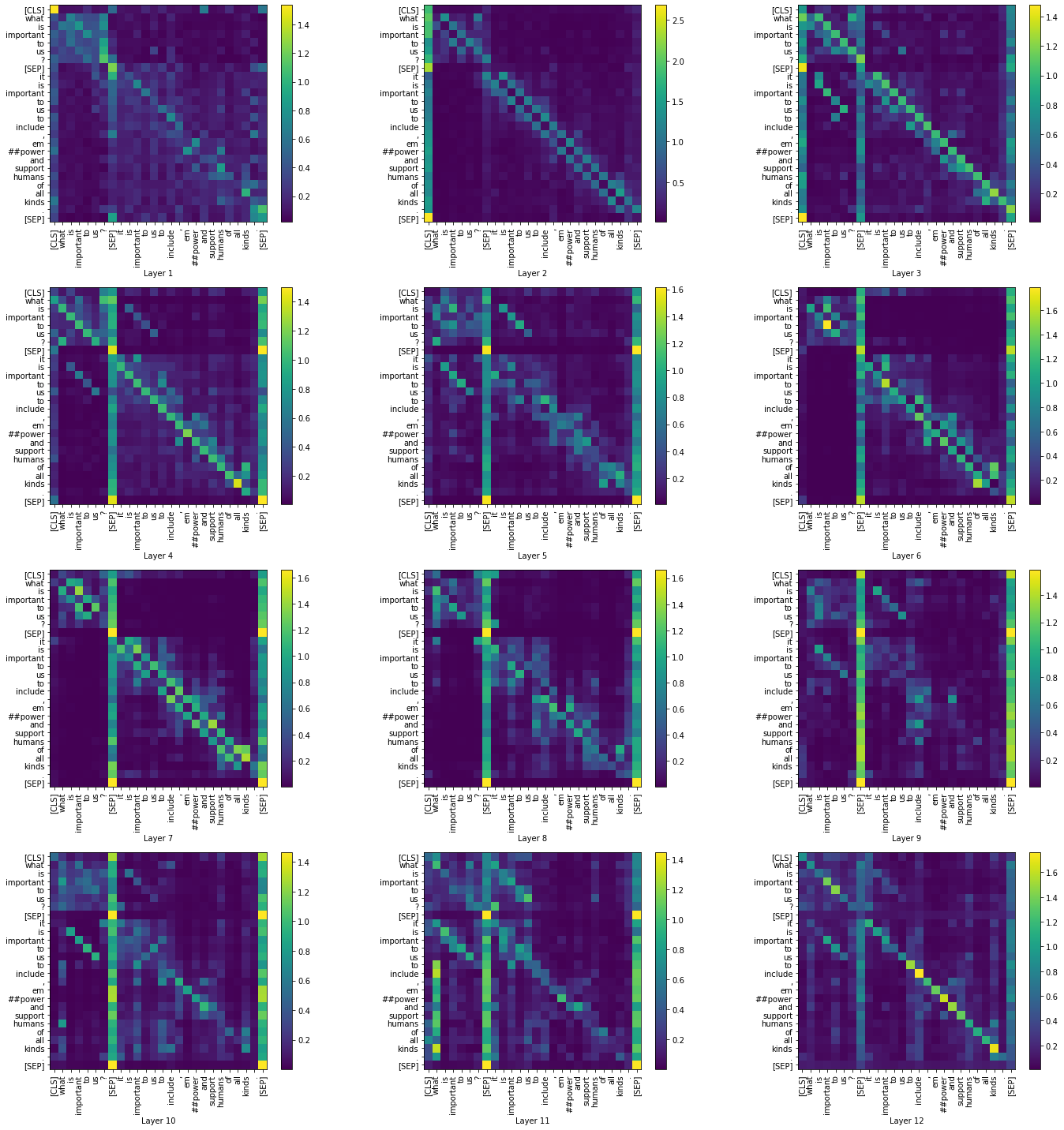

此示例使用 Captum 解释用于问答的 BERT 模型,使用 Hugging Face 的预训练模型,并在 SQUAD 数据集上进行了微调,并展示了如何使用 hooks 来检查和更好地理解嵌入和注意力层。

此示例使用attribution和Integrated Gradients算法分析注意力矩阵。此分析有助于我们识别不同tokens之间的强交互对,以进行特定模型预测。我们将我们的发现与向量norm进行比较,结果表明attribution分数比向量norm更有意义。

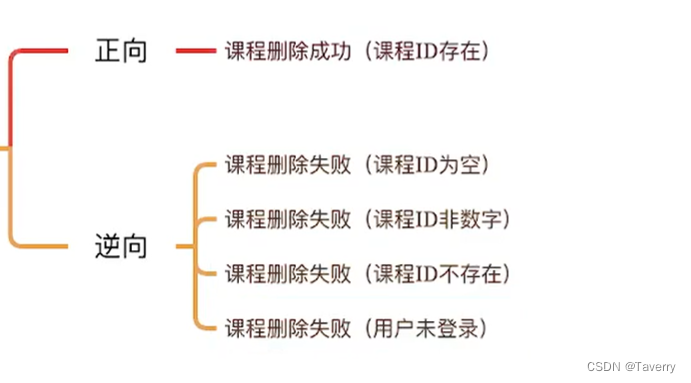

解释视觉模型

特征分析

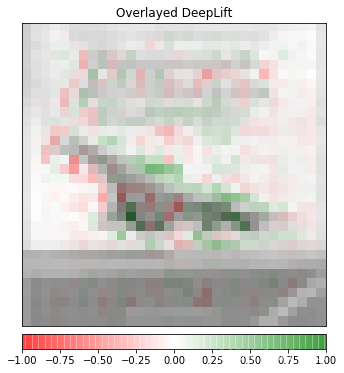

此示例加载预训练的CNN模型使用Integrated Gradients和DeepLIFT算法对CIFAR数据集进行特征分析。

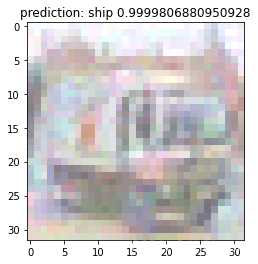

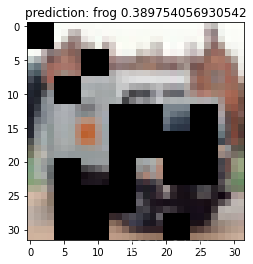

特征消融

此示例利用分割掩码来定义输入特征的消融组,并展示了这种分析如何帮助理解输入的哪些部分影响模型中的特定目标。

鲁棒性

此示例将 FGSM 和 PGD 等鲁棒性攻击以及 MinParamPerturbation 和 AttackComparator 等鲁棒性指标应用于在 CIFAR 数据集上训练的模型。除此之外,它还演示了如何将鲁棒性技术与归因算法结合使用。

解释多模态模型

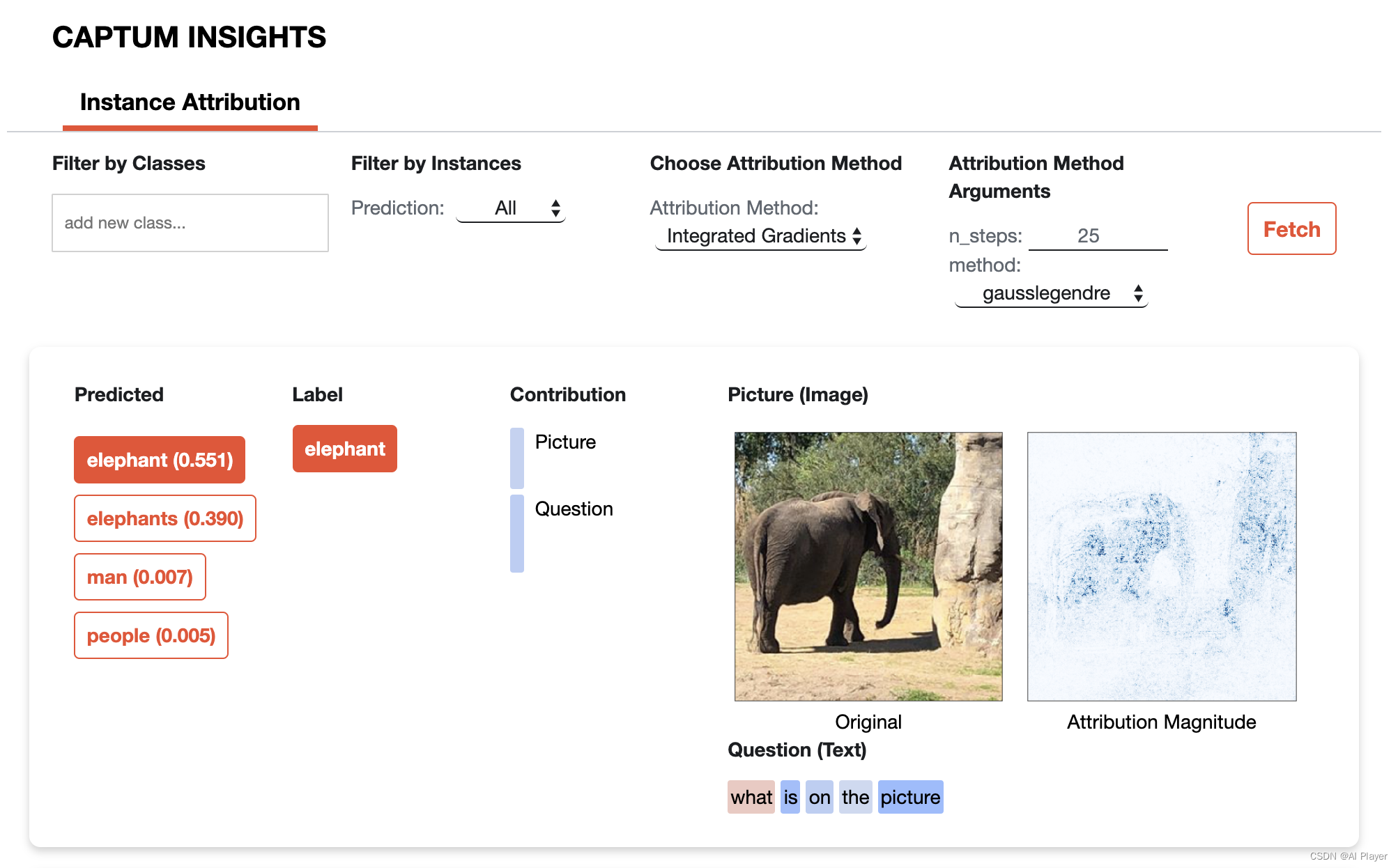

此示例针对开源视觉问答(VQA)模型,使用Integrated Gradients算法解释了几个测试问题的输出,并分析了模型文本和视觉部分的归因分数。