介绍一下我的是ubuntu20.04.机载电脑是orinnx,通过源码烧写的系统。

首先打开终端,输入

pip install evo --upgrade --no-binary evo安装过程中出现如下问题

缺少 onnx 库还有Pandas 版本不兼容,

ONNX(Open Neural Network Exchange)是一个开源的深度学习框架中立的模型格式,用于促进不同深度学习框架之间的互操作性。它允许将一个框架中训练好的模型转换为另一个框架中使用的模型,避免了将不同框架的模型绑定到一个特定平台上的问题。

pandas 是一个流行的 Python 数据处理和分析库,它提供了强大的数据结构(如 DataFrame 和 Series)和用于数据操作、清洗、分析、可视化的功能。还有一些警告

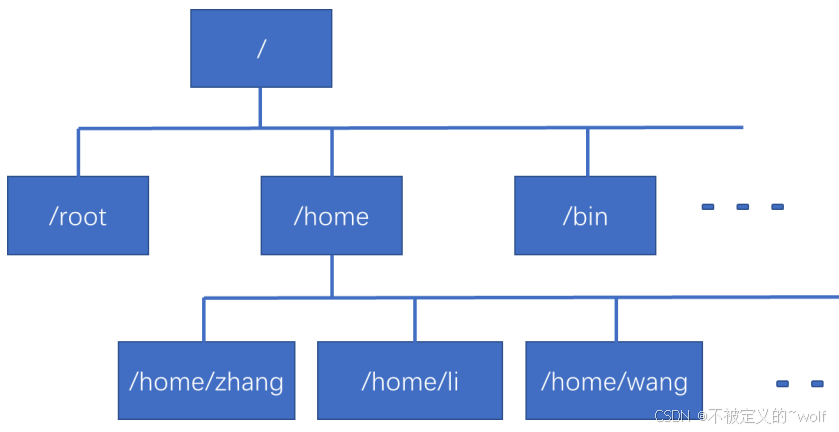

警告关于路径:安装了一些脚本(如 f2py, fonttools, evo 等)在 /home/glc/.local/bin 目录下,但该目录不在你的 PATH 环境变量中。

先解决 onnx 和 pandas 的问题。

输入

pip install onnx

会出现如下警告

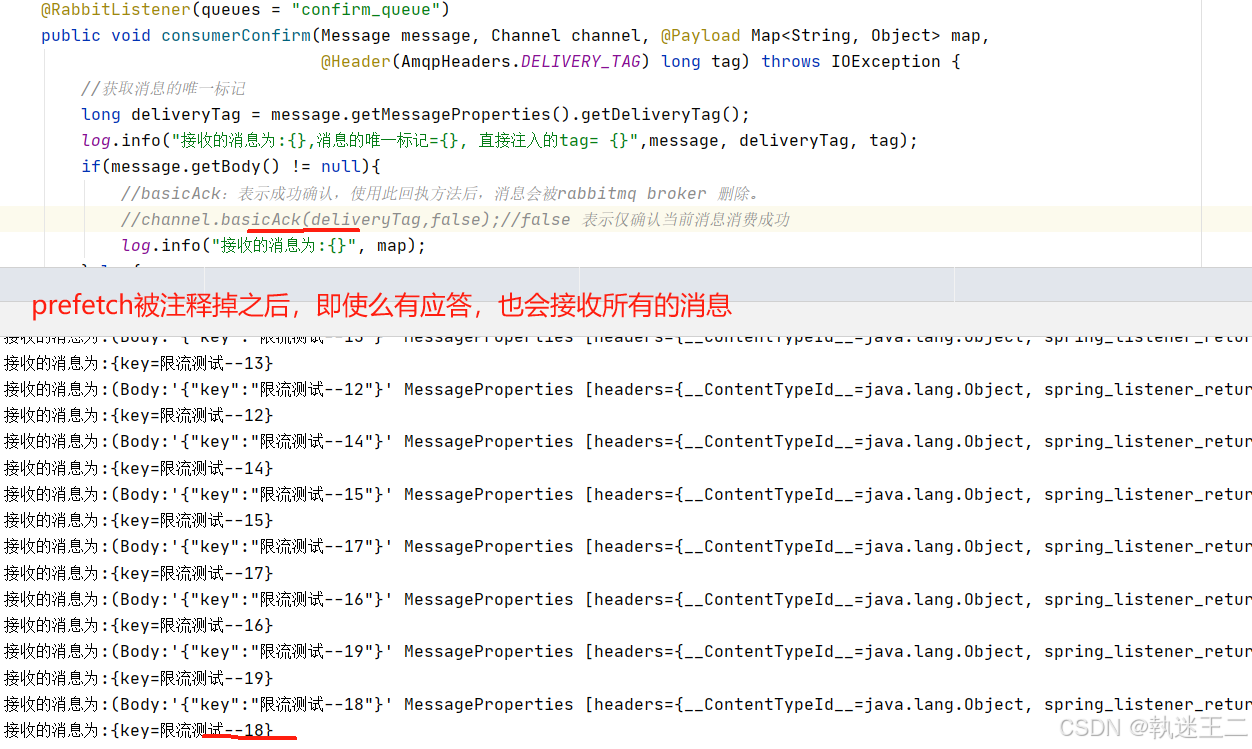

在你运行 pip install onnx 命令时,系统成功地下载并安装了 onnx 库及其依赖项 protobuf。

警告提示:提示 backend-test-tools、check-model 和 check-node 等脚本被安装到了 /home/glc/.local/bin 目录,但这个目录并不在你的 PATH 环境变量中。这意味着,如果你想在命令行直接使用这些脚本,你需要将 /home/glc/.local/bin 加入到你的 PATH 中。

输入

export PATH=$PATH:/home/glc/.local/bin

source ~/.bashrc

然后输入

pip install --upgrade pandas

出现如下即可

最好再输入一遍

pip install onnx

pip install --upgrade pandas

出现如下

我的pandas 和 onnx 都已成功安装并更新。具体步骤如下:

pandas安装成功:你已成功安装并更新了pandas到版本 2.0.3。onnx安装成功:onnx版本 1.17.0 已成功安装,而且没有需要更新的内容

最后再输入一次

pip install evo --upgrade --no-binary evo此时出现

这样从信息来看,evo 包已经是最新版本(1.31.0),并且所有依赖项都已经满足,因此安装/升级操作已经成功完成。没有报错信息,说明一切正常。到此evo安装完成。