首先默认你已经有了azure的账号。

最重要的是选择gpt-35-turbo-instruct模型、api_version:2023-05-15,就这两个参数谷歌我尝试了很久才成功。

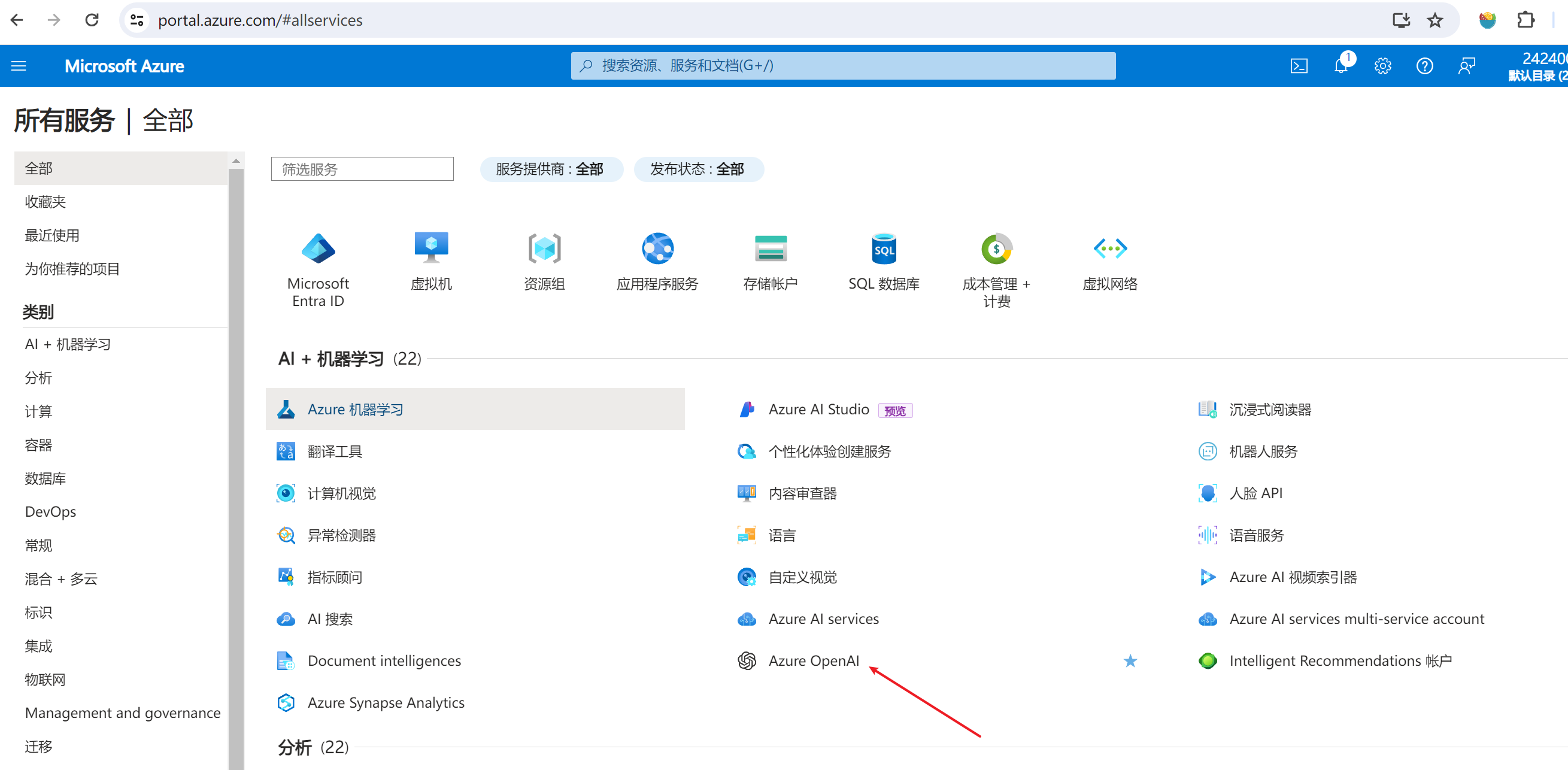

我们打开https://portal.azure.com/#home,点击更多服务:

我们点击Azure OpenAI:

再点击创建:

azure访问有点慢,我们等一会后会跳转到下面页面:

如果没有资源组,则输入一个就行:

点击确定。

再看实例名称和定价层:

这里的名称会体现到最终调用时的接口域名地址,比如我们这里是在langchain中使用,我们就输入这个名称了,定价层就选择和我一样的就行,具体什么作用见:https://azure.microsoft.com/zh-cn/pricing/details/iot-central/

回到正文,上述必填项都填好后,点击下一页:

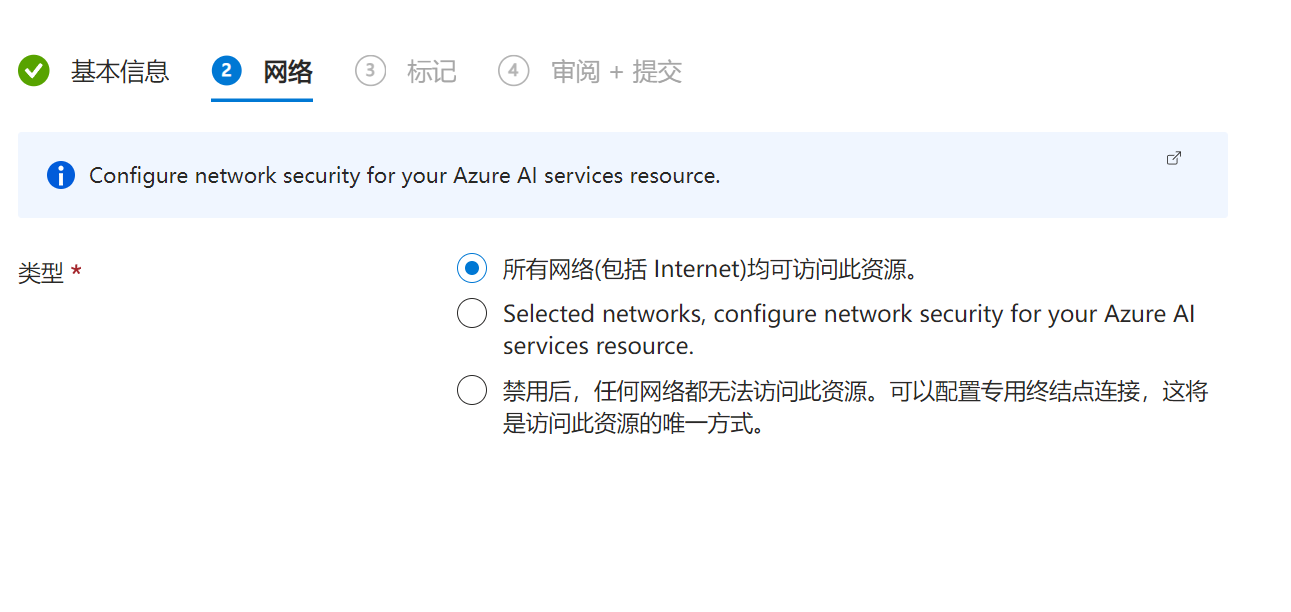

选择第一个:

再点下一页:

这一步的标记,我也没搞懂啥作用,我就跳过了,也不影响后面的使用,有知道的朋友也可以在评论区告诉我一下,我这里是直接点下一页了。

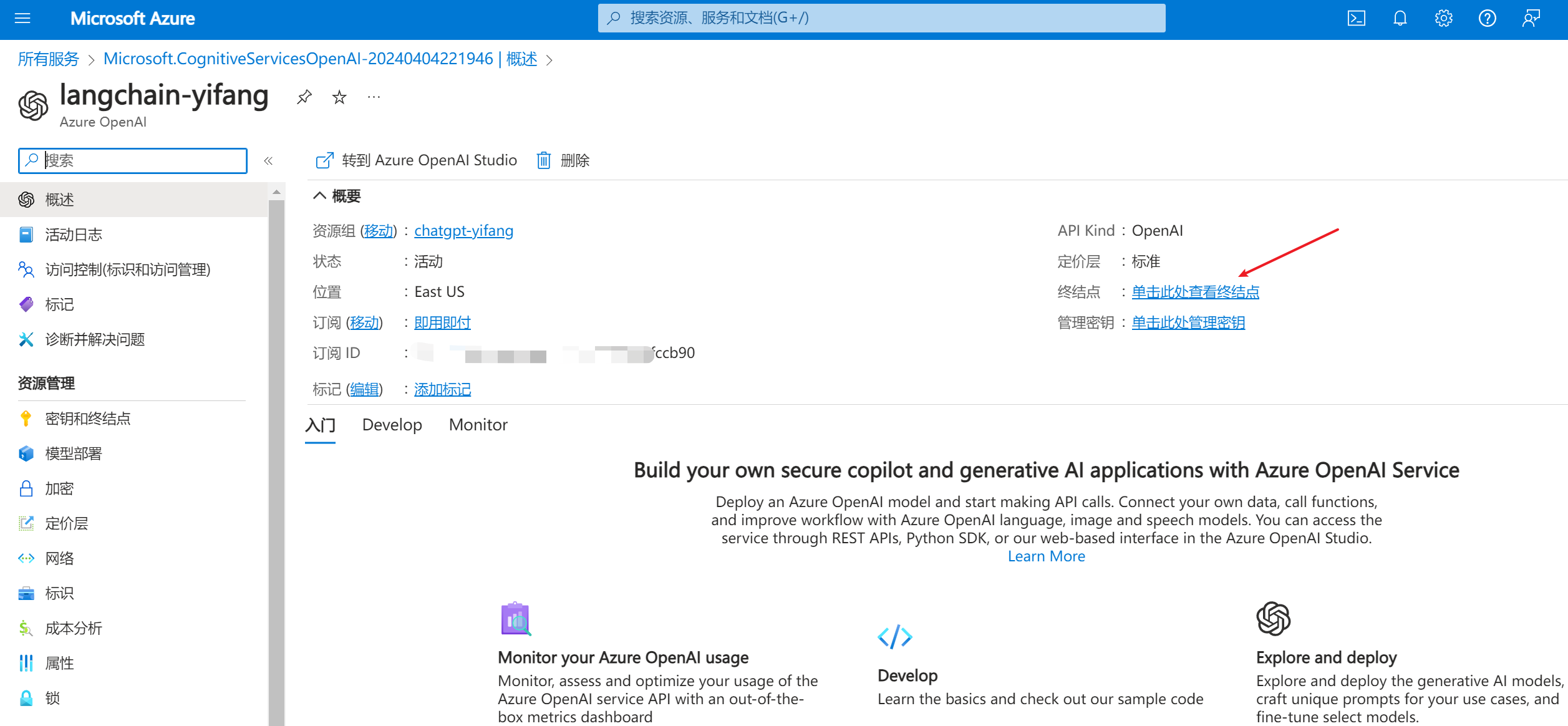

确认没问题后点击创建,之后系统会开始部署资源,部署好是这样的,我们点击转到资源:

我们先点击:单击此处查看终结点:

我们复制一下其中一个密钥和终结点的链接,因为在langchain要用到:

我们再点击模型部署:

这里要点击管理部署,跳转新页面。

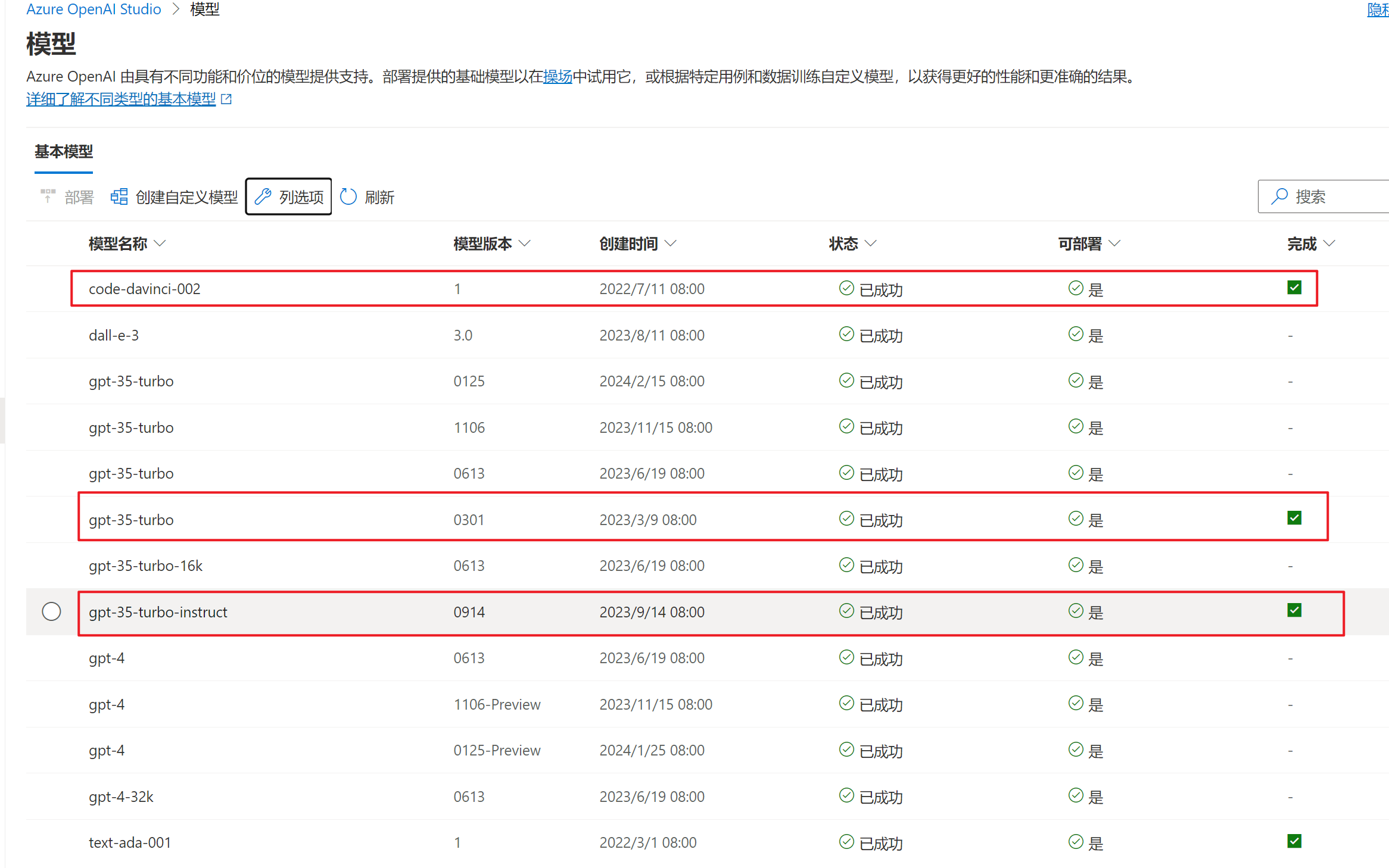

在管理部署页,我们先看看模型:

这里按流程操作一下,主要是为了看哪个能用以langchain:

这里有好几个是可以完成的:

我们再回到部署页,输入:gpt-35-turbo-instruct:

最后点击创建,等待部署,这个步骤挺快的:

部署好了:

OK,到此为知,azure相关的资源配置就完成了,接下来我们去langchain中配置并调通azure chatgpt接口:

使用conda创建一个虚拟python环境:

conda create -n loogchain_study1 python=3.10

当然也可以不创建虚拟环境,看个人习惯,创建虚拟环境只是为了pip包之间隔离,每个项目使用不一样的python版本和pip包。

创建好环境后,还需要激活环境:

conda activate loogchain_study1

再pip安装一下langchain所需的包:

pip install langchain_openai

pip install langchain

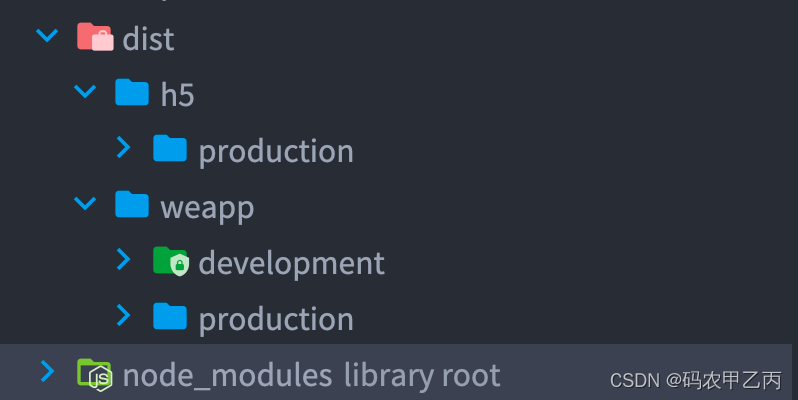

我们新建一个空目录专门用来放langchain的学习项目,我的做法是在这个空目录下建立setting.py(配置环境变量)和main.py(调用):

setting.py代码如下:

import os

# 传入刚才复制的密钥,就是有两个的密钥,复制其中一个即可

OPENAI_API_KEY = "xxxxxxxxxxxx"

# 这里的链接是终结点,直接复制过来就行

AZURE_OPENAI_ENDPOINT = "https://openai-study-yifang.openai.azure.com/"

# 其他参数不用动了

OPENAI_API_VERSION = "2023-05-15"

deployment_name = "gpt-35-turbo-instruct"

os.environ["OPENAI_API_KEY"] = OPENAI_API_KEY

os.environ["AZURE_OPENAI_ENDPOINT"] = AZURE_OPENAI_ENDPOINT

os.environ["OPENAI_API_VERSION"] = OPENAI_API_VERSION

main.py最小可运行代码:

from langchain_openai import AzureOpenAI

import setting

llm = AzureOpenAI(deployment_name=setting.deployment_name)

# 直接发起会话

def direct_chat():

text = "来个笑话"

print(llm(text))

if __name__ == '__main__':

direct_chat()

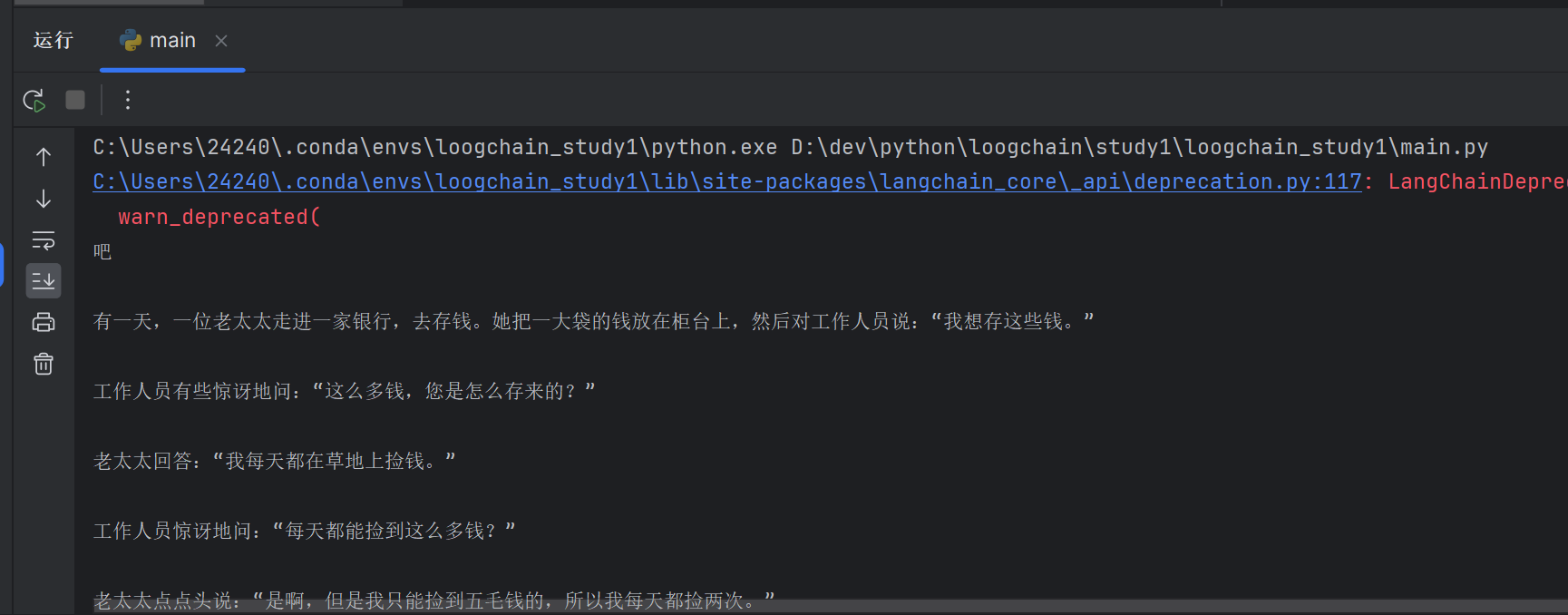

点击pycharm的运行:

就有结果了:

最后附上langchain的中文网指南:https://www.langchain.asia/getting_started/getting_started

这篇文章就到这里啦!如果你对文章内容有疑问或想要深入讨论,欢迎在评论区留言,我会尽力回答。同时,如果你觉得这篇文章对你有帮助,不妨点个赞并分享给其他同学,让更多人受益。

想要了解更多相关知识,可以查看我以往的文章,其中有许多精彩内容。记得关注我,获取及时更新,我们可以一起学习、讨论技术,共同进步。

感谢你的阅读与支持,期待在未来的文章中与你再次相遇!

![[leetcode]remove-duplicates-from-sorted-list](https://img-blog.csdnimg.cn/img_convert/4359dfc6aeefad449c07c3fe7b8a27c7.jpeg)