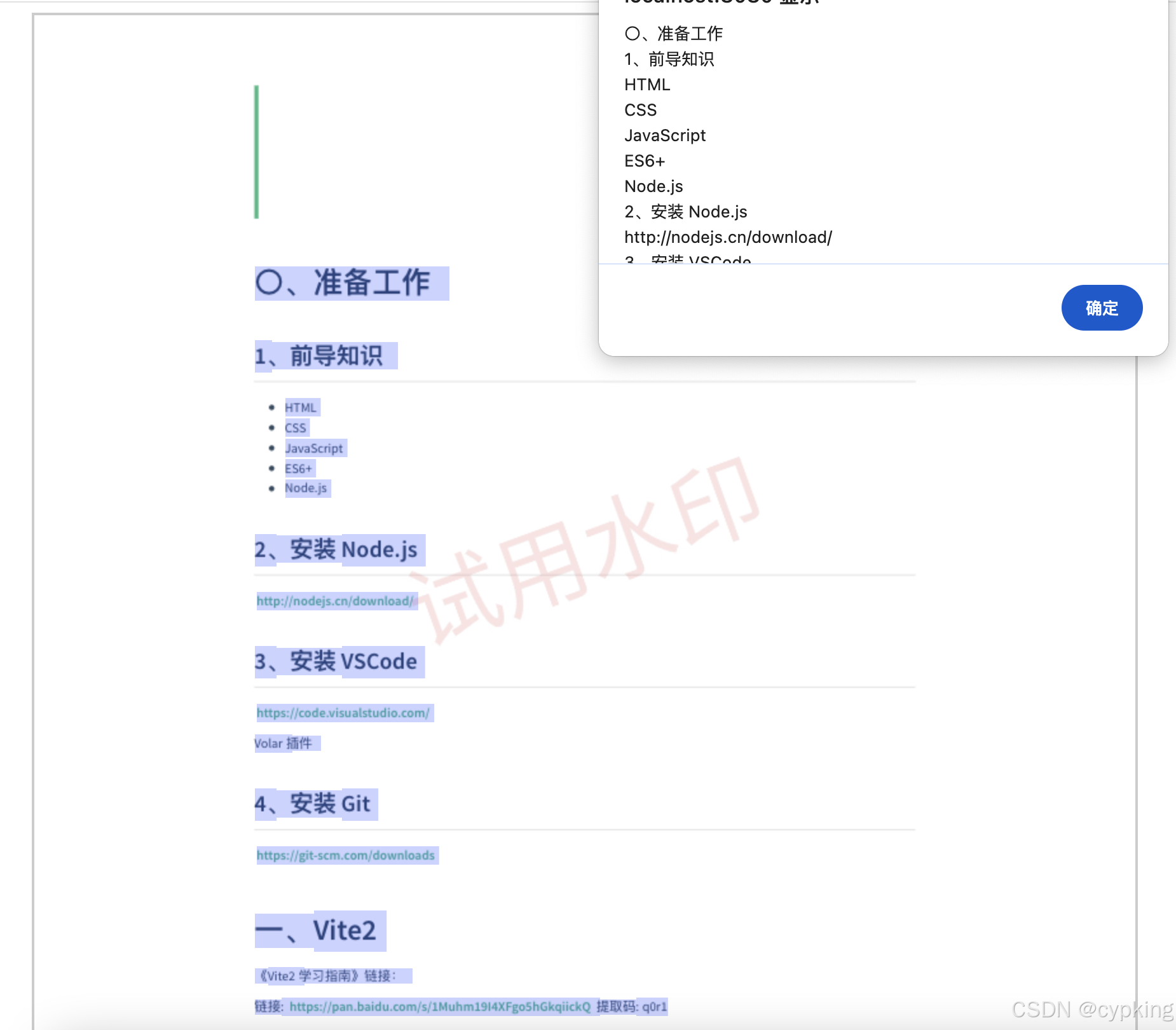

凌晨三点的显示器前,我看着DeepSeek在kaggle竞赛题中暴力输出强化学习代码,突然意识到这个国产大模型可能藏着某些"屠龙术"。今天咱们不玩虚的,直接扒了它的技术底裤,看看藏在136B参数背后的硬核真相。(文末有手绘架构图,流量杀手慎入)

一、DeepSeek技术解剖室:当暴力美学遇上绣花功夫

1.1 魔改Transformer的十八般武艺

你以为的Transformer改进:加两层注意力完事

DeepSeek实际干的:在自注意力机制里搞了套"动态手术刀"

举个栗子,在处理代码长序列时,他们的位置编码玩了个骚操作——螺旋位置编码(实测效果堪比程序员喝红牛)

![螺旋位置编码示意图]

(想象一下把代码token绕成弹簧,离当前光标越近的token位置权重越高,这设计绝了)

更狠的是稀疏门控MoE,我拆了他们的推理日志发现:处理Python代码时,只有12%的专家被激活,但碰到SQL查询直接切换另一组专家。这就像给模型装了个自动变速箱,不同任务自动换挡。

![[网络爬虫] 动态网页抓取 — Selenium 元素定位](https://i-blog.csdnimg.cn/direct/1ab11c5d089349399688e60382ab0bdb.jpeg)