目录

一、什么是爬虫

二、爬虫的主要用途

三、学会爬虫需要掌握的技能

四、爬虫使用的语言

五、编写爬虫需要的库,以python为例

六、爬虫示例-python

示例一

示例二

示例三

一、什么是爬虫

爬虫,又称网络爬虫或网页爬虫,是一种用来自动浏览互联网的网络机器人。其主要功能是收集网页信息,这些信息可以被搜索引擎用来创建索引。爬虫通常依照某种预定的规则访问网页,获取所需的数据,例如网页的内容、元数据甚至是特定链接等,然后记录或存储这些信息供进一步处理或分析。

二、爬虫的主要用途

- 搜索引擎:搜索引擎(如Google、Bing等)使用爬虫来收集互联网上的信息,创建一个可搜索的索引。

- 数据挖掘:爬虫可以用于收集特定类型的信息(如商品价格、新闻文章、社交媒体帖子等),这些信息可以用于数据分析或机器学习。

- 网站监控:爬虫可以定期检查网站以检测是否有更新或更改。

- 网络档案:组织如互联网档案馆使用爬虫来创建网页的历史记录。

- 市场研究:公司可以使用爬虫来收集竞争对手的信息,如价格、产品列表等。

- 社交媒体分析:爬虫可以用于收集社交媒体上的公开信息,以分析公众情绪或趋势。

请注意,虽然爬虫有很多合法的用途,但是滥用爬虫可能会违反隐私权或版权法,或者对网站服务器造成负担。因此,使用爬虫时应遵守相关法律和道德规范。

三、学会爬虫需要掌握的技能

- 熟悉一种或多种编程语言:Python是最常用的爬虫开发语言,因为它有许多强大的库可以使用,如Beautiful Soup,Scrapy等。

- HTTP协议:理解HTTP请求和响应,包括GET、POST请求,状态码,请求头和响应头等。

- HTML和CSS:能够解析和查找网页中的信息。

- 正则表达式:用于从文本中提取信息。

- 使用爬虫库/框架:如Python的Beautiful Soup,Scrapy,Requests等。

- JavaScript:许多现代网站都使用JavaScript进行动态加载,所以理解JavaScript以及如何与它交互是很有用的。

- 网站结构和数据存储:理解如何从网站URL、网页结构中提取信息,知道如何存储抓取的数据,常见的有CSV, JSON, XML, 或者数据库。

- 反爬虫策略:理解并能应对各种反爬虫机制,如IP限制,User-Agent限制等。

- 异步加载和AJAX:许多网站使用异步加载技术,需要理解并能处理。

- 使用代理:为了防止IP被封锁,需要学会使用代理。

- 自动化和分布式爬虫:对于大规模的爬虫任务,可能需要使用自动化工具和分布式系统。

这些技能的掌握程度取决于你要进行的爬虫任务的复杂性和规模。

四、爬虫使用的语言

爬虫可以使用的编程语言包括但不限于:

- Python:因为其丰富的爬虫库(如 Scrapy, BeautifulSoup, Requests 等)和易读性强的语法,Python 是最常用的爬虫编程语言。

- Java:Java 的强大性能和广泛的库支持也使其成为编写爬虫的一个好选择。

- JavaScript(Node.js):对于需要处理大量异步操作和解析 JavaScript 的爬虫,Node.js 是一个很好的选择。

- Ruby:Ruby 和其框架 Rails 也可以用来编写爬虫,尤其是对于 Ruby on Rails 网站。

- PHP:虽然不太常见,但 PHP 也可以用来编写爬虫。

- C#:.NET 平台的 C# 也可以用来编写爬虫,尤其是在 Windows 环境下。

- Perl:Perl 的强大文本处理能力使其成为编写爬虫的一个选择。

- Golang:因为其并发性能强大,Golang 也被用于编写爬虫。

这些语言的选择取决于具体的项目需求和开发者的熟悉程度。

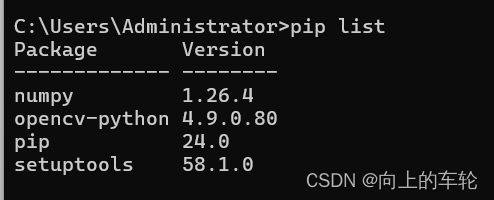

五、编写爬虫需要的库,以python为例

使用Python编写爬虫,常用的库有:

- Requests:这是一个用于发送HTTP请求的库,可以用来下载网页。

- BeautifulSoup:这是一个用于解析HTML和XML文档的库,可以用来解析网页并提取信息。

- Scrapy:这是一个强大的爬虫框架,可以用来编写爬虫并处理如爬取策略、存储数据等复杂问题。

- Selenium:这是一个用于自动化网页交互的工具,可以用来处理需要交互或者JavaScript渲染的网页。

- lxml:这是一个解析库,可以用XPath和CSS选择器等方式来提取信息。

- PyQuery:这是一个类似于jQuery的解析库,可以用来方便地提取信息。

- Pandas:这是一个数据处理库,可以用来清洗和处理爬取到的数据。

这些库可以根据需要进行选择和组合使用。

六、爬虫示例-python

示例一

以下是一个简单的Python爬虫示例,使用了Requests和BeautifulSoup库来爬取一个网页上的标题:

import requests

from bs4 import BeautifulSoup# 目标URL

url = 'http://example.com'# 使用requests库发送GET请求

response = requests.get(url)# 使用BeautifulSoup解析网页

soup = BeautifulSoup(response.text, 'html.parser')# 提取网页标题

title = soup.find('title').textprint(title)这个爬虫会发送一个GET请求到'http://example.com',然后解析返回的HTML,提取并打印出网页的标题。

请注意,这只是一个非常基础的爬虫示例,实际的爬虫可能需要处理更复杂的情况,如JavaScript渲染的页面、登录和会话管理、数据存储、错误处理、爬取策略等。

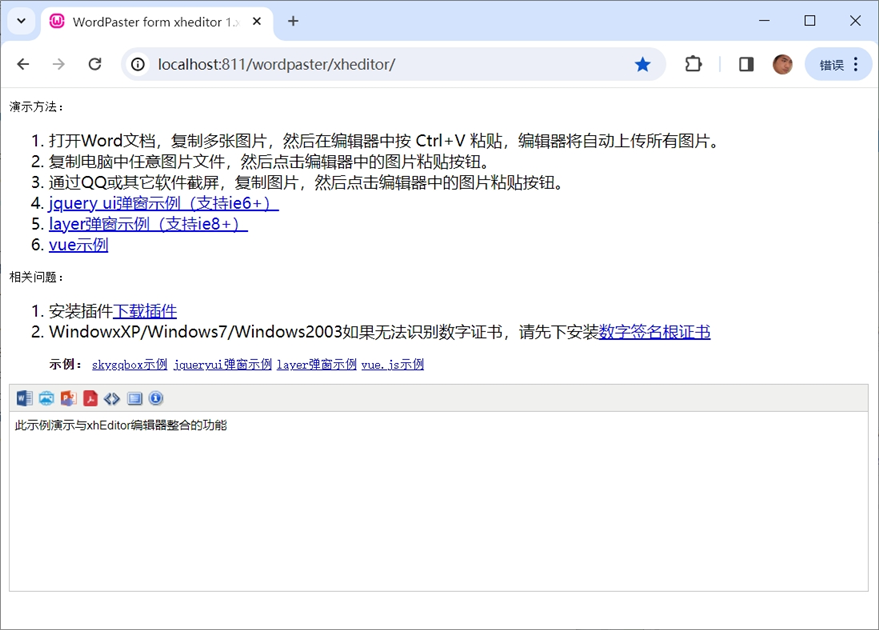

示例二

以下是一个使用Python的Scrapy框架来爬取quotes.toscrape.com网站上的名言的例子。Scrapy是一个强大的爬虫框架,可以处理更复杂的爬取任务。

首先,你需要创建一个Scrapy项目:

scrapy startproject quotes_spider然后,在quotes_spider/spiders目录下创建一个名为quotes.py的文件,内容如下:

import scrapyclass QuotesSpider(scrapy.Spider):name = "quotes"start_urls = ['http://quotes.toscrape.com/page/1/',]def parse(self, response):for quote in response.css('div.quote'):yield {'text': quote.css('span.text::text').get(),'author': quote.css('span small::text').get(),}next_page = response.css('li.next a::attr(href)').get()if next_page is not None:yield response.follow(next_page, self.parse)最后,你可以运行这个爬虫:

scrapy crawl quotes这个爬虫会爬取每一页的名言,并将名言的文本和作者作为字典返回。当爬取完一页后,它会查找下一页的链接,并继续爬取,直到没有下一页为止。

请注意,这只是一个基础的Scrapy爬虫示例,实际的爬虫可能需要处理更复杂的情况,如登录和会话管理、数据存储、错误处理、爬取策略等。

示例三

以下是一个使用Python的requests, BeautifulSoup, pandas和selenium库的示例,用于爬取一个动态加载的网页并处理数据。

首先,确保你已经安装了所有需要的库:

pip install requests beautifulsoup4 pandas selenium然后,你需要下载一个WebDriver,比如Chrome的WebDriver,用于selenium控制浏览器。

以下是爬虫代码:

import time

import pandas as pd

from bs4 import BeautifulSoup

from selenium import webdriver# 初始化一个driver

driver = webdriver.Chrome('/path/to/your/chromedriver') # 替换为你的chromedriver的实际路径

# 访问网页

driver.get('http://example.com')# 等待JavaScript加载完成

time.sleep(5)# 获取网页源代码

html = driver.page_source# 使用BeautifulSoup解析

soup = BeautifulSoup(html, 'html.parser')# 提取数据

data = []

for item in soup.find_all('div', class_='item'): # 替换为你实际要爬取的元素和类名data.append({'title': item.find('h1').text, # 替换为你实际要爬取的元素'content': item.find('p').text # 替换为你实际要爬取的元素})# 使用pandas处理数据

df = pd.DataFrame(data)

print(df)# 关闭driver

driver.quit()这个爬虫首先使用selenium访问网页并等待JavaScript加载完成,然后获取网页源代码。接着,使用BeautifulSoup解析网页并提取数据。最后,使用pandas处理数据。

请注意,这只是一个基础的示例,实际的爬虫可能需要处理更复杂的情况,如登录和会话管理、错误处理、爬取策略等。