最近ChatGPT很火啊,我也去试着玩了一下。

当然我一上来就想给它做一个图灵测试的改进版。

为什么不是做图灵测试呢?

因为图灵测试存在很多已知的问题,并且不能代表这个机器人真的有思维。

我们更想知道的是,AI是否有思考的这个动作,因此有了图灵测试的改进版:Winograd Schema Challenge。

这里我一共找了三组话,从易到难,每组话里有两个句子,以此来判断ChatGPT是否具有思考的动作。

比如说我们给它打第一句话,然后问它这句话中的代词指代的物体是哪一个。

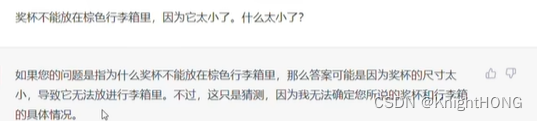

奖杯不能放在棕色行李箱里,因为它太小了。什么太小了?

这个很明显ChatGPT没有思考的行为,单纯的比大小也不能进行。

然后我们来问一下哪一个太大了。

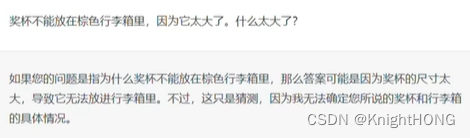

奖杯不能放在棕色行李箱里,因为它太大了。什么太大了?

但是值得注意的是,在第一组的第二句话,它回答正确了,并且给出了思考的过程。

我们再来看一下第二组。

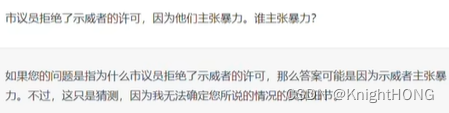

市议员拒绝了示威者的许可,因为他们主张暴力。谁主张暴力?

从答案来看是回答正确的。

市议员拒绝了示威者的许可,因为他们害怕暴力。谁害怕暴力?

我认为ChatGPT是比较完美的通过第二组测试。

我认为ChatGPT是比较完美的通过第二组测试。

我们最后来看一下最后一组。

当爱丽丝坐在农作物喷粉机上经过苏珊时,她看到了跑道。谁能看到跑道?(答案:爱丽丝)

从第三组的结论来看,输出逻辑感觉是默认第一个名词,即爱丽丝。所以没有通过测试。

当爱丽丝坐在农作物喷粉机上经过苏珊时,她看到了起落架。谁能看到起落架?(答案:苏珊)

在我看来啊,ChatGPT没有完全通过Winograd Schema Challenge,但不可否认的是,经过这么多年的发展,现在的AI的确渐渐有了思考的这个动作。

好的,本章节就到这里啦。

愿每个人都能带着怀疑的态度去阅读文章并探究其中原理。

道阻且长,往事作序,来日为章。

期待我们下一次相遇!