目录

- 云主机 ECS:云计算的强大引擎

- 什么是云主机ECS?

- 为何选择云主机ECS?

- 使用移动云ECS进行Kubernetes集群搭建

- 1. 环境准备

- 2. 安装步骤

- 2.1 在每一个节点上执行的操作

- 2.1.1 系统准备

- 2.1.2 安装Docker

- 2.1.3 安装Kubernetes的安装组件

- 2.2 在Master节点上执行的操作

- 2.3 在Node节点上执行的操作

云主机 ECS:云计算的强大引擎

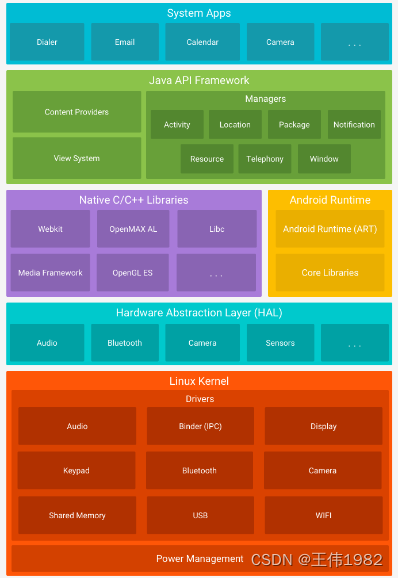

在日益数字化的世界中,企业和个人都正在寻找能够提供灵活、可革新的计算解决方案。云主机ECS(Elastic Compute Server)作为一种云计算服务,正好满足了这种需求。

什么是云主机ECS?

云主机ECS是一种提供高可靠和弹性扩展的计算服务。它允许用户按需获取云端服务器,根据业务需求选择不同规格的CPU、内存、操作系统、硬盘和网络。这种灵活性使得云主机ECS能够满足广泛的业务需求,从基本的网站托管到复杂的企业应用。

为何选择云主机ECS?

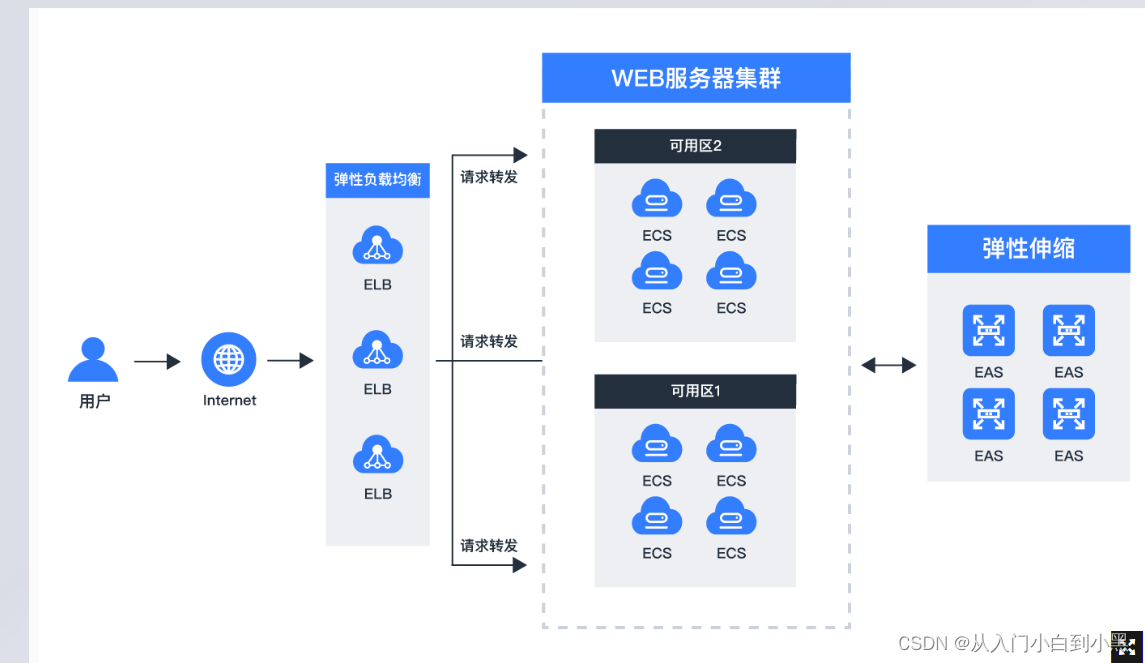

云主机ECS为用户提供了一种快速、灵活的方式来构建和扩展应用。从订购到使用,仅需数十秒时间,这使得用户能够立即开始工作,并根据需求灵活地增加或减少资源。

由于是在云端,云主机ECS可以提供高度的可靠性。数据不再局限于单一的物理服务器,而是分布在云的多个地方,这大大增加了数据的安全性和可用性。

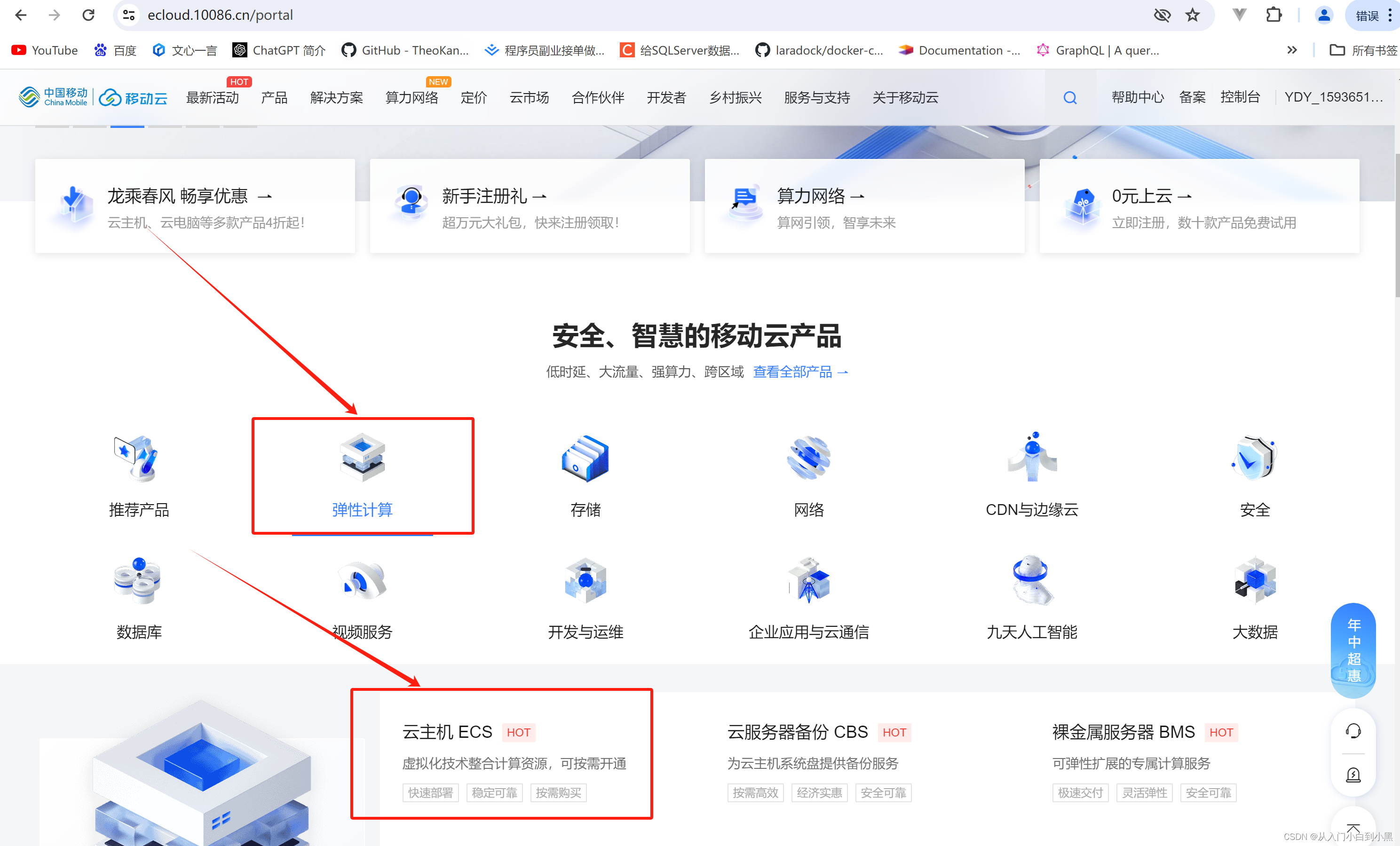

使用移动云ECS进行Kubernetes集群搭建

接下来将演示如何使用移动云ECS服务器搭建一个简单的Kubernetes集群环境。此处将使用两台ECS服务器,一台作为Master节点,一台作为Node节点。您也可以根据实际需要,后期按照步骤继续增加Node节点。

1. 环境准备

我们在移动云平台选择两台ECS服务器作为我们的Kubernetes集群环境。Master节点和Node节点的配置如下:

- Master节点:2核CPU、4GiB内存、Centos7.6 64位操作系统、带宽:1Mbps

- Node节点:2核CPU、4GiB内存、Centos7.6 64位操作系统,带宽:1Mbps

在移动云ECS安全组规则中,我们需要将公网所有端口都开放,以确保集群中的节点可以相互通信。

我们将使用以下版本的软件进行集群安装:

- Kubernetes (k8s): v1.15.0

- Docker: docker-ce-18.06.1.ce-3.el7

- Etcd: 3.3.10

- Dashboard: v1.10.1

- Flannel: v0.11.0-amd64

- CoreDns: 1.3.1

- Pause: 3.1

2. 安装步骤

以下是安装Kubernetes集群的详细步骤。在每一个节点上都需要进行以下的操作:

2.1 在每一个节点上执行的操作

2.1.1 系统准备

在Kubernetes集群中,为了保证其高效运行,我们需要在每个节点上关闭防火墙、SWAP分区以及Selinux,同时将系统中桥接的IPv4以及IPv6的流量串通。下面是具体的命令:

#关闭防火墙

systemctl stop firewalld

systemctl disable firewalld#暂时关闭SWAP分区

swapoff -a#永久禁用SWAP分区

swapoff -a && sed -i '/ swap / s/^\(.*\)$/#\1/g' /etc/fstab#禁用Selinux

setenforce 0 && sed -i 's/^SELINUX=.*/SELINUX=disabled/' /etc/selinux/config#将系统中桥接的IPv4以及IPv6的流量串通

cat >/etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system

2.1.2 安装Docker

我们使用镜像进行Docker的安装。首先下载镜像仓库描述文件,然后进行Docker的安装和配置。

#安装Docker

yum -y install docker-ce-18.06.1.ce-3.el7#启动Docker服务并设置开机自启动

systemctl enable docker && systemctl start docker#设置Docker参数,确保其与Kubernetes的参数一致

cat > /etc/docker/daemon.json <<EOF

{"exec-opts": ["native.cgroupdriver=systemd"],"log-driver": "json-file","log-opts": {"max-size": "100m"},"storage-driver": "overlay2","storage-opts": ["overlay2.override_kernel_check=true"]

}

EOFmkdir -p /etc/systemd/system/docker.service.d#重启Docker服务

systemctl daemon-reload

systemctl restart docker

2.1.3 安装Kubernetes的安装组件

在安装k8s之前,我们需要添加其yum源。

#增加Kubernetes yum源

vi /etc/yum.repos.d/kubernetes.repo# 输入如下内容

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enable=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg# 安装Kubeadm、Kubelet、Kubectl

yum install -y kubelet-1.15.0 kubeadm-1.15.0 kubectl-1.15.0# 开启kubelet服务

systemctl enable kubelet.service

2.2 在Master节点上执行的操作

# 初始化Master节点

kubeadm init \

--apiserver-advertise-address=此处为Master节点的公网IP\

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.15.0 \

--service-cidr=10.1.0.0/16 \

--pod-network-cidr=10.244.0.0/16

请注意,--apiserver-advertise-address 参数应输入Master节点的公网IP地址,--service-cidr 和 --pod-network-cidr 分别设定service和pod的网络CIDR。

在Master节点初始化完成后,会产生一个token,这个token在后期Node节点加入集群时会用到,因此请注意保存。

2.3 在Node节点上执行的操作

回到Node节点,使用master上生成的token执行join命令,将Node节点加入到Master节点形成的集群。

kubeadm join <master-ip>:6443 --token <token>

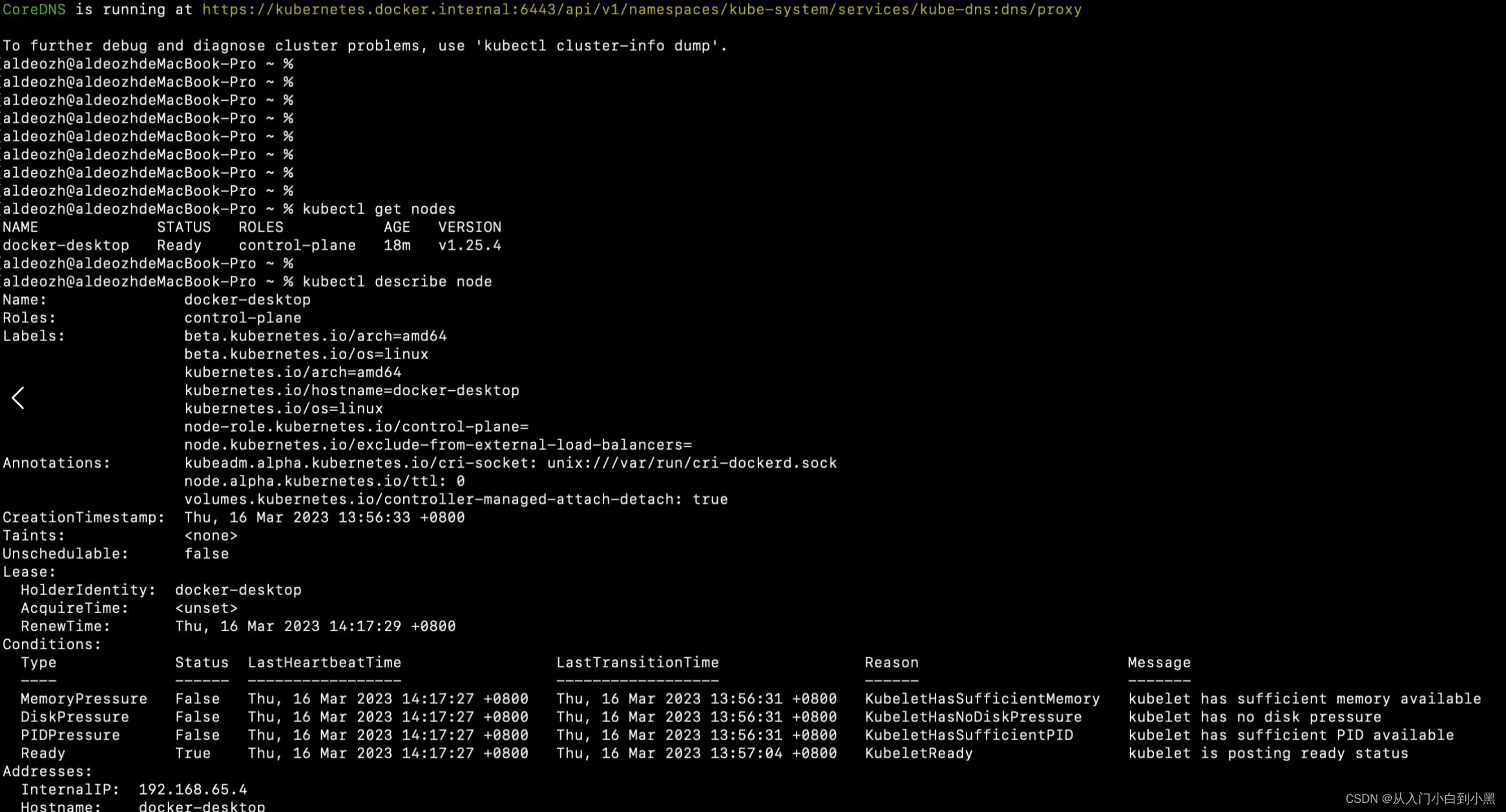

这样就完成了集群的搭建。我们可以通过以下命令查看节点状态:

kubectl get node

初始时,节点状态可能是NotReady,这是因为我们还需要部署网络插件。在Kubernetes集群中,其所有的节点的网络是扁平的,这需要我们的设置。对于网络插件,我们这里选择使用Flannel。

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

网络插件部署完成后,我们可以再次查看节点状态,此时应该已经变为Ready。

至此,我们就已经成功的使用移动云ECS服务器搭建了一个简单的Kubernetes集群环境。

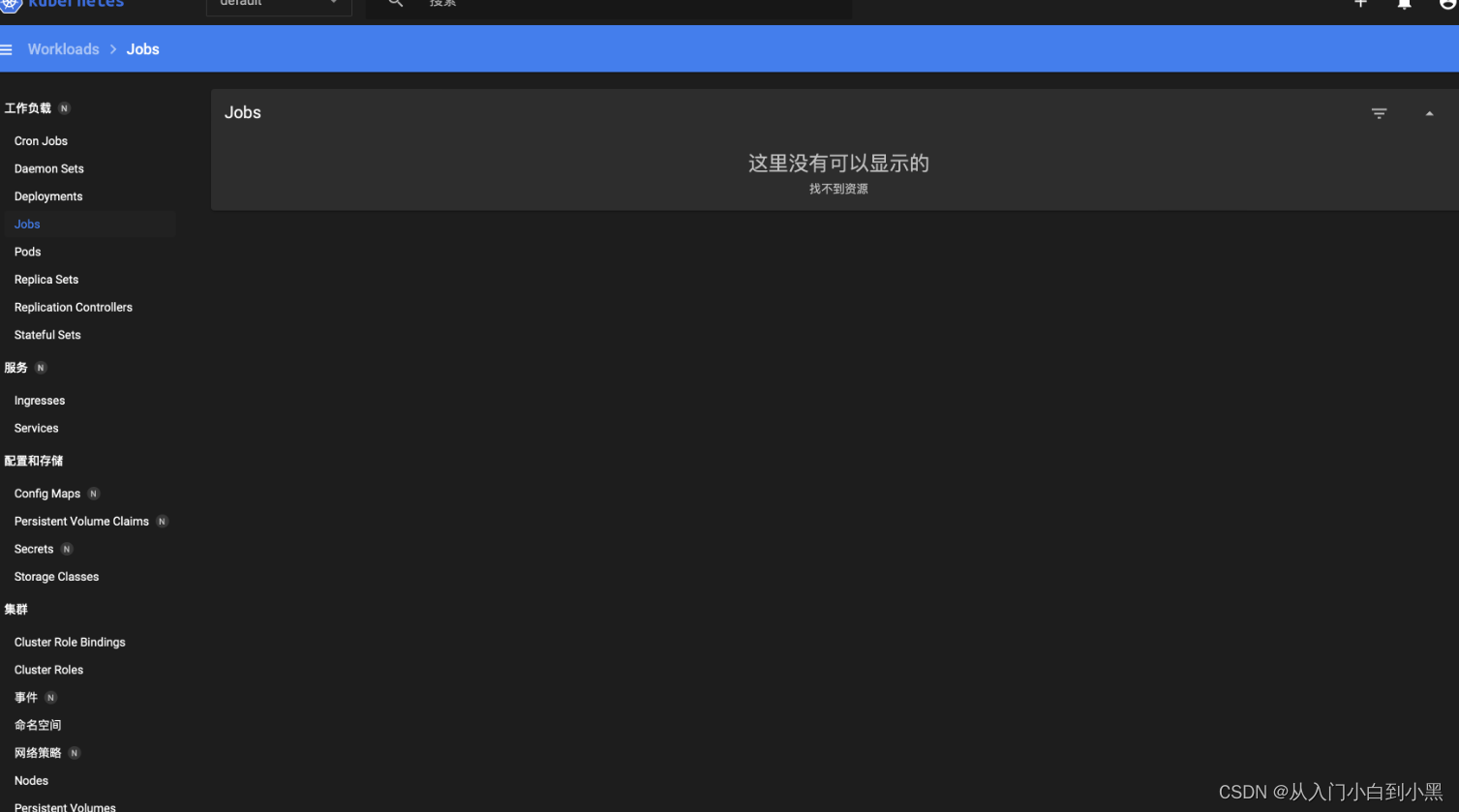

可以成功访问到控制台。