55. 右旋字符串(第八期模拟笔试)

先将整体反转,在将分割的两部分分别反转,实现旋转的效果。

#include <iostream>

#include <algorithm>using namespace std;int main(){string s;int n;cin>>n;cin>>s;reverse(s.begin(), s.end());reverse(s.begin(), s.begin() + n);reverse(s.begin() + n, s.end());cout<<s<<endl;return 0;

}

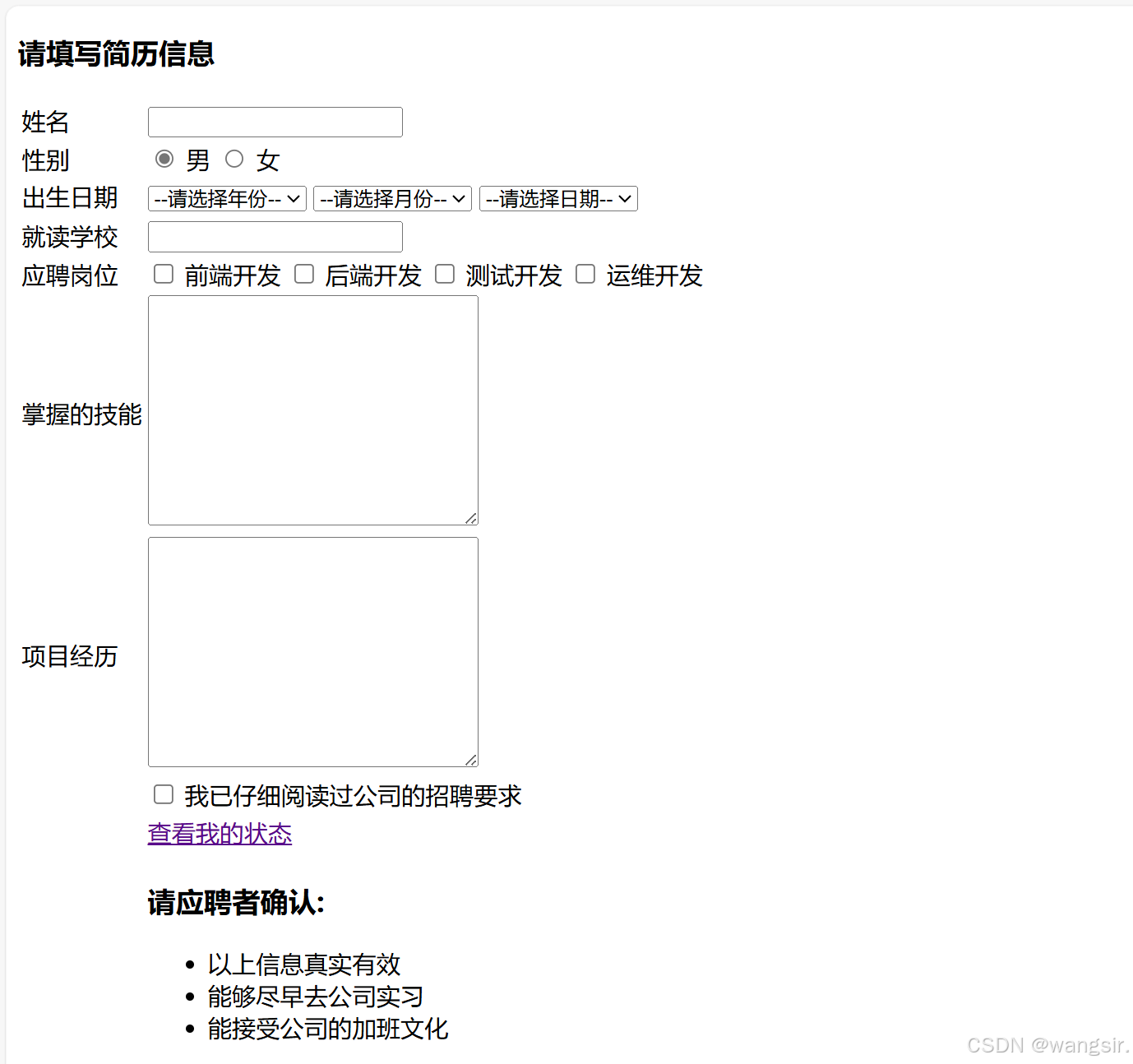

![[0242].第4-3章:SpringBoot2核心技术笔记](https://i-blog.csdnimg.cn/blog_migrate/555394c8116865fb1dfc18bf03fa9806.png)