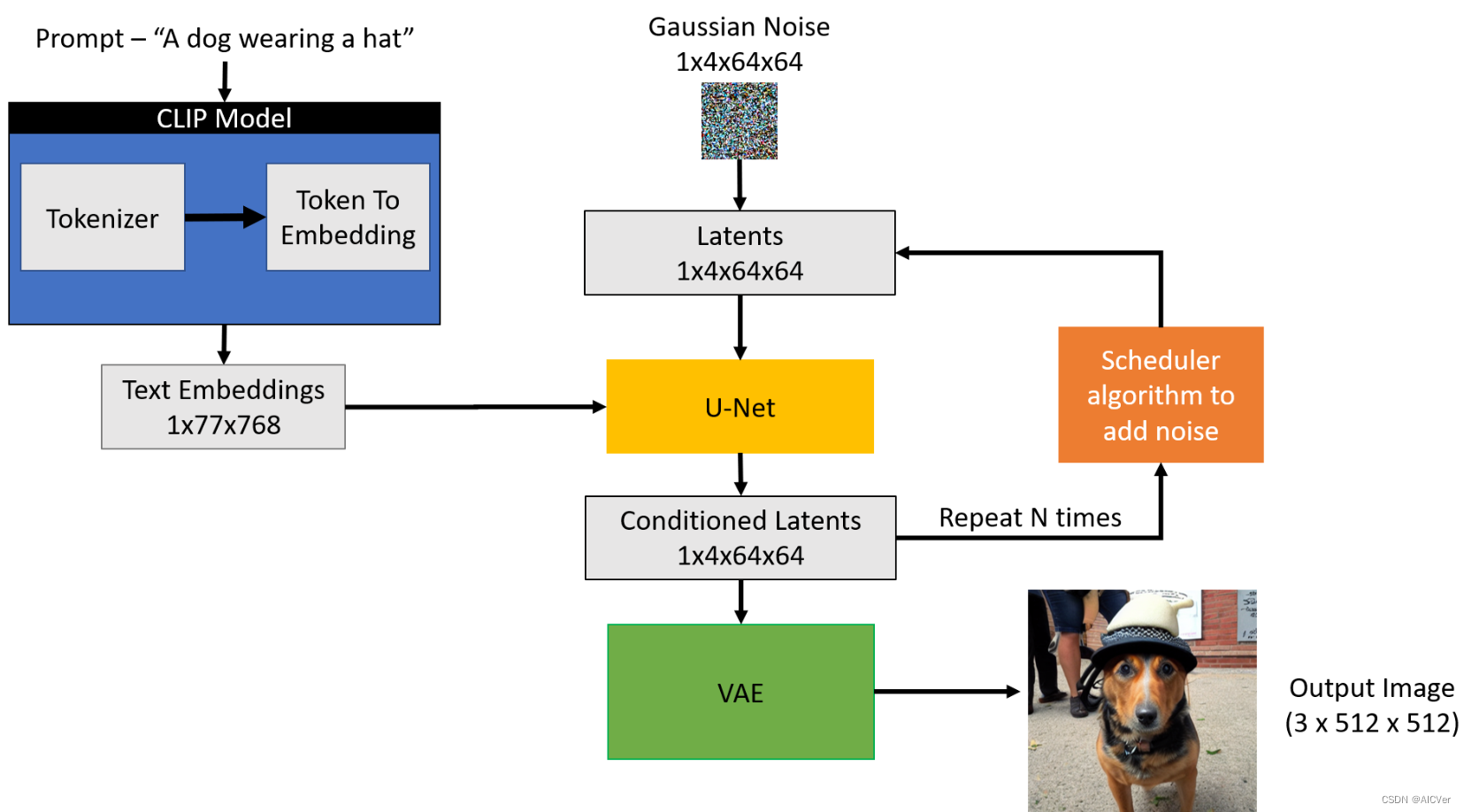

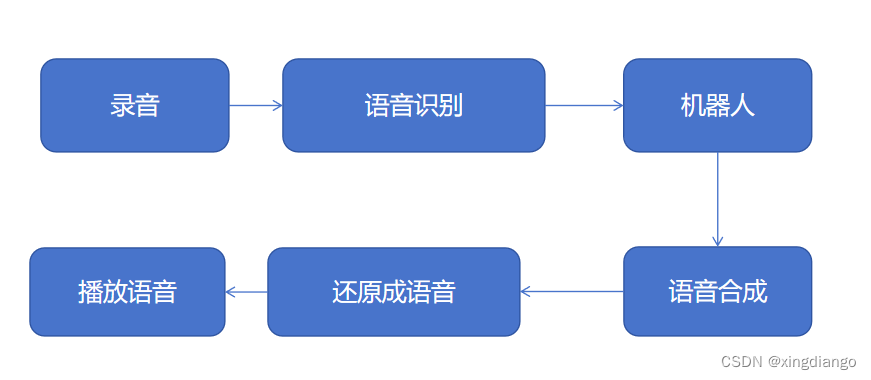

想要做一款能通过语音识别来聊天的智能机器人,首先需要能通过麦克风录制语音进行识别转换成文字,将文字发送给机器人得到聊天结果,并能将返回的文字转换成语音进行合成,之后再通过本地播放语音实现语音交互。

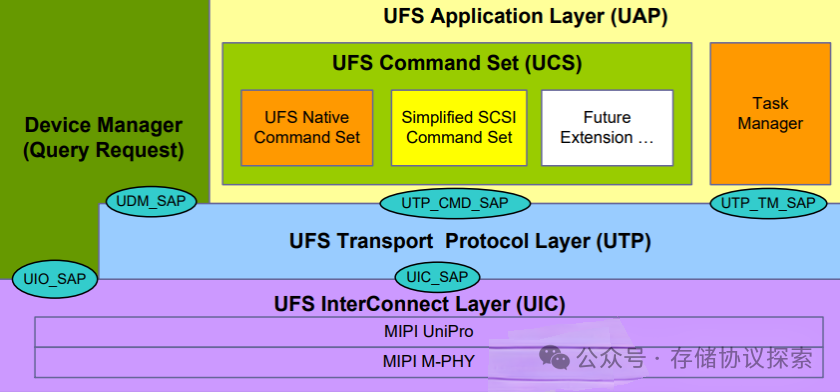

架构:

实现步骤

一、本地录音

本地录音可以通过pyAudio库实现语音录制。

音频采样率

音频采样率是指在一秒钟内对声音进行采样的次数。采样率越高,音频质量就越好。常见的音频采样率是44.1kHz和48kHz。

音频位深度

音频位深度是指存储每个采样的精度。位深度越高,音频质量就越好。常见的位深度是16位和24位。

音频通道数

音频通道数是指记录音频信号的通道数。单通道(单声道)音频只有一个通道,双通道(立体声)音频有两个通道,多通道音频有超过两个通道。

PyAudio API

PyAudio的API定义了一组函数和常量,可用于录制、播放和处理音频数据。以下是一些重要的函数和常量:

pyaudio.PyAudio()

这是一个构造函数,用于创建一个PyAudio实例。可以使用这个实例来访问其他PyAudio函数。

pyaudio.paInt16

这是一个常量,代表16位音频数据类型。您可以使用其他常量来指定不同的音频数据类型。

pyaudio.paFloat32

这是一个常量,代表32位浮点数音频数据类型。这种数据类型通常用于音频信号处理。

PyAudio.open()

这个函数用于打开音频流。它返回一个PyAudio的流对象。

stream.read()

这个函数用于从音频流中读取数据。

stream.write()

这个函数用于将数据写入音频流。

import requests

import pyaudio

import wavedef record_human_voice():chunk = 1024FORMAT = pyaudio.paInt16CHANNELS = 2RATE = 44100RECORD_SECONDS = 5WAVE_OUTPUT_FILENAME = "output.wav"p = pyaudio.PyAudio()stream = p.open(format=FORMAT,channels=CHANNELS,rate=RATE,input=True,frames_per_buffer=chunk)print("开始录音:")frames = []for i in range(0, int(RATE / chunk * RECORD_SECONDS)):data = stream.read(chunk)frames.append(data)print("录音结束。")stream.stop_stream()stream.close()p.terminate()wf = wave.open(WAVE_OUTPUT_FILENAME, 'wb')wf.setnchannels(CHANNELS)wf.setsampwidth(p.get_sample_size(FORMAT))wf.setframerate(RATE)wf.writeframes(b''.join(frames))wf.close()if __name__ == '__main__':record_human_voice()本地录音结束后,可以在本地项目目录下生成一个output.wav语音文件,可以通过本地播放器尝试打开播放,是否为本人录制视频。另外,需要注意,需要打开windows声音模块的麦克风录制开关,否则不能成功执行。

二、语音播放

可以使用wav