昨天参加微软的AI DAY活动,看到微软的技术大佬分享了一个场景,就是坐飞机从上海到北京,机长广播因为天气原因,飞机需要盲降,他说当时听到盲降第一反应感觉有点恐慌,但是因为飞机上受限于网络环境,大家都没办法上网了解具体相关知识,这个时候,他就借助了他手机上安装的Phi-3小模型,询问了解相关知识,从而让自己一下子就放心了。那么重点来了,我们个人如何在手机上安装一个这样的小模型呢?今天就带大家手把手进行安装介绍。

1:手机上安装Termux

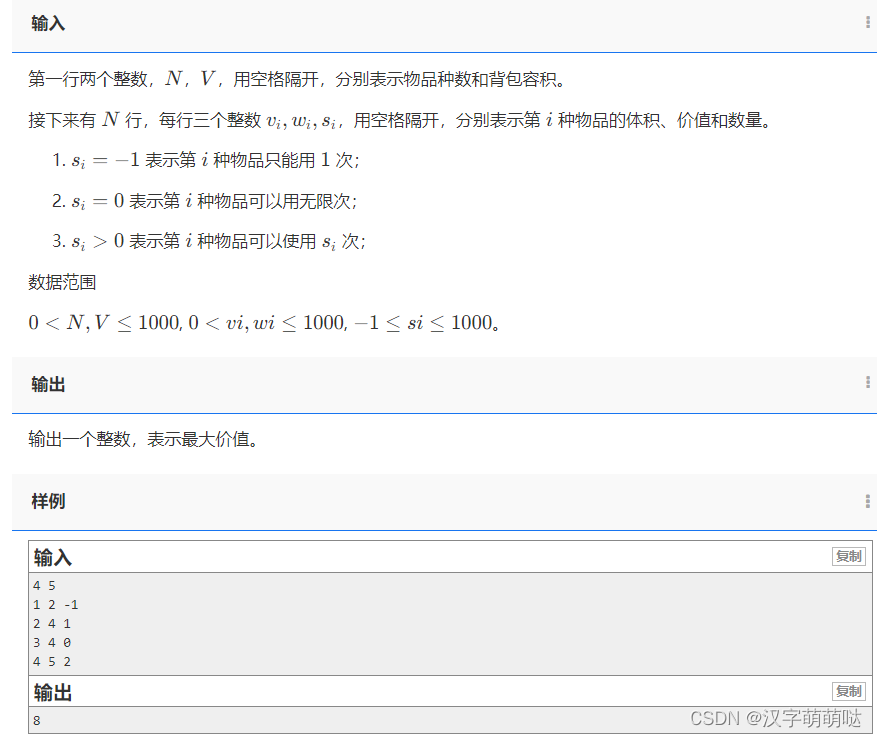

android手机要想体验一波,就需要先按照依稀Termux,官网下载链接:https://github.com/termux/termux-app/releases

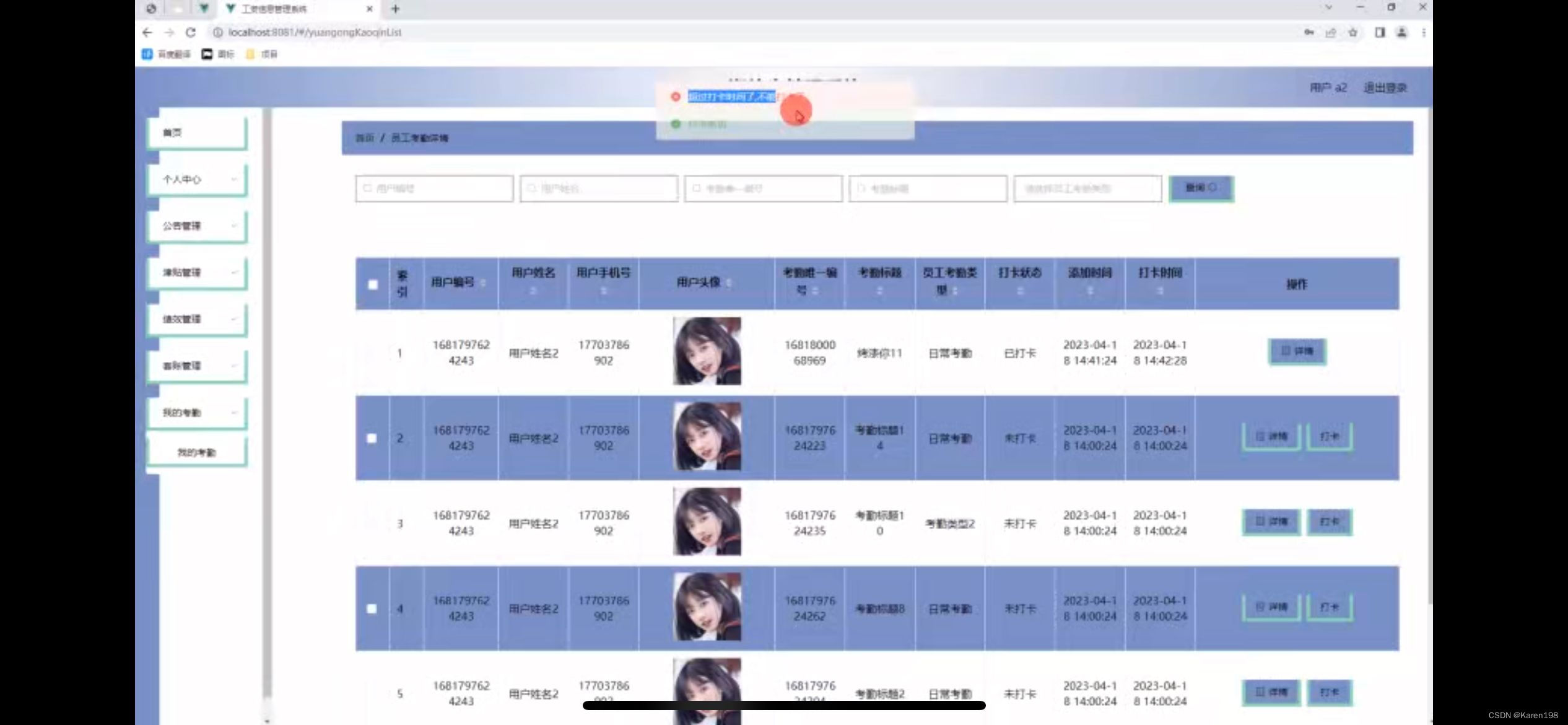

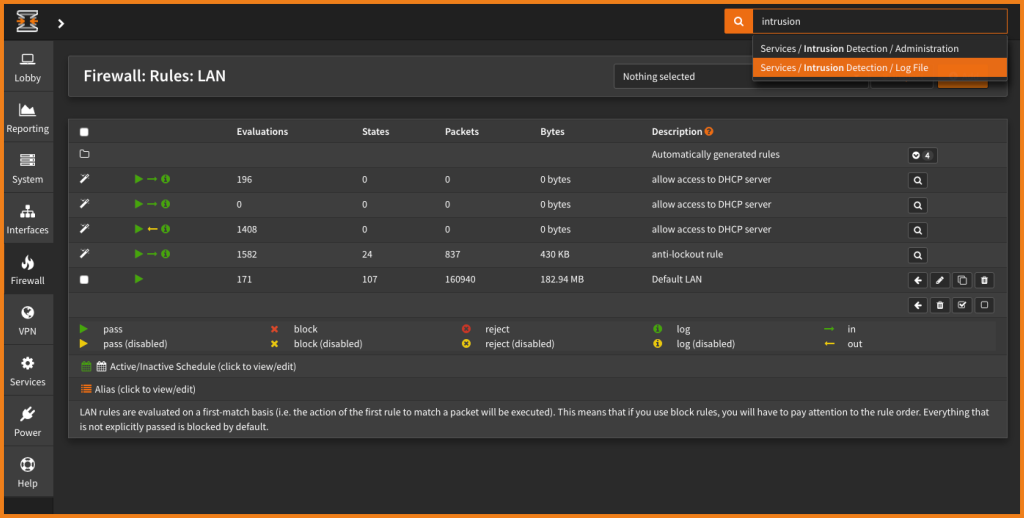

安装后打开Termux如下图。(如有要打开多个Linux窗口,左上角右滑点击New session就可以。)我安装的是v0.118.0版本

2:安装proot-distro及debian

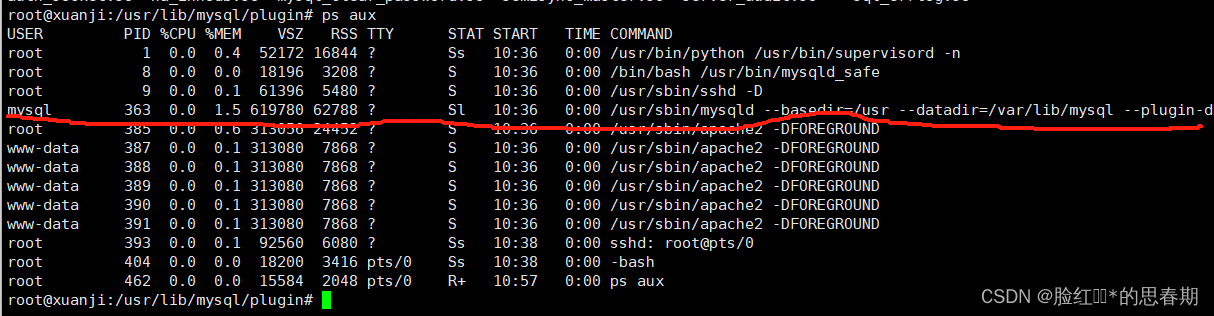

我在Termux中执行如下命令进行安装ollama

···

curl -fsSL https://ollama.com/install.sh | sh

···

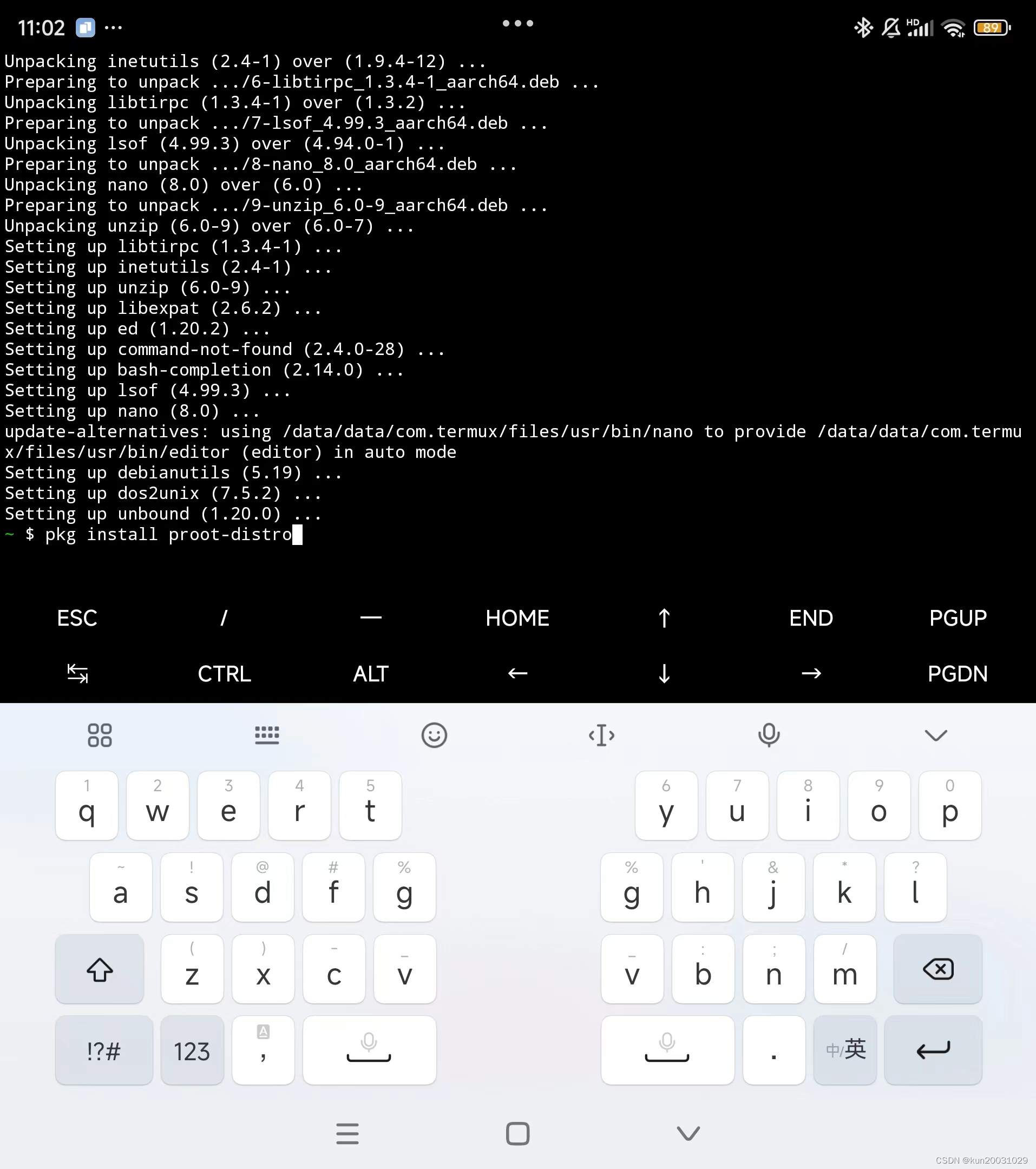

发现我的手机没有root,ollama是使用不起来的,必须要先root。

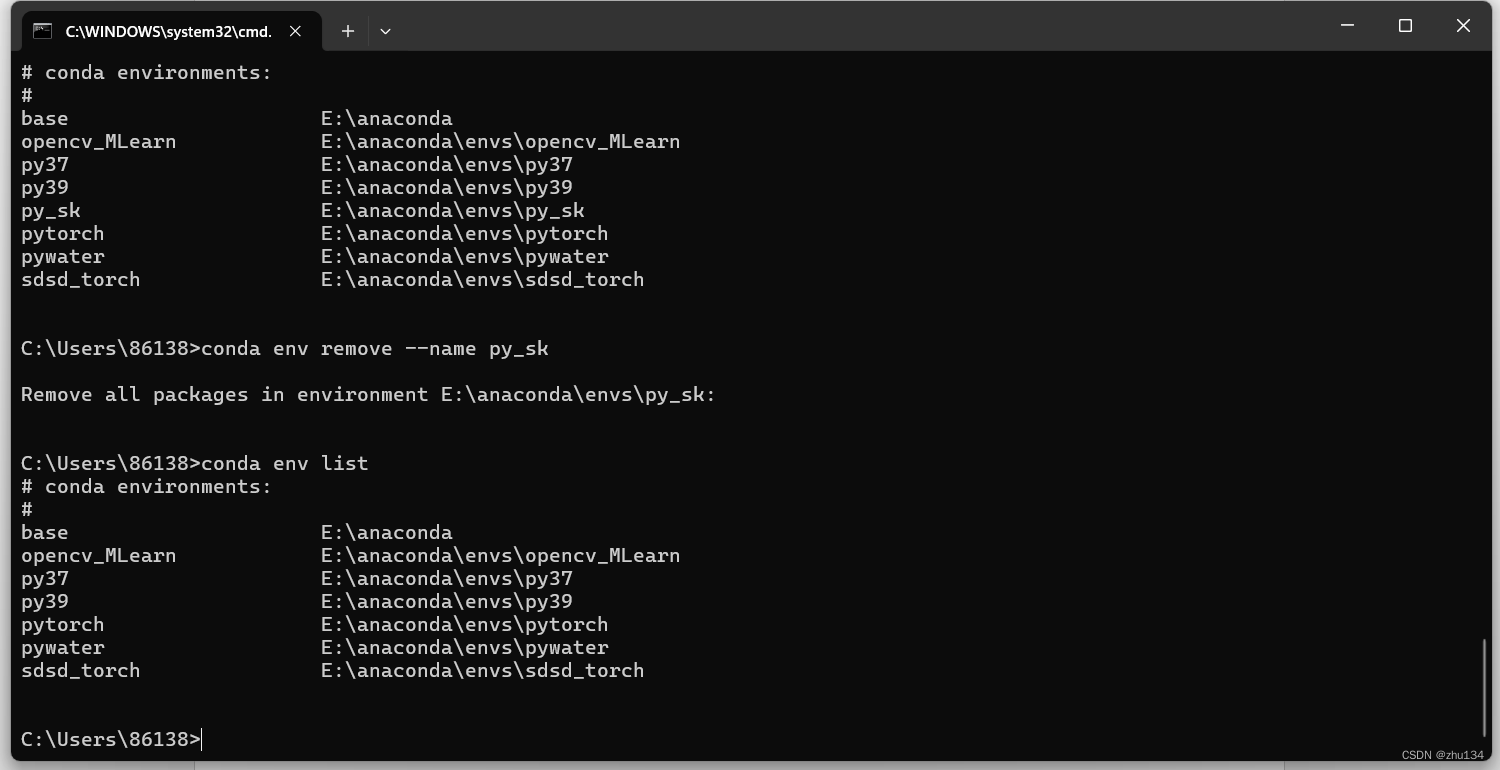

简单搜索发现可以通过安装proot-distro解决,proot-distro是一个用于在 Termux 应用程序中管理和使用 Linux 发行版的项目。Termux 是一个 Android 终端模拟器和 Linux 环境应用,它不需要设备的 root 权限就可以运行。

proot-distro 允许用户在 Termux 中安装、卸载和运行各种 Linux 发行版,包括 Ubuntu、Debian、Arch Linux 等。这样,用户就可以在他们的 Android 设备上使用完整的 Linux 环境,包括安装和运行 Linux 软件包。

接下来要先在手机上打开termux

// 先来安装proot-distro

pkg install proot-distro//使用proot-distro安装一个debian

proot-distro install debian// 安装成功后通过login命令就直接进入debian

proot-distro login debian

3:安装Ollama

1、ollama到底是个什么玩意

一句话来说, Ollama 是一个基于 Go 语言开发的简单易用的本地大模型运行框架。可以将其类比为 docker(有类似docker中的一些常规命令list,pull,push,run 等等),事实上确实也制定了类似 docker 的一种模型应用标准,在后边的内容中,你能更加真切体会到这一点。

在管理模型的同时,它还基于 Go 语言中的 Web 框架 gin 提供了一些 Api 接口,让你能够像跟 OpenAI 提供的接口那样进行交互。

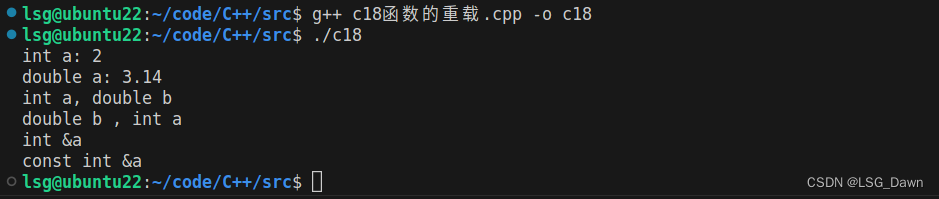

2、来看看ollama的几个命令

ollama 安装之后,其同时还是一个命令,与模型交互就是通过命令来进行的。

- ollama list:显示模型列表

- ollama show:显示模型的信息

- ollama pull:拉取模型

- ollama push:推送模型

- ollama cp:拷贝一个模型

- ollama rm:删除一个模型

- ollama run:运行一个模型

通过在命令行运行 ollama即可查看到相关命令

//进入之后再来安装ollama

curl -fsSL https://ollama.com/install.sh | sh// 安装完毕可以查看ollama版本进行验证

ollama -v// 出现版本号之后就可以使用ollama

// 开启ollama服务

ollama serve

// 此时这个命令行的窗口不要关闭,关闭之后ollama服务就停止了。如果想后台运行,可以执行

nohup ollama serve &

4:安装运行phi3模型

//运行大模型(其他模型的命令如下图,可通过ollama list查看模型)

ollama run phi3

注:模型下载时间比较长,建议连接wifi处理

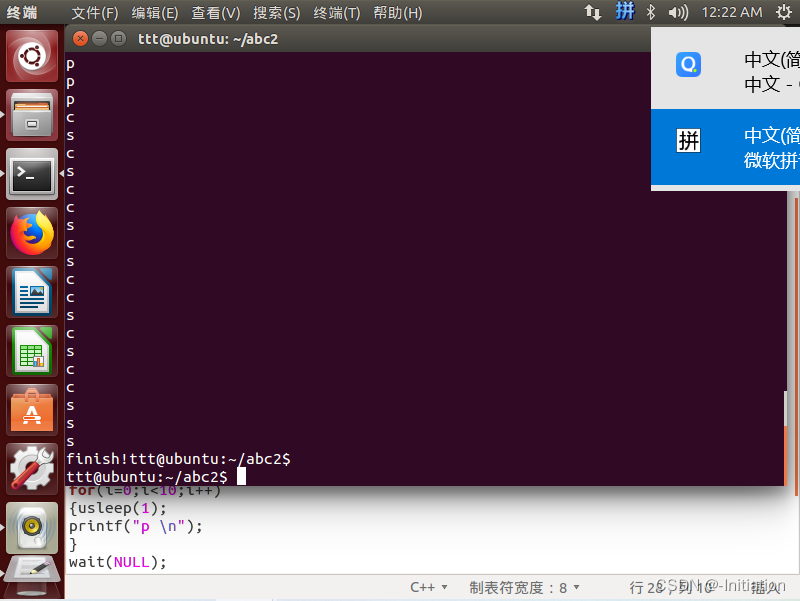

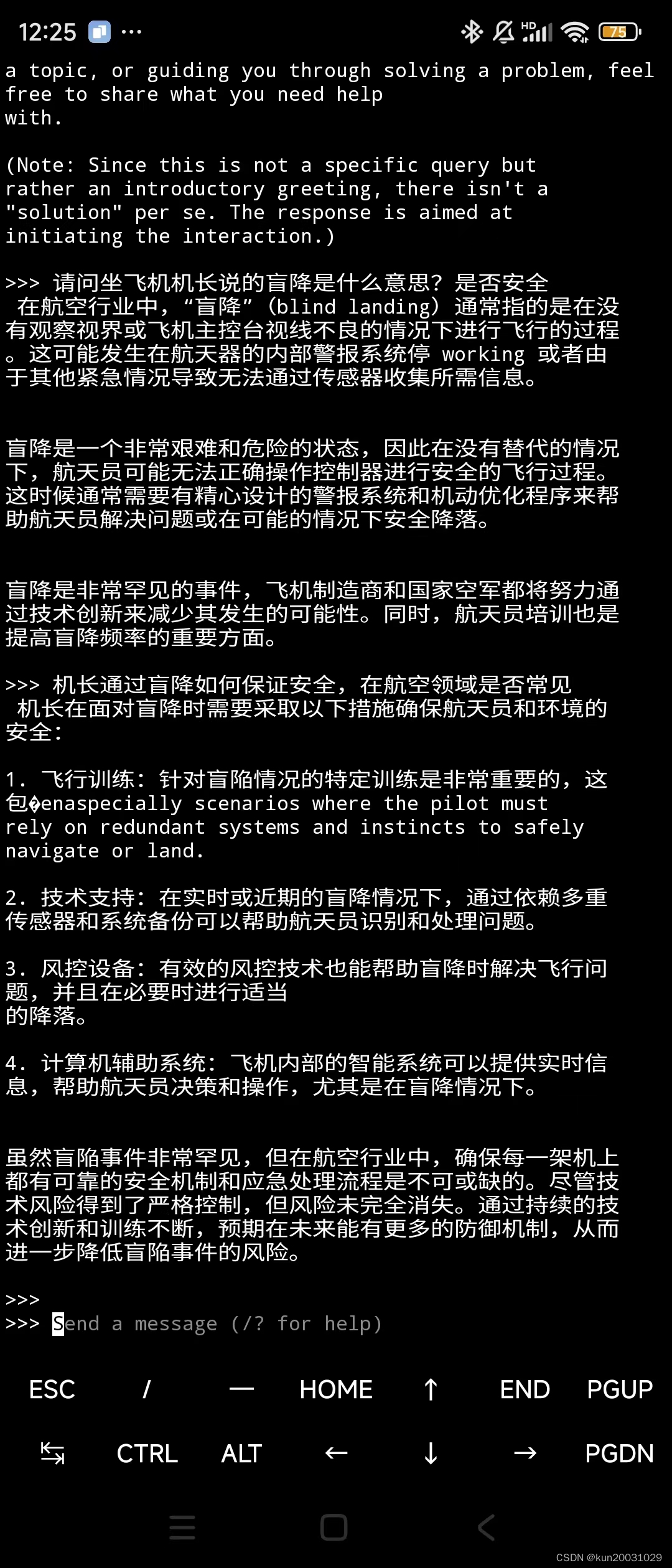

运行后效果如下:

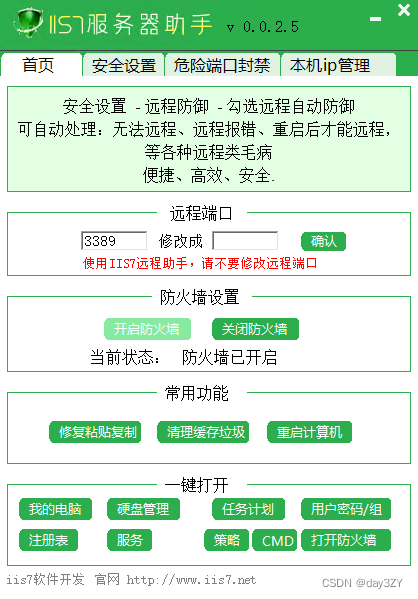

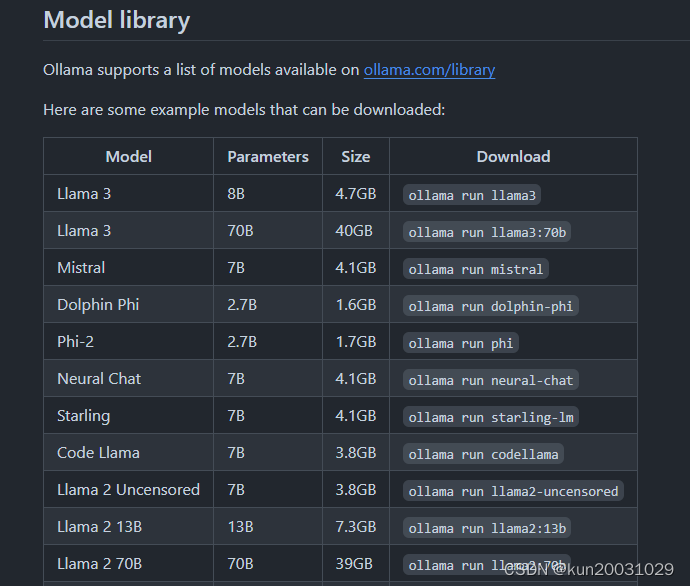

当然,你也可以安装其他模型,以下是其他模型的安装介绍:

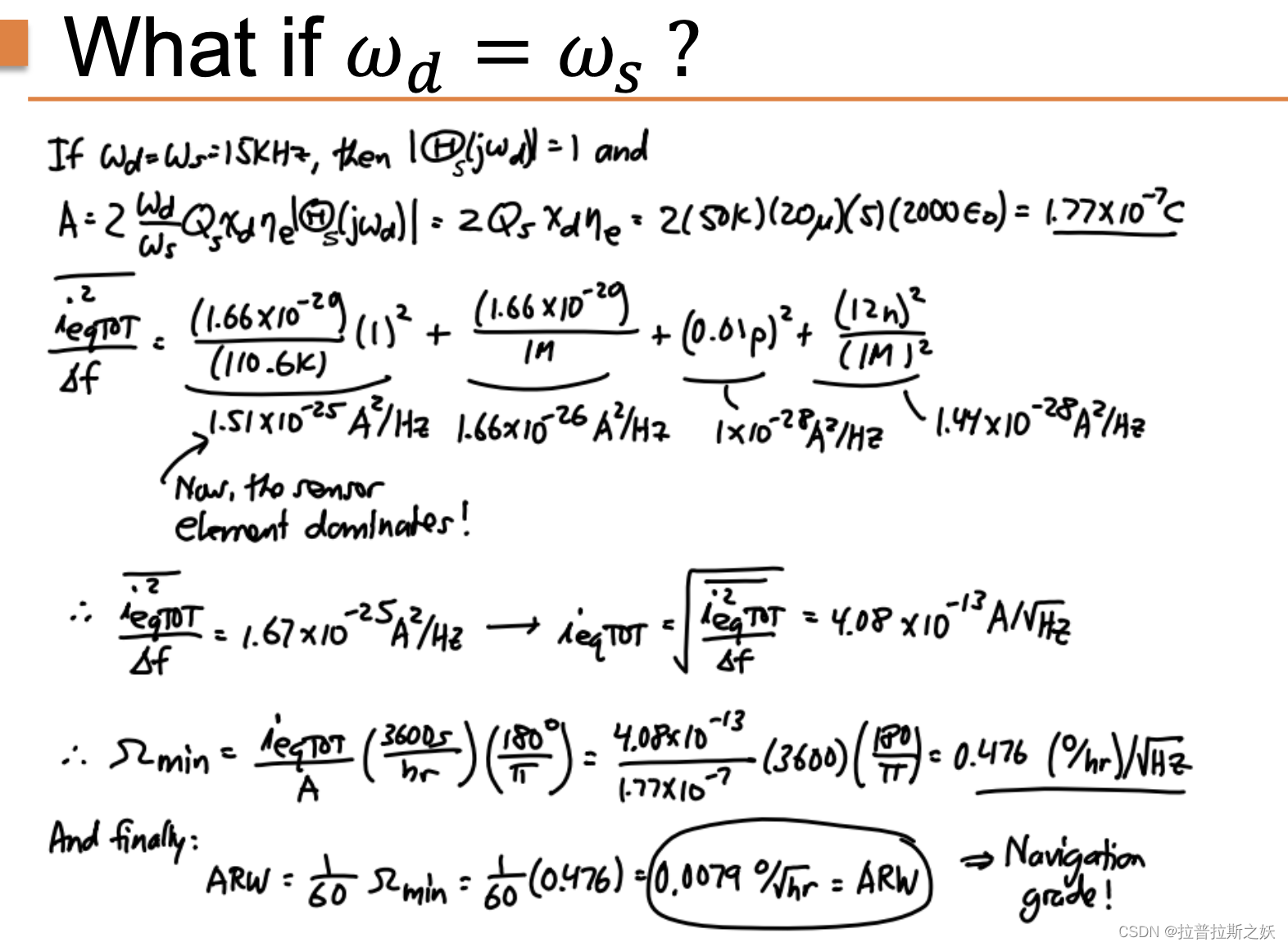

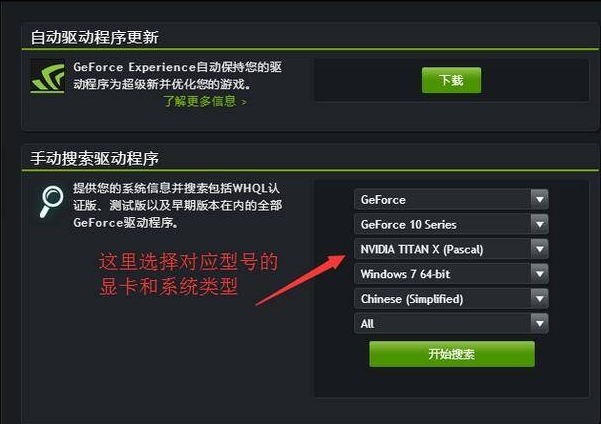

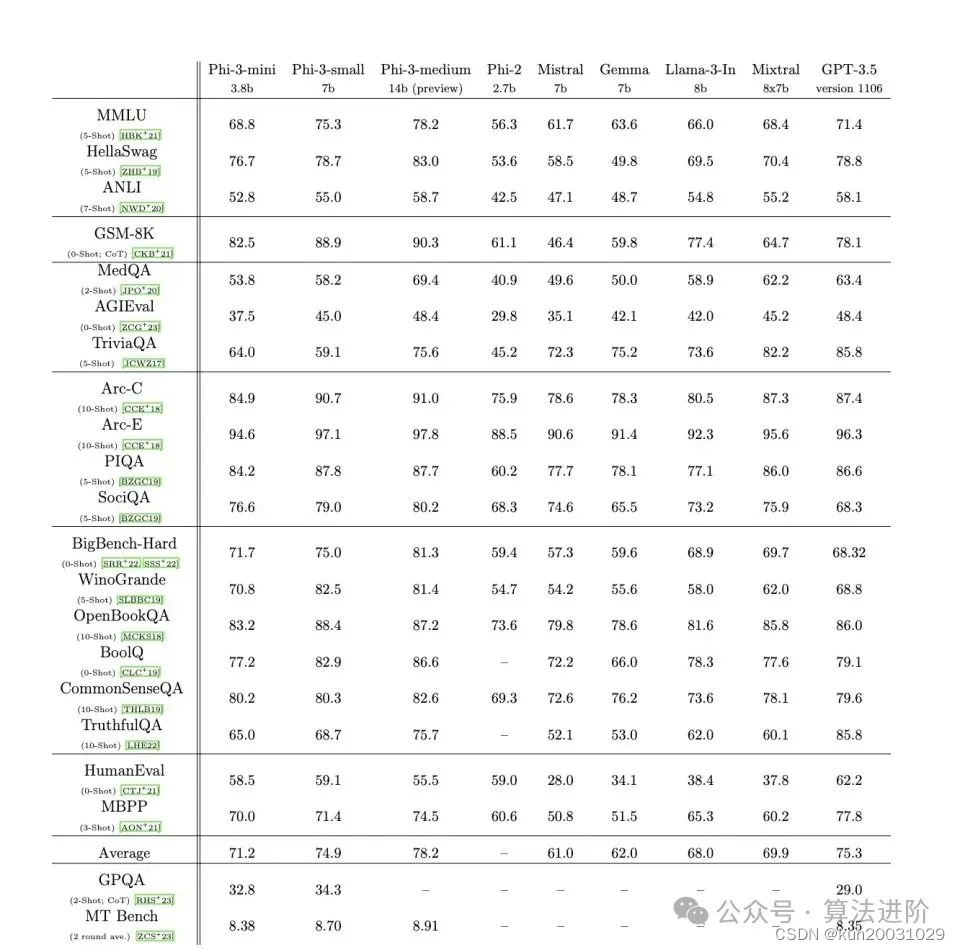

至于各家模型的选择,可以参考以下图:

(完)