简单浏览一下Sigir2024中与ranking相关的论文。不得不说,自从LLM大热后,传统的LTR方向的论文是越来越少了,目前不少都是RAG或类似场景下的工作了,比如查询改写、rerank等。

文章目录

- The Surprising Effectiveness of Rankers Trained on Expanded Queries

- Can Query Expansion Improve Generalization of Strong Cross-Encoder Rankers?

- Unbiased Learning to Rank Meets Reality: Lessons from Baidu’s Large-Scale Search Dataset

- Multi-granular Adversarial Attacks against Black-box Neural Ranking Models

The Surprising Effectiveness of Rankers Trained on Expanded Queries

对query进行改写和两个模型进行排序。大致流程:

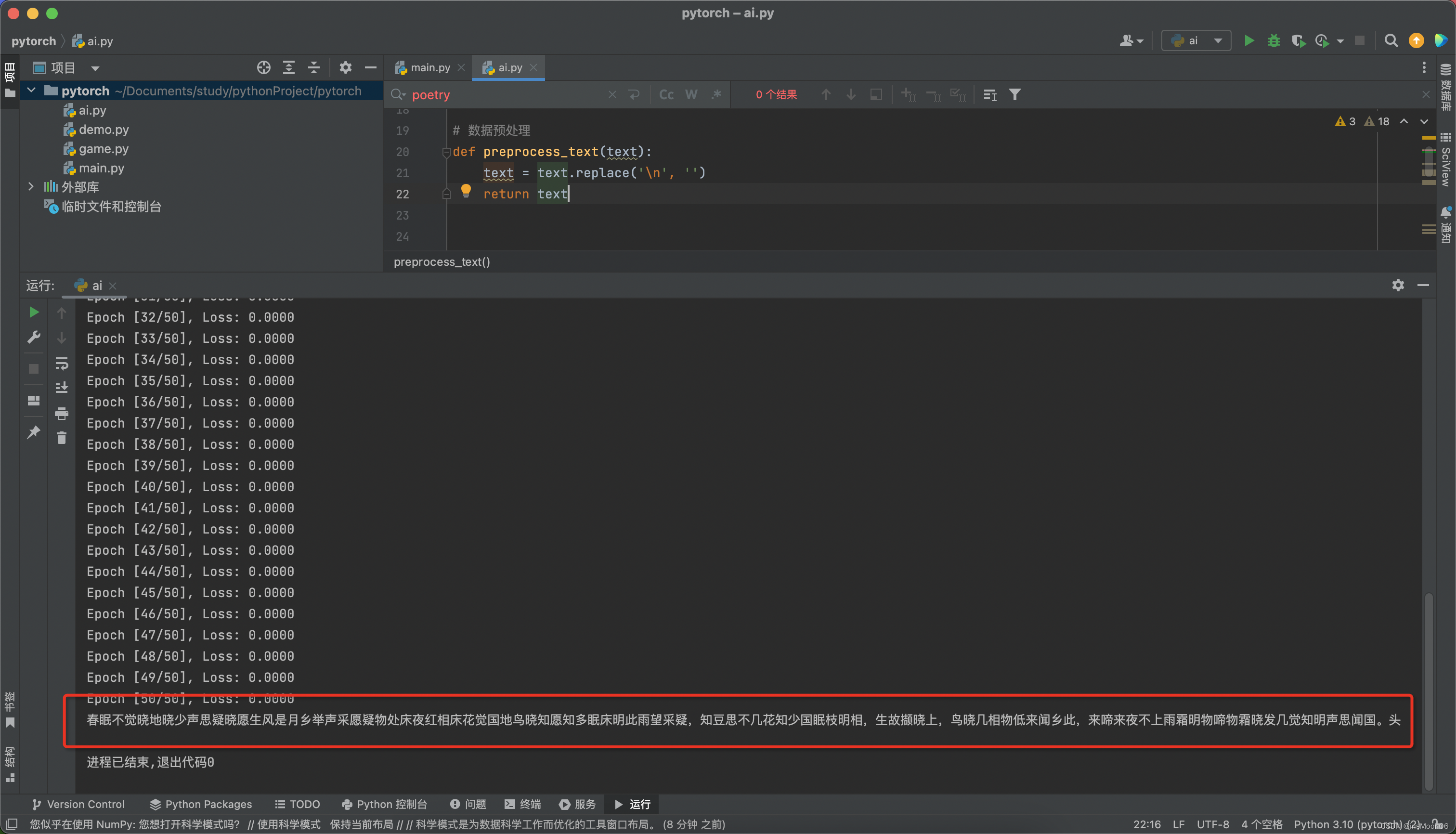

- 基于LLM和相关的文档对query进行改写,丰富长尾query的信息。

- 改写时需要筛选文档中与query相关的句子。

- 针对长尾query,在扩充后的query上训练一个专门的排序模型;

- 一共有两个排序模型,分别是针对简单query的Base Ranker和困难query的Specialized Ranker。以及一个判断query是否为困难query的模型。计算文档最终的得分时,先计算query为困难query的概率,再用两个排序模型计算得分并加权作为最终得分。

Can Query Expansion Improve Generalization of Strong Cross-Encoder Rankers?

query改写在检索阶段的作用很明显,其对交互式编码器的影响几何呢?已有的一些工作表明查询扩展对弱一些的排序模型效果更好,对强的则可能有害。如何应用查询扩展才能使其提升排序模型的能力呢,论文给出了两个关键的步骤:

-

高质量的关键词生成。排序更关注准确性(与检索不同),因此对查询扩展的精确性要求更高,避免扩展出现语义漂移的问题。文中的做法:通过LLM生成关键词,并通过self-consistency进行筛选(简言之:生成多次,取出现频率高的)。

- 这个确实很重要。排序阶段应该尽量保持原始查询的精确性,避免改写过于发散。

-

最小化查询扩展的破坏性。如何将生成的关键词插入到查询中,以最小化插入后的语义漂移。实验表明,即使直插入3个关键词在原始查询的末尾也会导致精度退化。文中的做法:每个关键词分别与原查询拼接后,各自进行排序,再进行融合。

Unbiased Learning to Rank Meets Reality: Lessons from Baidu’s Large-Scale Search Dataset

终于看到一篇传统的LTR论文,自从LLM大热,传统LTR论文是少之又少了啊。(虽然感觉这篇论文有点水)

这篇论文主要基于Baidu-ULTR数据集(由WSDM Cup 2023发布),通过实验分析了目前的主流ULTR方法能否真的提升ULTR效果。论文中主要考虑了位置偏差,直接看结论:

- 在该数据集上(后续同理),ULTR方法的提升甚微;

- 语言模型的训练对ULTR方法敏感;

- ULTR或许能提高点击,但可能与人工标注不一致。

Multi-granular Adversarial Attacks against Black-box Neural Ranking Models

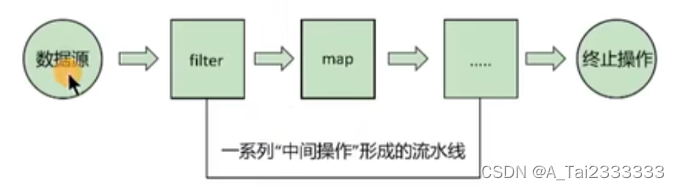

这篇论文主要提出了一种对文档添加不同粒度的扰动,来提高文本排序模型的鲁棒性。论文将添加不同粒度的扰动看作一个序列决策的问题,以强化学习的方式构建扰动直至最优的扰动,过程:

- 准备好一个代理排序模型,评估文档的相关性,一个LLM,评估文本的流畅度;

- 多粒度攻击者由两部分组成:sub-agent通过代理排序模型识别文档中脆弱的攻击位置和扰动粒度,meta-agent负责生成实际的扰动。

- 最终的目标:最大化扰动后文本的相关性以及流畅度。

文中比较关键的是基于强化学习的多粒度攻击者,主要是攻击位置的识别。这个论文有点意思,或许可以用到提升训练数据质量上。