文章目录

- 前言

- 免费版

- 直接修复代码

- 多文件上下文

- Agent模式

- 总结

前言

最近,GitHub 给开发者们带来了一个好消息:他们的 AI 编程助手 GitHub Copilot 现在可以免费使用了!以前,每个月要花 10 美元才能享受的服务,现在对所有人开放了免费版本。哇哇哇!!

之前试用了Cursor,但只有14天免费,当然也有无限续杯的方式。嫌麻烦的伙伴们,可以试一试这个GitHub Copilot

废话少说,直接试用一下:1. 打开Vscode,安装以下插件后,登录github的账号。就可以开启 GitHub Copilot 之旅了。

免费版

免费版支持 OpenAI 的 GPT-4o 和 Anthropic 的 Claude 3.5 Sonnet 模型,并提供每月 2000 次代码补全和 50 条聊天消息等核心功能,感觉不够用啊

直接修复代码

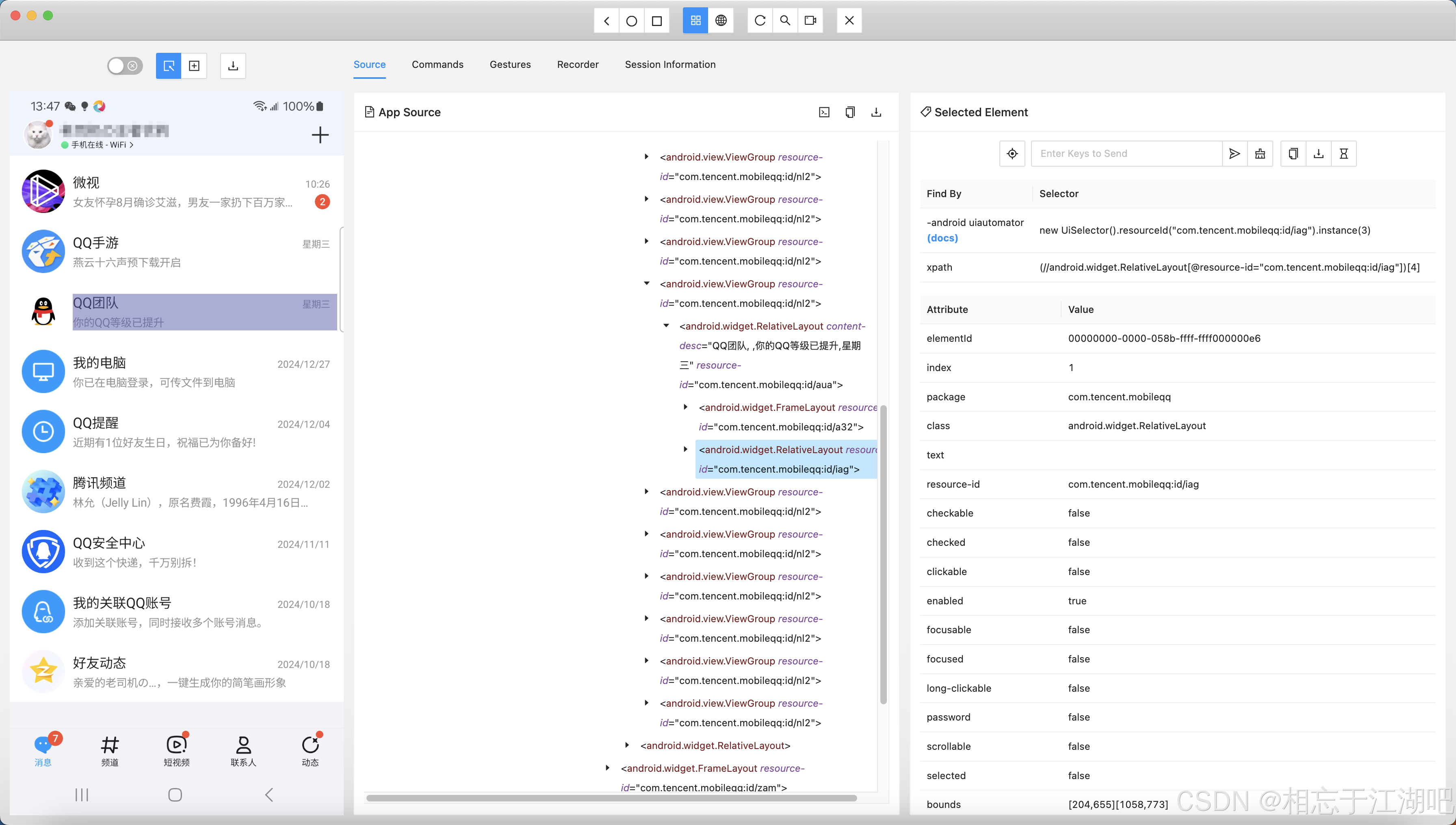

- 在报错或警告的代码,直接点击修复(Fix using Copilot)

修改后的代码,如下图,自己审核后,按需选择,因为生成的代码不是100%符合实际场景的,所以这个程度的AI,普通人还代替不了程序员,嘻嘻(#.#)

多文件上下文

- 添加多个文件,通过把对话聊天和代码生成结合起来,对多个文件进行更改。

使用了一番下来,体验还可以,但我发现好像没有Cursor的Agent模式。至于什么是 Agent模式?

Agent模式

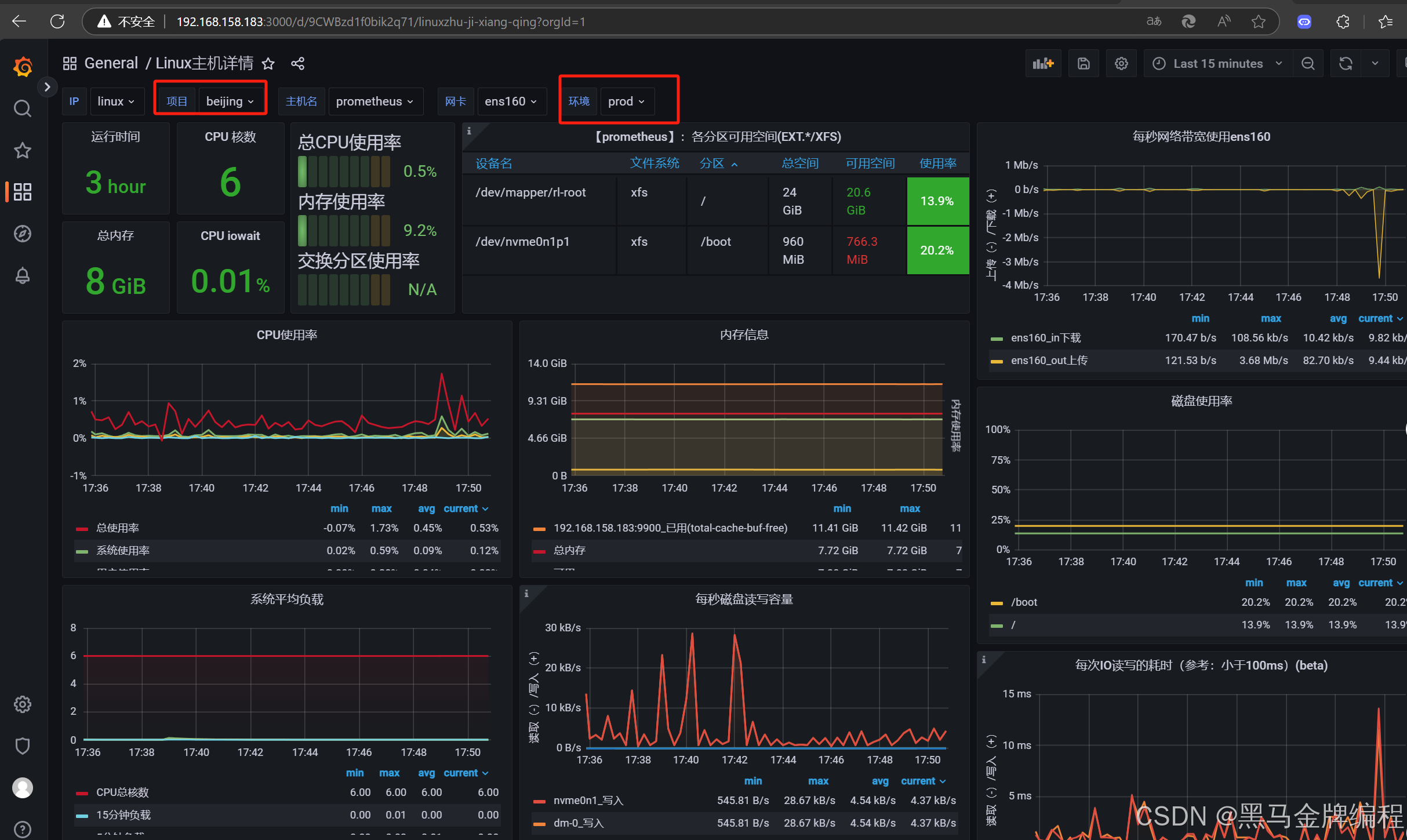

Agent 模式通过结合先进的 AI 模型(GPT-4o,Claude3.5 等)和自然语言处理技术(NLP),使开发者能够以自然语言指令的形式指导 AI 执行复杂的多步骤代码任务。它能够理解代码的全局结构和依赖关系,从而提供准确的代码生成和修改建议,实现高效且智能的代码操作和项目管理.

说的都是啥》?结合我使用Cursor的经验来理解,拿上次开发的五子棋来说,我告诉它的需求后,它会一步步分任务进行,遇到错误会自己修复,我只需等着最后审核代码。真是有点Agent-“代理,托管”的味道。

总结

好了,这里多聊一嘴,如今各种AI编程工具,AI程序员(Devin)层出,作为普通程序员,要怎么办?能怎么办。。深化专业技能,持续更新技术储备,积极拥抱 AI 技术/工具,提高工作效率,将精力投入到创新性工作。找到自己的位置!