🎩 欢迎来到技术探索的奇幻世界👨💻

📜 个人主页:@一伦明悦-CSDN博客

✍🏻 作者简介: C++软件开发、Python机器学习爱好者

🗣️ 互动与支持:💬评论 👍🏻点赞 📂收藏 👀关注+

如果文章有所帮助,欢迎留下您宝贵的评论,

点赞加收藏支持我,点击关注,一起进步!

引言

Lasso回归(Lasso Regression)和弹性网回归(Elastic Net Regression)是用于特征选择和正则化的线性回归方法。它们在处理高维数据和解决过拟合问题方面非常有效。以下是对它们的详细解释:

Lasso回归(Lasso Regression):

Lasso回归是一种使用 L1 正则化的线性回归方法。其损失函数由最小化残差平方和与系数绝对值之和的加权和组成。Lasso回归的数学表达式如下:

特点和作用:

- L1 正则化使得部分系数变为零,实现了特征选择,可以用于稀疏特征选择。

- 可以处理高维数据,并降低模型的复杂度。

- 适用于存在多重共线性问题的数据集。

弹性网回归(Elastic Net Regression):

弹性网回归是 Lasso 回归和 Ridge 回归的结合,同时使用 L1 和 L2 正则化项。其损失函数在 Lasso 回归和 Ridge 回归的基础上增加了一个混合比例参数。弹性网回归的数学表达式如下:

其中,𝛼α 是总的正则化参数,𝜌ρ 是 L1 正则化项在总正则化中的比例。

特点和作用:

- 组合了 L1 和 L2 正则化的优点,可以克服 Lasso 回归在高相关特征情况下的一些限制。

- 同时实现了特征选择和模型复杂度控制。

- 适用于处理高维数据、存在关联特征或存在较强共线性的数据集。

正文

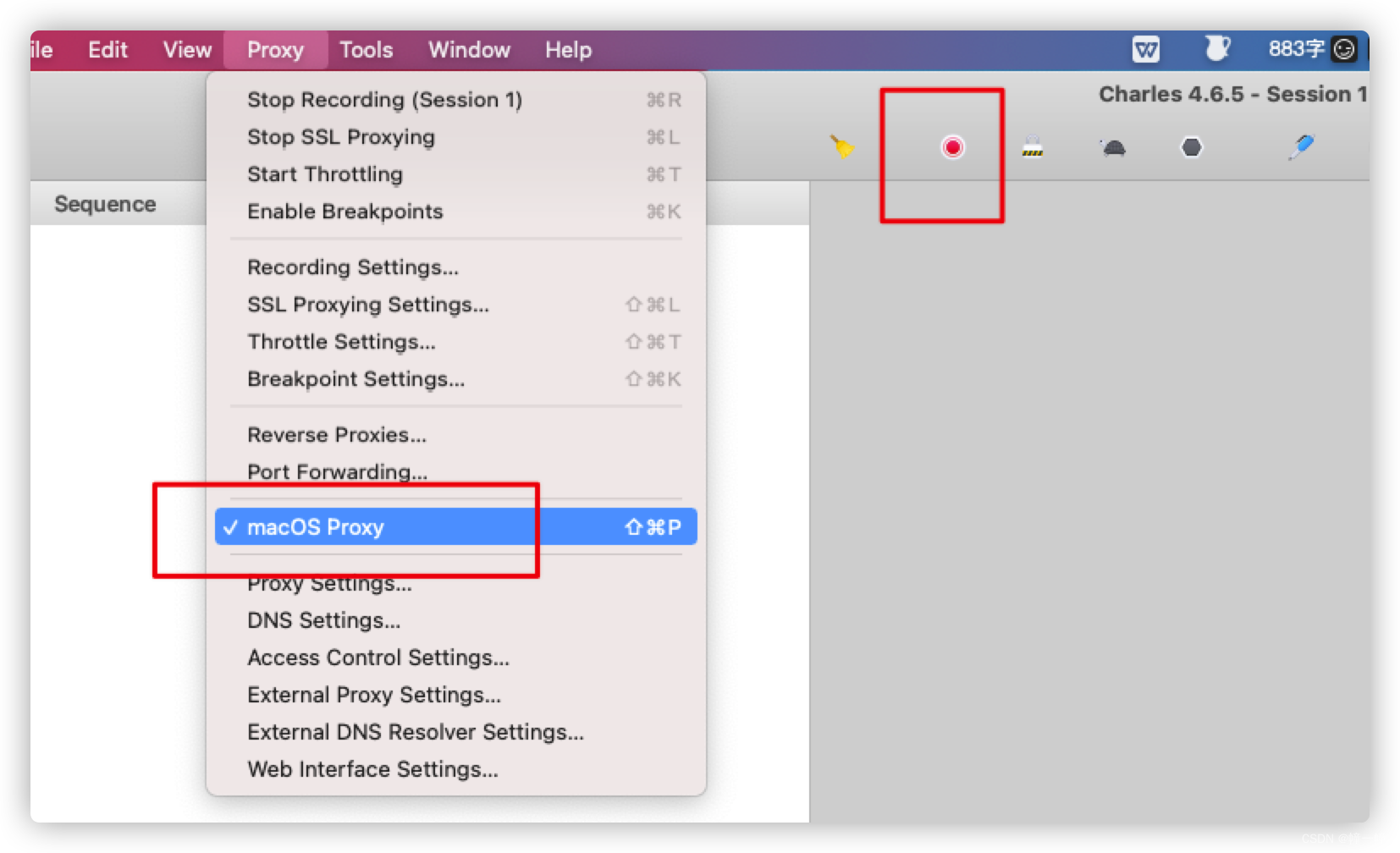

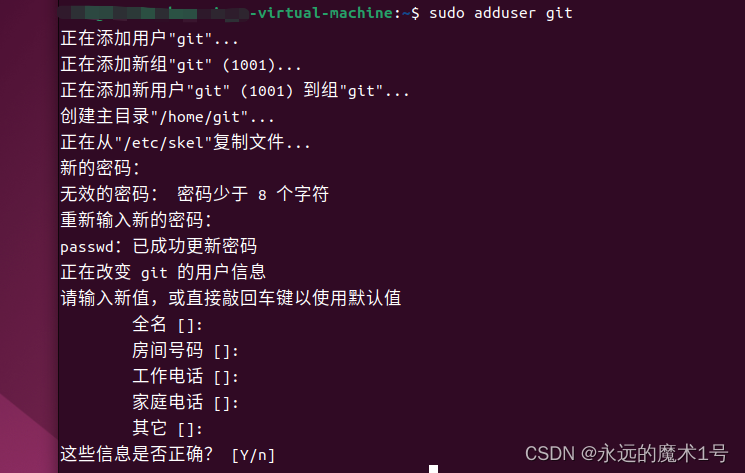

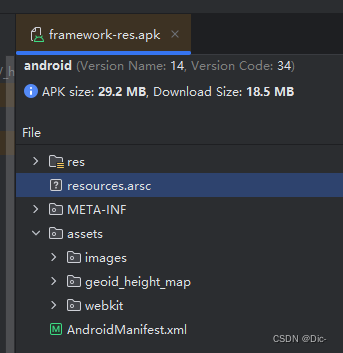

01-读取并展示邮政编码数据集中标签为 3 的部分样本的图像

这段代码实现了以下功能:

导入必要的模块:

- 导入 numpy 库,并重命名为 np。

- 导入 pandas 库,并重命名为 pd。

- 导入 matplotlib.pyplot 库,并重命名为 plt,同时从 pylab 中导入所有内容(包括 figure、subplot 等)。

- 导入 matplotlib.cm 库中的 cm 模块,用于颜色映射。

- 使用 warnings 库来过滤警告信息。

- 设置 matplotlib 图表显示中文。

- 导入 sklearn 中的支持向量机模型 svm。

- 导入 sklearn.linear_model 中的线性模型 LM。

- 导入 scipy.stats 库,并重命名为 st。

- 导入 scipy.optimize 库中的 root 和 fsolve 函数。

- 导入 sklearn.feature_selection 库中的各种特征选择方法。

- 导入 sklearn.linear_model 中的 Lasso、Ridge 和 ElasticNet 相关函数和类。

读取名为 ‘邮政编码数据.txt’ 的数据文件,使用空格作为分隔符,且没有列名(header=None)。

从数据中筛选出标签为 3 的样本,并分别将特征和目标变量提取出来,作为后续分析的数据源。

设定随机种子为 1,从目标变量 Y 中随机选择 25 个样本的索引。

创建一个 8x8 的图像,用于展示所选样本的图像。对于每个选定的样本:

- 将其特征数据转换成 16x16 的图像格式。

- 在子图中显示灰度图像。

将绘制的图像保存为文件’4.png’,分辨率设定为 dpi=500。

最后使用 plt.show() 显示生成的图像。

综上所述,这段代码的主要作用是读取并展示邮政编码数据集中标签为 3 的部分样本的图像,以及使用 matplotlib 和 numpy 进行图像处理和显示。

#本章需导入的模块

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from pylab import *

import matplotlib.cm as cm

import warnings

warnings.filterwarnings(action = 'ignore')

%matplotlib inline

plt.rcParams['font.sans-serif']=['SimHei'] #解决中文显示乱码问题

plt.rcParams['axes.unicode_minus']=False

from sklearn import svm

import sklearn.linear_model as LM

import scipy.stats as st

from scipy.optimize import root,fsolve

from sklearn.feature_selection import VarianceThreshold,SelectKBest,f_classif,chi2

from sklearn.feature_selection import RFE,RFECV,SelectFromModel

from sklearn.linear_model import Lasso,LassoCV,lasso_path,Ridge,RidgeCV

from sklearn.linear_model import enet_path,ElasticNetCV,ElasticNetdata=pd.read_table('邮政编码数据.txt',sep=' ',header=None)

tmp=data.loc[data[0]==3]

X=tmp.iloc[:,1:-1]

Y=tmp.iloc[:,0]

np.random.seed(1)

ids=np.random.choice(len(Y),25)

plt.figure(figsize=(8,8))

for i,item in enumerate(ids):img=np.array(X.iloc[item,]).reshape((16,16))plt.subplot(5,5,i+1)plt.imshow(img,cmap=cm.gray)

plt.savefig("../4.png", dpi=500)

plt.show()运行结果如下图所示:

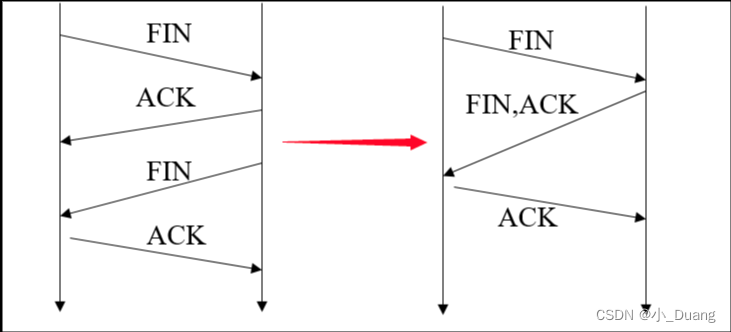

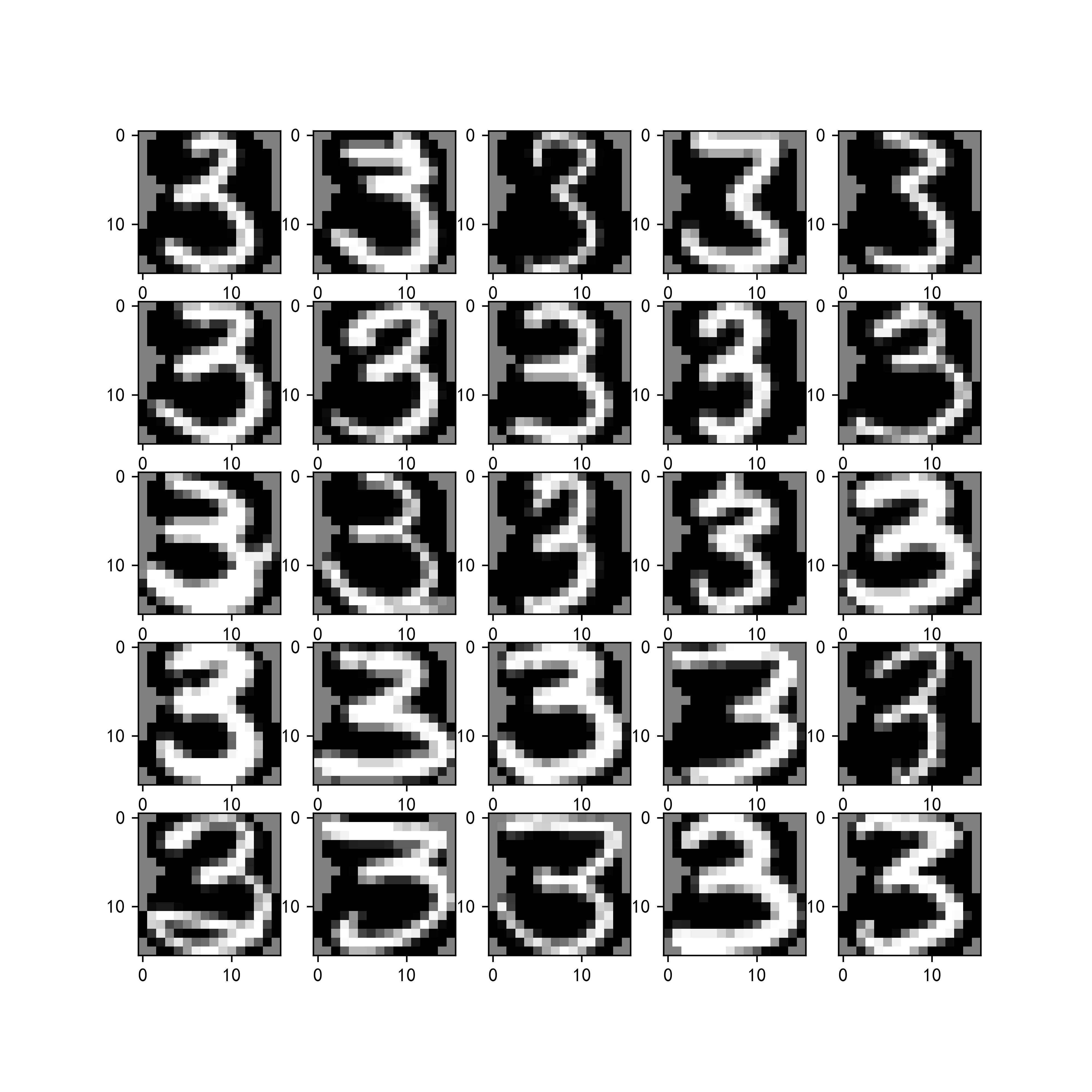

这段代码的作用如下所述:

特征选择器初始化和拟合:

selector=VarianceThreshold(threshold=0.05)初始化了一个方差阈值选择器,它用来删除方差低于指定阈值的特征。selector.fit(X)将该选择器应用于特征数据集 X,以识别并保留方差大于 0.05 的特征。输出剩余变量个数:

print("剩余变量个数:%d"%len(selector.get_support(True)))输出剩余的特征个数,即保留下来的特征数量。特征变换和逆变换:

X = selector.inverse_transform(selector.transform(X))使用选择器对 X 进行特征转换和逆转换操作。这一步骤可以理解为删除了方差较低的特征后,将 X 恢复为原始特征空间的数据格式。图像展示:

- 创建一个 8x8 的图像用于展示样本图像。

- 对于预先随机选择的每个样本

ids:

- 将其特征数据转换成 16x16 的图像格式。

- 在子图中显示灰度图像。

保存和显示图像:

plt.savefig("../4.png", dpi=500)将绘制的图像保存为文件’4.png’,设置分辨率为 dpi=500。plt.show()最后使用 matplotlib 显示生成的图像。综上所述,这段代码在进行方差阈值特征选择后,重新转换特征数据并展示了处理后的样本图像。通过这种方式,可以在保留数据关键特征的同时,有效地减少数据的维度和复杂性。

selector=VarianceThreshold(threshold=0.05)

selector.fit(X)

print("剩余变量个数:%d"%len(selector.get_support(True)))

X=selector.inverse_transform(selector.transform(X))

plt.figure(figsize=(8,8))

for i,item in enumerate(ids):img=np.array(X[item,]).reshape((16,16))plt.subplot(5,5,i+1)plt.imshow(img,cmap=cm.gray)

plt.savefig("../4.png", dpi=500)

plt.show()运行结果如下图所示:

02-利用不同的模型估计器进行特征选择,并展示处理后的样本图像,以便观察特征选择对图像的影响

这段代码的作用如下所述:

导入必要的模块:

- 代码从 numpy、pandas、matplotlib.pyplot 等库中导入所需的模块,用于数据处理和可视化。

- 也导入了机器学习相关模块,如 sklearn 中的 svm、linear_model 等,以及 scipy 中的统计模块和优化算法。

读取数据并筛选:

- 从名为 ‘邮政编码数据.txt’ 的数据文件中读取数据,使用空格分隔,无列名。

- 过滤出标签为 1 或 3 的样本数据,并提取特征 X 和目标变量 Y。

随机选择样本:

- 设定随机种子为 1,从目标变量 Y 中随机选择 25 个样本的索引。

特征选择:

- 对于每个模型估计器(LogisticRegression 和 SVC with linear kernel):

- 使用递归特征消除(RFE)选择器,设置要选择的特征数为 80。

- 对特征数据 X 和目标变量 Y 进行拟合和特征选择。

- 输出选取的变量重要性排名前5的信息。

- 对选择后的特征数据进行转换和逆转换。

- 创建一个 8x8 的图像用于展示处理后的样本图像。

- 对于预先随机选择的每个样本,将其特征数据转换成 16x16 的图像格式,并在子图中显示灰度图像。

显示图像:

- 在每个模型估计器上完成特征选择和图像展示后,使用

plt.show()分别显示这些图像。保存图像:

- 将最后一个模型估计器的图像保存为文件’4.png’,分辨率设定为 dpi=500。

综上所述,这段代码的主要作用是利用不同的模型估计器进行特征选择,并展示处理后的样本图像,以便观察特征选择对图像的影响。同时,通过保存图像文件,可以进一步对结果进行保存和分享。

#本章需导入的模块

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from pylab import *

import matplotlib.cm as cm

import warnings

warnings.filterwarnings(action = 'ignore')

%matplotlib inline

plt.rcParams['font.sans-serif']=['SimHei'] #解决中文显示乱码问题

plt.rcParams['axes.unicode_minus']=False

from sklearn import svm

import sklearn.linear_model as LM

import scipy.stats as st

from scipy.optimize import root,fsolve

from sklearn.feature_selection import VarianceThreshold,SelectKBest,f_classif,chi2

from sklearn.feature_selection import RFE,RFECV,SelectFromModel

from sklearn.linear_model import Lasso,LassoCV,lasso_path,Ridge,RidgeCV

from sklearn.linear_model import enet_path,ElasticNetCV,ElasticNetdata=pd.read_table('邮政编码数据.txt',sep=' ',header=None)

tmp=data.loc[(data[0]==1) | (data[0]==3)]

X=tmp.iloc[:,1:-1]

Y=tmp.iloc[:,0]

np.random.seed(1)

ids=np.random.choice(len(Y),25)

estimators=[LM.LogisticRegression(),svm.SVC(kernel='linear',random_state=1)]

for estimator in estimators:selector=RFE(estimator=estimator,n_features_to_select=80)selector.fit(X,Y)#print("N_features %s"%selector.n_features_)print("变量重要性排名 %s"%selector.ranking_[0:5])Xtmp=selector.inverse_transform(selector.transform(X))plt.figure(figsize=(8,8))for i,item in enumerate(ids):img=np.array(Xtmp[item,]).reshape((16,16))plt.subplot(5,5,i+1)plt.imshow(img,cmap=cm.gray)plt.show()

plt.savefig("../4.png", dpi=500) 运行结果如下图所示:

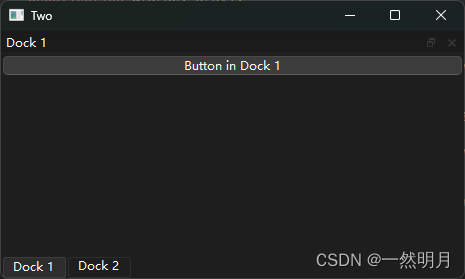

03-Lasso回归中的收缩参数alpha和训练误差

这段代码的作用如下所述:

导入必要的模块:

- 导入了 numpy、pandas、matplotlib.pyplot 等库,以及 sklearn 中的 svm、linear_model 等模块,用于数据处理、机器学习建模和可视化。

- 同样地,使用了 matplotlib.cm 进行颜色映射处理,以及 warnings 库来忽略警告信息。

读取数据并筛选:

- 从名为 ‘邮政编码数据.txt’ 的文本文件中读取数据,假设数据使用空格分隔且没有列名。

- 根据数据中第一列的值为 1 或 3 的条件,筛选出符合条件的数据作为分析的数据集。

Lasso 回归建模和分析:

- 使用 Lasso 回归模型对数据进行拟合和分析。

- 定义了一系列的 alpha 参数值,包括从 0 到 1 等间隔的20个值,并加入额外的 2 和 3。

- 初始化一个二维数组

coef来存储每个 alpha 值对应的回归系数。- 对每个 alpha 值,通过 Lasso 回归拟合数据,并计算回归系数和训练误差。

结果展示:

- 输出并打印了 alpha=0 时前五个变量的回归系数。

- 在图形化界面中,绘制了两个子图:

- 第一个子图展示了不同 alpha 值下每个变量的归一化回归系数变化情况,以及 alpha 参数与回归系数的关系。

- 第二个子图展示了不同 alpha 值下的训练误差变化情况。

保存图像:

- 最后将绘制好的图形保存为文件’4.png’,设定分辨率为 dpi=500。

综上所述,这段代码的主要目的是通过 Lasso 回归模型对数据进行分析和可视化,以研究不同收缩参数(alpha)对回归系数和模型训练误差的影响。保存的图像文件可以进一步用于结果展示和分享。

#本章需导入的模块

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from pylab import *

import matplotlib.cm as cm

import warnings

warnings.filterwarnings(action = 'ignore')

%matplotlib inline

plt.rcParams['font.sans-serif']=['SimHei'] #解决中文显示乱码问题

plt.rcParams['axes.unicode_minus']=False

from sklearn import svm

import sklearn.linear_model as LM

import scipy.stats as st

from scipy.optimize import root,fsolve

from sklearn.feature_selection import VarianceThreshold,SelectKBest,f_classif,chi2

from sklearn.feature_selection import RFE,RFECV,SelectFromModel

from sklearn.linear_model import Lasso,LassoCV,lasso_path,Ridge,RidgeCV

from sklearn.linear_model import enet_path,ElasticNetCV,ElasticNetdata=pd.read_table('邮政编码数据.txt',sep=' ',header=None)

tmp=data.loc[(data[0]==1) | (data[0]==3)]

X=tmp.iloc[:,1:-1]

Y=tmp.iloc[:,0]

fig,axes=plt.subplots(nrows=1,ncols=2,figsize=(12,5))

alphas=list(np.linspace(0,1,20))

alphas.extend([2,3])

coef=np.zeros((len(alphas),X.shape[1]))

err=[]

for i,alpha in enumerate(alphas):modelLasso = Lasso(alpha=alpha)modelLasso.fit(X,Y)if i==0:coef[i]=modelLasso.coef_else:coef[i]=(modelLasso.coef_/coef[0])err.append(1-modelLasso.score(X,Y))

print('前5个变量的回归系数(alpha=0):%s'%coef[0,][0:5])

for i in np.arange(0,X.shape[1]):axes[0].plot(coef[1:-1,i])

axes[0].set_title("Lasso回归中的收缩参数alpha和回归系数")

axes[0].set_xlabel("收缩参数alpha变化")

axes[0].set_xticks(np.arange(len(alphas)))

axes[0].set_ylabel("Beta(alpha)/Beta(alpha=0)")axes[1].plot(err)

axes[1].set_title("Lasso回归中的收缩参数alpha和训练误差")

axes[1].set_xlabel("收缩参数alpha变化")

axes[1].set_xticks(np.arange(len(alphas)))

axes[1].set_ylabel("错判率")

plt.savefig("../4.png", dpi=500)

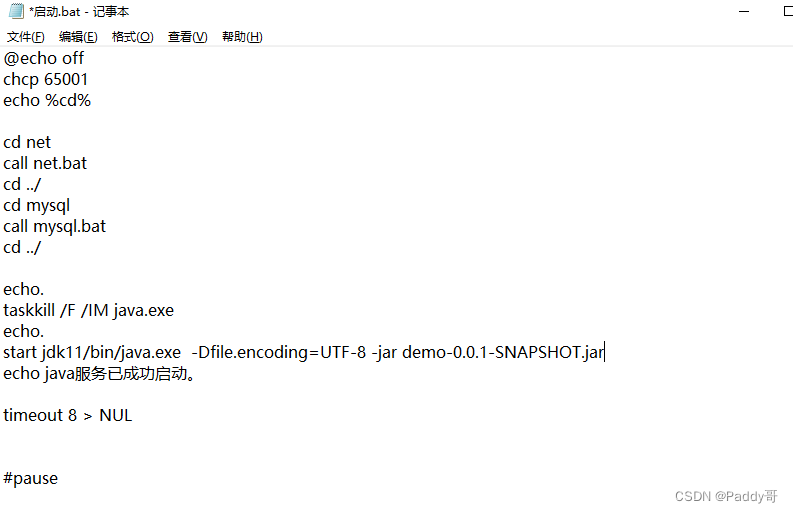

04-Lasso回归和弹性网回归

这段代码的作用如下所述:

导入必要的模块:

- 导入了 numpy、pandas、matplotlib.pyplot 等库,以及一些从 sklearn 中导入的模块,如 svm、linear_model 等,用于数据处理、机器学习建模和可视化。

- 使用了 matplotlib.cm 进行颜色映射处理,以及 warnings 库来忽略警告信息。

读取数据并筛选:

- 从名为 ‘邮政编码数据.txt’ 的文本文件中读取数据,假设数据使用空格分隔且没有列名。

- 根据数据中第一列的值为 1 或 3 的条件,筛选出符合条件的数据作为分析的数据集。

弹性网(Elastic Net)回归建模和分析:

- 对两种不同的 L1 范数比率 (l1_ratio) 进行弹性网回归建模(一种正则化方法,同时结合 L1 和 L2 范数)。

- 初始化了一个包含两个子图的图形界面

fig, axes,每个子图对应一个 l1_ratio 值。- 对每个 l1_ratio 值,通过

enet_path方法获取不同 alpha 值下的弹性网回归系数路径,并在子图中绘制出来。- 使用

ElasticNetCV方法自动选择最优的 alpha 值,并在图形标题中展示该值和训练误差。结果展示:

- 在每个子图中,设置合适的 x 和 y 轴标签、标题,并调整坐标轴以确保图形显示完整和清晰。

- 在第二个子图中,通过

axes[1].text方法添加了关于最优 alpha 值和训练误差的文本说明。保存图像:

- 最后将绘制好的图形保存为文件 ‘4.png’,设定分辨率为 dpi=500。

综上所述,这段代码的主要目的是使用弹性网回归方法对数据进行分析和可视化,探讨不同的 L1 范数比率下的回归结果,同时自动选择最优的 alpha 值,并保存图像用于结果展示和分享。

#本章需导入的模块

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from pylab import *

import matplotlib.cm as cm

import warnings

warnings.filterwarnings(action = 'ignore')

%matplotlib inline

plt.rcParams['font.sans-serif']=['SimHei'] #解决中文显示乱码问题

plt.rcParams['axes.unicode_minus']=False

from sklearn import svm

import sklearn.linear_model as LM

import scipy.stats as st

from scipy.optimize import root,fsolve

from sklearn.feature_selection import VarianceThreshold,SelectKBest,f_classif,chi2

from sklearn.feature_selection import RFE,RFECV,SelectFromModel

from sklearn.linear_model import Lasso,LassoCV,lasso_path,Ridge,RidgeCV

from sklearn.linear_model import enet_path,ElasticNetCV,ElasticNetdata=pd.read_table('邮政编码数据.txt',sep=' ',header=None)

tmp=data.loc[(data[0]==1) | (data[0]==3)]

X=tmp.iloc[:,1:-1]

Y=tmp.iloc[:,0]fig,axes=plt.subplots(nrows=1,ncols=2,figsize=(15,5))

ratios=[0.2,0.8]

bestalpha=[]

for i,ratio in enumerate(ratios):alphas_enet, coefs_enet, _ = enet_path(X,Y,l1_ratio=ratio)axes[i].plot(-np.log10(alphas_enet), coefs_enet.T, linestyle='--')model=ElasticNetCV(l1_ratio=ratio)model.fit(X,Y)bestalpha.append(model.alpha_)axes[i].set_xlabel('-Log(alpha)')axes[i].set_ylabel('回归系数')axes[i].set_title('Lasso回归和弹性网回归(L1范数率=%.2f)\n最优alpha=%.4f;训练误差=%.4f'%(ratio,model.alpha_,1-model.score(X,Y)))axes[i].axis('tight')

model=ElasticNet(l1_ratio=0.8,alpha=bestalpha[0])

model.fit(X,Y)

axes[1].text(0,-0.6,"alpha=%.4f时:训练误差=%.4f"%(bestalpha[0],1-model.score(X,Y)),fontdict={'size':'12','color':'b'})

plt.savefig("../4.png", dpi=500) 运行结果如下图所示:

这段代码的作用是进行特征选择并可视化处理后的特征数据。下面是详细解释:

随机种子设置和数据抽样:

np.random.seed(1):设置随机种子,确保随机结果可复现性。ids = np.random.choice(len(Y), 25):从目标变量Y的长度中随机选择 25 个索引,用于后续可视化。特征选择和模型拟合:

- 对于预先设定的两种

l1_ratio和对应的最优alpha值,分别进行如下操作:

- 创建

ElasticNet模型 (estimator),使用指定的l1_ratio和alpha值。- 使用

SelectFromModel进行特征选择,这个方法根据模型训练结果选择重要的特征。selector.fit(X, Y):根据给定的模型对特征X和目标变量Y进行拟合,以确定保留哪些特征。特征选择结果展示:

- 打印输出保留的特征个数:

len(selector.get_support(indices=True))表示保留的特征数量。- 使用

selector.inverse_transform(selector.transform(X)),将经过选择的特征逆转换回原始特征空间Xtmp,用于后续图像展示。特征数据可视化:

- 创建一个

8x8大小的图形界面 (plt.figure(figsize=(8,8))),用于展示选定的特征图像。- 对于每个随机选择的索引

item,从Xtmp中提取并重塑为16x16的图像 (img)。- 使用

plt.subplot(5,5,i+1)在图中安排每个特征图像的位置,并使用灰度色彩映射 (cmap=cm.gray) 显示图像。图像展示:

- 调用

plt.show()将生成的图像显示在界面上,每个子图显示一个特征图像。综上所述,这段代码主要用于使用弹性网回归进行特征选择,并通过图像展示选择后的特征数据,从而帮助分析人员理解数据中哪些特征对模型建立有重要贡献。

np.random.seed(1)

ids=np.random.choice(len(Y),25)

for ratio,alpha in [(0.2,bestalpha[0]),(0.8,bestalpha[1])]:estimator = ElasticNet(l1_ratio=ratio,alpha=alpha)selector=SelectFromModel(estimator=estimator)selector.fit(X,Y)#print("阈值(%f,%f):%s"%(ratio,alpha,selector.threshold_))print("保留的特征个数(%f,%f):%d"%(ratio,alpha,len(selector.get_support(indices=True))))Xtmp=selector.inverse_transform(selector.transform(X))plt.figure(figsize=(8,8))for i,item in enumerate(ids):img=np.array(Xtmp[item,]).reshape((16,16))plt.subplot(5,5,i+1)plt.imshow(img,cmap=cm.gray)plt.show()

运行结果如下图所示:

总结

综上所述,Lasso回归和弹性网回归是两种常用的线性回归方法,通过正则化惩罚的引入,能够在保持模型预测准确性的同时,实现特征选择和模型复杂度控制,适用于处理各种类型的数据集和回归问题。