前言

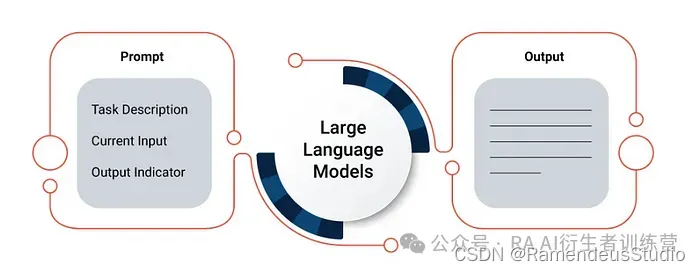

大型语言模型 (LLM) 为各行各业带来了变革性功能,让用户能够利用尖端的自然语言处理技术处理各种应用。然而,这些强大的 AI 系统的便利性是有代价的 — 确实如此。随着 LLM 变得越来越普及,其计算成本和延迟可能会迅速增加,从而给预算带来压力并影响性能。

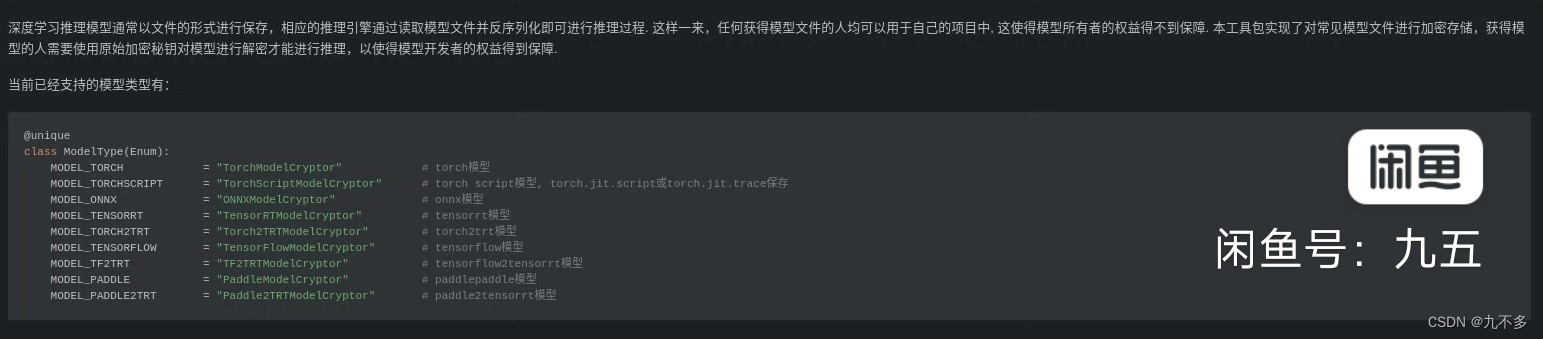

但是,如果您能够实现类似的结果,同时减少 LLM 支出和延迟,情况会怎样?解决方案在于简化您的提示,即指导语言模型的文本输入。通过优化标记使用并制作简洁而有效的提示,我们可以在不影响准确性的情况下最大限度地提高效率。

让我们探索简化提示的技术,优化令牌使用以降低 LLM 成本和延迟。我们将深入研究提示工程、上下文优化和令牌管理的策略,使您能够充分利用 LLM 的潜力,同时最大限度地降低开销。

基础知识:了解Token(令牌)及其影响

在我们深入研究提示精简的复杂性之前,必须了解Token的基本概念及其在 LLM 操作中的重要性。

Token是语言模型输入和输出的基本单位。它们代表模型识别和处理的单个单词、标点符号,甚至是子单词单元(如前缀或后缀)。当您向 LLM 提供输入提示时,它会被标记化(分解为单个标记),然后再由模型处理。

提示中的Token数量直接影响 LLM 所需的计算资源,进而影响成本和延迟。令牌越多,处理需求就越高,从而导致费用增加和响应时间延长。

此外,许多 LLM 提供商采用基于Token的定价模式,根据处理的令牌数量向您收费。因此,优化令牌使用可以节省大量成本,特别是对于具有高容量或实时要求的应用程序。

Prompt工程:制作简洁有效的提示

提示设计艺术是简化 LLM 提示的核心。通过精心设计提示,您可以有效地传达您的意图,同时最大限度地减少令牌的使用。以下是一些值得考虑的策略:

- 拥抱简单:在提示中力求清晰简洁。避免不必要的冗长或冗余信息,因为这些信息会增加令牌开销,而对核心意图没有贡献。将复杂的任务分解为多个有针对性的提示,而不是将所有内容塞进一个复杂的输入中。

- 利用上下文和示例:提供相关上下文和说明性示例,以指导 LLM 实现您的期望输出。精心挑选的示例可以比冗长的解释更有效地传达复杂的要求,减少标记数量,同时保持准确性。

- 利用提示模板:为常见任务或领域开发可重复使用的提示模板。这些模板可以封装最佳实践,减少每次从头开始制作提示的需要,并确保一致的令牌优化。

- 尝试提示格式:探索不同的提示格式,例如小样本学习(提供一些示例)、基于前缀的提示(提供特定于任务的前缀)或思路链提示(指导模型的推理过程)。不同的格式可能会为特定用例带来更好的标记效率。

- 迭代和优化:根据经验结果和性能指标不断迭代和优化您的提示。分析Token使用情况、成本和延迟,并进行数据驱动的调整以进一步优化。

上下文优化:利用先验知识

虽然简洁的提示必不可少,但它们不应牺牲准确和相关输出所需的关键背景。幸运的是,LLM 提供了强大的技术来整合相关背景,而不会增加标记数量。

- 少量学习:少量学习不提供冗长的解释,而是向 LLM 展示少量精心挑选的示例。这些示例作为演示,使模型能够更有效地推断所需的任务和输出格式。

- 上下文检索:利用外部知识源或数据库动态检索相关上下文。通过有选择地将重点上下文片段合并到提示中,您可以减少标记开销,同时确保 LLM 能够访问必要的背景信息。

- 微调和角色嵌入:根据特定领域的数据微调 LLM,或将个性化提示或角色嵌入模型的权重中。这种方法允许您“融入”上下文和偏好,从而减少推理过程中对冗长提示的需求。

- 提示链:将复杂的任务分解为一系列较小的提示,每个提示都基于前一个输出。此技术可让您保留上下文,同时最大限度地减少单个提示的标记使用。

Token管理:优化输入和输出

虽然简化提示至关重要,但在整个 LLM 的输入和输出生命周期中有效管理Token使用也同样重要。以下是一些需要考虑的高级技术:

- 截断和窗口化:如果您的输入或输出超出了标记限制,请策略性地截断或窗口化数据以关注最相关的片段。实施滑动窗口、汇总或智能截断等技术,以在标记限制内最大化信息密度。

- 批处理和分块:对于高容量或实时应用程序,批处理或分块输入可在多个请求之间分摊令牌开销。仔细平衡批处理大小以优化吞吐量和延迟权衡。

- 标记化策略:探索高级标记化策略,例如字节级字节对编码(BPE)或句子片段标记化,这些策略可以为特定域或语言提供更有效的标记表示。

- 令牌回收:实施令牌回收机制,以在多个请求中重复使用令牌,减少重复标记和处理冗余输入段的需要。

- 缓存和记忆:缓存和记忆提示、响应和中间结果,以避免对重复输入或子任务进行冗余计算和标记处理。

- 压缩和量化:探索压缩和量化技术,以减少 LLM 权重和激活的内存占用和计算开销,间接优化 token 处理效率。

成本和绩效监控

在我们实施这些先进技术时,持续监控它们对成本和性能的影响至关重要。建立强大的监控和分析框架来跟踪令牌使用情况、成本、延迟和准确性指标。这种数据驱动的方法将使您能够:

- 识别优化机会:精确定位令牌使用率、成本或延迟过高的提示、用例或工作流步骤,并相应地确定优化工作的优先级。

- 验证准确性和质量:确保您的 token 优化策略不会损害输出的准确性或质量。监控相关指标,例如人工评估分数、特定于任务的基准或应用程序级 KPI。

- 迭代和改进:根据经验数据不断改进您的策略,调整技术、参数和阈值,以在效率和准确性之间达到最佳平衡。

- 预测和预算:利用历史数据和使用模式准确预测未来的 LLM 成本和资源需求,实现主动的容量规划和预算。

- 实施动态优化:基于实时监控数据,动态调整优化策略和资源分配,以应对波动的需求、工作负载模式或成本限制。

自动监控和持续优化

在我们实施先进的提示精简和令牌优化技术时,建立强大的自动监控和持续优化流程至关重要。这种数据驱动的方法将使您能够最大限度地提高效率,同时确保输出质量并与不断变化的业务需求保持一致。

- 实时令牌使用情况跟踪:实施全面的监控系统,实时跟踪所有 LLM 应用程序和工作流程中的令牌使用情况。分析令牌使用模式,识别热点,并相应地确定优化工作的优先级。

- 成本和延迟监控:持续监控优化策略对 LLM 成本和延迟的直接影响。与 LLM 提供商的计费和绩效指标集成,全面了解效率改进情况。

- 输出质量保证:建立自动化质量保证机制,以验证应用优化技术后 LLM 输出的准确性、连贯性和特定任务性能。利用人工评估、基准数据集和应用程序级指标来确保输出质量不受影响。

- 动态提示适应:实施动态提示适应系统,该系统可以根据实时监控数据自动调整提示、上下文和优化策略。这可能涉及上下文修剪、即时提示重新表述或基于成本、延迟或质量阈值在优化模式之间切换等技术。

- 持续实验和 A/B 测试:培养持续实验和 A/B 测试的文化,以迭代方式改进和改善您的快速精简和优化方法。系统地测试和评估新技术、标记化策略或上下文整合方法,并采用最有效的方法。

- 自动优化工作流程:开发自动优化工作流程,整合提示精简的各个方面,从数据预处理和上下文合并到提示工程、标记化和输出后处理。这些端到端工作流程应可配置、可扩展,并与您的监控和适应系统紧密集成。

- 机器学习驱动的优化:利用机器学习技术构建智能优化模型,可以从历史数据、使用模式和性能指标中学习。这些模型可以提供主动建议,预测未来的Token使用情况和成本,甚至可以自动执行即时优化的某些方面。

通过采用自动监控和持续优化,我们将实现效率提升的良性循环,使您的 LLM 应用程序能够无缝扩展,同时适应动态 LLM 环境中不断变化的业务需求和技术进步。

案例研究:真实世界的应用

客户服务聊天机器人

在客户服务领域,由 LLM 提供支持的聊天机器人彻底改变了企业与客户互动的方式。然而,由于查询量大且需要实时响应,LLM 成本和延迟可能会迅速上升。

通过实施提示工程技术,例如使用简洁的基于模板的提示并利用知识库中的上下文检索,组织可以将其聊天机器人令牌使用率优化 30% 以上。令牌数量的减少意味着大幅节省成本并缩短响应时间,从而提升整体客户体验。

内容生成和摘要

LLM 已成为内容生成和摘要任务的宝贵工具,可帮助作家、记者和研究人员高效地创作高质量内容。然而,这些应用程序的Token密集型特性可能会造成预算紧张并带来延迟。

通过采用小样本学习、即时链接和智能截断等技术,一家大型媒体公司简化了其内容生成工作流程。他们在保持输出质量的同时将令牌使用量减少了高达 45%,从而能够以经济高效的方式扩展其内容制作能力。

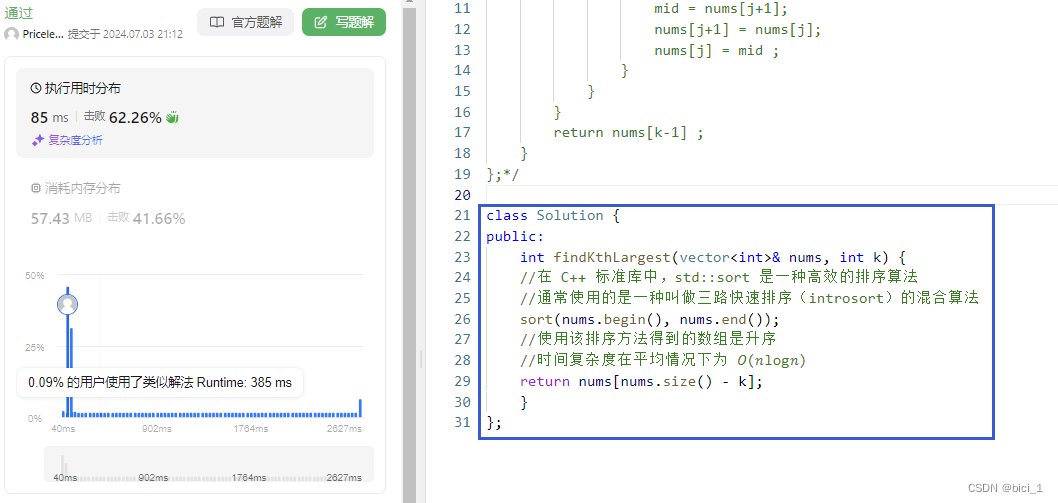

代码生成和协助

在软件开发领域,LLM 已成为代码生成、文档编制和任务自动化的强大助手。然而,代码和技术上下文的复杂性可能会导致提示冗长和令牌开销增加。

通过利用特定领域的微调,一家领先的科技公司优化了其基于 LLM 的编码助手,以提高 token 效率。他们根据精选的代码示例和文档语料库对模型进行了微调,从而实现了更简洁的提示,并在不牺牲准确性的情况下将 token 使用量减少了高达 25%。

结论:释放无与伦比的效率

在 LLM 领域,创新往往需要付出高昂的代价,因此掌握快速精简和Token优化的技巧是至关重要的。本综合指南为您提供了应对 LLM 部署复杂性的策略和技巧,在保持最高绩效、道德和责任标准的同时,实现无与伦比的效率。

真正的精通不仅在于应用这些技术,还在于不断追求迭代、改进和适应——这是一个持续的循环,可确保您的解决方案始终处于成本效益和能力的最前沿。拥抱负责任的人工智能精神,将道德考量融入您的优化工作中,在技术边界不断重新定义的时代培养信任和责任感。

前路充满挑战,但对于那些决心踏上这条旅程并致力于追求卓越的人而言,回报是巨大的。想象一下这样一个未来:曾经高昂的LLM费用将成为遥远的记忆,延迟只是耳语,而可能性的界限不断被重新定义。

抓住这一时机,大型语言模型领域无与伦比的效率时代已经到来。充分发挥 LLM 部署的潜力,让您的成功回响在您的组织、您的行业乃至全世界。

欢迎你分享你的作品到我们的平台上. http://www.shxcj.com 或者 www.2img.ai 让更多的人看到你的才华。

创作不易,觉得不错的话,点个赞吧!!!