下面是我关于大语言模型学习的一点记录

目录

人工智能学习路线

MaxKB 系统(基于大语言模型的知识问答系统)

部署开源大语言模型LLM

1.CPU模式(没有好的GPU,算力和效果较差)

2.GPU模式(需要有NVIDIA显卡支持)

Ollama网络配置

Ollama前台页面配置

使用docker中的ollama下载并运行AI模型

ollama模型仓库(可以选择自己想用的模型安装体验)

🏆 LMSYS Chatbot Arena Leaderboard(排行榜)

人工智能学习路线

人工智能学习路线(学+测) - 阿里云开发者社区人工智能学习路线,算法原理、框架精讲、机器学习实战、图像识别实战、自然语言处理实战,人工智能技术一站式学习![]() https://developer.aliyun.com/learning/roadmap/ai

https://developer.aliyun.com/learning/roadmap/ai

MaxKB 系统(基于大语言模型的知识问答系统)

官网和GitHub链接,可以用于公司知识库

MaxKB - 基于大语言模型的知识库问答系统MaxKB 是一款基于 LLM 大语言模型的知识库问答系统。![]() https://maxkb.cn/https://github.com/1panel-dev/MaxKB

https://maxkb.cn/https://github.com/1panel-dev/MaxKB![]() https://github.com/1panel-dev/MaxKB

https://github.com/1panel-dev/MaxKB

docker安装

docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data 1panel/maxkb

MaxKB是知识问答系统,主要对文档进行分块,内容块和问答框以及匹配度设置和问答记录登记 反馈等等情况。但本身不具有LLM模型,需要另外部署或者接入API,例如千帆

我们自己部署一套开源模型

部署开源大语言模型LLM

1.CPU模式(没有好的GPU,算力和效果较差)

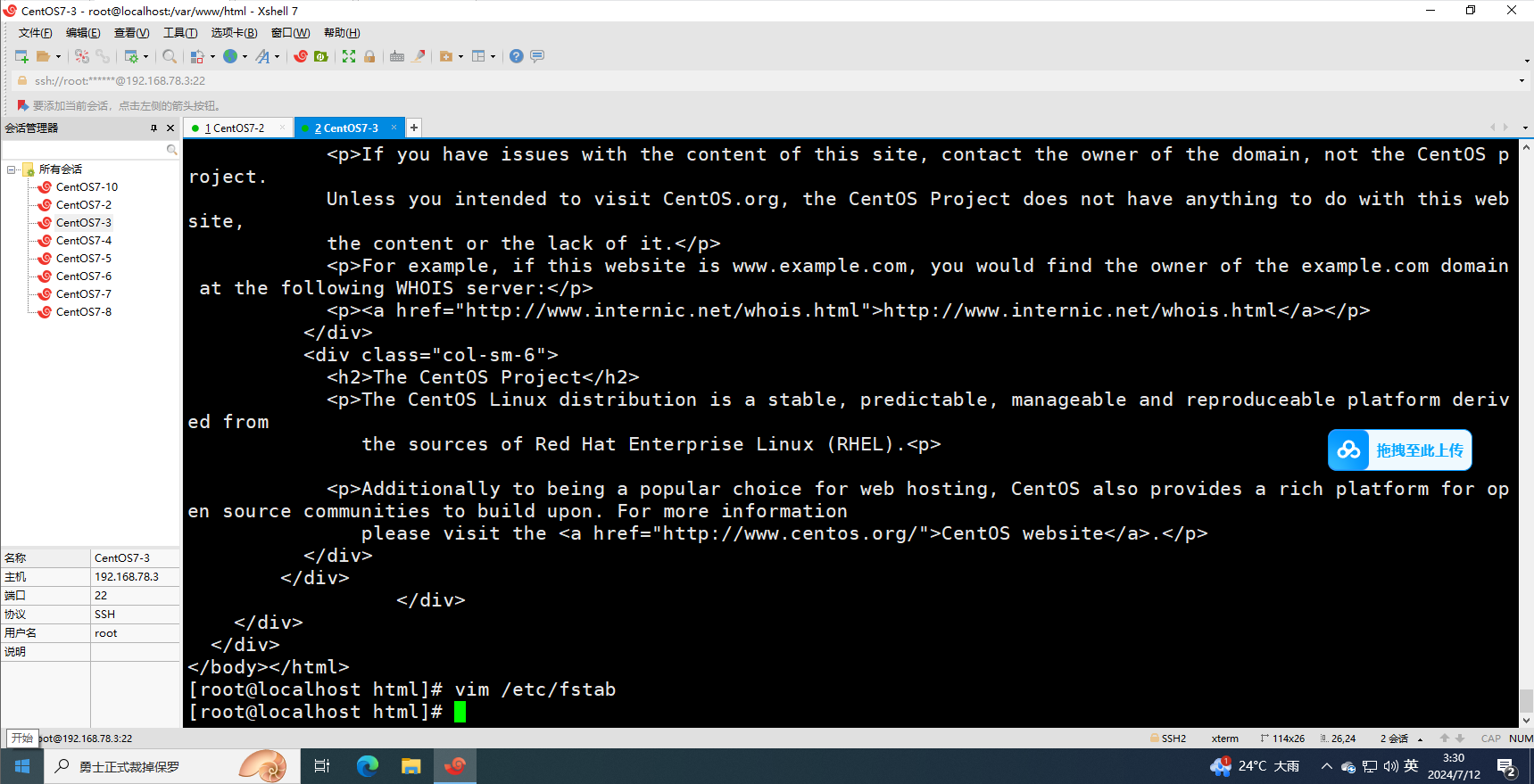

docker部署ollama(给MaxKB调用)

docker run -d -v /opt/ai/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

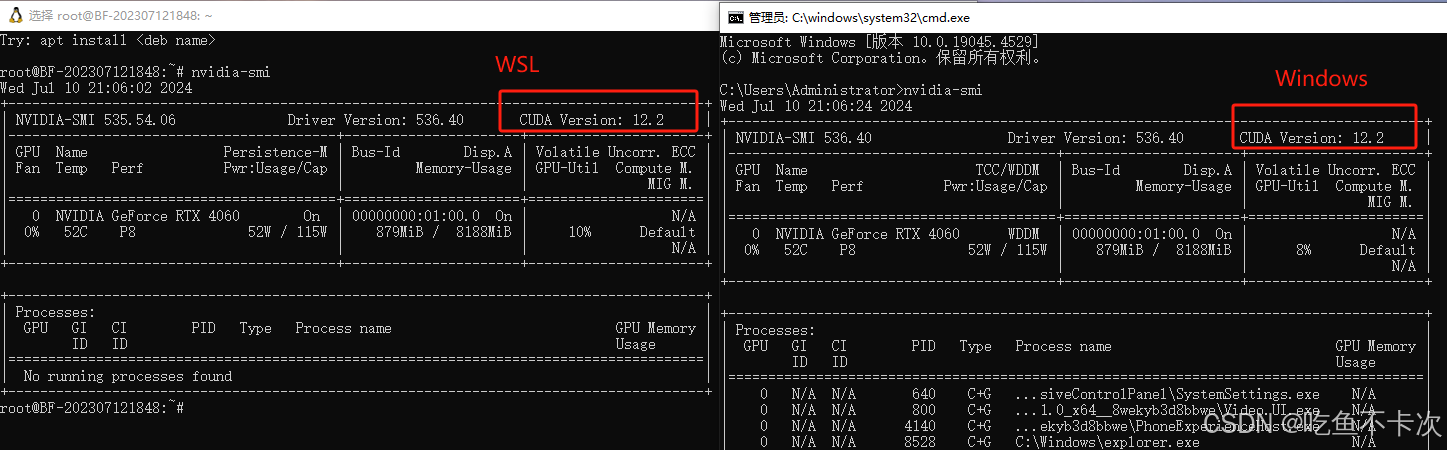

2.GPU模式(需要有NVIDIA显卡支持)

企业级需要4090 2块做推理

安装英伟达容器工具包(以Ubuntu22.04为例)

其他系统请参考:英伟达官方文档

# 1.配置apt源curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \

&& curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \

sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \

sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list

# 2.更新源sudo apt-get update

# 3.安装工具包sudo apt-get install -y nvidia-container-toolkit

docker使用GPU运行ollama

docker run --gpus all -d -v /opt/ai/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

Ollama网络配置

如何在我的网络上暴露Ollama?

Ollama默认绑定127.0.0.1端口11434。通过OLLAMA_HOST环境变量更改绑定地址。

https://docs.dify.ai/v/zh-hans/guides/model-configuration/ollama#zai-windows-shang-she-zhi-huan-jing-bian-liang

Ollama前台页面配置

docker部署ollama web ui(第一次登录需要注册)

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

使用docker中的ollama下载并运行AI模型

#通义1.0 4b

docker exec -it ollama ollama run qwen:4b-chat

#中文 lama2-chinese:13b模型

docker exec -it ollama ollama run llama2-chinese:13b

#通义7b-chat-v1.5-q5_K_M

docker exec -it ollama ollama run qwen:7b-chat-v1.5-q5_K_M

#通义千问2.0 Qwen2-7B(2024年6月底更新,当前最好用的开源,推荐用这个模型,下面有排行榜,在有限的资源下Qwen2-7B是开源中的顶流了,70亿的体量能满足企业开展,如果资源不够可以搞小一点的模型,测试下来P100勉强可以跑,A10可以跑5并发 3000token)

docker exec -it ollama ollama run qwen2:72b

#进入容器

docker exec -it ollama bash

root@9592d72fca5b:/# ollama list

NAME ID SIZE MODIFIED

llama2-chinese:13b 990f930d55c5 7.4 GB 3 hours ago

qwen:0.5b-text-v1.5-q6_K c8c2e4f579df 514 MB 15 minutes ago

qwen:4b-chat d53d04290064 2.3 GB 5 hours ago

qwen:7b-chat-v1.5-q5_K_M 44ca6b3fda9d 5.5 GB About an hour ago

root@9592d72fca5b:/# ollama rm qwen:0.5b-text-v1.5-q6_K

deleted 'qwen:0.5b-text-v1.5-q6_K'

root@9592d72fca5b:/# ollama list

NAME ID SIZE MODIFIED

llama2-chinese:13b 990f930d55c5 7.4 GB 3 hours ago

qwen:4b-chat d53d04290064 2.3 GB 5 hours ago

qwen:7b-chat-v1.5-q5_K_M 44ca6b3fda9d 5.5 GB About an hour ago

ollama模型仓库(可以选择自己想用的模型安装体验)

ollama模型仓库

🏆 LMSYS Chatbot Arena Leaderboard(排行榜)

https://chat.lmsys.org/?leaderboard

https://cevalbenchmark.com/static/leaderboard.html

上面这个网站收集的模型比较

SuperCLUE

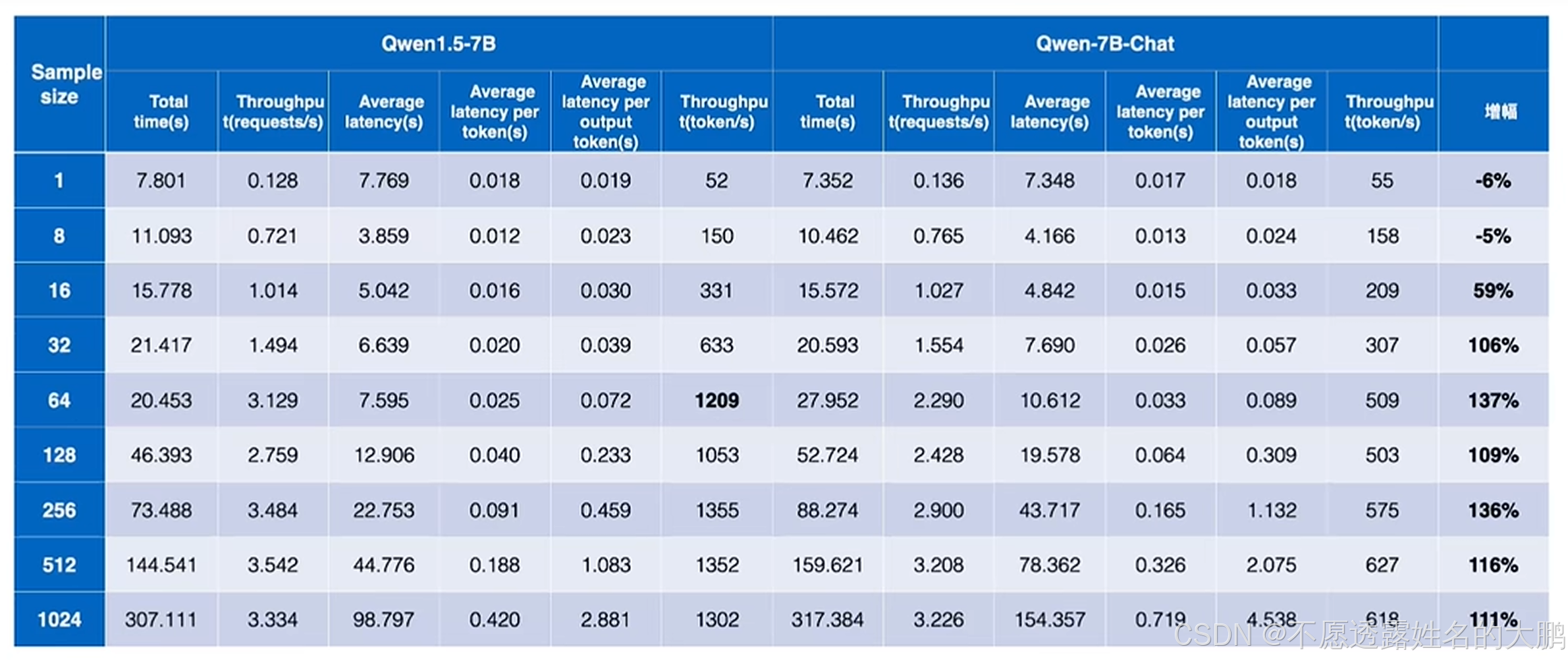

这部分是Qwen1.5的比对,目前已经到Qwen2.0了