🌈个人主页: 鑫宝Code

🔥热门专栏: 闲话杂谈| 炫酷HTML | JavaScript基础

💫个人格言: "如无必要,勿增实体"

文章目录

- 模型验证曲线(Validation Curves)解析

- 什么是模型验证曲线?

- 模型验证曲线的解读

- 模型验证曲线的优缺点

- 示例代码

模型验证曲线(Validation Curves)解析

在机器学习模型的训练过程中,我们通常会遇到一些需要调整的超参数(Hyperparameters)。这些超参数的选择对模型的性能有着重大影响。例如,在训练支持向量机(SVM)时,我们需要选择合适的正则化参数C;在训练神经网络时,我们需要选择合适的隐藏层数量等等。那么,如何选择这些超参数的最佳值呢?这就需要借助一种叫做模型验证曲线(Validation Curves)的技术。

什么是模型验证曲线?

模型验证曲线是一种用于评估模型超参数对模型性能影响的可视化工具。它通过绘制不同超参数值对应的训练分数和验证分数曲线,帮助我们选择最佳超参数值。

具体来说,模型验证曲线包含以下几个步骤:

- 选择一个待调整的超参数,以及一个超参数值范围。

- 使用网格搜索(Grid Search)或其他方法,在给定的超参数值范围内生成一系列候选值。

- 对于每个候选超参数值,进行如下操作:

- 使用该超参数值训练模型,获得训练集上的分数(如准确率或其他指标)。

- 在同一个模型上,计算验证集上的分数。

- 将所有候选超参数值对应的训练分数和验证分数分别绘制在两条曲线上。

通过观察这两条曲线的走势,我们可以发现一些有趣的现象,并据此选择合适的超参数值。

模型验证曲线的解读

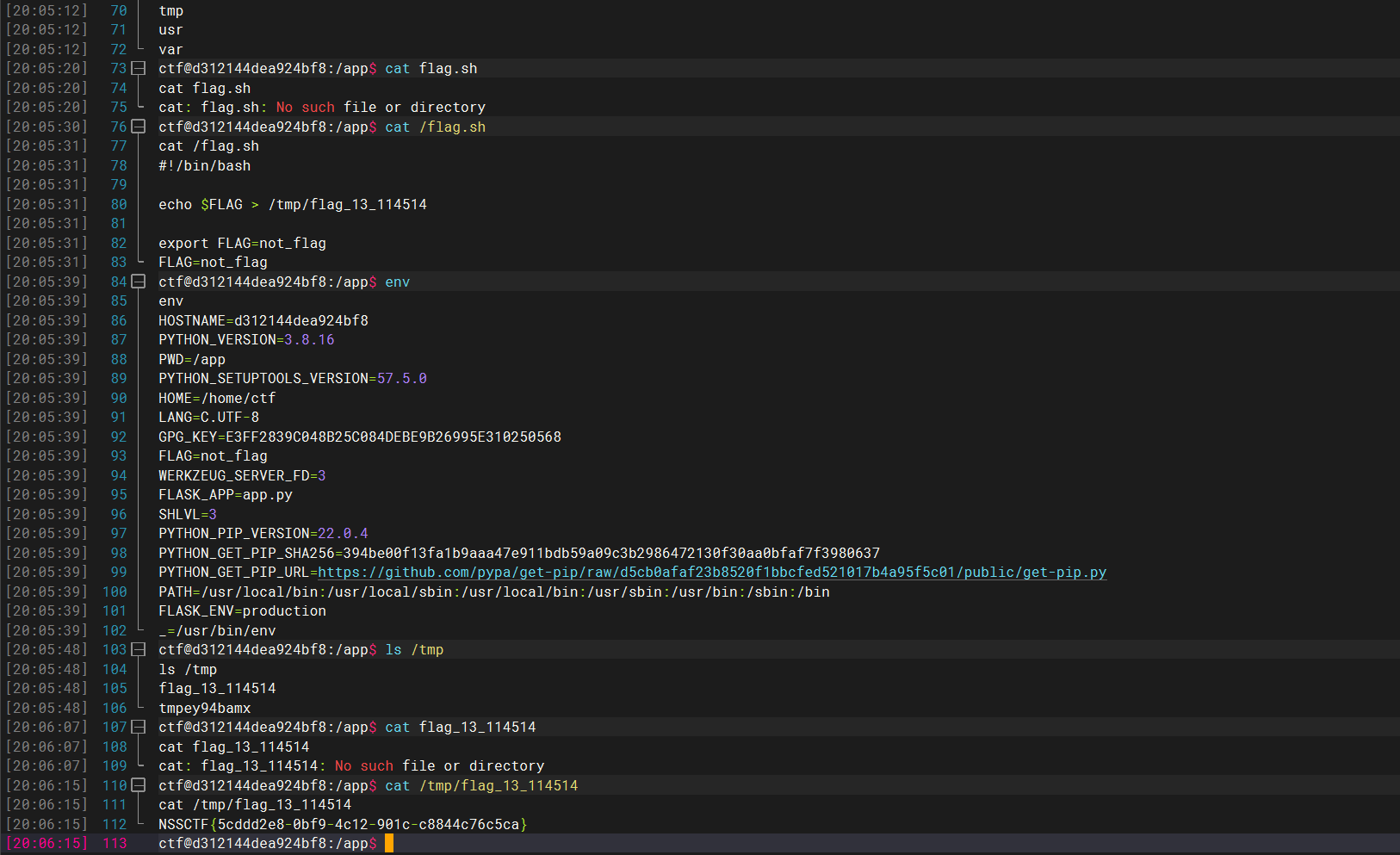

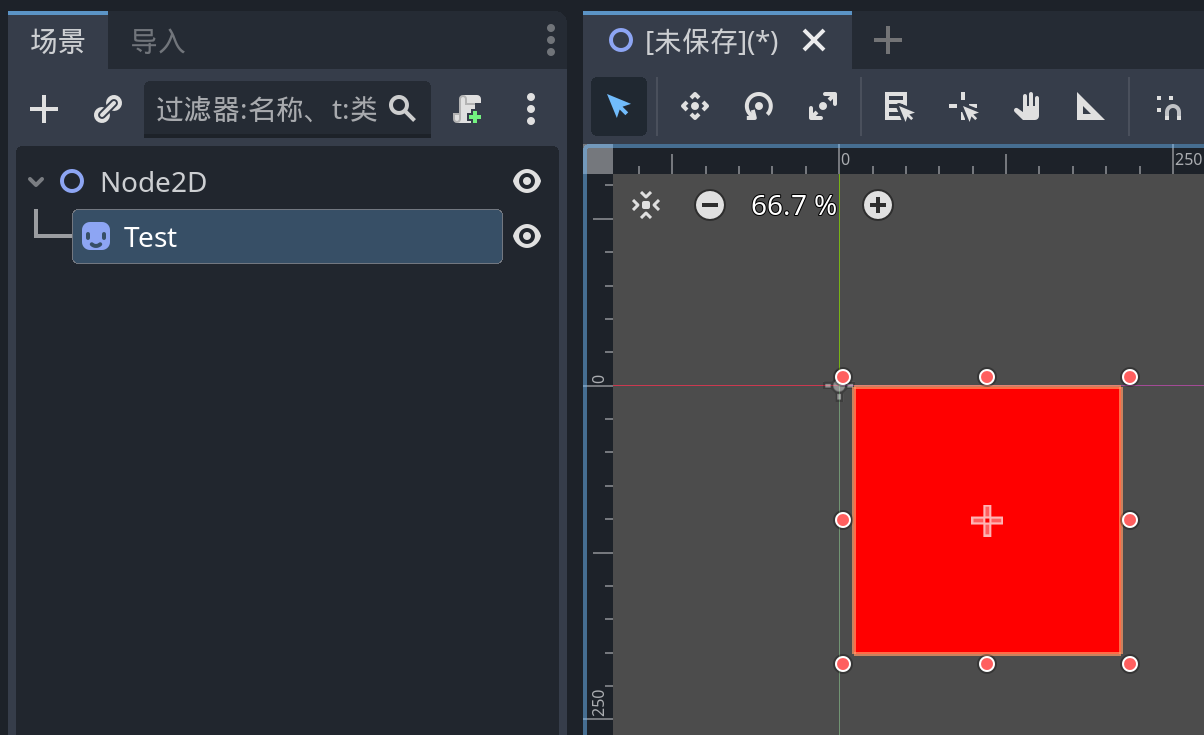

让我们通过一个具体的例子来理解如何解读模型验证曲线。假设我们正在训练一个支持向量机(SVM)模型,需要调整正则化参数C。我们绘制了C的模型验证曲线,如下所示:

在上图中,横轴表示正则化参数C的值,纵轴表示模型在训练集和验证集上的分数。我们可以观察到以下几点:

-

欠拟合(Underfitting): 当C的值较小时(如0.0001),训练分数和验证分数都较低,说明模型过于简单,没有很好地捕捉到数据的规律,出现了欠拟合的情况。

-

过拟合(Overfitting): 当C的值较大时(如100),训练分数很高,但验证分数较低,说明模型过于复杂,将训练数据中的噪声也学习了进去,出现了过拟合的情况。

-

最佳值区域: 在中间的C值范围内(如0.1到10),训练分数和验证分数都比较高,而且两条曲线相差不大,说明模型在这个区域内具有较好的泛化能力,我们可以在这个区域内选择一个合适的C值作为最终模型的超参数。

通过观察模型验证曲线,我们可以直观地了解模型在不同超参数值下的表现,从而选择最佳超参数值,避免欠拟合和过拟合问题。

模型验证曲线的优缺点

模型验证曲线作为一种超参数调优的可视化工具,具有以下优点:

-

可解释性强: 通过观察曲线的走势,我们可以直观地理解模型在不同超参数值下的表现,以及欠拟合和过拟合的情况。

-

操作简单: 只需要选择一个超参数及其值范围,就可以自动绘制模型验证曲线,无需复杂的数学推导。

-

适用范围广: 模型验证曲线可以应用于各种机器学习模型,如支持向量机、决策树、神经网络等,只要模型有需要调整的超参数即可使用。

然而,模型验证曲线也存在一些缺点和局限性:

-

只能调整一个超参数: 每次只能调整一个超参数,如果模型有多个需要调整的超参数,就需要多次绘制模型验证曲线,工作量较大。

-

计算开销较大: 对于每个超参数值,都需要重新训练模型并计算验证集分数,当数据集较大或模型较复杂时,计算开销会变得很高。

-

无法处理相关超参数: 如果两个超参数之间存在相关性,单独调整每个超参数可能无法找到最佳组合。

-

无法自动选择最佳值: 虽然模型验证曲线可以帮助我们确定一个合适的超参数值范围,但最终的选择仍需要人工判断。

尽管存在一些局限性,但模型验证曲线仍然是一种非常有用的超参数调优工具,特别是在初步探索阶段。通过结合其他技术(如随机搜索、贝叶斯优化等),我们可以进一步提高超参数调优的效率和效果。

示例代码

以下是使用Python中的scikit-learn库绘制模型验证曲线的示例代码:

from sklearn.svm import SVC

from sklearn.model_selection import validation_curve

import matplotlib.pyplot as plt

import numpy as np# 生成示例数据

X, y = make_blobs(n_samples=1000, centers=2, n_features=10, random_state=0)# 创建估计器对象

clf = SVC(kernel='rbf', gamma=1, random_state=0)# 设置需要评估的超参数值范围

param_range = np.logspace(-6, -1, 5)# 计算模型验证曲线

train_scores, test_scores = validation_curve(clf, X, y, param_name='C', param_range=param_range,scoring='accuracy', n_jobs=-1)# 计算均值和标准差

train_mean = np.mean(train_scores, axis=1)

train_std = np.std(train_scores, axis=1)

test_mean = np.mean(test_scores, axis=1)

test_std = np.std(test_scores, axis=1)# 绘制模型验证曲线

plt.figure(figsize=(8, 6))

plt.title('Validation Curve')

plt.xlabel('C')

plt.ylabel('Score')

plt.semilogx(param_range, train_mean, label='Training score', color='r')

plt.semilogx(param_range, test_mean, label='Cross-validation score', color='g')

plt.fill_between(param_range, train_mean - train_std, train_mean + train_std, alpha=0.2, color='r')

plt.fill_between(param_range, test_mean - test_std, test_mean + test_std, alpha=0.2, color='g')

plt.legend()

plt.show()

在这个示例中,我们使用scikit-learn库中的validation_curve函数计算了支持向量机模型在不同正则化参数C值下的训练分数和验证分数。然后,我们使用Matplotlib库绘制了模型验证曲线,包括训练分数曲线、验证分数曲线,以及它们的标准差区域。

通过运行这段代码,你将看到一个类似于前面示例图片的模型验证曲线。你可以根据曲线的走势,选择一个合适的C值作为最终模型的超参数。