接前文背景,

当需要从关系型数据库(如Oracle)中读取数据时,Spark提供了JDBC连接功能,允许我们轻松地将数据从Oracle等数据库导入到Spark DataFrame中。然而,在处理时间字段时,可能会遇到一些挑战,特别是在Oracle的DATE和TIMESTAMP类型与Spark SQL的日期时间类型之间进行转换时。

Spark通过JDBC读取Oracle基本配置

val jdbcUrl = "jdbc:oracle:thin:@hostname:port:sid"

val connectionProperties = new java.util.Properties()

connectionProperties.put("user", "username")

connectionProperties.put("password", "password")

connectionProperties.put("driver", "oracle.jdbc.driver.OracleDriver") val df = spark.read.jdbc(jdbcUrl, "your_table", connectionProperties) df.show()时间转换

我一开始的续期就是将timestamp类型的且格式为yyyy-mm-dd hh:mm:ss字段转换为特定格式的字符串yyyy-MM-dd的将date类型,这是我最直接的需求。

我是从Oracle读取出来,在Oracle中字段的类型就是Date,格式是yyyy-mm-dd,但是通过这个spark连接jdbc读取出来,就变成了yyyy-mm-dd hh:mm:ss,字段类型也发生了专变成了timestamp类型,导致后面的处理报错。

误区:我们不能直接将TIMESTAMP类型转换成DateType的同时还保持yyyy-MM-dd的字符串格式,因为DateType在Spark SQL中代表的是没有时间的日期(即只包含年、月、日),但是我们可以迂回啊!

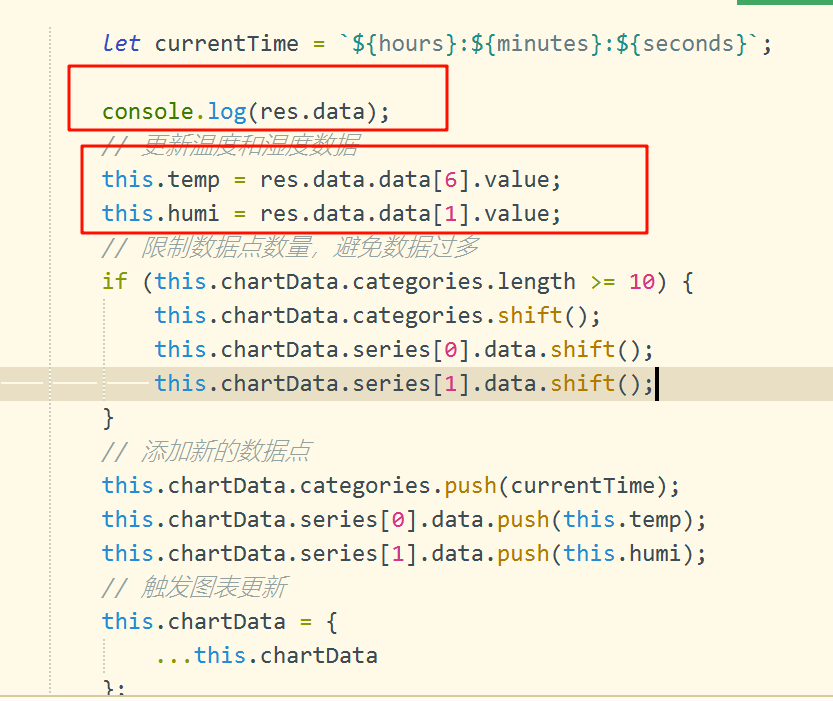

解决思路:

//1、先把TIMESTAMP转换为String格式的yyyy-mm-dd

val dfWithStringDate = df.withColumn("stat_date", date_format(col("stat_date"), "yyyy-MM-dd")) //2、再把String格式的yyyy-mm-dd转为Date类型.withColumn("stat_date", to_date(col("stat_date")))

这样得到了一个既包含DateType日期字段也包含StringType(yyyy-MM-dd格式)日期字段的DataFrame。。。。。。。。。。。。。。。。。。。。。。。

如有其他理解,欢迎交流。

N!