书生大模型全链路开源体系

- 书生浦语大模型开源历程

- 书生浦语2.0(InternLM2)体系

- 模型到应用

- 书生浦语开源开放体系

书生浦语大模型开源历程

书生浦语2.0(InternLM2)体系

书生浦语2.0体系,模型大小主要有2种规格:

- 7B,为轻量级的研究和应用提供了一个轻便但性能不俗的模型。

- 20B,模型的综合性能更为强劲,可有效支持更加复杂的实用场景。

每种规格里包含3类模型:

- 基座模型(InternLM2-Base),高质量和具有很强可塑性的模型基座是模型进行深度领域适配的高质量起点。

- 强化后的基座模型(InternLM2),在 Base 基础上,在多个能力方向进行了强化 ,在评测中成绩优异,同时保持了很好的通用语言能力,是我们推荐的在大部分应用中考虑选用的优秀基座。

- 对话模型(InternLM2-Chat),在 Base 基础上,经过 SFT 和 RLHF,面向对话交互进行了优化,具有很好的指令遵循、共情聊天和调用工具等的能力。

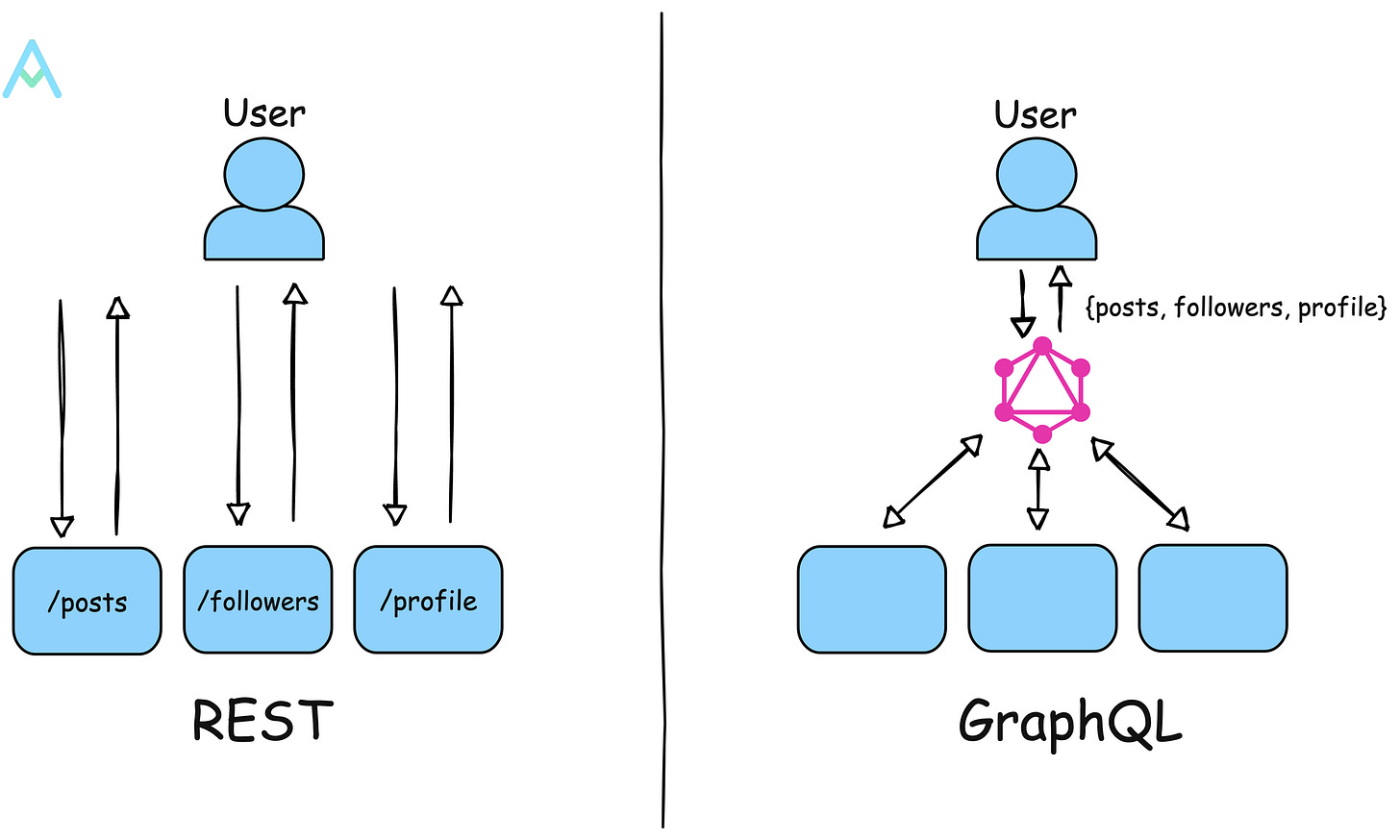

模型到应用

书生浦语开源开放体系

在大模型开发过程中,所涉及到的每个环节,书生浦语都有对应的开源工具:

- 数据阶段,书生万卷开源了2TB数据,涵盖多种模态和任务。

- 预训练阶段,轻量级训练框架InternEvo支持并行训练,极致优化,速度达到3600 tokens/sec/gpu。

- 微调阶段,XTuner支持多种大语言模型,包括但不限于 InternLM、Mixtral-8x7B、Llama 2、ChatGLM、Qwen、Baichuan。

- 部署阶段,LMDeploy支持全链路部署,每秒生成2000+ tokens。

- 评测阶段,OpenCompass支持全方位评测,涵盖100套评测集,50万道题目。

- 应用阶段,Lagent工具支持多种智能体,支持代码解释器等多种工具。