在上一节影片里我讲解了神经网络的结构 首先我们来快速回顾一下 在本节影片里,我们有两个目标 首介绍梯度下降的概念 它不仅是神经网络工作的基础 也是很多其他机器学习方法的基础 然后我们会研究一下这个特别的网络是如何工作的 以及这些隐藏的神经元层究竟在寻找什么 作为覆习 这里我们引用一个经典的例子——手写数字识别 神经网络领域的“Hello World” 这些数字书写在28乘28像素的网格上 每个网格对应一个0到1之间的灰度值。

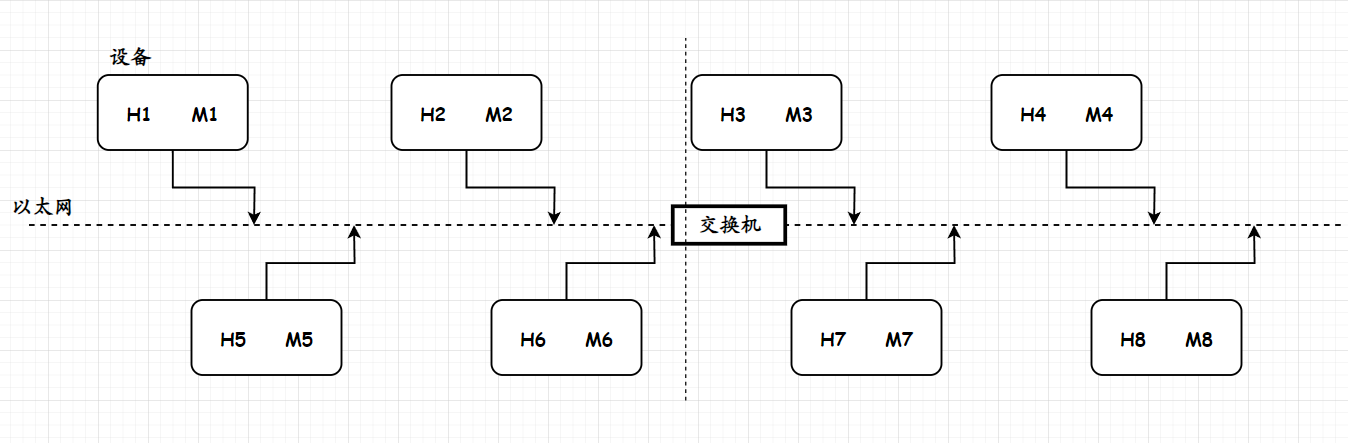

这些灰度值 决定了神经网络输入层的784个神经元的激活(782=28*28) 随后每一层的各个神经元的激活值 都基于前一层的加权和 与一个被叫做偏差的常数 相加 来获得 然后你把它和一些其他函数相加

比如sigmoid 或者我上节视频提到的ReLu 总之我们随意给出两个具有16个神经元的层

每一个神经网络有 13000个可以调整的权重值和偏差 正是这些值决定了这个神经网络如何工作 那么“这个网络可以将给定数字分类”是什么意思呢

即最后一层10个数字中被点亮的那个数字就是输入的数字 请记住,我们使用这个分层的结构,目的是或许,第二层可以辨别出数字中的特征线段 第三层或许可以辨别出组成数字的圈和线 而最后一层可以把所有特征结合在一起 从而辨别出这个输入的数字

因此,在这里 我们将学习神经网络是如何学习的 我们想要的是一种可以向这个神经网络展示大量训练数据的算法 这里所说的大量训练数据是指 很多手写数字的图像以及 标明了这个图像上的数字到底是几的标签

它能够通过这些训练数据 来调整13000个权重值和偏差以达到 改善神经网络表现的目的 我们所期望的是 这个分层的结构可以学习 超出训练数据范围的图像的识别 我们测试的方法是 当你完成对这个网络的训练后 当你向它展示它从未见过的图像时 观察它判断的精确度

幸运的是 通常我们可以用来自MNIST base的数据来开始训练 MNIST base的好人们收集了数以万计带有标签的手写数字图像 当你一但真正了解它的工作原理,你会发现向机器解释学习的过程非常有挑战的一件事

它并不像一些疯狂的科幻 反倒是更像微积分练习 也就是说 基本上是找到某一个特定函数的最小值 请记住,

从概念上讲, 我们认为每一个神经元都与前一层的所有神经元相连加权求和计算中的加权值 在定义中像是一种 神经元间连接强度的参考值 而偏差值则代表了某个神经元是倾向于激活 还是不激活并关闭 如果我们将所有的权重值和偏差值初始化为随机数

毫无疑问,这个神经网络会表现地一塌糊涂 用一个例子来说明 当你输入一个3的图像

输出层看起来一片混乱 所以,你要做的是,定义一个成本函数 来告诉电脑,不! 你是错的! 正确的输出应该是,多数神经元激活值为0 但是对于这个神经元来说,你给我的是垃圾 用数学语言来描述, 就是你需要把每个【垃圾输出】与【你想要的正确输出】的【差的平方】相加 这就是在单个训练例子中的成本

注意,如果网络能很正确地辨别出图像 这个和会非常小

但如果这个值很大 说明这个神经网络根本不知道它在干嘛 所以你要做的就是 考虑在你所能处理的上万个训练案例中的平均成本

这个平均成本就是我们对该神经网络 表现好坏的衡量值

记住这个神经网络本质上是一个函数 它将784个像素值数字作为输入 10个数字作为输出 从某种意义上来说 是通过这些权重和偏差来参数化

然而成本函数的复杂性表现在 最重要的是它将13,000 左右的权重和偏差值作为输入 并输出一个数字来反应这些权重和偏差质量的好坏

它的定义,由神经网络经过上万次训练后的表现来决定 这里面有很多要思考的 不过直接告诉电脑,它的工作有多烂 它一点帮助也没有

你想要知道的是,如何可以调整这些权重和偏差 从而让它表现的好一点 我们用一个简单的例子来说明 (而不是费力思考一个有着13000个输入输出的函数)

我们想象这样一个简单的函数 它只有一个输入和一个输出 如何找到一个输入值使函数值最小 学过微积分的学生知道 有时你可以非常容易地指出一个函数的最小值

但对于一些非常复杂的函数来说,就不一定可行了

当然包括我们那个超级复杂的有着13000个自变量的成本函数

一个更灵活的办法是,从任意一个输入量开始,找出让函数值变小的方向 尤其是,如果你知道函数在某一点的斜率 那么,当斜率为正时,向左;

当斜率为负时,向右 就可以找到函数输出变小的方向

如果你用合适的步骤不断地重复检查每一点的斜率 你就可以找到函式的局部最小值 你可以在大脑里想象这样一幅图 一个球向山下滚落

值得注意的是,即使在这样一个简单的单一输入函式中,依然有可能出现很多可以滚入的山谷

从你随机选取的输入值开始,找到的局部最小值

根本不能保证,它就是整个函数的最小值 对于我们的神经网络的函式来说,也是一样的情况

另外需要注意的是,如果你的步长和斜率成比例 那么当越接近最小值时,你的步长就越小,这会帮助你避免找过头 扩展一下想象力,

如果一个函数有两个自变量和一个因变量 你可以想象,输入自变量空间是一个XY平面 而成本函数则是飘浮在上面的一个曲面 现在,需要考虑的不是函数的斜率 而是在输入空间的寻找前进方向 换句话说,就是让函数输出减小得最快 下山的方向是什么?

同样的,我们想象一个球向山下滚落 熟悉多变量微积分的人会知道函数的梯度会给你最陡峭的上升方向 也就等同于哪个方向是函数增加最快的方向

很自然的,用负梯度就可以找到函数下降最快的方向 而且,这个梯度向量的长度实际上是这个最陡斜坡有多陡的指标

如果你并不熟悉多变量微积分 并且想学习更多关于这方面的内容 你可以看一下可汗学院关于这一章节的内容

事实上,对于我们来说,最重要的是 原则上这个矢量是可以计算出来的

它会告诉你下山的方向以及会有多陡 知道这些知识就够了,具体的细节并不重要

因为如果你知道可以通过计算梯度方向来找到函数值变小的方向并向山下走出第一步 那么你就可以重复这个过程

这个原理在拥有13000个自变量的函式中同样适用 想象一下,把有13000个权重和偏差的神经网络

放入一个超大的向量中 成本函数的负梯度只是一个简单的矢量 它是一个超级大的输入变量空间中的一个方向

告诉你哪个方向会让成本函数最快地变小

当然,对于我们专门设计的成本函数而言 改变权重和偏差意味着 让神经网络对每一组训练数据的输出

看起来不像是十个数字中随机的一个

而是实际上我们想让它输出的那一个 要知道,这个成本函式是每一组训练数据效果的平均 所以如果你减小这个函数值 意味着改善了所以样本的表现

让这个梯度计算更有效率的算法是神经网络学习的核心 它叫做反向传播 这是我下个视频重点要讲的 其中我非常想花时间讲一讲 对于一组特定的训练数据 每一个权重和偏差到底发生了什么

参考

https://youtu.be/IHZwWFHWa-w?si=_TERPs9nz8S5lU8n