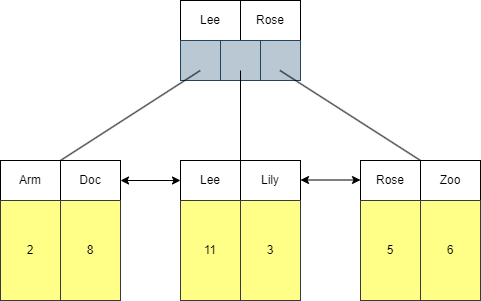

一、Embedding+MLP模型

Embedding+MLP 主要是由 Embedding 部分和 MLP 部分这两部分组成,使用 Embedding 层是为了将类别型特征转换成 Embedding 向量,MLP 部分是通过多层神经网络拟合优化目标。——用于广告推荐。

- Feature层即输入特征层,是模型的input部分,如上图的Feature#1是向上连接到embedding层,而Feature #2是直接连到stacking层。——前者代表类别型特征经过one-hot编码后生成的特征向量——过于稀疏,不适合直接输入网络中进行学习(所以先接入embedding层转为稠密向量);而后者是数值型特征。

- Stacking 层中文名是堆叠层,也叫连接(Concatenate)层作用是把不同的 Embedding 特征和数值型特征拼接在一起,形成新的包含全部特征的特征向量。

- MLP 层的作用是让特征向量不同维度之间做充分的交叉,让模型抓取到更多的非线性特征和组合特征的信息,使深度学习模型在表达能力上较传统机器学习模型大为增强。

- Scoring 层,它也被称为输出层,为了拟合优化目标。对于CTR 预估这类二分类问题,Scoring 层往往使用的是逻辑回归模型,输出层使用 sigmoid 函数作为激活函数,输出一个介于 0 和 1 之间的概率值;而对于图像分类等多分类问题,Scoring 层往往采用 softmax 模型,使用 softmax 函数作为激活函数,输出每个类别的概率值。

深度学习模型DeepCrossing——一个经典的Embedding+MLP模型结构——微软提出。属于Embedding+MLP模型的进阶,在 Embedding + MLP 的基础上增加了交叉层,以更好地模拟特征之间的高阶交互。

二、Wide&Deep模型——线性模型(Wide)和深度神经网络(Deep)

推荐算法面临一个和搜索排序系统一个类似的挑战——记忆性和泛化性的权衡。

记忆能力:可以被理解为模型直接学习并利用历史数据中物品或者特征的“共现频率”的能力。也可以简单地理解成对商品或者是特征之间成对出现的一种学习,由于用户的历史行为特征是非常强的特征,特征之间的直接线性关联,对于特征间的简单关系很有效。

泛化能力:可以被理解为模型传递特征的相关性,以及发掘稀疏甚至从未出现过的稀有特征与最终标签相关性的能力。对于泛化能力来说,它的主要来源是特征之间的相关性以及传递,捕捉复杂特征组合中的隐形关系、非线性关系。利用特征之间的传递性,就可以探索一些历史数据当中很少出现的特征组合,获得很强的泛化能力。

GooglePlay提出的Wide&Deep是比较经典的一个深度学习模型,它使模型既具有想象力又具有记忆力——线性模型(Wide)使模型既具有记忆力和深度神经网络(Deep)使模型既具有泛化性。

Wide&Deep架构示意图

Wide&Deep模型的工作流程:

- 特征工程:首先对原始数据进行预处理和特征工程,生成一系列可用于模型训练的特征。

- Wide 部分:将一部分特征直接输入到线性模型中,用于捕捉直接的线性关系——通常采用的是逻辑回归或线性回归模型,仅考虑每个特征对目标变量的直接贡献,而不考虑特征之间的交互。每个特征的权重都是独立计算的,不涉及与其他特征的相互作用——可以手动设置简单的二阶特征交叉。

- Deep 部分:将另一部分特征输入到深层神经网络中,用于学习特征之间的非线性关系。(本项目中输入全部特征)

- 联合训练:Wide 和 Deep 两部分的输出会被合并起来,通常是在最后一层通过加权求和的方式进行融合。

- 输出层:最后的输出层会根据Wide和Deep部分的融合结果生成最终的预测值。

举个简单的例子:电影推荐系统——预测用户是否会喜欢一部电影。

Wide 部分

特征包括:用户的年龄、性别、电影类型、导演等。

这些特征之间可能有直接的关系,比如年轻观众可能更喜欢动作片。

使用Wide部分(例如逻辑回归)来捕捉这些直接关系。

Deep 部分

特征包括:用户的观看历史、评分历史等。

这些特征之间的关系更为复杂,例如用户观看历史中的模式可能是非线性的。

使用Deep部分(例如多层神经网络)来学习这些复杂的模式。

如何工作

输入:用户特征和电影特征作为输入。

Wide 部分:直接使用特征进行线性预测。

Deep 部分:使用神经网络学习特征间的非线性关系。

合并:Wide和Deep的预测结果在最后一层合并。

输出:预测用户是否会喜欢这部电影。

结果

预测:结合了记忆性(Wide部分)和泛化性(Deep部分),可以更准确地预测用户喜好。

优势:能够处理简单和复杂的关系,提高推荐系统的准确性。

三、DeepFM模型

DeepFM是由哈工大和华为公司联合提出的深度学习模型。DeepFM模型包含因子分解机 (FM) 和深度神经网络 (DNN)。

- FM 部分:处理了一阶特征(每个特征的独立贡献)和二阶特征交互(特征之间的相互作用)——相对于Wide&Deep中的Wide部分多出二阶特征交互的部分——可以自动捕捉所有的可能的特征二阶交互。——DeepFM用FM替换原来的Wide部分,加强了浅层网络部分特征组合的能力。

- Deep 部分:通过 MLP 处理高阶特征交互,这里的高阶交互指的是通过神经网络自动学习得到的复杂特征组合。

- 合并输出:将 FM 部分的一阶和二阶特征交互与 Deep 部分的高阶特征交互结果合并,得到最终的预测。

DeepFM架构示意图

DeepFM VS Wide&Deep

假设我们有一个推荐系统,需要预测用户是否会点击某个广告。我们的特征包括用户的年龄、性别、所在城市、广告类型等。

DeepFM 的FM部分会考虑年龄与所在城市的交互效应。例如,年龄较大的用户在某些城市可能更倾向于点击某种类型的广告。

Wide & Deep 的Wide部分仅考虑年龄、性别、所在城市等特征各自对点击率的贡献,而不考虑它们之间的交互。

- DeepFM 通过FM部分捕捉特征间二阶交互效应,更好处理复杂的数据关系。

- Wide & Deep 的Wide关注每个特征一阶效应,快速学习每个特征的重要性。

这两种模型各有优势,数据集非常稀疏且需要捕捉复杂的特征交互,那么DeepFM可能更适合;数据集包含丰富的特征,并希望通过显式特征工程来捕捉特征间的交互,那么Wide & Deep可能更适合。

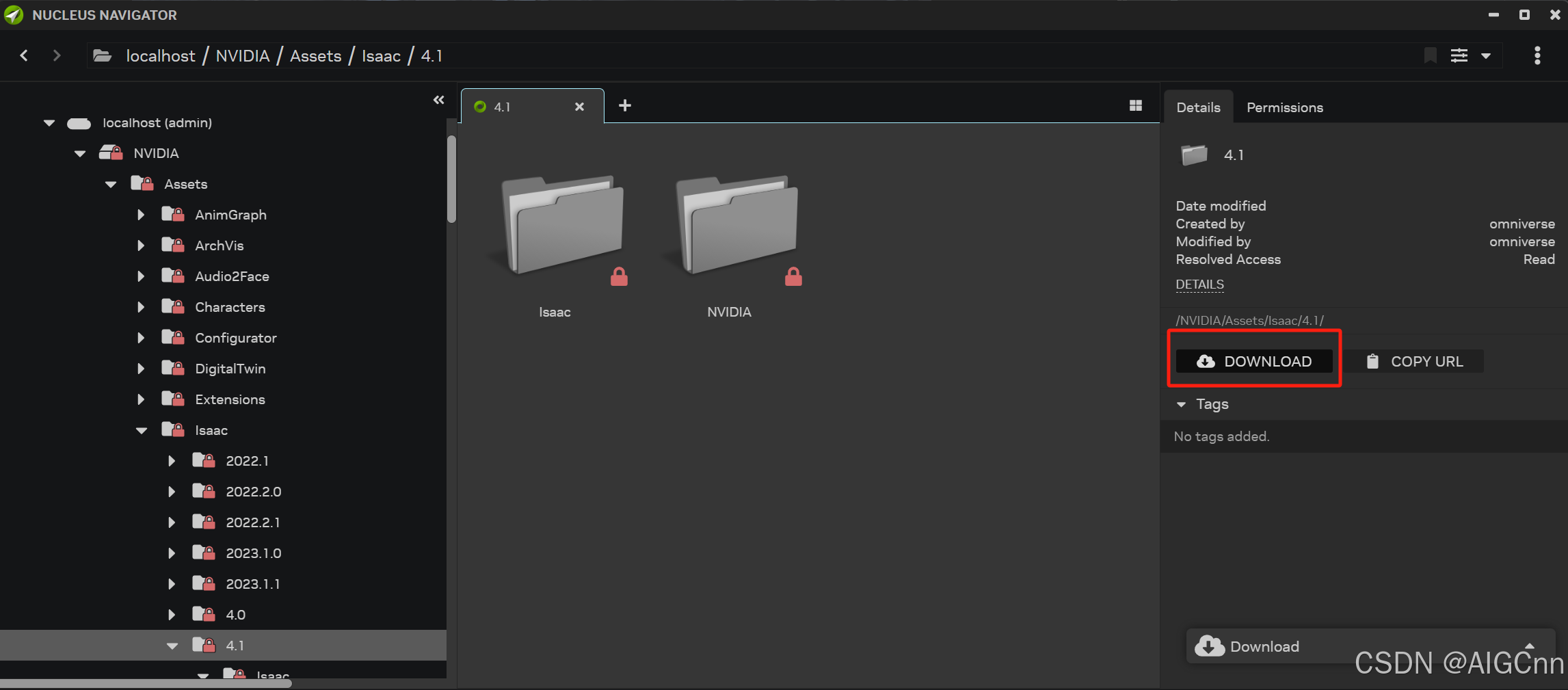

四、NeuralCF(神经网络协同过滤)

NeuralCF 结合了传统矩阵分解的优点(记忆性)和深度学习的能力(泛化能力),通过MLP代替内积操作来提高推荐准确性——新加坡国立学者提出。

NeuralCF的模型结构图 (出自论文Neural Collaborative Filtering)

最经典的是输入用户和物品id,转化成One-hot编码后经过简单的Embedding后生成稠密向量,然后将用户塔和物品塔拼接一起,送进MLP层中充分交叉,获取更高阶的特征,然后输出。

双塔模型——NeuralCF 的扩展

双塔模型是在经典 NeuralCF 基础上的扩展,其中增加了更多的特征信息,并且在每个塔内进行了更充分的特征交叉。这种扩展能够使模型更好地理解用户和物品之间的复杂关系,提高推荐的准确性。

- 多特征输入:不仅限于用户ID和物品ID,还包括其他相关的特征信息。

- 特征交叉:每个塔内的 MLP 能够处理更多特征的交叉,增强模型的学习能力。

- 独立建模:用户和物品分别在独立的塔中建模,最后通过某种方式(如点积)进行交互。

交互方式(用户Embedding-物品Embedding):

- 如果数据集较小或者特征比较简单,捕捉线性相似度,使用点积可能会更有效率,同时避免过拟合的风险。

- 如果数据集较大或者特征之间存在复杂的非线性关系,使用 MLP 进行交互可以更好地捕捉这些关系,尽管这可能会增加计算复杂度。