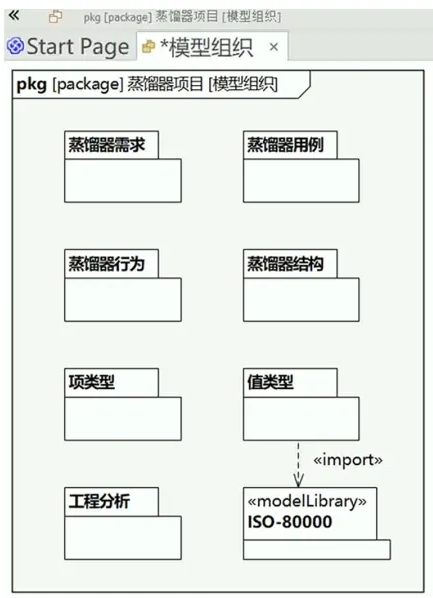

Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction

- 北大和字节团队的一篇VLM,在生成任务上,用GPT范式,声称在FID上超过了DIT,SD3和SORA。开源。

- 首先是multi-scale的VQVAE,然后是VAR transformer,如下图所示。每个尺度其实并不是GPT范式的,每个尺度都是Bert范式的,只是上一尺度的输出会拿来上采样,产生新一轮的输入。感觉这根本不能算是GPT范式,scale level的只是一种coarse to fine的bert而已。

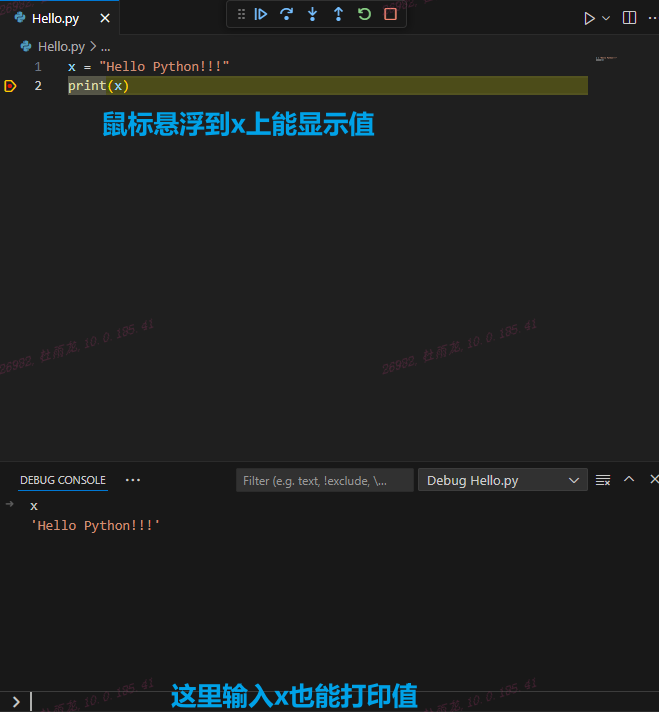

Autoregressive Image Generation without Vector Quantization

- 这是一篇 MIT,DeepMind 和 清华的论文,何凯明是作者之一,开源

- 文章提出去掉vq,把categorical cross-entropy loss训练的离散预测任务,改成由diffusion loss训练的连续任务。网络的输出接一个denoising diffusion(MLP),作为condition,然后算diffusion的损失:

- 这个diffusion就是标准的diffusion,有forward和backward,train这个diffusion model的时候顺便也把梯度传到了z,从而train到了GPT的网络。训练的时候对每一张图片采样4个不同的t来算损失,提高训练效率。noise schedule是cos shape,1000 steps。inference的时候用了100步来去噪。condition 的z通关AdaIN的方式加入到这个diffuison 网络。

- 本文不是GPT范式的,而是对MAE范式的一个拓展。文章认为GPT范式受限于casual attention,而对于图像来说bidirectional attention是更合理的。所以基于MAE范式做了一个AR的generation,用的还是自回归,一次根据自己上次预测的一些token,预测一些新的token,encoder用的是MAE的encoder,基于已知的tokens,做bidirectional 的attention,decoder则是加了一些mask和positional embedding,从这些空的token预测出新的东西来。并且,一次不仅预测一个token,而是多个。如下图所示:最终的MAR方案,其实是Figure2(b)的方案的decoder结构和Figure3 ©的方案表示的next sets-of-token prediction的结合。训练的时候和MAE差不多,mask ratio是0.7到1.0;inference的时候,用64步的自回归,mask ratio从1到0的曲线是cosine曲线。同时,被mask掉的token是完全random的,也就是说下一个预测的token是完全随机的。

- 从实验结果看,主要做的三点改进,都是有效的。第一点是把quantization+crossentropy loss改成w/o vq+diffusion loss;第二点改进是把raster order改成random order;第三点改进是把casual attention改成bidirectional attention:

- 可以看到,三点改进都使得FID下降了。

- 此外,可以看到最后多了一个CFG的变量,是因为文章引进了diffusion loss,那就可以引进classifier-free guidance,就是最后一栏的效果。不过不知道crossent是怎么引进CFG的。。

- 文章给了一些VLM范式的重要启发,包括casual/bidirectional direction的注意力,包括image patch放到1D squence的order,包括提出了新的MAR范式。

Taming Transformers for High-Resolution Image Synthesis

- 这是一篇海德堡大学的两个下属研究机构的一篇论文,开源。

- 文章的结构就很自然,就是GPT范式,把图像用VQGAN转成token,再用GPT做next token prediction,再用VQGAN的decoder解成img:

- 首先用下面的损失train一个VQ-GAN:

- train好的VQ-GAN 有了encoder,codebook和decoder,就可以用GPT来生成img了。

- 如果要实现conditioned synthesis,如果条件也是图片,可以再train一个针对条件的VQ-GAN,然后把条件的tokens放在前面,继续用GPT的方式来生成输出的token即可。

- 另一点是,生成图像的时候,如果用上全局注意力,成本太高了。因此,用了局部注意力,结合上next token prediction,整体看起来就是这样的:

- 使用1024的code book,16x16的sequence length,GPT2-medium的结构(307M parameters),12G显存。

Autoregressive image generation using residual quantization

- 这是两个韩国人发的一篇论文,虽然是22年的,但是残差量化的思想还挺有意思的。同时,这也是一个GPT范式的工作

- 本文对VQ-VAE进行了改进,VQ只有一个codebook,存在各种问题。RQ-VAE把VQ量化后的结果和量化前的特征计算的残差,也进行量化,并且和第一步的量化共享码表。

- 因此,每张图片,考虑有D层的残差,应该有TD个token,其中T是HW。直接对TD长度的sequence做transformer反而时间复杂度太高。为此,专门设计了RQ-Transformer。

- 首先就是把TD给按设计的那样求和起来,也就是说D个token求和变成最接近量化前的那个vector,这样sequence length就是T了。这一步称为spatial transformer。spatial transformer的结果就是对T个token会产生T个输出的h。第二步,就是用这T个h,各自用AR的方式,去自回归生成D个token,这一步称为depth transformer。这TD个token最终就可以用最初定义的方式去decode回图像。

- inference的时候,就很自然,给一个起始的u1,spatial transformer的输出就是v1,v1送进depth transformer,输出S11,S11再送进depth transformer,AR地继续产生S12,S13,。。。到S1D,然后求和,产生u2,u2再送进spatial transformer,产生v2,以此类推,就能够自回归地生成一张图片。如下图所示:

- 接着提出了两个配合的训练策略。就GPT训练的时候输入一般是直接把GT放进来,然后用casual mask来训练,测试才自回归嘛。如果要采样自回归,就没法一整个句子并训练,会慢很多。但这里,因为有VQ encoder,所以其实还是可以给输入加一下扰动的,就是quantize的时候,根据与code book的距离用采样的策略而不用min;然后label也同样用距离的函数来算一个soft label而非one-hot的label。从消融实验可以看到加上这两个trick,FID稍微低了一点。

Vector-quantized image modeling with improved vqgan

- 这是google search发表在ICLR2022上的工作,使用的是GPT范式,把VQGAN改进了一下。

- 首先是把VQ-GAN的encoder改成了ViT, patch size是88,一张256256的图片会切成32*32个patch,一共1024个token。不过文章声称,从CNN改成transformer,只要给更多的训练数据,不仅performance提升了,速度也加快了,很神奇,1024个token的transformer会比CNN快吗?

- 对于VQ的过程也做了几点改进,首先还是用sample而不是用最小距离选code;其次look up的时候不是直接对比encoder的输出和码表,而是用一个linear projection把256d的code映射到32d上再去look up,这提高了reconstruction的表现。第三是对encoder和codebook都做了L2归一化,使得code限制在一个球面上。

- ViT-VQGAN的损失函数如下:

Movq: Modulating quantized vectors for high-fidelity image generation

- 这是澳大利亚蒙纳士大学的几个看名字像是中国人发在NIPS2022的一篇论文。非GPT范式。

- 这里说用了spatially conditional normalization为不同位置的相同zq提供了变化,但从公式上看并没有,不同位置的相同zq,其γ,β,μ,σ,应该都是一样的,感觉有点扯淡,NIPS的审稿人什么水平,这都看不出:

- 然后是把encoder的输出分了几组channels,各自用一个共享的codebook进行量化。

- 然后是用的MaskGIT的范式,而非GPT范式,加上自己说了code可以切分,所以mask会有三个维度去random mask一些code。

- 从第一个spatially conditional normalization看起来就觉得有点扯淡,估计是篇水货。

Maskgit: Masked generative image transformer

- google research的一篇Bert范式的图像生成论文。流程如下所示,唯一的特点是,推理的时候每次迭代其实是全部预测一次,但是根据置信度进行排序,然后只保留前n部分,n随迭代次数线性增加。

Denoising autoregressive representation learning

- google deepmind的一篇ICML2024的论文

- 方法确实是GPT范式,从图片中看起来怪怪的,其实是给了两个方案。一个是直接就GPT套上去,加一个MSE Loss,不需要quantize,也不是cross entropy;另一个方案就是GPT的输出加噪,然后用diffusion的方式训练,跟Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction有点类似,但是后者是用conditional的方式加进去的,而这里是直接加噪到GPT的输出上。

- 这个看起来只是个预训练提取特征的任务,并不是为了生成。

Diffusion Models as Masked Autoencoders

- 这是Meta AI的一篇论文,提出了DiffMAE模型,用 diffusion model 来实现MAE,其实就是把MAE的decoder,改成diffusion,结构如下图所示:

- 它做的任务更多还是为了pretrain一个encoder,生成任务并没有过多介绍。

Unified-io: A unified model for vision, language, and multi-modal tasks.

- 华盛顿大学的一篇论文,开源,很牛逼,提出一个统一模型能够同时做 pose estimation,object detection,depth estimation, image generation 和一些vision-language 任务如region captioning,referring expression等。

- 其核心在于把这些任务的输入输出都建模为离散的token的序列,从而能够用一个Seq2Seq模型统一处理这些任务。其中数据格式分为四类:文本,图片,dense 如segmentation label,sparse 如object detection label。

- 在输入中,会用文本prompt指定任务类型。然后文本用SentencePiece来分词做token,dense转成图片,其中segmentation任务会先随机给类别上色,再用文本指出每种颜色代表什么类别。然后所有的图片和dense转成的图片会用VQ-GAN来量化成token,codebook size为16384。sparse则用一个额外的vocabulary来对坐标的每个维度单独编码,如一个点就有两个token,一个x一个y,一个box则有4个token,分类则用text表示。

- 模型的结构是T5,是transformer的encoder-decoder结构。此外,对图像做了2-d相对位置编码和1d绝对值位置编码,两种都有。

Conditional Image Generation with PixelCNN Decoders

- 这是google deepmind 2016年的一篇文章,改进了PixelCNN。这里就和PixelCNN一起讲。PixelCNN也是一个自回归模型,它一次前向只预测一个像素,因此需要重复H*W次前向来生成一张图片:

- 文章的改进是在卷积层的激活函数中加了门控和条件向量:

Generative Pretraining from Pixels

- 这篇文章其实做的是MAE差不多的事情,是用GPT和Bert的预训练模式来预训练一个图像模型,并以提供一个好的image encoder。不过这里没有tokenizer,也没有分patch,而仅仅只是把图片降采样成32x32,然后直接reshape成1D,也就是说一个token就是一个像素。

- 最终做分类任务的时候用的是最后一层的avg pooling作为特征。从下面的实验结果可以看到,GPT的范式提取的特征,总体来说比Bert范式要好一些

Generating Diverse High-Fidelity Images with VQ-VAE-2

- 这是deepmind在2019年发表在NIPS上的一篇论文,用的是PixelCNN来生成图像,不过有多尺度的VQ,开源,可以参考:

- 这里可以看到,有两个encoder和两个decoder。有点复杂,算法如下:

- 两个encoder的输入都包含输入的图片,产生低分辨率特征的encoder仅以图片为输入,而产生高分辨率特征的encoder以量化后的低分辨率特征和图片同时作为输入。decoder则以量化后的两个特征图为输入,重建图像。

- VQ-VAE2训练完成后,要额外train 一个PixelCNN和一个条件PixelCNN来生成图像,PixelCNN就负责采样生成低分辨率特征图,条件PixelCNN负责以低分辨率特征图为条件,生成高分辨率特征图,再过第一阶段train的decoder生成图片。

Unified-IO 2: Scaling Autoregressive Multimodal Models with Vision, Language, Audio, and Action

- 这是华盛顿大学的第二版Unified-IO,发表在CVPR2024,开源

- 网络结构如下图所示,仍然沿用第一版的T5 transformer模型。不过引进了一些其它的trick,包括RoPE, QK Norm,Scaled Cosine Attention,能够提高训练稳定性。

- 这里的dynamic packing是一种加速训练的方式,把序列长度短的sample用mask放到同一个sequence里面去作为一个sample,从而对齐batch。

An Image is Worth 32 Tokens for Reconstruction and Generation

- 字节的一篇2024年放arxiv的文章,不知道投哪,挺有意思的,提出了一个tokenize的新范式,开源。

- 原先tokenize一般就是对图像转成2D的特征图,切patch得到每个patch一个token,总共是hw个token,展品送进一维序列模型。这篇论文提出开源用ViT来把图像编码成1D的token序列,而且仅需要32个。其实方法很简单,就是往ViT的encoder里面,额外送进32个latent token,这32个token对应的输出开源认为就提取了图像的信息,直接拿这32个token做reconstrucion即可。而reconstruction的方法也与之相对应,要用mask token对应的输出作为输出,如下图所示:

- 在图像生成任务上的做法也很简单,直接在它的TiTok空间上自回归就行,用的是MaskGIT的范式,自回归生成完整的32个token后,再用事先train好的decoder来还原成图像:

- 此外,TiTok还有一种训练方式,原本的训练方式是可以的,但是新训练方式更好。新训练方式分为两阶段训TiTok,第一阶段直接拿train好的VQ-GAN的decoder来作为decoder;第二阶段再fix encoder和codebook,finetune decoder。感觉这部分内容说得不是很详细,具体得看看代码。