人工智能咨询培训老师叶梓 转载标明出处

多语言模型如mBERT和XLM-R通过零样本或少样本跨语言迁移极大地推动了低资源语言的NLP应用。但这些模型由于容量限制,对低资源语言和未见语言的迁移性能并不理想。为了解决这一问题,来自德国达姆施塔特工业大学、剑桥大学和DeepMind的研究者们提出了一种名为MAD-X的适配器框架,旨在通过学习模块化的语言和任务表示,实现对任意任务和语言的高效迁移。

论文链接:https://arxiv.org/pdf/2005.00052

代码链接:https://adapterhub.ml/

方法

在跨语言迁移学习中,标准的迁移设置通常涉及使用大型多语言模型(如mBERT或XLM-R)先在源语言的标记数据上进行微调,然后直接应用于目标语言的推理。这种方法的缺点是多语言初始化需要平衡多种语言,导致模型在推理时无法针对特定语言表现出色。

为了改善这一问题,提出了一种简单的方法,即在源语言的特定任务微调之前,先通过遮蔽语言模型(MLM)在目标语言的未标记数据上微调预训练的多语言模型。虽然这种方法使得模型无法在多个目标语言上进行评估,因为它会偏向于特定目标语言,但如果我们只关心特定(即固定的)目标语言的性能,这种方法可能更可取。

实验发现,目标语言的适应性迁移学习相较于标准设置能提高跨语言迁移性能,且不会导致预训练模型中已有的多语言知识发生灾难性遗忘。但这种简单的适应方法仍继承了预训练多语言模型和标准迁移设置的基本限制:模型的有限容量阻碍了对低资源和未见语言的有效适应。另外,对整个模型进行微调在许多任务或语言上并不具有很好的扩展性。

MAD-X框架旨在解决现有预训练多语言模型在迁移到其他语言时的不足。该框架由三种类型的适配器组成:语言适配器、任务适配器和可逆适配器。适配器在训练时保持预训练多语言模型的参数不变,使得学习语言和任务特定的转换变得模块化且参数高效。

语言适配器是为了学习特定语言的转换而设计的。它们采用了Pfeiffer等人在2020年提出的高效适配器架构,该架构通过简单的下投影(down-projection)和上投影(up-projection)以及残差连接来定义适配器的内部结构。如图1所示,语言适配器被添加到每个Transformer层,并且在训练时,通过遮蔽语言模型(MLM)在未标记的目标语言数据上进行训练,以学习使预训练多语言模型更适合特定语言的转换。

任务适配器与语言适配器具有相同的架构,它们被堆叠在语言适配器之上,接收来自语言适配器的输出以及Transformer前馈层的残差。任务适配器是唯一在下游任务(如NER)训练时更新的参数,旨在捕获特定于任务但能跨语言泛化的知识。

可逆适配器是针对预训练多语言模型在低资源语言和未见语言上性能不足的问题提出的解决方案。这些适配器被堆叠在嵌入层的顶部,而其逆适配器位于输出嵌入层之前。如图2所示,可逆适配器通过将输入嵌入向量分割并转换,实现了输入和输出表示的适应。这种设计允许我们利用同一组参数来适应输入和输出表示,这对于避免在特定任务微调中丢弃的输出嵌入过度拟合预训练任务至关重要。

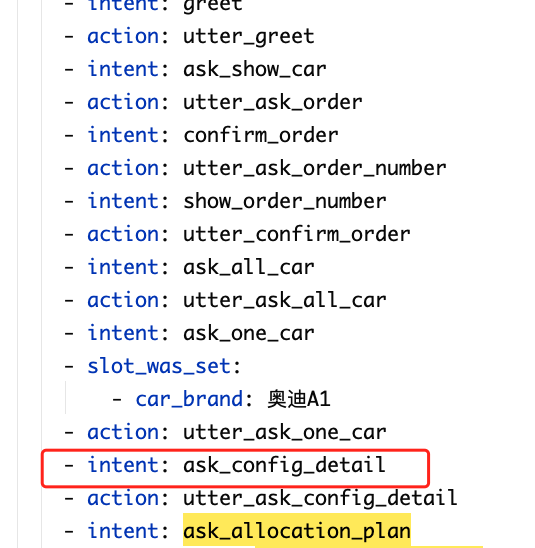

通过通过图1 示例,展示了如何使用MAD-X框架进行零样本跨语言迁移。以英语(En)作为源语言和克丘亚语(Qu)作为目标语言,首先对可逆适配器AEnInv和AQuInv以及语言适配器AEnLang和AQuLang进行预训练。然后在英语NER训练集上训练NER任务适配器ANER Task。在训练过程中,嵌入通过AEnInv传递,并且在模型的每一层,数据首先通过固定的AEnLang,然后进入NER适配器ANER Task。在零样本推理中,将英语的可逆和语言适配器AEnInv和AEnLang替换为其克丘亚对应物AQuInv和AQuLang,而数据仍然通过NER任务适配器ANER Task传递。

想要掌握如何将大模型的力量发挥到极致吗?叶老师带您深入了解 Llama Factory —— 一款革命性的大模型微调工具。9月22日晚,实战专家1小时讲解让您轻松上手,学习如何使用 Llama Factory 微调模型。

加助理微信提供直播链接:amliy007,29.9元即可参加线上直播分享,叶老师亲自指导,互动沟通,全面掌握Llama Factory,关注享粉丝福利,限时免费CSDN听直播后的录播讲解。

LLaMA Factory 支持多种预训练模型和微调算法。它提供灵活的运算精度和优化算法选择,以及丰富的实验监控工具。开源特性和社区支持使其易于使用,适合各类用户快速提升模型性能。

实验

数据集和语言选择:

NER任务:使用了WikiANN数据集,该数据集最初由Rahimi等人在2019年进行划分,包括训练集、开发集和测试集。这个数据集覆盖了大量语言,是评估跨语言能力的理想选择。

QA任务:采用了XQuAD数据集,这是著名的SQuAD数据集的跨语言版本,由Artetxe等人在2020年提出。XQuAD提供了一个在多种语言上评估问答系统的机会。

CCR任务:使用了XCOPA数据集,这是COPA数据集的跨语言版本,由Ponti等人在2020年提出。XCOPA专注于因果推理,为评估模型的常识推理能力提供了平台。

研究者们精心挑选了一组具有代表性的语言,以确保评估结果的全面性和多样性。这些语言的选择基于几个标准:不同大小的维基百科文章(数据可用性)、是否包含在预训练的多语言模型中(如mBERT和XLM-R),以及语言类型的多样性。

表格2展示了从每种源语言迁移到所有16种目标语言时的NER任务F1得分的平均值。这些结果不仅包括了在多语言预训练中见过的语言,也包括了未见过的,提供了对模型跨语言迁移能力的全面评估。

研究者们将MAD-X框架与当前最先进的跨语言迁移模型XLM-R进行了比较。XLM-R是一个基于Transformer的模型,预训练了100种语言,是评估跨语言迁移能力的重要基准。

除了标准的XLM-R模型,研究者们还考虑了两种基线:在源语言数据上进行MLM微调的XLM-R(XLM-RBase MLM-SRC)和在目标语言数据上进行MLM微调的XLM-R(XLM-RBase MLM-TRG)。这些基线为评估MAD-X框架提供了重要的参照。

在MAD-X框架的实验中,主要使用XLM-R Base架构。研究者们评估了完整的MAD-X框架,以及没有可逆适配器(-INV)和没有语言适配器及可逆适配器(-LAD -INV)的变体。

使用Transformers库进行所有实验。通过MLM在未标记数据上进行微调,训练步骤为250,000步,批大小为64,XLM-R和适配器的学习率分别为5e-5和1e-4。

对于NER任务,对每种源语言-目标语言组合进行了五次微调运行,选择验证性能最佳的检查点进行评估。

对于QA任务,在英语SQuAD训练集上进行了三次微调运行,评估了所有XQuAD目标语言,并报告了平均F1和精确匹配(EM)得分。

对于CCR任务,在相应的英语训练集上进行了三次微调运行,评估了所有XCOPA目标语言,并报告了准确率得分。

通过这些详细的实验设置和结果分析,研究者们展示了MAD-X框架在跨语言迁移学习任务中的有效性和优越性,特别是在处理低资源语言和未见语言时的性能提升。

![[AI]从零开始的so-vits-svc webui部署教程(小白向)](https://i-blog.csdnimg.cn/direct/a50225e1883342acada23cbb1a401d9b.png)