DataWhale AI夏令营-《李宏毅深度学习教程》笔记-task2

- 第五章 循环神经网络

- 5.1 独热编码

- 5.2 RNN架构

- 5.3 其他RNN

- 5.3.1 Elman 网络 &Jordan 网络

- 5.3.2 双向循环神经网络

第五章 循环神经网络

循环神经网络RNN,RNN在处理序列数据和时间依赖性强的问题上具有独特的优势,尤其是在自然语言处理和时间序列预测领域。

由图可知RNN的输入来自于上一层的输出结果和当前层的输入,所以RNN常被用来预测金融市场、气象等领域,通过分析过去的数据序列预测未来的趋势。

但是这种RNN的结果有很大的缺陷就是,当进行长序列预测时,RNN可能会由于序列较长遗忘了之前某些重要信息,导致预测精度下降。

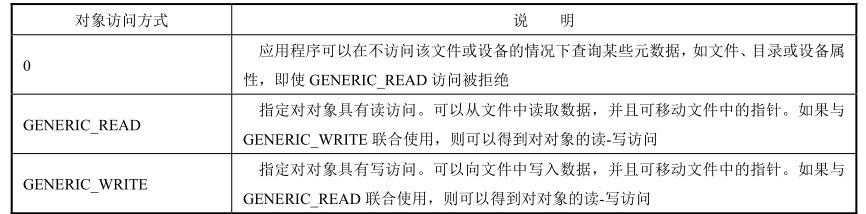

为了解决RNN长序列遗忘问题,长短记忆网络LSTM被开发出来,通过引入三个“门”机制来管理记忆的存储、更新和删除,这使得它能够更有效地捕捉长期依赖关系。这三个门分别是输入门、遗忘门和输出门,如下图,it作为输入门;ft作为遗忘门;ot作输出门。

除了LSTM之外,Transformer架构也很好解决了RNN所面临的长期依赖和计算效率问题,并且Transformer架构目前也被广泛的应用于大模型领域,也取得了很好的效果。

Transformer架构的核心包括以下三个方面:

- 自注意力机制(Self-Attention): 自注意力机制是 Transformer的核心。它通过计算输入序列中每个元素与其他所有元素之间的相似性(注意力权重),并根据这些权重加权和更新每个元素的表示。这样,模型能够捕捉到序列中元素之间的依赖关系,而不受元素位置的限制。

- 位置编码(Positional Encoding): 由于 Transformer模型不依赖序列顺序,它需要一种方法来表示输入序列中元素的位置。位置编码是一种向量,它被添加到输入的嵌入向量中,用来保留序列的位置信息。

- 多头注意力机制(Multi-Head Attention):多头注意力机制通过将自注意力机制应用于多个不同的“头”,从不同的子空间中学习信息。这样可以捕捉到更多样化的依赖关系,并提高模型的表达能力。

5.1 独热编码

回归本书正题,独热编码(one-hot)编码,常被用在自然语言处理领域多标签多分类等任务中。编码形式如图所示,即对应维度标签为1,其余为0。

5.2 RNN架构

其实前面提到过了RNN架构,书中给出的例子如下图,其实也就是之前提到过的每一层的输出不知取决于当前层的输入还有上一层的输出有关,书中给出的解释是,上一层的输出结果会储存在记忆层中,这时候当前隐藏层预测结果会同时考虑当前的输入与记忆层的内容。

5.3 其他RNN

5.3.1 Elman 网络 &Jordan 网络

Jordan 网络,Jordan 网络存的是整个网络输出的值,它把输出值在下一个时间点在读进来,把输出存到记忆元里。Elman网络没有目标,很难控制说它能学到什么隐藏层信息(学到什么放到记忆元里),但是Jordan网络是有目标,比较很清楚记忆元存储的东西。

5.3.2 双向循环神经网络

循环神经网络还可以是双向,即双向循环神经网络(Bidirectional Recurrent Neural Network,Bi-RNN)。如图,假设句子里的每一个单词用 xt 表示,其是先读 xt,再读 xt+1、xt+2。但其读取方向也可以是反过来的,它可以先读xt+2,再读xt+1、xt。我们可以同时训练一个正向的循环神经网络,又可以训练一个逆向的循环神经网络,然后把这两个循环神经网络的隐藏层拿出来,都接给一个输出层得到最后的yt。所以把正向的网络在输入xt 的时候跟逆向的网络在输入 xt 时,都丢到输出层产生 yt,产生 yt+1,yt+2,以此类推。

双向循环神经网络的好处是,神经元产生输出的时候,它看的范围是比较广的。