一、介绍

VGen可以根据输入的文本、图像、指定的运动、指定的主体,甚至人类提供的反馈信号生成高质量的视频。它还提供了各类常用的视频生成模型工具,例如可视化、采样、训练、推理、使用图像和视频的联合训练,加速等各类工具和技术。

"VGen" 模型,特别是阿里云推出的 I2VGen-XL,是一个基于扩散模型的视频生成系统。该系统提供了强大的代码库和视频生成模型,旨在通过输入文本、图像、所需运动、主题甚至反馈信号来生成高质量的视频。

I2VGen-XL采用级联扩散模型进行高质量图像到视频的合成。该方法通过解耦语义准确性和清晰度等因素,确保生成视频的卓越性能。

二、部署流程

基础环境:

系统:Ubuntu系统,

显卡:3090,

显存:24G,cuda11.3

磁盘大于100G(本人搭建环境所用系统盘为50G,数据盘50G)

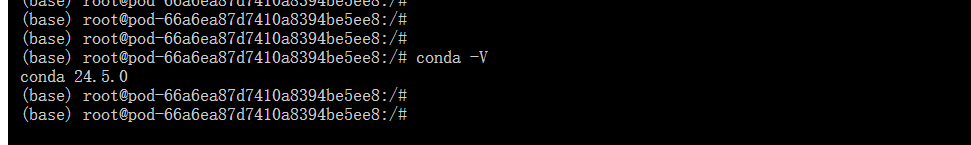

1. 查看系统是否有Miniconda3的虚拟环境

conda -V

如果输入命令没有显示Conda版本号,则需要安装。

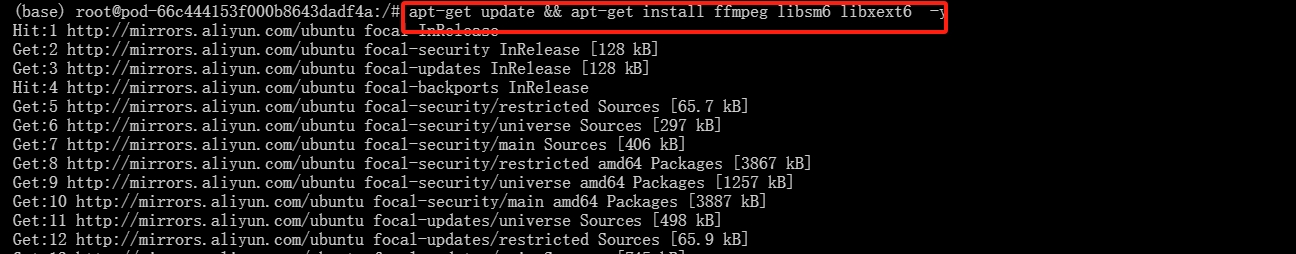

2. 更新系统命令

输入下列命令将系统更新及系统下载

apt-get update && apt-get install ffmpeg libsm6 libxext6 -y

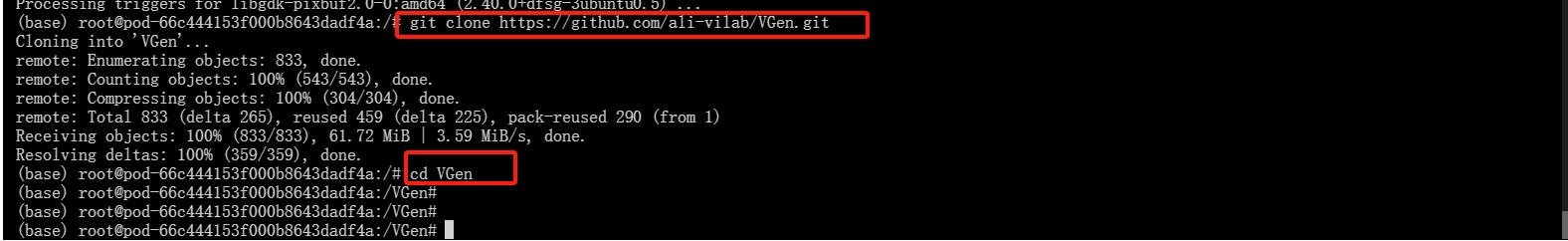

3. 下载模型

输入下列命令对VGen模型进行下载同时进入项目中

git clone https://github.com/ali-vilab/VGen.git

cd VGen

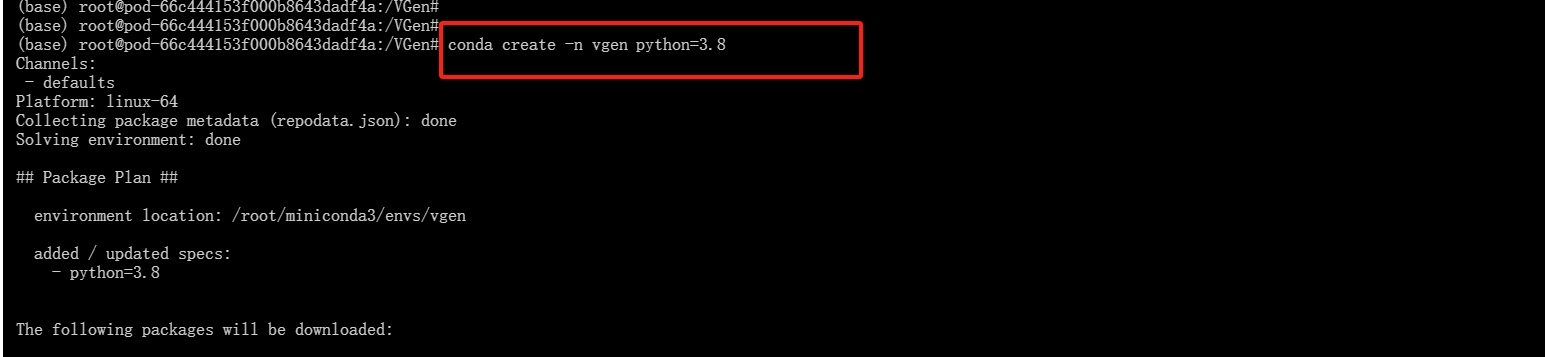

4. 创建虚拟Python环境

- 创建一个名为"vgen"的虚拟镜像,python版本为3.10

conda create -n vgen python=3.10

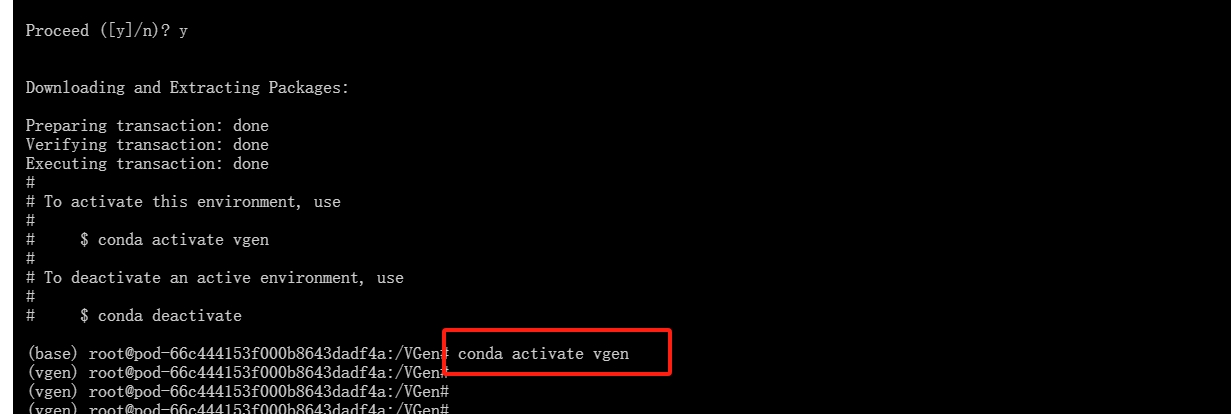

- 激活“vgen"虚拟环境

conda activate vgen

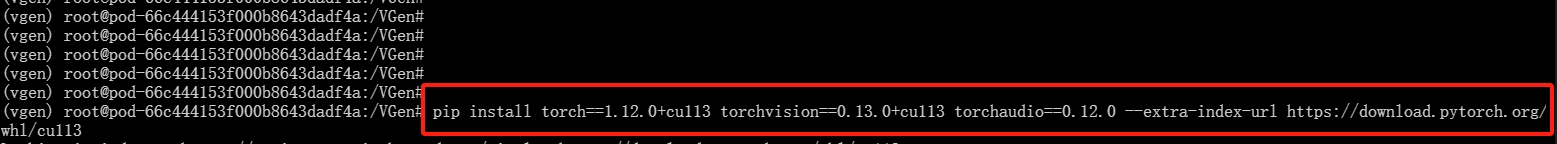

5. 安装pytorch

- 输入下列命令对pytorch进行安装

pip install torch==1.12.0+cu113 torchvision==0.13.0+cu113 torchaudio==0.12.0 --extra-index-url https://download.pytorch.org/whl/cu113

(时间会很长需要耐心等待)

6. 下载模型依赖包

进入模型文件并下载模型依赖包

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

系统下载过程中,切勿有任何操作,直到出现“Successfully installed......”开头则安装结束并且成功。

7. 添加模型

使用并运行I2VGen-XL模型

- 首先进入下载此模型(本人下载到数据盘新建model文件夹放入)

git lfs install

git clone https://huggingface.co/damo-vilab/i2vgen-xl

如果上述命令不可用,则使用:(推荐)

!pip install modelscope

from modelscope.hub.snapshot_download import snapshot_download

model_dir = snapshot_download('damo/I2VGen-XL', cache_dir='models/', revision='v1.0.0')

- 再运行下列命令:

python inference.py --cfg configs/i2vgen_xl_infer.yaml test_list_path data/test_list_for_i2vgen.txt test_model models/i2vgen_xl_00854500.pth

表示输入图像路径及其相应的标题。具体格式请参考演示文件中的建议。 是用于加载模型的路径。几分钟后,您可以从目录中检索要创建的高清视频。

三、界面演示

在本地运行 gradio 应用程序,使用下列命令运行项目呈现模型的成功界面

python3 gradio_app.py