最近已有不少大厂都在秋招宣讲,也有一些已在 Offer 发放阶段了。

节前,我们邀请了一些互联网大厂朋友、今年参加社招和校招面试的同学。

针对新手如何入门算法岗、该如何准备面试攻略、面试常考点、大模型技术趋势、算法项目落地经验分享等热门话题进行了深入的讨论。

今天分享一位朋友的上岸之旅,最终拿下快手大模型算法岗:

这段时间面了很多算法和大模型的岗位,能走到最后一轮的寥寥无几,几乎全军覆没,感谢快手给了我上岸的机会,太幸运了!

算法岗真的要好好研究明白才行,问的内容全又细,面试官几乎全程直接提问题,没有什么闲聊内容。

分享最近一段时间面试字节、小红书、快手等大厂的大模型&算法岗面试题,大部分会经常提及,童鞋们可以对照查漏补缺奥!

面试题

- 目前主流的开源模型体系有哪些?

- 如何让大模型处理更长的文本?

- 什么情况下用Bert模型,什么情况下用LLaMA、ChatGLM类大模型,咋选?

- LLMs输入句子长度理论上可以无限长吗?

- 什么是LLMs复读机问题?

- 为什么会出现LLMs复读机问题?

- 如何缓解LLMs复读机问题?

- 为何现在的大部分是Decoder only结构?

- 涌现能力是啥原因?

- prefix LM和causal LM的区别是什么?

- 请简述什么是大模型,以及它与传统模型的主要区别是什么?

- 谈谈你对 Transformer 模型的理解,以及它在自然语言处理中的应用。

- 你如何评估大模型的性能?有哪些常用的评估指标?

- 请描述一下你如何对大模型进行优化,以提高其性能和效率。

- 你是否有过使用或开发大模型的经验?请分享一个具体的案例。

- 面对大模型训练和推理所需的庞大计算资源,你有什么解决方案或建议?

- 请简述 Transformer 的基本结构和工作原理。

- 多头自注意力机制的作用是什么?

- 为什么Transformer使用位置编码(Positional Encoding)?

- 如何优化 Transformer 模型的性能?

- Transformer 在自然语言处理中有何应用?

- 谈谈你对 Transformer 未来发展的看法?

1、目前主流的开源模型体系有哪些?

- Transformer体系:由Google提出的Transformer 模型及其变体,如BERT、GPT 等。

- PyTorch Lightning:一个基于PyTorch的轻量级深度学习框架,用于快速原型设计和实验。

- TensorFlow Model Garden:TensorFlow官方提供的一系列预训练模型和模型架构。

- Hugging Face Transformers:一个流行的开源库,提供了大量预训练模型和工具,用于NLP 任务。

2、prefix LM 和 causal LM 区别是什么?

prefix LM (前缀语言模型):在输入序列的开头添加一个可学习的任务相关的前缀,然后使用这个前缀

和输入序列一起生成输出。这种方法可以引导模型生成适应特定任务的输出。

causal LM (因果语言模型):也称为自回归语言模型,它根据之前生成的 token 预测下一个token。在

生成文本时,模型只能根据已经生成的部分生成后续部分,不能访问未来的信息。

3、涌现能力是啥原因?

涌现能力 (Emergent Ability) 是指模型在训练过程中突然表现出的新的、之前未曾预料到的能力。这种现象通常发生在大型模型中,原因是大型模型具有更高的表示能力和更多的参数,可以更好地捕捉数据中的模式和关联。

随着模型规模的增加,它们能够自动学习到更复杂、更抽象的概念和规律,从而展现出涌现能力。

4、大模型LLM的架构介绍?

大模型LLM(Large Language Models) 通常采用基于Transformer的架构。Transformer模型由多个编码器或解码器层组成,每个层包含多头自注意力机制和前馈神经网络。这些层可以并行处理输入序列中的所有位置,捕获长距离依赖关系。大模型通常具有数十亿甚至数千亿个参数,可以处理大量的文本数据,并在各种NLP任务中表现出色。

前馈神经网络 (Feedforward Neural Network) 是一种最基础的神经网络类型,它的信息流动是单向的,从输入层经过一个或多个隐藏层,最终到达输出层。在前馈神经网络中,神经元之间的连接不会形成闭环,这意味着信号在前向传播过程中不会回溯。前馈神经网络的基本组成单元是神经元,每个神经元都会对输入信号进行加权求和,然后通过一个激活函数产生输出。激活函数通常是非线性的,它决定了神经元的输出是否应该被激活,从而允许网络学习复杂和非线性的函数。

前馈神经网络在模式识别、函数逼近、分类、回归等多个领域都有应用。例如,在图像识别任务中,网络的输入层节点可能对应于图像的像素值,而输出层节点可能代表不同类别的概率分布。

训练前馈神经网络通常涉及反向传播 (Backpropagation) 算法,这是一种有效的学习算法,通过计算输出层的误差,并将这些误差信号沿网络反向传播,以调整连接权重。通过多次迭代这个过程,网络可以逐渐学习如何减少输出误差,从而实现对输入数据的正确分类或回归。

在设计和训练前馈神经网络时,需要考虑多个因素,包括网络的层数、每层的神经元数目、激活函数的选择、学习速率、正则化策略等,这些都对网络的性能有重要影响。

5、目前比较受欢迎的开源大模型有哪些?

GPT系列:由OpenAl开发的生成式预训练模型,如 GPT-3。

BERT系列:由Google开发的转换式预训练模型,如BERT、RoBERTa等。

T5系列:由Google开发的基于Transformer的编码器-解码器模型,如T5、mT5等。

6、目前大模型模型结构都有哪些?

- Transformer:基于自注意力机制的模型,包括编码器、解码器和编码器-解码器结构。

- GPT系列:基于自注意力机制的生成式预训练模型,采用解码器结构。

- BERT系列:基于自注意力机制的转换式预训练模型,采用编码器结构。

- T5系列:基于Transformer的编码器-解码器模型。

7、prefix LM 和 causal LM、encoder-decoder 区别及各自有什么优缺点?

prefix LM:通过在输入序列前添加可学习的任务相关前缀,引导模型生成适应特定任务的输 出。优点是可以减少对预训练模型参数的修改,降低过拟合风险;缺点是可能受到前缀表示长度的限制,无法充分捕捉任务相关的信息。

causal LM:根据之前生成的 token预测下一个 token, 可以生成连贯的文本。优点是可以生成灵 活的文本,适应各种生成任务;缺点是无法访问未来的信息,可能生成不一致或有误的内容。

encoder-decoder:由编码器和解码器组成,编码器将输入序列编码为固定长度的向量,解码器 根据编码器的输出生成输出序列。优点是可以处理输入和输出序列不同长度的任务,如机器翻译;缺点是模型结构较为复杂,训练和推理计算量较大。

8、模型幻觉是什么?业内解决方案是什么?

模型幻觉是指模型在生成文本时产生的不准确、无关或虚构的信息。这通常发生在模型在缺乏足够信息的情况下进行推理或生成时。业内的解决方案包括:

- 使用更多的数据和更高质量的训练数据来提高模型的泛化和准确性。

- 引入外部知识源,如知识库或事实检查工具,以提供额外的信息和支持。

- 强化模型的推理能力和逻辑推理,使其能够更好地处理复杂问题和避免幻觉。

9、大模型的Tokenizer的实现方法及原理?

大模型的Tokenizer通常使用字节对编码 (Byte-Pair Encoding,BPE) 算法。BPE算法通过迭代地将最频繁出现的字节对合并成新的符号,来构建一个词汇表。在训练过程中,模型会学习这些符号的嵌入表示。Tokenizer将输入文本分割成符号序列,然后将其转换为模型可以处理的数字表示。

这种方法可以有效地处理大量文本数据,并减少词汇表的规模。

10、ChatGLM3的词表实现方法?

ChatGLM3 使用了一种改进的词表实现方法。它首先使用字节对编码 (BPE) 算法构建一个基本的词表,然后在训练过程中通过不断更新词表来引入新的词汇。具体来说,ChatGLM3 在训练 过程中会根据输入数据动态地合并出现频率较高的字节对,从而形成新的词汇。这样可以有效地处理大量文本数据,并减少词汇表的规模。

同时,ChatGLM3 还使用了一种特殊的词表分割方法,将词表分为多个片段,并在训练过程中逐步更新这些片段,以提高模型的泛化能力和适应性。

11、GPT3、LLAMA、ChatGLM 的 Layer Normalization 的区别是什么?各自的优缺点是什么?

GPT3:采用了Post-Layer Normalization (后标准化)的结构,即先进行自注意力或前馈神经网络的计算,然后进行Layer Normalization。这种结构有助于稳定训练过程,提高模型性能。

LLAMA:采用了Pre-Layer Normalization (前标准化)的结构,即先进行Layer Normalization,然后进行自注意力或前馈神经网络的计算。这种结构有助于提高模型的泛化能力和鲁棒性。

ChatGLM:采用了Post-Layer Normalization的结构,类似于GPT3。这种结构可以提高模型的性能和稳定性。

12、大模型常用的激活函数有哪些?

ReLU(Rectified Linear Unit):一种简单的激活函数,可以解决梯度消失问题,加快训练速度。

GeLU(Gaussian Error Linear Unit):一种改进的ReLU函数,可以提供更好的性能和泛化能力。

Swish:一种自门控激活函数,可以提供非线性变换,并具有平滑和非单调的特性。

13、多查询注意力与群查询注意力是否了解?区别是什么?

Multi-query Attention 和 Grouped-query Attention 是两种不同的注意力机制变种,用于改进和扩展传统的自注意力机制。Multi-query Attention:在Multi-query Attention中,每个查询可以与多个键值对进行交互,从而 捕捉更多的上下文信息。这种机制可以提高模型的表达能力和性能,特别是在处理长序列或复杂关系时。

Grouped-query Attention:在Grouped-query Attention中,查询被分成多个组,每个组内的查询与对应的键值对进行交互。这种机制可以减少计算复杂度,提高效率,同时仍然保持较好的性能。

14、多模态大模型是否有接触?落地案例?

多模态大模型是指可以处理和理解多种模态数据(如文本、图像、声音等)的模型。落地案例,例如:

OpenAI的DALL-E和GPT-3:DALL-E是一个可以生成图像的模型,而GPT-3可以处理和理解文本。两者结合可以实现基于文本描述生成图像的功能。

Google的Multimodal Transformer:这是一个可以同时处理文本和图像的模型,用于各种多模态任务,如图像字幕生成、视觉问答等。

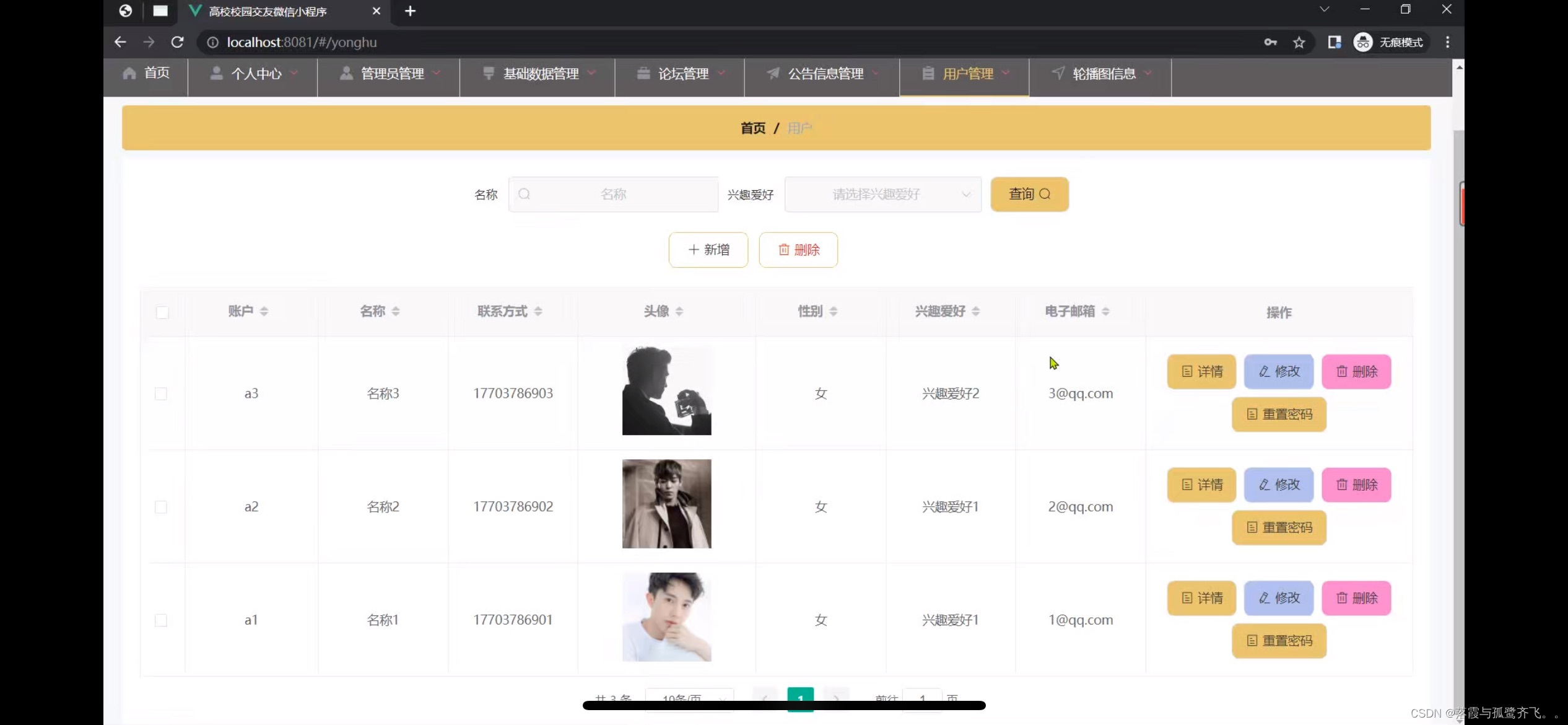

这份《大模型算法岗常见面试题100道》已经上传CSDN,还有完整版的大模型 AI 学习资料,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

PDF书籍: 完整版本链接获取

👉[CSDN大礼包🎁:《

大模型算法岗常见面试题100道》免费分享(安全链接,放心点击)]👈