研究背景

现实世界图像超分辨率(Real-World Super-Resolution, Real-SR)技术,作为提升图像清晰度的关键技术,正变得越来越重要。然而,如何准确评估Real-SR方法的性能,一直是该领域的一大挑战。目前的评估方式往往通过从一个大退化空间中随机选取的一小组退化来构建测试集,并计算出小测试集上的平均性能来对模型进行评估,这样的方式往往无法全面了解 real-SR模型的整体性能,还可能会产生不一致且具有误导性的结果。为了解决这个问题,我们提出了SEAL--一个real-SR系统评估框架。

SEAL通过对退化空间进行聚类,找到了一组具有代表性的退化样本,用于构建大尺度测试集。进一步,SEAL提出了一个从粗到细(coarse-to-fine)的评估协议,以衡量真实SR方法在测试集上的分布和相对性能。该协议包含两个新的系统性评估指标:接受率(AR)和相对性能比(RPR)。在SEAL的评估下,我们对现有的real-SR方法进行了基准测试,获得了系统性的对比结果和新的观测现象。

本文获得了 ICLR 2024 Spotlight, 点击底部“阅读原文”即可获取论文全文!

回顾真实超分辨率模型的评估策略

为了评估Real-SR 方法的性能,现有的工作直接根据 IQA 指标(如 PSNR)计算随机抽样的小尺寸测试集上的平均性能[1][2]。然而,我们发现这种评估方案存在很严重的缺陷。由于退化空间的广阔性,随机选择的小测试集无法可靠地表示退化空间,可能会导致评估结果出现严重偏差和随机性。此外,目前的评估策略不足以全面的 real-SR 方法在整个退化空间中的泛化性,因为它们通常是对所有测试样本的量化结果进行平均,而无法判断在哪些退化任务上取得了好的性能。

如图 1 (b)所示,一种方法可能在 60% 的退化类型上优于另一种方法,但它在一个小的测试集中可能无法获得更高的平均 PSNR 值。平均分不能充分体现整体性能和分布。此外,如果我们的目标是提高平均分数,那么我们可以只专注于提高简单的退化任务(如小噪声或模糊)的性能,但这会对困难的退化任务产生不利影响。这将违背我们的主要目标。相反,一旦我们在简单的情况下取得了令人满意的结果,我们就应该把重点转向具有挑战性的情况,以提高整体性能[3]。综上,我们需要一个能够全面评估真实 SR 方法性能的新框架。

通过以上分析,我们发现当前的真实超分辨率模型评估面临着如下挑战:

(1)由于退化空间包含海量的退化任务,如何评估它们的整体性能?直接对所有退化进行测试显然是不可行的,如何选择代表性的退化任务,进而构建大尺度的测试集?

(2)在大尺度的测试集上,传统的使用均值来代表模型的性能难以反映模型的整体性能,如何设计新的指标来反映模型在大尺度测试集上的综合性能?

SEAL:一个大尺度系统性评估框架

我们提出了SEAL(Systematic Evaluation of Real-World Super-Resolution)框架来解决上述挑战。通过退化聚类表征技术,SEAL能够将复杂的退化空间进行稀疏化,形成具有代表性的退化任务,为Real-SR方法的大尺度系统性评估提供了新的解决路径。

如下图所示,我们提出的评估框架包括基于聚类的退化空间表示方法和一套基于代表性退化任务的系统性评价指标。具体来说,我们将退化空间划分为 K 类,并使用类中心的退化参数创构建了K 个退化任务数据集。为了对大尺度的测试集上的性能提供参考,我们采用了经典的real-SR模型和 SOTA 的 real-SR模型作为及格线(Acceptance Line)和优秀线(Excellence Line)。待测试的真实 SR 模型在 K 个测试数据集上的分布式性能将与及格线和优秀线进行比较,并通过一系列指标进行评估,包括 AR(及格率)、RPR(相对性能比)、RPR_A(可接受退化任务的平均 RPR)和 RPR_U(不可接受退化任务的平均 RPR)。

退化空间的生成(Generating the degradation space)在真实场景超分的研究中,现有的工作一般采用多个退化的组合来模拟真实场景退化过程[1][2],因此,退化空间对高分辨率图像(HR)的作用过程可以表示为:

假设有 s 种退化类型(如模糊、重采样、噪声和压缩),每种类型包含 个离散的退化级别。总退化任务的个数应为。如果 , ,那么退化空间中包含的任务将达到,这已经是一个天文数字了。显然,从如此巨大的空间中随机抽取有限数量的退化来构建一个只包含 100 张图像的测试集并不能充分代表整个空间,这将不可避免地导致不一致和潜在误导性的结果。

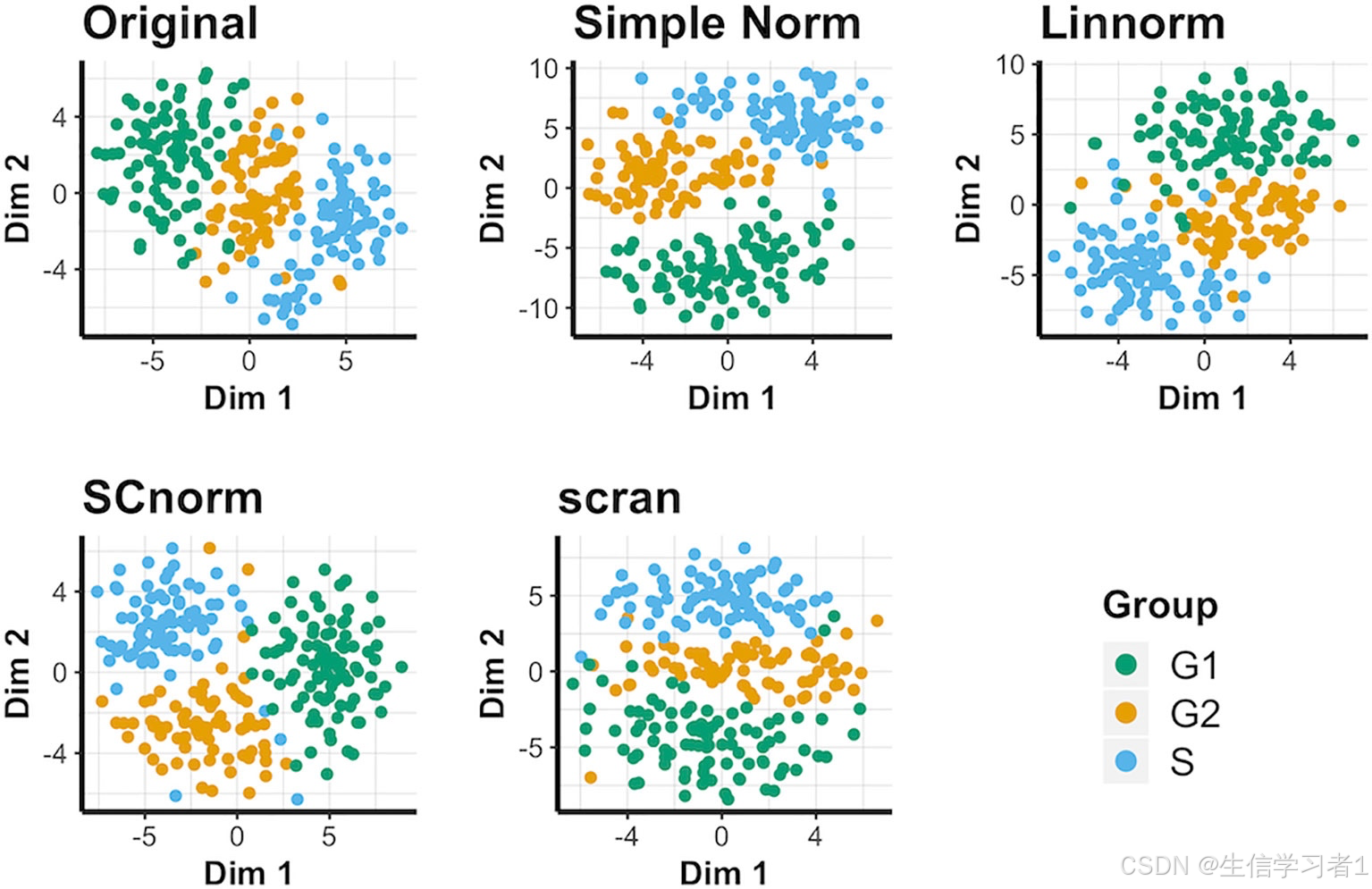

退化空间的表示(Representing the degradation space)为了表示退化空间 D,一种直接的方法是按退化参数划分空间,这种方式听起来似乎是合理的。然而,我们发现不同退化类型的组合可能具有相似的视觉效果和复原难度。如下图所示,经过不同退化的图像具有相似的外观。这表明使用图像的特征而不是退化参数来区分退化图像可能更为合理。

为了有效的表示大退化空间,我们采用了谱聚类方法来对退化图像的直方图特征进行聚类,进而将类中心作为大退化空间下的代表性退化任务。可以得到如下的代表性退化任务集。

大尺度系统性测试集(Large-scale systematic test sets)我们利用聚类中心的退化参数构建了一组用于系统评估测试集(SE test set):

分布式绝对性能(Distributed Absolute Performance)为了全面系统地展示real-SR 模型在上的性能,最直接的方式是对 real-SR 模型计算其在上的分布式绝对性能。

分布式相对性能(Distributed Relative Performance)为了全面系统地展示real-SR 模型在上的性能,我们提出了一组新的评价指标来展示 real-SR的不同特性。

及格线和优秀线(Ac. and ex. line)我们提出了两条参考线来为模型的评价提供基准,这两条参考线为不同的超分模型在上的测试性能。

及格率(Acceptance rate)(AR) 衡量实际 SR 模型所有 K 个代表性退化任务中可接受案例的百分比。可接受案例是指实际 SR 模型的性能超过接受线的退化任务。

相对性能比 (Relative Performance Ratio)(RPR) 用于比较同一尺度下real-SR 模型在及格线和优秀线的相对性能提升。

RPR四分位(Interquartile range of RPR)采用了第 75% 和 25% 位置的RPR分数的差来表示,反映了real-SR 模型在整个测试集上的性能提升的变化范围。

及格任务的RPR分数(Average RPR on acceptable cases )计算了及格任务的的 RPR 分数的平均值:

不及格任务的RPR分数(Average RPR on unacceptable cases )计算不及格任务的的 RPR 分数的平均值:

可定制化的由粗到细的评估流程。根据所提出的指标,我们制定了一个从粗到细的评估协议,对不同的real-SR 模型进行对比。如图所示,模型按优先级顺序依次通过建议的指标进行比较。AR 代表粗粒度比较,而 RPR 则提供细粒度比较。如果它们的性能与当前指标过于接近,则使用下一个指标对它们进行排序。由于每个指标具有不同的含义,这个流程可以根据用户的偏好来自由的定制。

实验结果

MSE-based实验结果

实验结果的图 4 中展示了分布式性能对比,这可以给用户提供大退化空间下多个单退化任务的性能对比。通过我们提出的系统性评测指标,表格 1 也提供了综合性排名,当 AR 大于 0.25 时,我们继续采用 RPR 进行排名。我们发现大部分的方法的 AR 分数都低于 0.5,这意味着都没有超过及格线(FSRCNN),这意味着大部分的 real-SR网络在超过一半的退化任务上比一个小网络 FSRCNN 还差。此外,相比于PSNR 的平均值,我们的 SEAL 评估框架可以提供更系统性、全面性的对比。类似的现象在如下的 GAN-based结果上也可以观测到。

GAN-based实验结果

在 Tab.1和 Tab.2中,由于AR 较低,我们在排名中排除了real-SR 模型中AR低于 0.25 的模型。对于real-SR 模型中 的模型,将根据 {, , , } 进行逐步排序,阈值分别为 {0.02, 0.02, 0.05, 0.05} 。如果当前指标的差值超过了阈值,则使用该指标代表整体排名。否则,将考虑下一个指标。从我们提出的 SEAL 评估中,我们可以得出以下几点结论:

(1) 现有的一些方法在大多数降解情况下都失败了。如表1和表2所示,一些现有方法的 值低于 0.5。例如,在大多数降解情况下,大多数基于 MSE 的真实 SR 模型甚至无法超越小型网络(即 FSRCNN-mz)。

(2) 我们的 SEAL 能够从多个维度对现有方法进行排序,如鲁棒性( )和相对性能提升( )。例如,在 Tab. 2中,与 SwinIR(=0.24)相比,基于度量学习的 MMRealSR 具有显著的鲁棒性( 0.08)。因此,根据我们目前从粗到细的评估协议,MMRealSR 排名第一。有趣的是,我们发现在相同的 水平下,SwinIR 实现了更高的 。如果用户优先考虑在可接受任务的性能,SwinIR 将是更好的选择。因此,我们也可以灵活地将 设置为第一个更精细的指标。

(3) 接受线可以作为视觉效果对比的参考线。视觉结果对比显示在 Fig.1和 Fig.2 中。很明显,接受线的视觉结果可以作为图像质量的基本要求,而优秀线的视觉结果则代表了当前评估协议下图像质量的上限。低于接受线的视觉效果明显表现出不可接受的视觉效果,包括模糊(如图中 RealSRGAN 和 DASR 的鳄鱼的视觉效果)、过度锐化(如图中 RealESRNet 的文本结果和其他伪影。值得注意的是,我们的 SEAL 可以根据未来的需要灵活使用新的参考线。

与传统方法的对比

我们随机抽取 100 个退化任务,将其添加到 Set14 中,得到 100 个测试集(Set14-Random)。表 3 显示:1)在两个 Set14-Random100 数据集上获得的 PSNR 平均值(mean)和标准差(std)显示出明显的不一致性,表明在采样的退化任务中存在很高的随机性和可变性。2) 在我们的 Set14-SE(由 100 个代表性案例组成)上,比较方法的平均值(mean)和标准差(std)非常接近,因此很难在各种方法之间建立一个具有明显差异的清晰排名。因此,随机生成的测试集无法提供差异化的排名。相比之下,我们的 SEAL 可根据 AR 分数对这些方法进行明确排名,提供了一种新的系统评价视角。

总结

在这项工作中,我们开发了一种新的评估框架,用于公平、全面地评估real-SR 模型。我们首先使用基于聚类的方法来模拟一个大的退化空间,并设计了两个新的评估指标--AR 和 RPR,用于对 real-SR模型在代表性的退化任务上的评估。然后,我们用提出的评估流程对现有的real-SR 方法进行基准测试,并展示了新的观察结果。最后,我们对退化聚类进行了广泛的对比研究。通过大量的实验和分析,我们证明了 SEAL 的有效性和通用性。

SEAL可以做什么

SEAL 提供了大退化空间下性能观测的一个工具。我们可以使用 SEAL 去观测新的模型设计对整个退化空间上不同任务带来的影响,进一步发现更多的 insights,作为新研究的 motivation。此外,SEAL也可以作为全方位对比工具,对设计好的模型和现有模型性能进行对比,以展示新设计模型的特性。

如果这个工作可以给你带来一点帮助,欢迎大家star我们的开源仓库(https://github.com/XPixelGroup/SEAL)。我们会在近期更新出下一版本的 SEAL benchmark 结果,进一步改进了退化空间表示的方法,构建了新的轻量又具有多样性的 Seal100测试集,提供了 Diffusion-based real-SR测试结果,敬请大家关注!也欢迎联系(wenlong.zhang@connect.polyu.hk)进行进一步的讨论和合作。

参考文献

[1]. Zhang K, Liang J, Van Gool L, et al. Designing a practical degradation model for deep blind image super-resolution[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. 2021: 4791-4800.

[2]. Wang X, Xie L, Dong C, et al. Real-esrgan: Training real-world blind super-resolution with pure synthetic data[C]//Proceedings of the IEEE/CVF international conference on computer vision. 2021: 1905-1914.

[3]. Zhang W, Li X, Shi G, et al. Real-world image super-resolution as multi-task learning[J]. Advances in Neural Information Processing Systems, 2024, 36.

![[Git] Git下载及使用 从入门到精通 详解(附下载链接)](https://i-blog.csdnimg.cn/direct/0f99f4f2c6c94b699828ef50f9528028.png)