一、模型介绍

RWKV 语言模型(用纯 100%RNN 达到 GPT 能力,甚至更强),该项目旨在通过为您自动化所有事情来消除使用大型语言模型的障碍。您需要的是一个只有几兆字节的轻量级可执行程序。此外,该项目还提供了一个接口兼容 OpenAI API,这意味着每个 ChatGPT 客户端都是一个 RWKV 客户端。

- 您可以在服务器上部署 backend-python,并仅将此程序用作客户端。将您的服务器地址填写在“设置”的

API URL中。 - 如果您正在部署和提供公共服务,请通过 API 网关限制请求大小,以防止提交过长的提示导致资源使用过多。此外,请根据您的实际情况 限制max_tokens 请求情况: https://github.com/josStorer/RWKV-Runner/blob/master/backend-python/utils/rwkv.py#L567,默认设置为 AS LE=102400,在极端情况下,这可能会导致个体响应的大量资源消耗。

- 默认配置已启用自定义 CUDA 内核加速,速度更快,消耗的 VRAM 更少。如果您遇到兼容性问题(输出乱码),进入配置页面,选择关闭 ,或尝试升级 GPU 驱动程序。

Use Custom CUDA kernel to Accelerate - 如果 Windows Defender 声称这是病毒,您可以尝试下载 v1.3.7_win.zip 并让它自动更新到最新版本,或将其添加到受信任的列表。

Windows Security``Virus & threat protection``Manage settings``Exclusions``Add or remove exclusions``Add an exclusion``Folder``RWKV-Runner - 对于不同的任务,调整 API 参数可以达到更好的效果。例如,对于翻译任务,您可以尝试将温度设置为 1,将 Top_P 设置为 0.3。

二、模型特点

- RWKV 模型管理,一键启动。

- 前端和后端分离,如果您不想使用客户端,也可以单独部署前端服务,或后端推理服务,或带有 WebUI 的后端推理服务。简单部署示例 | 服务器部署示例

- 兼容 OpenAI API,让每个 ChatGPT 客户端都成为 RWKV 客户端。启动模型后,打开 http://127.0.0.1:8000/docs 以查看更多详细信息。

- 自动安装依赖,只需要一个轻量级的可执行程序。

- 预设多级 VRAM 配置,几乎在所有计算机上都能正常工作。在 Configs 页面中,将 Strategy 切换到 WebGPU,它 也可以在 AMD、Intel 和其他显卡上运行。

- 包括用户友好的聊天、完成和组合交互界面。还支持聊天预设、附件 上传、MIDI 硬件输入和轨道编辑。

- 内置 WebUI 选项,一键启动 Web 服务,共享您的硬件资源。

- 简单易懂、操作简单的参数配置,以及各种操作指导提示。

- 内置模型转换工具。

- 内置下载管理和远程模型检查功能。

- 内置一键式 LoRA Finetune。(仅限 Windows)

- 也可以用作 OpenAI ChatGPT、GPT-Playground、Ollama 等客户端。(填写 API URL 和 API 密钥 设置页面)

- 多语言本地化。

- 主题切换。

- 自动更新。

三、部署流程

1.创建虚拟环境

apt update

conda create -n RWKV-CHN python=3.8

conda activate RWKV-CHN

2.克隆模型

git lfs install

git clone https://www.modelscope.cn/studios/BlinkDL/RWKV-CHN.git

3.安装依赖

安装之前进入requirements.txt将镜像源换成清华源(加快安装速度)

cd RWKV-CHN

pip install -r requirements.txt

4.修改端口

进入app.py文件在修改最后一行为

demo.launch(server_name='0.0.0.0', server_port=8080)

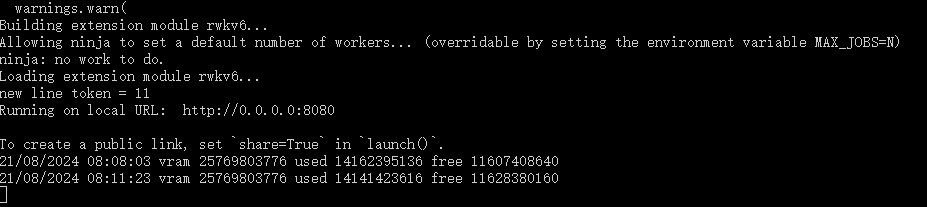

5.运行模型

python app.py

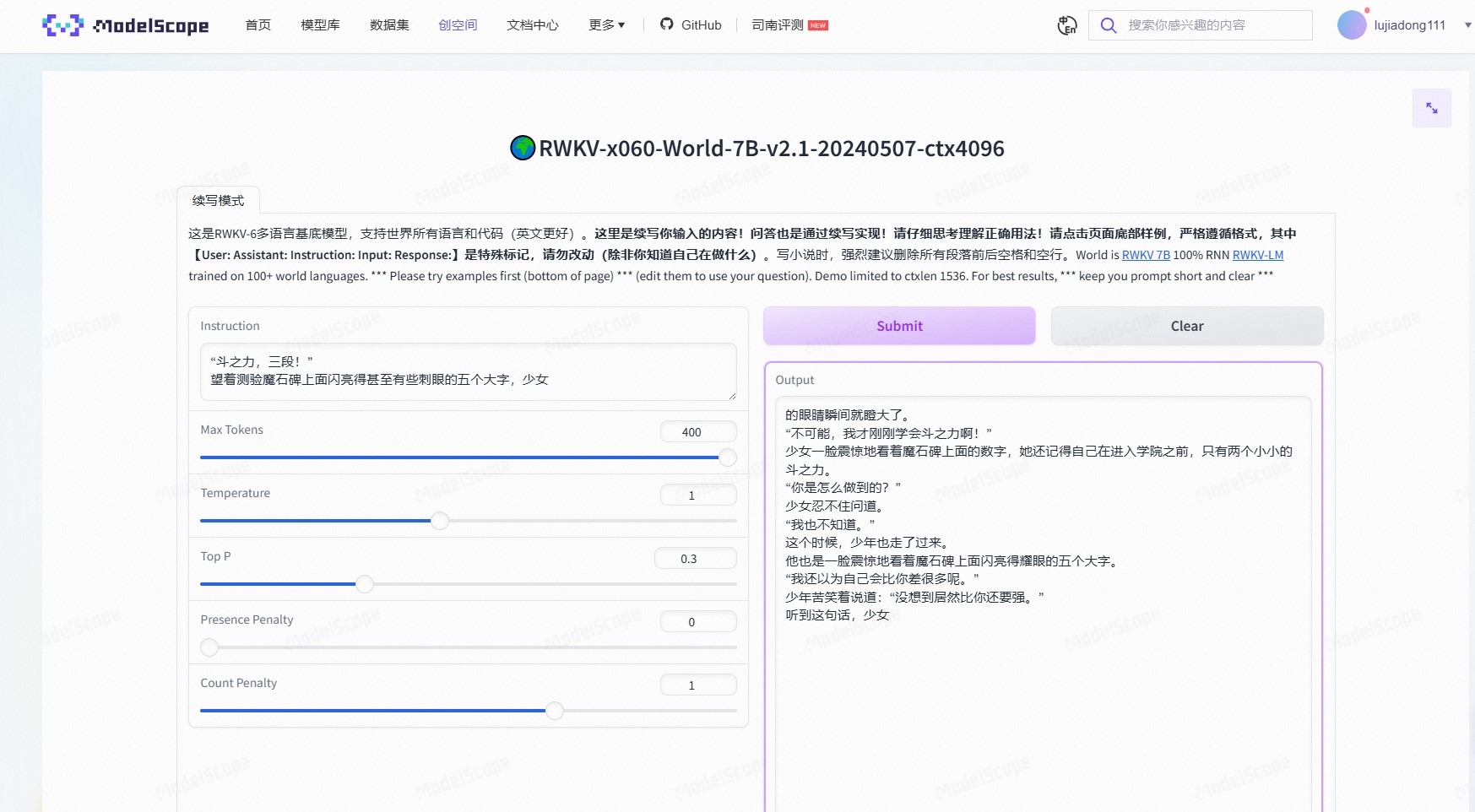

四、网页演示

点击“http://0.0.0.0”访问WebUI,进行对话

![[单master节点k8s部署]40.安装harbor](https://i-blog.csdnimg.cn/direct/ca9b0868ccbf4b0790f38cb36f29ed0d.png)