论文地址:https://arxiv.org/pdf/2408.16767

项目地址:GitHub - liuff19/ReconX: ReconX: Reconstruct Any Scene from Sparse Views with Video Diffusion Model

---------------------------------------------------------------------------------------------------------------------------------

任务:

将模糊重建挑战重新构建为时间生成任务

挑战:

传统3D场景重建在“密集视角”(即从多个角度拍摄大量照片)情况下表现很好,但当捕获的视角有限时,重建变得困难。这是因为有限视角下信息不足,导致“未见区域”出现伪影和失真。

解决:

1. 重新定义问题:ReconX 将这个模糊的重建问题视为一个“时间生成任务”,也就是说,它不直接解决3D重建的病态问题,而是通过时间维度(视频序列)生成一个逐帧一致的3D场景。

2. 使用大规模预训练的扩散模型:扩散模型是一种生成模型,能够从稀疏视角中生成高质量的内容。ReconX 利用这种模型来生成细节丰富的视频帧,并通过这些帧确保3D场景的一致性。

贡献:

- 提出了ReconX,一种新的稀疏视角3D场景重建框架,将模糊的重建挑战重新定义为时间生成任务。

- 将3D结构引导整合到视频扩散模型的条件空间中,以生成具备3D一致性的帧,并提出了一种基于3D置信度感知的优化方案,通过3DGS从生成的视频中重建场景。

- 大量实验表明,ReconX在多个真实世界数据集上在高保真度和泛化性方面优于现有方法。

大致过程:

- 首先, 给定稀疏的图像,通过一个 无姿态的立体重建方法DUSt3R 构建全局点云。

- 然后,将其编码到一个丰富的上下文表示空间中,作为交叉注意力层中的3D条件,指导视频扩散模型合成细节保留的帧,并生成具备3D一致性的场景新观察视角。

- 最后,通过结合3D置信度感知和鲁棒的场景优化方案的高斯点散射,从生成的视频中重建3D场景,从而有效地去除视频帧中的不确定性模糊。

详细过程:

该项目分为一下几步:构建三维结构指导,3D一致的视频帧生成,自信感知3d优化

构建三维结构指导

从稀疏视图的图像集(可能只有几个图像)中恢复场景的3D结构。

首先,对于给定的稀疏图像集,构建了一个连接图。每个图像被视为一个节点,如果两个图像之间有相同或重叠的视觉内容,它们之间就会形成一条边。这种结构便于识别哪些视图有共享信息。

接下来,系统通过每对图像之间的视觉信息预测点云和置信度图,生成每对视图共享的3D点。

通过旋转和缩放,使每对图像的点云预测对齐到同一个全局坐标系中。这一步是为了确保不同视角下的点云一致。

对齐后的点云被进一步简化,并通过 Transformer 编码器投射到一个潜在的3D上下文空间中。这是为了让系统在处理过程中能够更好地理解和利用这些3D结构信息。

最终,通过这个上下文空间,系统生成了3D结构引导信息,这些信息将用于指导视频扩散模型生成3D一致性较好的新视图。

3D一致的视频帧生成

将3D结构引导F(P) 融入到视频扩散过程中,以生成3D一致性帧。为了确保生成帧与场景的高保真渲染视图之间的一致性,利用视频插值能力来恢复更多未见的视角。

首先,利用3D结构引导来提升生成帧的质量,使其更加符合稀疏图像视角下的3D结构。

然后,模型通过交叉注意力机制,在每层的空间特征中融合图像和3D结构特征,进而生成符合高保真标准的新视角帧。

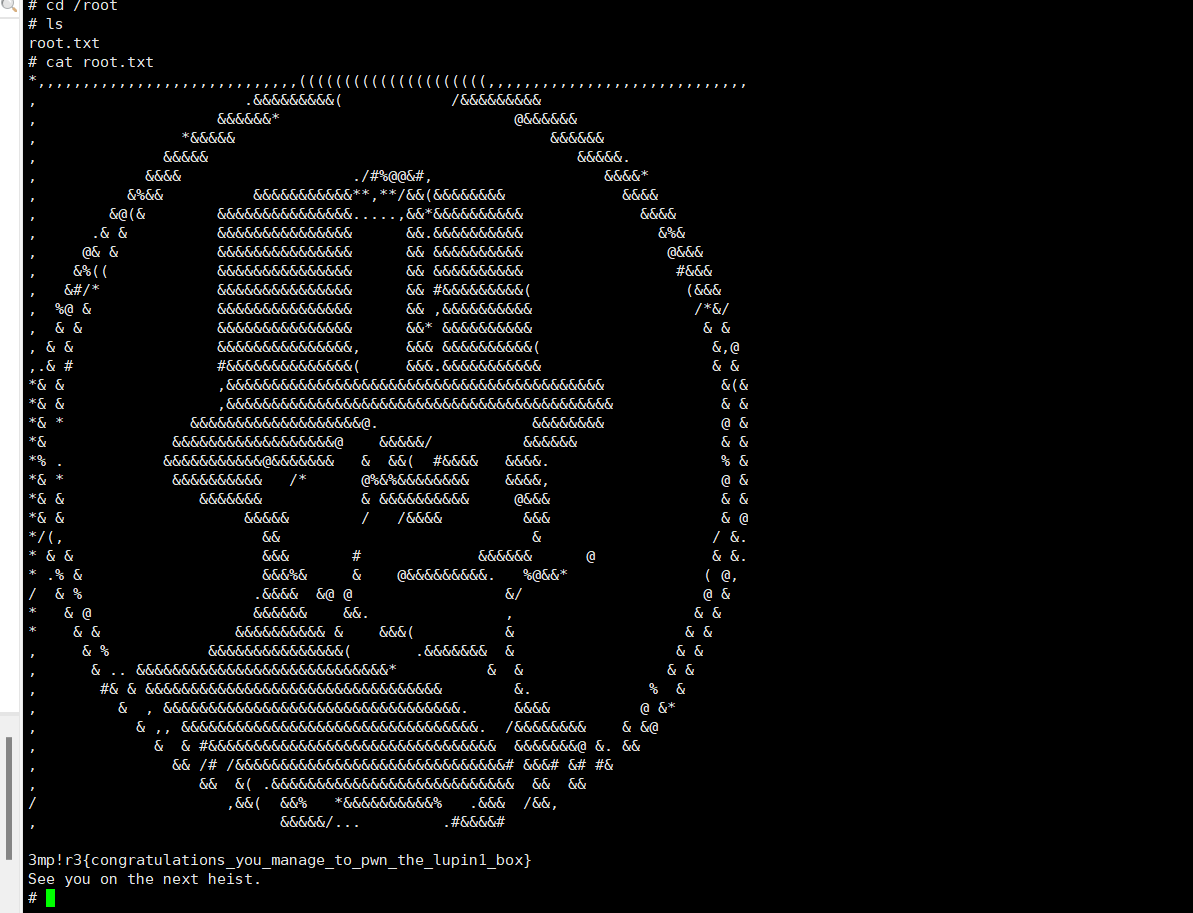

置信感知3DGS优化

置信感知机制主要通过全局对齐生成帧的像素值,建模每个像素的颜色值为高斯分布,其中均值是生成帧的像素值,方差则衡量生成帧和真实帧的差异。

问题:

传统的3D重建方法主要用于处理经过校准的摄像机拍摄的真实照片,而直接应用这些方法于生成的视频时,由于生成图像的不确定性,难以恢复一致的3D场景。

解决:

采用了一种置信感知的3DGS(3D结构引导系统)机制来重建复杂场景。

首先,对于生成的帧 Ii 和真实视图 i 的每像素颜色值表示为^Ci和Ci

然后,将像素值建模为3DGS中的高斯分布,其中 Ii 的均值和方差为Ci和σi。方差σi表示生成的视图与实际视图之间的差异。目标是最小化所有帧之间的负对数似然。

最后,从DUSt3R的 Transformer 解码器中找到对齐良好的映射函数A,该函数为每个生成的帧 构建置信度图

。具体地说,在难以估计的区域(例如,具有固体颜色的区域)中,置信度分数往往较低,而在不确定性较低的区域得分将较高。