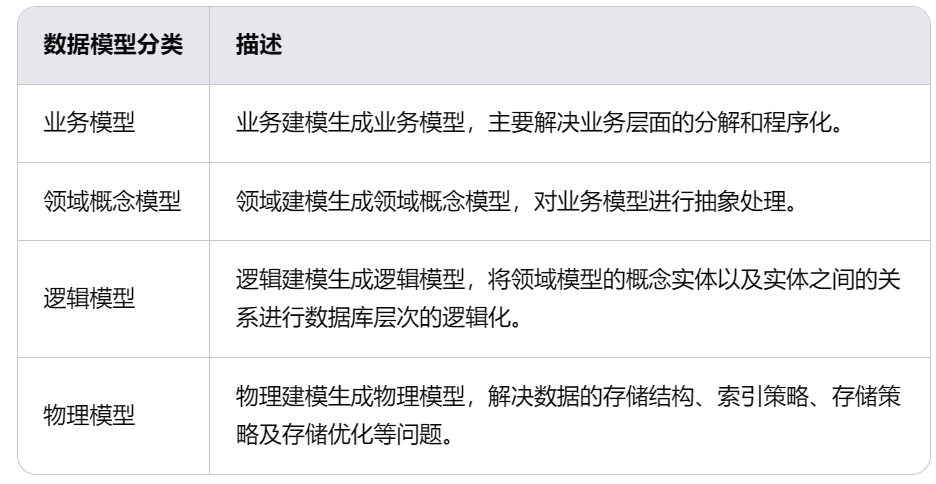

网络分层模型和对应实现

TCP/IP 网络分层模型

物理层、链路层、网络层、传输层、应用层

物理层对应网卡网线

应用层对应常见的Nginx,HTTP、FTP等等各种应用

linux 实现链路层、网络层和传输层

链路层协议靠网卡驱动实现,内核协议栈实现网络层和传输层

内核对更上层的应用曾提供socket接口供用户进程访问

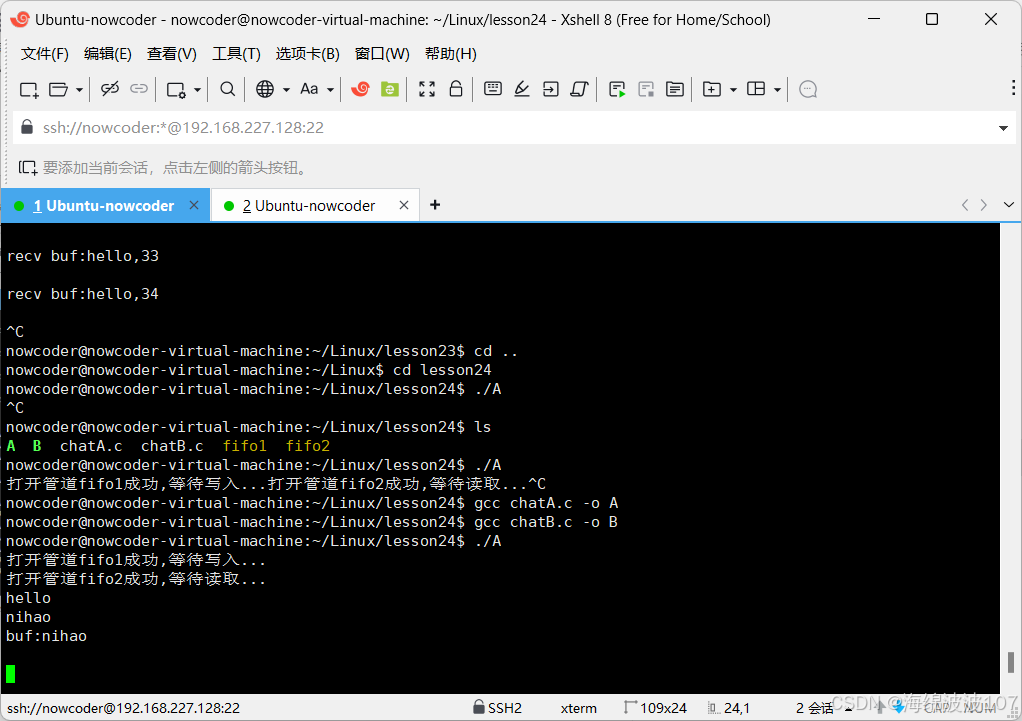

硬中断和软中断

内核和网络设备驱动是通过中断的方式来处理的

当设备有数据到达,会给CPU对应引脚上触发一个电压变化,通知CPU处理数据,这就是硬中断

对网络模块来说,处理流程较复杂以及耗时,如果在中断函数中处理所有事情,会过度占据CPU,导致CPU无法响应其他设备,例如键鼠

因此linux 中断处理函数分为上下两个部分,上半部分只进行最简单的部分,快速处理然后释放CPU,接着CPU就可以允许其他中断进来

剩下的绝大部分工作可以在下半部分进行,从容处理

2.4以后的内核版本下半部分的实现方式是软中断,由ksoftirqd 内核线程全权处理,通过给内存的一个变量的二进制值来通知软中断处理程序,这就是软中断

内核收包路径

- 数据帧从外部网络到达网卡

- 网卡把桢DMA到内存

- 硬中断通知CPU

- CPU响应硬中断,简单处理后发出软中断

- ksoftirqd 进程处理软中断,调用网卡驱动注册的poll函数开始收包

- 帧被从Ring buffer 上摘下来保存为一个skb

- 协议层开始处理网络帧,处理完后的数据data被放到socket的接收队列中

当网卡收到数据后,linux第一个工作模块是网络驱动,网络驱动会以DMA的方式把网卡上收到的帧写到内存里,再向CPU发起一个中断,通知CPU有数据到达

当CPU收到中断请求后,会调用网络驱动注册的中断处理函数,网卡的终端处理函数并不会做过多工作,发起软中断请求,释放CPU

ksoftirqd 检测到软中断请求到达,调用poll开始轮询收包,收到后交由各级协议栈处理,放入到socket 的接收队列中

硬中断在哪个CPU上被响应,那么软中断也是在这个CPU上处理的,所以说,如果你发现你的linux软中断CPU消耗都集中在一个核上的话,做法就是调整硬中断的CPU亲和性,将硬中断打散到不同CPU核上去

总结

开始收包前,linux做了很多准备工作

- 创建ksoftirqd 线程,设置好它自己的线程函数,用来处理后续的软中断

- 协议栈注册,linux要实现很多协议,例如:ip\udp\tcp 每一个协议会将自己的处理函数注册一些,方便包来了迅速找到对应的处理函数

- 网卡驱动初始化,每个驱动都有一个初始化函数,内核会让驱动也初始化一下,准备好DMA,把NAPI的poll函数地址告诉内核

- 启动网卡,分配RX,TX队列,注册中断对应的处理函数

上述准备好后,打开硬中断,等待数据包到来

数据到了以后,第一个迎接它的是网卡

-

网卡将数据帧DMA到内存的RingBuffer中,然后向CPU发起终端通知

-

CPU响应中断请求,调用网卡启动时注册的终端处理函数

-

中断处理函数几乎没干啥,就发起了软中断请求

-

内核线程ksoftirqb 线程发现有软中断请i去到来,先关闭硬中断

-

ksoftirqd 线程开始调用驱动的poll函数收包

-

poll函数将收到的包送到协议栈注册的ip_rev函数中

-

ip_rev函数再将包送到udp_rcv 函数中(对于tcp包就送到tcp_rcv)

完