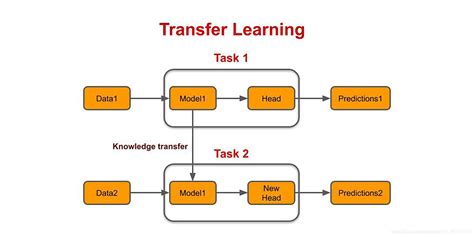

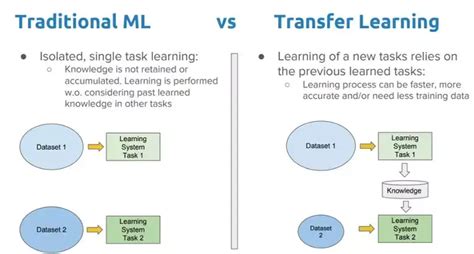

迁移学习(Transfer Learning)是一种机器学习技术,旨在将一个任务(源任务)上学到的知识迁移到另一个相关但不完全相同的任务(目标任务)上,从而提高目标任务的学习效果。这种方法的核心思想是利用不同任务之间的共同特征或模式,通过在源任务上预训练的模型参数来加速目标任务的学习过程。

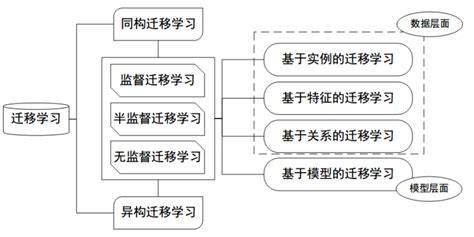

迁移学习的方法可以分为基于实例的迁移、基于特征的迁移、基于模型的迁移和基于关系的迁移。其中,基于实例的迁移通过权重分配分别作用于源域和目标域;基于特征的迁移将两个域的特征变换到同一空间;基于模型的迁移通过参数共享机制实现;基于关系的迁移利用源域中的一般性逻辑关系进行迁移。

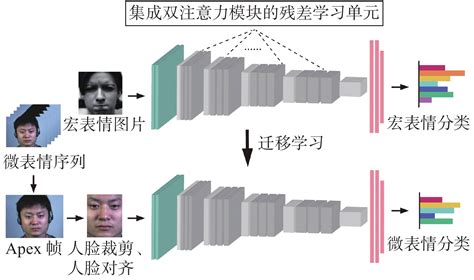

在实际应用中,迁移学习通常包括以下步骤:首先加载一个已在大型数据集上训练好的预训练模型,如ImageNet上的CNN模型;其次,冻结预训练模型的某些层,以防止它们在新任务上训练时被更新;最后,在预训练模型的顶部添加一些自定义层,以适应新的任务需求。

迁移学习的优势在于它能够显著减少新任务所需的数据量和训练时间,特别是在数据稀缺的情况下,能够有效提高模型的泛化能力和性能。然而,迁移学习也存在局限性,例如当源域和目标域的任务相似度较低时,可能会出现负迁移的问题,导致学习效果不佳。

此外,迁移学习在多个领域都有广泛应用,如图像识别、自然语言处理等。例如,在图像分类任务中,预训练的CNN模型可以在新数据集上进行微调,从而提高识别能力。

基于双注意力模型和迁移学习的Apex帧微表情识别

迁移学习是一种重要的机器学习技术,通过利用已有知识来解决新问题,可以显著提高学习效率和模型性能,尤其适用于数据量不足或计算资源有限的情况。