hihi,朋友们,时隔半年(24年11月),终于能腾出时间唠一唠SD了🤣,真怕再不唠一唠,就轮不到SD了,技术更新换代是在是太快!

朋友们,最近(24年2月)是真的没时间整理笔记,每天都在疯狂的学习Stable Diffusion和WebUI & ComfyUI,工作实在有点忙,实践期间在飞书上记了一些学习笔记,后面看有时间我再回来补齐吧!

基本概念

开始前我们先熟悉几个概念,这些内容在之前的文章里面也有专门介绍过:

- 关于AIGC文生图:一文读懂AIGC文生图系列发展近况

- 关于扩散模型: 一文读懂「Diffusion Model,DM」扩散模型

- 关于Midjourney:深入浅出剖析典型文生图产品Midjourney

SD介绍

Stable Diffusion是一种基于深度学习的图像扩散生成模型,利用文本描述生成图像。该模型由CompVis、Stability AI和LAION合作开发,具有高稳定性和生成质量。

产品介绍

Stable Diffusion直译为稳定扩散,理解稳定扩散之前先通过两张图片介绍一下什么是前向扩散和逆向扩散。所谓前向扩散(forward diffusion)过程就是向训练图像中不断地添加噪声,从而使其逐渐变为一张毫无意义的纯噪声图。经过前向扩散猫的图像变成了随机噪声。反过来,逆向扩散(Reverse Diffusion)过程是从一个随机噪声图像开始恢复出猫图像的过程。

因此,Stable Diffusion可以理解为从一张完全高斯噪音开始,根据用户输入的要求,逐步剔除噪音,直到产生出用户所要图片的过程。

它的核心是如何降噪(降噪模型),而降噪模型的核心是噪声预测器(根据用户文本输入,预测噪声),即高斯图片->逐步减去噪声->得到用户所需图片。

这个过程里面一共用到了图像编码器、文本编码器、扩散模型、图像解码器四个神经网络模型。

发展路线

SD 1.1:首个版本,提出improved aesthetics,优化图像质量,使用4plus模型配置。

SD 1.2:引入大数据集LAION-2B进行训练,提高了图像质量,使用5plus模型配置。

SD 1.3:过渡版本

SD 1.4:在图像生成效果上有较大提升,训练迭代次数增加到195000步。

SD 1.5:继续改进美学效果,使用5plus模型,训练达到225000步,可以生成更高质量图片。

SD2.0:这是Stable Diffusion的一个主要版本。它在之前版本的基础上实现了显著的改进,特别是在图像的美学质量和生成模型的细节上。

SD2.1:这个版本进一步优化了之前版本的特性。强调了更有效的文本编码器,使用了更先进的CLIP版本,生成的图像与文本提示的一致性和相关性有所提升。

SD变种:这可能是Stable Diffusion的一个变体版本,具有特殊的属性或针对特定应用场景的优化。

SDXL:这是Stable Diffusion的一个扩展版本。演化更大的模型(比如使用了更大的UNet),或者训练了更广泛的数据集。强调了CLIP文本编码器和VAE的改进,提供了更准确的文本到图像的转换能力。

Stable Diffusion 2.x系列:

SD 2.0:基于CompVis模型,提升细节生成能力。

SD 2.1:引入Hypernetwork,支持无限分辨率生成。

SD 的演化过程中,最主要的变化就是模型结构和训练数据的变化。SD1.x 系列,大多数是在 SD1.2 的基础上继续微调得到的,包括我们使用最多的 SD1.4 和 SD1.5 模型;SD2.x 系列则是新开的故事线,使用了全新的模型结构。

功能介绍

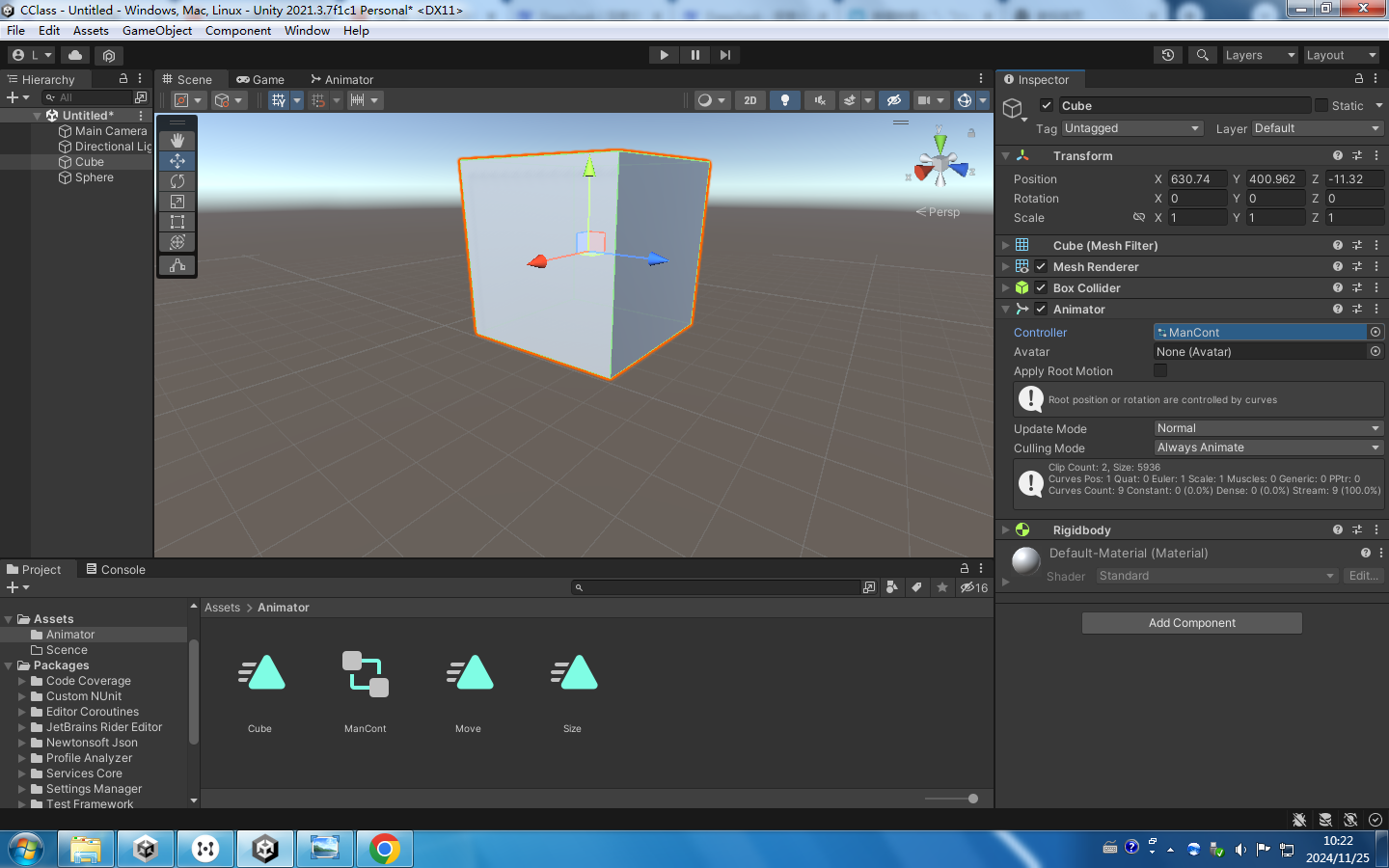

关于界面使用,SD有两种方式一种是webUI,另外一种是comfyUI,comfyUI是一种更灵活的工作流式的操作方式。

webUI

全程讲操作流程还是太费时间了,建议大家跟着教程走一遍基本就了然于胸了!我不在这里赘述,给大家一个比较强全面的讲解:

- 超详细!外婆都能看懂的Stable Diffusion入门教程</