ragflow和ollama连接后,已经添加了两个模型但是ragflow仍然一直warn:Please add both embedding model and LLM in Settings > Model providers firstly.这里可能是我一开始拉取的镜像容器太小,容不下当前添加的模型,导致无法去设置模型,进行后续操作

后面拉了docker-compose-CN-oc9.yml后,发现可以显示出下面的界面:但是卡了,重新配一遍

左边栏中的系统应该是当前运行的容器

只要是ragflow没有完全部署好都会出现网络异常,好家伙回去重新配ragflow

更换镜像容器-------记录

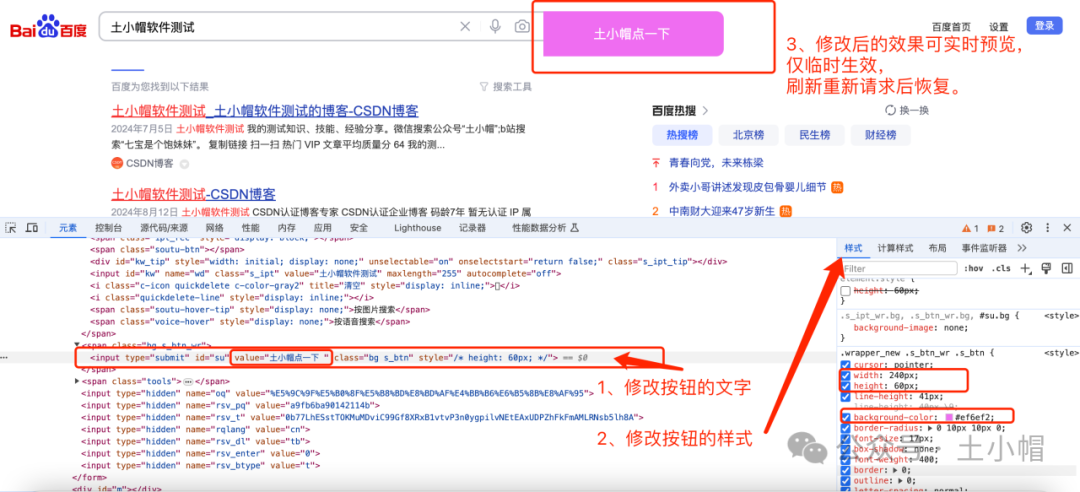

首先,修改.env文件的配置

我需要内置embedding模型的镜像,所以需要将RAGFLOW_IMAGE 变量修改为: RAGFLOW_IMAGE=infiniflow/ragflow:v0.13.0(当前改的这个)。修改后,再运行上面的命令。

注意: 安装内置 embedding 模型和 Python 库的指定版本的 RAGFlow Docker 镜像大小约 9 GB,可能需要更长时间下载,请耐心等待。

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

原文链接:https://blog.csdn.net/jycjyc/article/details/143857323

sudo su

sysctl -w vm.max_map_count=262144

cd ragflow/docker

修改.env文件的RAGFLOW_IMAGE为想要的版本后,重新拉取新的镜像

docker compose -f docker-compose.yml up -d

但是系统这里没有显示dev

接着,检测服务器状态

docker logs -f ragflow-server

我最最最担心的事情发生了,windows的C盘飙红

发现报错,可能和我的C盘满了有关系????

OK停下来去清理C盘