负载均衡(Load Balancing)是一种计算机技术,用于在多个服务器、网络连接、计算资源之间合理分配工作负载,以提升应用程序的可用性、性能和可扩展性,以下是详细介绍:

-

工作原理

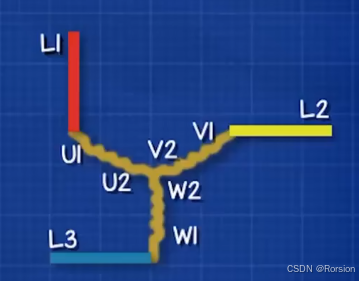

- 流量分配:负载均衡器会监控一组后端服务器的实时状态,依照设定的算法,将来访的网络流量、用户请求均匀或按特定规则分发给后端服务器处理。例如,将电商网站的用户下单请求分发给不同的订单处理服务器。

- 健康检查:定时检查后端服务器是否正常运行,倘若某台服务器出现故障,如响应超时、端口无响应,负载均衡器会自动停止向它分配新请求,后续请求转至其他健康服务器,避免用户请求遇到错误。

-

负载均衡算法

- 轮询算法(Round Robin):按顺序依次将请求分配给后端服务器,循环往复,保证各服务器接收请求数量大致相同,非常公平,适用于所有服务器性能相近的场景。

- 加权轮询算法(Weighted Round Robin):考虑到服务器性能差异,给性能强的服务器分配更高权重,权重高的服务器在一轮分配中会收到更多请求。比如,配置高的服务器权重设为 3,普通服务器权重设为 1,前者接收请求频率就是后者 3 倍。

- 最少连接算法(Least Connections):优先把新请求分配给当前连接数最少的服务器,适合处理长连接或连接时长差异大的应用,确保各服务器负载更均衡。

- IP 哈希算法(IP Hash):依据客户端 IP 地址计算哈希值,借此决定请求发往哪台服务器,如此,同一客户端的多次请求大概率会被同一台服务器处理,常用于有状态服务场景,像在线游戏,能维持玩家会话连贯性。

-

实现方式与部署位置

- 硬件负载均衡器:是专门的物理设备,像 F5 Networks 的 Big-IP 系列,性能强劲、功能丰富,能处理海量并发流量,稳定性高,不过价格昂贵,常用于对可靠性、性能要求苛刻的大型企业数据中心。

- 软件负载均衡器:基于软件实现,比如 Nginx、HAProxy 。Nginx 安装配置简便,能高效处理 HTTP、HTTPS 协议;HAProxy 对 TCP、UDP 协议支持出色,功能定制灵活,成本较低,中小规模网站或创业公司采用较多。

- 云负载均衡服务:云服务商提供的托管式负载均衡方案,例如亚马逊的 Elastic Load Balancing、阿里云的负载均衡服务。用户直接在云平台上简单配置就能使用,与云资源集成度高、可按需扩展,还免去硬件维护成本。依据负载均衡器部署位置,又分四层(传输层)负载均衡与七层(应用层)负载均衡:

- 四层负载均衡:工作在传输层,依据 IP 地址和端口号转发流量,性能高、速度快,常用于转发 TCP、UDP 流量,像视频流、游戏数据传输场景。

- 七层负载均衡:运作于应用层,能识别 HTTP、HTTPS 等应用层协议内容,按内容做更智能的请求分发,如按用户请求的 URL 路径、Cookie 信息把请求导向特定服务器。

-

应用场景

- 高流量网站:电商、新闻资讯类大型网站访客众多,负载均衡把请求分散到多台 Web 服务器,防单台服务器过载,维持快速响应。

- 云计算环境:云平台中多租户共享资源,负载均衡合理分配各租户的计算、存储任务,提升资源利用率与服务质量。

- 企业应用系统:诸如 ERP、CRM 系统,保障企业内大量员工稳定访问,避免关键业务流程卡顿,提升办公效率。